Formation Data-Science pour l`Actuariat

15 Septembre 2015

Formation

Data-Science pour l’Actuariat

Formation Data Science pour l’Actuariat

Pourquoi?

- Révolution numérique :

données massives et hétérogènes, nouveaux comportements clients,

nouveaux usages, nouveaux modes de distribution, objets connectés

- Nouveaux besoins de compétences pour les entreprises

- Nouvelles compétences à acquérir pour les actuaires

Nouveau contexte : nouveau besoin

Réponse: une formation complémentaire pour les actuaires

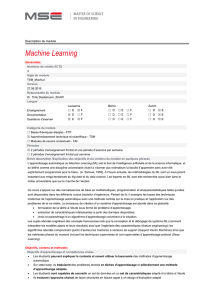

Principes pédagogiques

- Complément aux formations à l’actuariat en matière d’extraction, gestion

et analyse de données massives et hétérogènes, internes et externes:

algorithmes, approche data driven, apprentissage statistique, identification de sur-

apprentissage, robustesse des méthodes

- Acquisition conjointe d’un socle de connaissances théoriques et de

savoir-faire opérationnels:

immersion dans le monde des Data (notamment concours type Kaggle)

exemples d’applications aux métiers de l’assurance et la protection sociale

- Réalisation d’un projet sur un sujet actuariel encadré par un tuteur

Objectifs de la formation

A l’issue de sa formation, l’actuaire Data Scientist sera notamment apte à :

- mettre en place informatiquement les méthodes statistiques en Python (ou

R),

- mesurer l'efficacité d'un algorithme (complexité, gestion de la mémoire..) et

envisager le calcul parallèle,

- prendre des décisions sur le stockage de données dans une entreprise

d'assurance, une mutuelle, une institution de prévoyance ou un courtier

- mettre en œuvre des méthodes avancées online ou offline.

- proposer des outils de reporting et de visualisation afin de synthétiser

l'information.

Dans le cadre des ses fonctions, ces compétences acquises lui permettront

notamment de travailler en équipe et de façon créative avec les fonctions

informatiques et marketing pour assurer l’efficacité et la solvabilité de

nouvelles offres et de nouvelles méthodes de distribution.

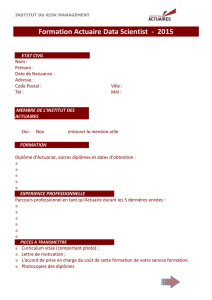

Gouvernance de la formation

Direction des Etudes:

Arthur Charpentier (Actuaire, Prof. Stat. Rennes et UQAM)

Romuald Elie (Actuaire, Prof. Maths, Université Paris-Est et ENSAE)

Jérémie Jakubowicz (Agrégé et Docteur Maths, Prof Télécom Paris Sud et ENSAE)

Comité Scientifique:

Michel Bois (Actuaire, DSI CNP, Membre du Comex CNP)

Renaud Dumora (Actuaire, DGA Paribas BNP Cardif)

Philippe Marie-Jeanne (Actuaire, Directeur Lab Big Data Innovation AXA Group)

Françoise Soulié-Fogelman ( ENS, Consultante, ex KXEN)

Olivier Sorba (Actuaire, CRO Groupe Lagardère)

Marc Hoffmann (Professeur Stat Dauphine et X, Chaire Big Data Havas ILB)

Florence Picard (Actuaire, Commission Scientifique Institut des actuaires)

Organisme de formation: IRM Institut du risk management

Thomas Behar Président, Membre du Comex de CNP, Président de l’Institut des Actuaires

Régis de Laroullière Directeur, Directeur de l’Institut des Actuaires

Catherine Idée Rosier Responsable des formations

Sous le parrainage de la

Commission Scientifique de l’Institut des Actuaires

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

1

/

19

100%