Reconnaissance Géophysique pour le génie civil

1

Reconnaissance Géophysique

La reconnaissance géophysique, ou prospection géophysique (geophysical survey en

anglais), met en oeuvre un ensemble de méthodes indirectes où l’on cherche, à partir d’une ou

plusieurs propriétés physiques à déterminer la structure du milieu souterrain de manière non

destructive (non-invasive) et avec un échantillonnage spatial suffisamment dense pour que les

variations latérales et verticales en soient décrites aussi complètement que le permettent la

propriété et la méthode de mesure utilisées. La résolution, c’est à dire le degré de finesse avec

lequel le sous-sol va être décrit, est en effet variable selon la propriété choisie et la méthode

utilisée.

Les mesures peuvent être réalisées à partir de la surface, de puits ou d’excavations

préexistantes. Le plus souvent elles ne permettent pas, à elles seules, de déterminer les valeurs

de paramètres géotechniques mais sont indispensables pour placer judicieusement les forages

où seront effectuées les mesures de ces paramètres, pour interpoler entre ces localisations et

pour déceler les anomalies préjudiciables à un projet.

Certaines méthodes de grand rendement et capables de déterminer les grands traits de

la structure géologique – sismique réfraction et méthodes électriques en particulier – seront

mises en œuvre dès les premiers stades de l’étude du projet (faisabilité géotechnique G12,

phase 1). Ces mesures seront réalisées quasi obligatoirement pour les études de tracés

linéaires (routes, autoroutes, voies ferrées).

On choisit la propriété à mesurer à partir de la corrélation qu’on lui connaît avec les

caractéristiques géotechniques recherchées et de l’amplitude des contrastes qu’elle peut

montrer. Toutefois, les propriétés physiques montrant à la fois une variabilité suffisamment

importante en fonction des paramètres d’état du terrain significatifs en géotechnique (porosité,

teneur en eau, argilosité …), et donnant lieu à des méthodes de mesure réalisables à faible

coût avec des appareils robustes et de mise en œuvre facile sur le terrain, sont en nombre

limité. On s’arrêtera ici à la densité, à la vitesse de propagation des ondes de compression et

aux propriétés électriques. On ne traitera pas des propriétés magnétiques qui, quoique d’un

usage très important en prospection archéologique et en géophysique de l’environnement sont

peu utilisées en Génie Civil, ni des propriétés thermiques qui présentent l’avantage de pouvoir

être mesurées en télédétection mais sur une épaisseur inférieure au mètre. Si une même

propriété physique peut-être mesurée de plusieurs façons, le premier choix du prospecteur

reste celui de la propriété à mesurer, en fonction des caractéristiques recherchées du terrain, la

2

facilité d’emploi et les sensibilités des appareils disponibles intervenant ensuite dans le choix

de la méthode de mesure et de l’appareillage. Le coût de la mise en œuvre d’une méthode

reste toujours un élément déterminant dans les choix.

3-1 Propriétés physiques utilisées

3-1-1 Densité, d

Par définition, la densité d’un matériau est le rapport entre le poids d’un volume donné

et le poids du même volume d’eau, c’est donc une grandeur sans unité contrairement à la

masse volumique et au poids volumique (dans le système c.g.s., la masse volumique de l’eau

étant de 1gcm-3 la valeur exprimant la densité est la même que celle exprimant cette

propriété).

Pour les milieux superficiels du sous-sol, la densité de la fraction solide est toujours

très proche de ds =2,67. De ce fait, pour un sol saturé on aura :

d=ds(1-n)+n

n étant la porosité, et pour un sol non-saturé,

d=ds(1-n)+nSr,

si l’on néglige le poids de la fraction gazeuse, Sr étant le degré de saturation en eau. On a

donc des relations linéaires très simples et, pour les milieux saturés, directement une valeur de

la porosité.

La mise en évidence de contrastes de densité est réalisée à partir de la surface par

mesures gravimétriques et indirectement en sismique (cf infra). En forage, on peut aussi faire

des mesures avec un gravimètre (mais c’est très rare) ; par contre, les diagraphies de densité

avec un rayon d’investigation de 40cm environ sont couramment réalisées avec des sondes γ-

γ,. Le rayonnement γ par ces sondes interagit avec les nuages électroniques des atomes

présents, la quantité de rayons rétrodiffusés dépend du nombre d’électrons donc de la masse

des atomes. La restitution de la densité nécessite un étalonnage.

3-1-2 Vitesse de propagation des ondes élastiques, Vp

Pour un milieu linéaire, homogène et isotrope, la vitesse des ondes de compression

dépend des coefficients de Lamé, λ et μ, et de la masse volumique ρ. On a :

ρ

μλ

2+

=

pV.

3

Les données expérimentales ne correspondent cependant pas à cette expression théorique, la

vitesse étant en générale croissante avec la densité. On a donc recherché à partir de séries

d’expériences, des lois empiriques simples permettant de relier la vitesse avec les paramètres

significatifs. La meilleure de ces lois est celle proposée par Wyllie (1957), elle s’appuie sur le

modèle ‘en pile’ où l’on considère que, dans le volume élémentaire, l’onde traverse

successivement la partie solide puis la partie liquide puis la partie gazeuse et que les temps de

transit s’ajoutent. On a donc sommation des lenteurs (inverse des vitesses) :

g

r

w

r

sp V

Sn

V

nS

V

n

V

)1()1(

1

−

++

−

=,

où Vg est la vitesse dans la fraction gazeuse (proche de 330m s-1), Vw la vitesse dans l’eau

(1500 ms-1) et Vs la vitesse dans la fraction solide. Cette dernière vitesse ne correspond pas à

la vitesse dans les cristaux (de quartz, calcite ou autres) mais a été définie à partir de

l’expérimentation. On peut l’appeler, « vitesse dans le solide en grain ou dans le squelette».

Pour un squelette solide à dominante quartzeuse, elle est un peu plus faible, 6000 ms-1

environ, que pour un squelette solide à dominante calcaire, 6500 à 7000 ms-1. Cette

expression montre toute l’importance qu’a la fraction gazeuse dans la vitesse totale : une

teneur de 10% en gaz peut diviser par 2 la vitesse des ondes de compression. Les argiles

saturées et consolidées ont une vitesse comprise entre 2500 et 3000 ms-1.

Les milieux les plus lents que l’on puisse rencontrer correspondent aux couches

superficielles non-saturées dont la vitesse peut être aussi faible que 750 ms-1, voire moins

pour des couches superficielles. Les milieux les plus rapides correspondent aux dolomies et

surtout aux formations cristallines saines (granites en place) dont la vitesse est de 6500 ms-1.

La plage totale de variation est d’un facteur proche de 10, bien supérieur à celle présentée par

la densité qui n’est que d’un facteur 2.

Les tableaux ci-après montrent les corrélations qui ont été observées entre la vitesse

des ondes P dans la couche superficielle et la rippabilité du terrain, et donnent une ensemble

de valeurs observées pour les différents minéraux et les sols.

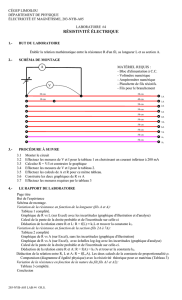

3-1-3 Propriétés électriques ρ, σ, ε

Pour pouvoir rendre compte des phénomènes observés lorsqu’on applique sur un

matériau un champ électrique deux propriétés indépendantes doivent être considérées : la

conductivité électrique qui caractérise les déplacements « libres » des charges électriques sur

des distances « macroscopiques » et la permittivité électrique relative qui caractérise la

polarisation électrique du matériau. Cette deuxième propriété recouvre plusieurs types de

4

phénomènes différents, « déformations » de molécules ou du réseau, rotations de molécules,

déplacements de charges sur de faibles distances (au plus à l’échelle du pore).

La conductivité, σ, est définie par la loi d’Ohm, i=σE, où i est la densité de courant,

c’est à dire la somme des charges traversant la surface unité pendant l’unité de temps, E le

champ électrique. La conductivité s’exprime en Sm-1. Plutôt que la conductivité, on utilise en

prospection son inverse la résistivité : ρ=1/σ ( en Ω.m).

La permittivité diélectrique relative, εr, est définie par D=ε0 E+P=ε0εrE, où D est le

vecteur induction électrique, P la polarisation électrique, ε0 la permittivité diélectrique du

vide, ε0=1 /(36π109) Fm-1. La permittivité relative est sans unité.

Pour le mécanicien en général et le géotechnicien en particulier, les notations utilisées dans le

domaine des méthodes électriques peuvent créer des difficultés. On veillera ainsi à ne pas

confondre le champ électrique avec le module d’Young, la conductivité avec le coefficient de

Poisson, la résistivité avec la masse volumique et la permittivité diélectrique avec un

déplacement.

3-1-3-1 Conductivité (ou résistivité) électrique, σ, ρ

L’analyse de la variation de la résistivité d’une roche ou d’un sol avec la température

montre sans ambiguïté qu’elle décroît quand la température augmente. On a donc affaire à une

conductivité électrolytique où la baisse de la viscosité du fluide avec la température rend plus

facile le déplacement des ions. Pour une solution de chlorure de sodium (les ions les plus

abondants dans le sous-sol) on a :

σ(T)=σ(T0)(1+(T-T0) 0,02),

où la température est comptée en degré Kelvin (ou Celsius).

Cependant l’expérience montre que souvent le déplacement d’ions dans l’eau interstitielle ne

peut suffire à expliquer les valeurs obtenues et, qu’en présence de matériaux fins (argiles), la

conductivité est notablement plus élevée. On tient compte de ce fait en séparant les cas de

roches ou de sols grossiers des cas où intervient de l’argile.

5

a) Milieux sans argile, loi d’Archie

Dans ce type de milieu on observe une proportionnalité directe entre la résistivité

totale d’un échantillon, ρt, et la résistivité de l’eau qu’il contient, ρw. Le rapport

w

t

F

ρ

ρ

=, est

appelé « facteur de formation ».

Pour un milieu saturé, ce facteur est lié à la porosité par une formule du type

F=n-m,

à laquelle on peut ajouter un coefficient multiplicatif. Cette loi empirique est la loi d’Archie

(1942). Le coefficient m est toujours proche de 2, il dépend de la complexité du parcours des

ions dans le réseau poreux, on l’appelle coefficient de tortuosité ou de cimentation. Pour un

milieu non-saturé on aura

F=(nSr)-m,

mais il est aussi possible d’introduire deux exposants légèrement différents, l’un pour n,

l’autre pour Sr.

Si les grains se rapprochent d’une forme sphérique, m est plutôt inférieur à 2 (grès,

sable), si les grains se rapprochent d’une forme « en plaquette », il est plutôt supérieur à 2.

b) Milieux avec argile

Dans les matériaux fins il faut tenir compte d’un phénomène de conduction

« surfacique » qui s’explique de la façon suivante (théorie de la « double couche » de Gouy-

Chapman) : en bordure des grains, les sites d’arrêt du réseau cristallin sont favorables à la

fixation d’anions qui se trouvent ainsi liés de manière rigide au réseau. C’est aussi le cas des

feuillets d’argile (smectite) qui sont chargés négativement. La surface négativement chargée

attire par effet électrostatique des cations qui se placent à l’extérieur de la couche d’anions

mais qui restent libres de glisser dans les directions tangentes à la surface. Le déplacement de

ces cations correspond à une « conductivité surfacique ». Dans les matériaux grossiers où la

surface spécifique est faible, cet effet est négligeable, mais dans les matériaux fins cet effet est

dominant. Ces cations sont les mêmes que ceux qui interviennent dans la mesure de la

capacité d ‘échange cationique (C.E.C.) méthode de mesure du contenu en argile d’un sol.

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

34

34

35

35

36

36

37

37

38

38

39

39

1

/

39

100%

![Rôle et optimisation des prises de terre [Sifoee]](http://s1.studylibfr.com/store/data/001083412_1-b28789a190bf4a5727eaa349cd653b34-300x300.png)

![[43] Mesures de terre](http://s1.studylibfr.com/store/data/003076158_1-dbbfde993ee94446213553e1bf6db82e-300x300.png)