Bonnes pratiques et optimisation

Bonnes pratiques et

optimisation

Ministère de l'Écologie, du Développement

durable et de l'Énergie

Licence ETALAB

Version 1.0.0

1er mars 2016

Table des

matières

Objectifs 3

Introduction 4

I - Installation du serveur PostgreSQL/PostGIS 5

II - Paramétrage du serveur PostgreSQL pour l'exploitation des données

spatiales 8

III - Bonnes pratiques de sécurité 14

IV - Optimisation de la gestion de la base de données 16

V - Optimisation des requêtes SQL 19

Contenus annexes 22

3

Les objectifs du module sontde:

Savoir installer correctement le serveur PostgreSQL/PostGIS

Optimiser le paramétrage du serveur pour l'exploitation des données spatiales

Connaître et appliquer les bonnes pratiques de sécurité (intrusion, intégrité des données)

Savoir optimiser la gestion de la base de données spatiale

Savoir optimiser les requêtes SQL

Objectifs

4

Le temps d'apprentissage de ce module est estimé à 2 heures et 30 minutes.

Il ne comporte pas d'exercices mais fournit des informations importantes sur l'optimisation et la sécurité.

Introduction

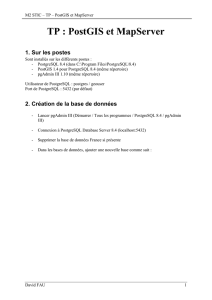

Installation du serveur PostgreSQL/PostGIS

5

Les informations qui suivent sont extraites du document PostgreSQL/PostGIS : bonnes

pratiques et astuces (portail SIG)

http://www.portailsig.org/content/postgresql-postgis-bonnes-pratiques-et-astuces

et du support de formation réalisé par Christophe Masse et Didier Leclerc, CMSIG.

Fondamental

Le paramétrage du serveur PostgreSQL est enregistré dans le fichier de configuration

postgresql.conf

Seul l'administrateur du serveur peut changer les paramètres du serveur et modifier le fichier

postgresql.conf

Le serveur PostgreSQL doit être relancé pour appliquer les modifications de configuration

1 - Choisir un port différent de celui par défaut (5432)

Cette mesure de sécurité basique est surtout conseillée dans le cadre d'une ouverture vers le

web.

Méthode

Dans le fichier de configuration postgresql.conf, changer la valeur port=5432

Installation du

serveur

PostgreSQL/PostGIS

I

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

34

34

35

35

36

36

37

37

38

38

39

39

40

40

1

/

40

100%