memoire

1

REPUBLIQUE ALGERIENNE DEMOCRATIQUE ET POPULAIRE

MINISTERE DE L’ENSEIGNEMENT SUPERIEUR ET DE LA RECHERCHE SCIENTIFIQUE

Université Mouloud Mammeri de Tizi-ouzou

Faculté de Génie Electrique et Informatique

Département d’Informatique

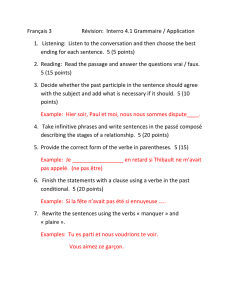

MEMOIRE

Pour obtenir le diplôme de

MAGISTER

Option : Systèmes Informatiques

Présenté et soutenu publiquement par

Mr. RAHMANI Rabah

Découverte d’associations sémantiques dans les

bases de données relationnelles par des méthodes

de Data Mining

Proposé et dirigé par

Mr. DJOUADI Yassine-Mansour

Maître de Conférences

JURY :

Mr. RASSOUL Idir Maître de conférences Classe A, UMMTO Président

Mr. DJOUADI Yassine-Mansour Maître de conférences Classe A, UMMTO Rapporteur

Mme. AMIROUCHE Fatiha Maître de conférences Classe B, UMMTO Examinatrice

Mr. SADI Bachir Maître de conférences Classe A, UMMTO Examinateur

2

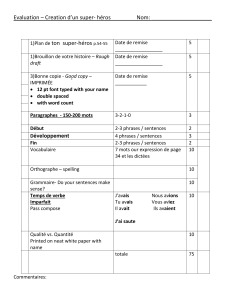

Table des matières

Introduction ............................................................................................................................ 4

Chapitre 1

Introduction à l’extraction de connaissances......................................................................... 6

1.1 Introduction...................................................................................................................... 7

1.2 Processus général du KDD............................................................................................... 7

1.3 Les tâches du Data-Mining. ........................................................................................... 11

1.4 Les outils du Data-Mining.............................................................................................. 12

1.5Conclusion....................................................................................................................... 18

Chapitre 2

Le modèle relationnel............................................................................................................. 19

2.1 Les concepts du modèle ................................................................................................ 20

2.2 Algèbre relationnelle..................................................................................................... 23

2.3 Conclusion..................................................................................................................... 26

Chapitre 3

Découverte de règles d’associations et de dépendances fonctionnelles. ............................ 27

3.1. Introduction.................................................................................................................. 28

3.2. Découverte de règles d’association basées sur les fréquents. ......................................28

3.3 Découverte de dépendances fonctionnelles................................................................... 31

3.4 Conclusion..................................................................................................................... 34

Chapitre 4

Découverte de dépendances multivaluées. ........................................................................... 35

4.1 Introduction.................................................................................................................... 36

4.2 Définition et propriétés des dmvs................................................................................... 39

4.3 Stratégies de découverte de dmv.................................................................................... 41

4.4 Conclusion...................................................................................................................... 51

Chapitre 5

Proposition d’une méthode découverte de dépendances multivaluées.............................. 52

5.1 Introduction................................................................................................................... 53

3

5.2 Présentation de la méthode............................................................................................. 53

5.3 Enumération des dmvs candidates. ................................................................................ 54

5.4 Description de la proposition. ........................................................................................ 56

5.5 Conclusion...................................................................................................................... 69

Conclusion............................................................................................................................... 70

Bibliographie........................................................................................................................... 71

4

Introduction

L’apparition du modèle relationnel de données, (Codd, 1970), a constitué une avancée

méthodologique décisive pour les informaticiens dans leur métier de conception et de

réalisation d’applications, à tel point qu’il est pratiquement le seul à être utilisé de nos jours.

Ce modèle fournit, pour la première fois, grâce à ses fondements mathématiques solides, la

possibilité de dissocier nettement et de façon sûre leur effort de représentation des données de

celui d’écriture des programmes de traitements car il offre simultanément le moyen de

représentation des données, la relation, et le moyen de leur manipulation, l’algèbre

relationnelle, assurant ainsi ce qui était recherché à l’époque: l’indépendance entre données et

traitements.

Dès lors, l’effort de représentation des données constitua la part prépondérante dans la

construction d’une base de données et la recherche s’orienta alors vers l’enrichissement du

modèle de représentation, lui exigeant d’être de plus en plus fidèle à la réalité représentée ; en

quelque sorte d’être plus «sémantique». C’est ainsi que les années 1970 et 1980 virent la

proposition de plusieurs modèles sémantiques (Codd, 1979) (Hammer, 1978) (Peckham,

1988) (Smith, 1977) etc.

Dans ce mémoire on s’intéressera au premier niveau de sémantique, capté à travers les

contraintes entre les valeurs des attributs, donnant naissance à la notion de dépendances entre

données.

CODD, lui-même, énonça les premières associations sémantiques de son modèle en

établissant les dépendances fonctionnelles et la notion de normalisation de relations (Codd,

1972). D’autres dépendances furent ensuite proposées : dépendances multivaluées

dépendances de jointure, etc. (Fagin, 1977) (Fagin, 1979).

Typiquement, la construction d’une base de données commence par l’élaboration de

son schéma conceptuel. Cette activité, intuitive au départ, puis plus ou moins formalisée

dans ses étapes suivantes, consiste à déduire de la réalité à modéliser des attributs à

regrouper sous forme de relations. Ce regroupement est effectué en se fondant sur

certaines propriétés générales concernant les valeurs des attributs ; ce sont les énoncés de

dépendance (fonctionnelle, multivaluée, de jointure, etc.).

Les données factuelles sont alors progressivement ajoutées, modifiées ou supprimées dans

la base de données répondant à ce schéma par le biais d’un système de gestion de bases de

données.

La qualité et la durée de vie d’une base de données obtenue grâce à cette démarche sont

tributaires, non seulement de la sagacité de son concepteur mais aussi de l’évolution de

la réalité qui est difficile à maîtriser. Le concepteur a-t-il oublié une dépendance ? A-t-il

utilisé une dépendance démentie par la réalité des données ?

C’est lorsque l’on constate des anomalies d’insertion, de mise à jour, de suppression,

que l’on est amené à se poser ces questions.

Un moyen d’y répondre est de « fouiller » dans les données factuelles de la base de

données afin de découvrir ces dépendances.

C’est pour cela que ce travail entre dans le cadre général de ce qui est désigné par

« découverte de connaissances dans les données ».

L’intitulé de ce domaine suggère, qu’à partir de données de plus en plus nombreuses et

faciles d’accès, on peut extraire quelques «pépites» précieuses que sont les

connaissances.

5

Plus précisément, la découverte de connaissances dans les données, est maintenant un

domaine bien établi et délimité ; il possède ses propres méthodes et fait appel à des outils

bien précis.

Aussi, notre travail concerne la découverte de dépendances multivaluées entre

attributs d’une relation déjà enregistrée.

Outre cette introduction et une conclusion, ce mémoire comporte cinq chapitres.

Le premier est une introduction au processus de découverte de connaissances dans les

données avec sa définition et ses différentes étapes.

Dans le deuxième chapitre on décrira le modèle relationnel de données en mettant

l’accent sur les dépendances fonctionnelles.

Le chapitre trois introduit quelques méthodes de découverte de dépendances

fonctionnelles et de règles d’association.

Le chapitre quatre donne le détail sur les dépendances multivaluées et sur deux

méthodes de leur découverte.

Enfin le chapitre cinq concerne notre contribution à la découverte de dépendances

multivaluées par la présentation de notre algorithme

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

34

34

35

35

36

36

37

37

38

38

39

39

40

40

41

41

42

42

43

43

44

44

45

45

46

46

47

47

48

48

49

49

50

50

51

51

52

52

53

53

54

54

55

55

56

56

57

57

58

58

59

59

60

60

61

61

62

62

63

63

64

64

65

65

66

66

67

67

68

68

69

69

70

70

71

71

72

72

73

73

1

/

73

100%