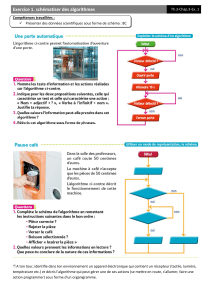

Algorithmes d`apprentissage par renforcement

Master MVA: Apprentissage par renforcement Lecture: 2

Algorithmes d’apprentissage par renforcement

Professeur: Rémi Munos http://researchers.lille.inria.fr/∼munos/master-mva/

Références bibliographiques:

•Sutton et Barto, Reinforcement Learning, an introduction, 1998.

•Bertsekas et Tsitsiklis, Neuro-Dynamic Programming, 1996.

•Livre PDMIA, chapitre 2.

•Sutton, Learning to predict by the method of temporal differences, 1988.

•Watkins et Dayan, Q-learning, 1992.

•Jaakola, Jorda et Singh, On the convergence of Stochastic Iterative Dynamic Programming Algorithms,

1994.

Problématique de l’apprentissage par renforcement: Les probabilités de transition et les récompenses

sont initialement inconnues de l’agent. Différentes hypothèses sont possibles pour explorer l’environnement

tout en permettant la convergence vers une politique optimale:

•Apprentissage en-ligne: l’agent se trouve en un état xt, choisit une action at, observe une récom-

pense rt=r(xt, at)et se retrouve en xt+1 ∼p(·|xt, at), et recommence. Pour espérer apprendre une

stratégie optimale il faut s’assurer que le PDM permet de revenir à un état où on peut obtenir le

taux optimal de récompenses même si on fait des actions (exploration) sous-optimales au début. Voir

algorithme UCRL [Auer et al. 2006-2009]

•Apprentissage épisodique: On génére une séquence d’épisodes où à chaque étape on on suit une

politique pendant un certain temps (éventuellement aléatoire), ce qui nous permet d’explorer, puis on

réinitialise l’état et on passe à l’épisode suivant.

•Apprentissage avec modèle génératif: On dispose d’un simulateur de l’environnement (type boîte

noire) qui permet, en entrant xet a, de générer une récompense r=r(x, a)et un état suivant y∼

p(·|x, a).

1 Préliminaires: outils statistiques

1.1 Rappels sur les modes de convergence de variables aléatoires

Soient X, X1, X2,... des v.a. Alors

(a) Xnconverge presque sûrement vers X,Xn

p.s.

−→ X, si

P( lim

n→∞ Xn=X) = 1,

1

2Algorithmes d’apprentissage par renforcement

(b) Xnconverge vers Xen probabilité, Xn

P

−→ X, si pour tout ² > 0,

lim

n→∞

P[|Xn−X|> ²]=0,

(c) Xnconverge vers Xen loi (ou en distribution), Xn

D

−→ X, si pour toute fonction fcontinue, bornée,

lim

n→∞

E[f(Xn)] = E[f(X)].

On a les propriétés: Xn

p.s.

−→ X=⇒Xn

P

−→ X=⇒Xn

D

−→ X.

1.2 Inégalité de Chernoff-Hoeffding

Inégalité de Markov:

Proposition 1.Soit Yune v.a. positive. Alors pour tout a > 0,

P(Y≥a)≤EY

a.

Proof. On a P(Y≥a) = E[1{Y≥a}] = E[1{Y/a ≥1}]≤E[Y/a].

Inégalité de Hoeffding:

Proposition 2.Soit Yune v.a. centrée à valeurs dans [a, b]. Alors pour tout s∈R,

E[esY ]≤es2(b−a)2/8.

Proof. Par convexité de l’exponentielle, on a pour tout a≤x≤b,

esx ≤x−a

b−aesb +b−x

b−aesa.

En notant p=−a/(b−a)on a

Eesx ≤b

b−aesa −a

b−aesb

= (1 −p+pes(b−a))e−ps(b−a)=eφ(u)

avec u=s(b−a)et φ(u) = −pu + log(1 −p+peu). La dérivée de φest φ0(u) = −p+p

p+(1−p)e−u. De plus

φ(0) = φ0(0) = 0. De plus, φ00(u) = p(1−p)e−u

(p+(1−p)e−u)2≤1/4.

Donc d’après le théorème de Taylor, il existe θ∈[0, u]tel que

φ(u) = φ(0) + uφ0(0) + u2

2φ00(θ)≤u2

8=s2(b−a)2

8.

Algorithmes d’apprentissage par renforcement 3

Inégalité de Chernoff-Hoeffding

Proposition 3.Soient Xi∈[ai, bi]variables aléatoires indépendantes. Soit µi=EXi. Alors

P¡¯

¯

n

X

i=1

Xi−µi¯

¯≥²¢≤2e−2²2

Pn

i=1(bi−ai)2.(1)

Proof. On a:

P(

n

X

i=1

Xi−µi≥²) = P(esPn

i=1 Xi−µi≥es²)

≤e−s²E[esPn

i=1 Xi−µi],par Markov

=e−s²

n

Y

i=1

E[es(Xi−µi)],par indépendence des v.a.

≤e−s²

n

Y

i=1

es2(bi−ai)2/8,par Hoeffding

=e−s²+s2Pn

i=1(bi−ai)2/8

En choisissant s= 4²/ Pn

i=1(bi−ai)2on déduit P¡Pn

i=1 Xi−µi≥²¢≤e−2²2

Pn

i=1(bi−ai)2. En refaisant le même

calcul pour P¡Pn

i=1 Xi−µi≤ −²¢on déduit (1).

2 Approximation stochastique pour l’estimation d’une moyenne

2.1 Monte-Carlo

Soit Xune variable aléatoire de moyenne µ=E[X]et de variance σ2=Var[X]. Soient xn∼Xdes

réalisations i.i.d. Définissons la moyenne empirique

µn=1

n

n

X

i=1

xi.

Alors E[µn] = µ, Var[µn] = Var[X]

n, et on a

•Loi faible des grands nombres: µn

P

−→ µ.

•Loi forte des grands nombres:µn

p.s.

−→ µ.

•Théorème Central Limite:√n(µn−µ)D

−→ N(0,Var[X]).

2.2 Estimation d’une moyenne inconnue

Soit Xune variable aléatoire à valeurs dans [0,1], de moyenne µ=E[X]inconnue que l’on souhaite estimer.

Soit xn∼Xdes réalisations i.i.d. Soit l’estimateur µnconstruit selon: µ1=x1, et pour n > 1,

µn= (1 −ηn)µn−1+ηnxn(2)

où (ηn)sont des pas d’apprentissage.

4Algorithmes d’apprentissage par renforcement

Proposition 4.Sous l’hypothèse que les pas sont positifs et vérifient

X

n≥0

ηn=∞,(3)

X

n≥0

η2

n<∞,(4)

alors on a µn

p.s.

−→ µ. (on dit que l’estimateur µnest consistant).

Remarque: Les pas ηn=1

nsatisfont les conditions précédentes, et on a alors la moyenne empirique

µn=1

nPn

i=1 xi. La loi forte des grands nombres est donc une conséquence de cette proposition.

Lemme de Borel-Cantelli: Si (En)n≥1est une suite d’événements tels que Pn≥1P(En)<∞, alors la

probabilité qu’une infinité d’entre eux se réalisent simultanément est nulle.

Proof. Si la probabilité qu’une infinité Ed’entre eux se réalisent était ≥a > 0, alors la probabilité que

chaque Ei∈ E se réalise serait ≥aet donc Pn≥1P(En)≥PEn∈E a=∞.

Preuve de la proposition 4. Preuve partielle. Nous allons considérer uniquement des pas ηn=n−αavec

α≤1(afin de satisfaire (3)) et α > 1/2(afin de satisfaire (4)). La preuve générale peut être trouvée dans

On Stochastic Approximation, Dvoretzky, 1956.

Cas α= 1 (i.e. µnest la moyenne empirique des xi). D’après l’inégalité de Chernoff-Hoeffding, on a

P¡¯

¯µn−µ¯

¯≥²¢≤2e−2n²2.(5)

Nous utilisons le lemme de Borel-Cantelli avec les évènements En={¯

¯µn−µ¯

¯≥²}. On déduit de (5)

que Pn≥1P(En)est finie et donc qu’avec probabilité 1, il n’existe qu’un nombre fini d’instants ntels que

¯

¯µn−µ¯

¯≥². On choisit une suite d’²k→O. Donc pour tout ²k, il existe nktel que pour P(∀n≥nk,¯

¯µn−µ¯

¯≤

²k)=1. L’union dénombrable d’évènements de mesure nulle est toujours de mesure nulle, donc

P(∀k, ∃nk,∀n≥nk,¯

¯µn−µ¯

¯≤²k) = 1,

ce qui est la définition que limn→∞ µn=µpresque sûrement.

Cas 1/2< α < 1.Nous écrivons

µn=

n

X

i=1

λixi,avec

n

X

i=1

λi= 1,(6)

avec λi=ηiQn

j=i+1(1 −ηj). On a

log λi= log ηi+

n

X

j=i+1

log(1 −ηj)≤log ηi−

n

X

j=i+1

ηj

donc λi≤ηie−Pn

j=i+1 ηj.

Algorithmes d’apprentissage par renforcement 5

Nous bornons maintenant la somme des amplitudes au carré: pour tout 1≤m≤n,

n

X

i=1

λ2

i≤

n

X

i=1

η2

ie−2Pn

j=i+1 ηj

≤

m

X

i=1

e−2Pn

j=i+1 ηj+

n

X

i=m+1

η2

i

≤me−2(n−m)ηn+ (n−m)η2

m

=me−2(n−m)n−α+ (n−m)m−2α

On choisit m=nβavec β= (1 + α/2)/2(donc 1−2αβ = 1/2−α):

n

X

i=1

λ2

i≤ne−2(1−n−1/4)n1−α+n1/2−α≤2n1/2−α

pour nassez grand.

A partir de l’écriture de µnselon (6), on utilise l’inégalité de Chernoff-Hoeffding pour déduire une majoration

de µn−µen forte probabilité:

P¡¯

¯µn−µ¯

¯≥²¢≤e−2²2

Pn

i=1 λ2

i≤e−²2

n1/2−α.

pour nassez grand.

On utilise ensuite le même argument (lemme de Borel-Cantelli) que dans le cas α= 1 (car Pn≥1P(|µn−µ| ≥

²)<∞) pour en déduire la convergence presque sûre de µnvers µ.

2.3 Autres algorithmes d’approximation stochastique

AS de Robbins-Monro (1951): Résoudre le système f(x)=0lorsque l’évaluation de la fonction fest

bruitée, i.e. en xnon observe yn=f(xn) + bnoù bnest un bruit indépendant centré. Soit:

xn+1 =xn−ηnyn.

Supposons fcroissante et notons x∗la solution. Sous les mêmes hypothèses Pηn=∞,Pη2

n<∞, on a la

convergence xn

p.s.

−→ x∗.

AS de Kiefer-Wolfowitz (1952): On veut trouver le minimum local d’une fonction florsque l’évaluation

de son gradient est bruité, i.e. en xn, on dispose de gn=∇f(xn) + bn. Alors:

xn+1 =xn−ηngn.

alors sous les mêmes hypothèses sur (ηn)(et une condition de positivité de la Hessienne ∇2f), on a xn

p.s.

−→ x∗

avec x∗minimum de f. Il s’agit d’un algorithme de gradient stochastique.

2.4 Approximation stochastique de point fixe

Lorsque Test un opérateur contractant, nous avons vu que l’algorithme d’itérations sur les valeurs: Vn+1 =

TVngénère une séquence de fonctions qui converge vers V∗.

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

1

/

13

100%