Cahier d'études: Fonctionnement et évolution des ordinateurs

CAHIER D’ETUDES

ET DE RECHERCHE

Nom :

Prénom :

Promo : PO58X201

1er cycle CDIL

Electronique

Date de création :

Page 1 sur 19

1 PROBLEMATIQUE RETENUE 2

Comprendre le fonctionnement et l’évolution d’un ordinateur.

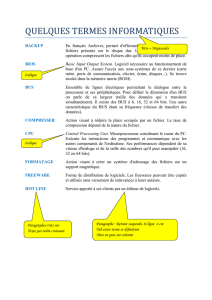

2 DEFINITIONS 2

Présentation des savants :

Pascal : né le 19 Juin 1623 à Clermont

Blaise Pascal, marqué par la mort prématurée de sa mère, a été élevé aux côtés de ses deux

soeurs : c'est un enfant surdoué, de santé très fragile mais d'une précocité étonnante, d'une

grande curiosité et d'une intelligence hors du commun. Il est d'abord un jeune savant connu

pour ses travaux mathématiques et physiques, et publie à 17 ans un traité de géométrie, Essai

sur les coniques (1640)

(Blaise Pascal)

Babbage : né le 26 Décembre 1791 à Teignmouths (Angleterre).

Charles Babbage a été le premier à énoncer le principe de l'ordinateur. Il travailla une grande

partie de sa vie à la construction d'un ordinateur mécanique qu'il appelait machine à

différences.

Il n'arriva jamais à l'achever mais une partie du mécanisme est exposée au Musée de la

Science de Londres. En 1991, à partir de ses plans on a pu reconstruire une partie de cette

machine, qui fonctionna parfaitement. Pour la reconstruire on utilisa les tolérances qui étaient

disponibles au XIXe siècle, ce qui nous porte à croire qu'elle aurait pu être construite du

vivant de Babbage sous réserve de disposer d'une force motrice suffisante et de métaux assez

résistants.

CAHIER D’ETUDES

ET DE RECHERCHE

Nom :

Prénom :

Promo : PO58X201

1er cycle CDIL

Electronique

Date de création :

Page 2 sur 19

Turing : né le 13 Mai 1972 a Londres.

Alan Mathison Türing est pourtant le père des ordinateurs modernes, au moins pour leur

partie théorique. Sa contribution à la victoire des alliés pendant la Seconde Guerre Mondiale

est décisive. Mais un suicide prématuré, peut-être "encouragé" par les autorités britanniques,

l'a plongé dans l'anonymat de l'histoire.

En 1935, il met au point le concept d'une machine universelle, qui formalise la notion de

problème résoluble par un algorithme. Cette machine de Turing est capable de calculer tout ce

qu'un processus algorithmique est capable de faire. Par essence même, les ordinateurs

modernes sont des réalisations concrètes des machines de Turing.

Von Neumann : né le 28 Décembre 1903 a Budapest.

Il est le 3ème fils d'un des plus riches banquiers de Hongrie, et vit dans un milieu intellectuel

particulièrement stimulant : les plus grands scientifiques, les écrivains les plus réputés

fréquentent le salon de ses parents. Il dispose de dons exceptionnels pour l'apprentissage

Durant la seconde guerre mondiale, il perçoit, lors de la réalisation de la bombe, l'importance

à venir des machines électroniques pour réaliser des calculs insurmontables à la main. Il

contribue de façon décisive à la mise en oeuvre des premiers ordinateurs. Il est ainsi le

premier à avoir l'idée que le programme doit être codé et rangé dans la mémoire de la

machine à côté des données des calculs. En particulier, une seule machine peut réaliser toute

sorte de calculs différents. Ce modèle dit de Von Neumann préside toujours à la conception

des ordinateurs modernes.

CAHIER D’ETUDES

ET DE RECHERCHE

Nom :

Prénom :

Promo : PO58X201

1er cycle CDIL

Electronique

Date de création :

Page 3 sur 19

L’architecture de Von Neumann décompose l’ordinateur en 4 parties

distinctes

1. L’unité arithmétique et logique (UAL) ou unité de traitement : son rôle est d’effectuer

les opérations de base ;

2. L’unité de contrôle, chargée du séquençage des opérations ;

3. La mémoire qui contient à la fois les données et le programme qui dira à l’unité de

contrôle quels calculs faire sur ces données. La mémoire se divise entre mémoire

volatile (programmes et données en cours de fonctionnement) et mémoire permanente

(programmes et données de base de la machine).

4. Les dispositifs d’entrée-sortie, qui permettent de communiquer avec le monde

extérieur.

Sources : Wikipédia & Bibmath.net

L’instruction correspond, en informatique, a une opération élementaire qu’ un programme

demande a un processeur d’effectuer. C'est l'ordre le plus basique que peut comprendre un

ordinateur.

La collection d'instructions machine qui peuvent être données à un processeur est son jeu

d'instructions. Les instructions machine sont codées en binaire. Un champ de l'instruction

appelé « code opération » ou « opcode » désigne l'opération à effectuer. Puisque sa valeur

numérique n'a pas de sens pour les humains, le programmeur utilise une abréviation désignant

le code opération fourni par le langage assembleur pour ce processeur.

La taille d'une instruction dépend de l'architecture de la plateforme, mais elle est usuellement

comprise entre 4 et 64 bits

CAHIER D’ETUDES

ET DE RECHERCHE

Nom :

Prénom :

Promo : PO58X201

1er cycle CDIL

Electronique

Date de création :

Page 4 sur 19

On appelle « mémoire » tout composant électronique capable de stocker temporairement des

données. On distingue ainsi deux grandes catégories de mémoires :

la mémoire centrale (appelée également mémoire interne) permettant de mémoriser

temporairement les données lors de l'exécution des programmes. La mémoire centrale

est réalisée à l'aide de micro-conducteurs, c'est-à-dire des circuits électroniques

spécialisés rapides. La mémoire centrale correspond à ce que l'on appelle la mémoire

vive.

la mémoire de masse (appelée également mémoire physique ou mémoire externe)

permettant de stocker des informations à long terme, y compris lors de l'arrêt de

l'ordinateur. La mémoire de masse correspond aux dispositifs de stockage

magnétiques, tels que le disque dur, aux dispositifs de stockage optique, correspondant

par exemple aux CD-ROM ou aux DVD-ROM, ainsi qu'aux mémoires mortes.

Une mémoire présente principalement 5 caractéristiques :

Sa capacité -> volume global d’informations pouvant être stocké, exprimée en bits

Son temps d’accès -> correspond au temps écoulé entre la demande (lecture/écriture)

et la disponibilité de la donnée.

Son temps de cycle -> correspond au temps minimum écoulé entre deux accès

succéssifs.

Son débit -> correspond au volume d’informations échangé par unité de temps (en

bits/sec)

Sa non volatilité -> correspond a l’aptitude de la mémoire a conserver des données

lorsqu’elle n’est plus alimentée en électricité.

La mémoire vive, généralement appelée RAM (Random Access Memory, traduisez mémoire

à accès direct), est la mémoire principale du système, c'est-à-dire qu'il s'agit d'un espace

permettant de stocker de manière temporaire des données lors de l'exécution d'un programme.

En effet, contrairement au stockage de données sur une mémoire de masse telle que le disque

dur, la mémoire vive est volatile, c'est-à-dire qu'elle permet uniquement de stocker des

données tant qu'elle est alimentée électriquement. Ainsi, à chaque fois que l'ordinateur est

On distingue généralement deux grandes catégories de mémoires vives :

Les mémoires dynamiques (DRAM, Dynamic Random Access Module), peu

coûteuses. Elles sont principalement utilisées pour la mémoire centrale de l'ordinateur

;

CAHIER D’ETUDES

ET DE RECHERCHE

Nom :

Prénom :

Promo : PO58X201

1er cycle CDIL

Electronique

Date de création :

Page 5 sur 19

Les mémoires statiques (SRAM, Static Random Access Module), rapides et

onéreuses. Les SRAM sont notamment utilisées pour les mémoires cache du

processeur ;

Fonctionnement de la mémoire vive :

La mémoire vive est constituée de centaines de milliers de petits condensateurs emmagasinant

des charges. Lorsqu'il est chargé, l'état logique du condensateur est égal à 1, dans le cas

contraire il est à 0, ce qui signifie que chaque condensateur représente un bit de la mémoire.

Etant donné que les condensateurs se déchargent, il faut constamment les recharger (le terme

exact est rafraîchir, en anglais refresh) à un intervalle de temps régulier appelé cycle de

rafraîchissement. Les mémoires DRAM nécessitent par exemple des cycles de

rafraîchissement est d'environ 15 nanosecondes (ns).

Chaque condensateur est couplé à un transistor (de type MOS) permettant de « récupérer » ou

de modifier l'état du condensateur. Ces transistors sont rangés sous forme de tableau

(matrice), c'est-à-dire que l'on accède à une case mémoire (aussi appelée point mémoire) par

une ligne et une colonne.

Chaque point mémoire est donc caractérisé par une adresse, correspondant à un numéro de

ligne (en anglais row) et un numéro de colonne (en anglais column). Or cet accès n'est pas

instantané et s'effectue pendant un délai appelé temps de latence. Par conséquent l'accès à

une donnée en mémoire dure un temps égal au temps de cycle auquel il faut ajouter le temps

de latence.

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

1

/

19

100%