mini-dossiers - Collège de Maisonneuve

Projet Culture Scientifique

Julie Descheneau, département de physique

Collège de Maisonneuve

Voici un aperçu des mini-dossiers ( remis par les étudiants de Physique NYC des

groupes 6,7,8 de la session d’hiver 2008.)

Pour en savoir plus sur un sujet, double-cliquez sur l’image du résumé (pages suivantes)

et le document s’ouvrira.

DESJARDINS-D., Daphnée,

HAMEL, Élyse

et

LEFEBVRE, Myriam

La Terre est pourvue d’un champ magnétique qui influence la vie des organismes

vivants. Saviez-vous que celui-ci s’est déjà inversé il y a 780 000 ans et que cela pourrait

se reproduire d’ici 2000 ans? Il intéressant de noter les divers impacts qu’auraient un tel

phénomène. Celui-ci peut être provoqué de deux manières différentes. Certains

scientifiques affirment que l’inversion des pôles sera spontanée et d’autres croient qu’elle

sera due à l’impact d’une comète. Suite à cette collision, les pôles pourraient s’inverser

ou retourner tout simplement à leur origine. Mais tous s’entendent pour dire que peu

importe la manière dont le champ se déplace, il y aura d’abord une absence de champ

magnétique pour une durée approximative de quelques semaines. Selon des spécialistes,

cette absence entraînerait la disparition de la protection de la ceinture magnétique de la

Terre. Suite à cette disparition, les vivants ne seraient plus protéger contre les

bombardements cosmiques. Ceci pourrait provoquer l’extinction de plusieurs espèces ou

la création de nouvelles espèces par mutation génétique.

Cette inversion affecterait particulièrement certains animaux qui s’orientent grâce

au champ magnétique. Nous nous sommes penchées sur le cas des pigeons voyageurs et

des oiseaux migrateurs, mais nous aurions pu vous parler des abeilles, des baleines, des

tortues de mer et même de certaines bactéries. Contrairement aux humains, les pigeons

possèdent réellement un sixième sens. En effet, il ne s’oriente pas seulement avec la

vision et l’olfaction, mais aussi avec le sens magnétique. Après plusieurs expériences, des

scientifiques ont émis l’hypothèse que des microcristaux de magnétites situés dans la

boîte crânienne sont la cause de leur sensibilité magnétique. Les oiseaux migrateurs n’ont

pas seulement le sens magnétique, ils ont aussi une sensibilité aux différentes longueurs

d’onde de la lumière. Par exemple, lors d’une expérience un chercheur a remarqué que

les rouges-gorges qui étaient éclairés par de la lumière jaune étaient désorientés pour leur

migration. La lumière dérange leur perception magnétique ce qui les faits déviés de leur

trajectoire habituelle. De plus, l’intensité de la lumière les fait tous converger vers une

GAGNÉ, Antoine

GERARDI, Savannah

LABERGE GOUPIL, Mathieu

L’antimatière

Le sujet de notre recherche scientifique, dans le cadre du cours de physique NYC,

n’est certainement pas un phénomène que tous reconnaissent. L’antimatière suscite beaucoup

d’intérêt au sein des sociétés scientifiques.

Sur la planète Terre, nous sommes entourés et constitués de matière. Cette dernière

porte une charge. Le terme « antimatière » a été choisi pour ce phénomène pour indiquer

qu’elle est entre autres l’opposé de la matière. Ceci signifie que l’antimatière porte une

charge de signe contraire de la charge de la matière. Il est important de mentionner que la

matière est sur terre et que l’antimatière est dans l’Univers, à l’au-delà de notre « visibilité ».

Par contre, de nombreuses théories affirment que l’Univers est constitué de plus de matière

que d’antimatière. Une explication qui puisse soutenir ce fait n’a pas encore fait surface dans

le domaine des sciences physiques, mais plusieurs croient que ce problème soit originaire du

Big Bang. Lors de cette « explosion », la matière et l’antimatière étaient présentes à quantité

égales. Pour une raison encore ignorée, la quantité de matière aurait pris le dessus sur celle de

l’antimatière.

La matière, étant caractérisée par des particules positives (les protons) et des particules

négatives (les électrons), est l’opposé de l’antimatière (comme mentionné ci-haut). Ceci nous

indique donc que les protons (+) de la matière deviennent négatifs (les antiprotons) dans

l’antimatière et que les électrons (-) de la matière deviennent positifs (les positrons) dans

l’antimatière. La réaction matière-antimatière occasionne un très grand dégagement d’énergie

suivant E=mc2. La matière et l’antimatière, une fois en contact, s’annihilent. Cette

transformation de l’énergie a lieu lorsqu’une particule de la matière rencontre son opposé de

l’antimatière (exemple : positron + électron = ÉNERGIE). Cette réaction devrait égaliser les

quantités de matière et d’antimatière existantes dans l’Univers, mais ce n’est tout de même

pas le cas.

Résumé de l’article 1

Des chercheurs ont découvert que le centre de la voie lactée émet 511 KeV d’énergie

sous forme de photons gamma. Cela correspond exactement à l’énergie émise par

l’annihilation d’un électron par son antiparticule : le positron. Des chercheurs ont donc tenté

de découvrir l’origine de la quantité immense d’antimatière nécessaire pour que ce

phénomène ait lieu. Ils ont tout d’abord posé l’hypothèse de la matière noire. Pour quelle soit

confirmée, le centre de la galaxie devait être symétrique au niveau énergétique. Ces les

positrons pouvaient provenir de l’annihilation de particules exotiques de matière noire dans le

halo central symétrique de la galaxie. Il pouvait s'agir de neutralinos, ou de particules

massives de Kaluza-Klein, de mini trous noirs ou de supernovas. Or, le satellite a révélé un

flux deux fois plus intense d’un coté du centre galactique que de l’autre. Des astres de la

classe binaire X seraient donc les sources plus probables de l’antimatière. Ils sont composés

d’un soleil équivalent au notre et d’un trou noir ou une étoile à neutrons.

Le point sur… la radiothérapie :

La radiothérapie est une technique qui permet de soigner divers types de cancer.

Le principe est de bombarder tumeur et ganglions satellites à l’aide de rayons

électromagnétiques pour que le matériel génétique détruit empêche la régénération des

cellules malades. Les rayons X sont produits par un accélérateur de particules qui

augment la vitesse des électrons. Les électrons sont freinés par une cible de Tungstène

qui permet de convertir l’énergie en rayon X. L’utilisation des électrons est dû au fait

que ces particules peuvent passer à travers les tissus et s’arrêter en fonction de leur

énergie. De plus, le Tungstène est utilisée parce qu’il permet de prolonger cette distance.

Ensuite, un obturateur en plomb est utilisé pour formé le rayon à celle de la tumeur pour

diminuer le nombre de cellules saines touchées. Avant d’agir sur la tumeur, les

cancérologues doivent la localiser. Ils disposent de diverses méthodes comme la

curiethérapie. Cette technique consiste à implanter une source radioactive au cœur de la

tumeur. Pour arriver à l’emplacement de la tumeur, les cancérologues doivent utilisés les

cavités naturelles de l’organisme ce qui veut dire que l’accès est restreint. Ils peuvent

utilisés se bombardement de rayon X qui permet d’aller plus en profondeur et minimiser

les risques d’endommagement. La radiothérapie possède déjà des projets d’avenir pour

améliorer les traitements. Par exemple : l’utilisation de bras mécanique pour la précision,

les ions carbonés chargés remplacerons les électrons parce qu’il semble plus puissant et

permet la réduction du nombre d’exposition au rayon X.

Résumé

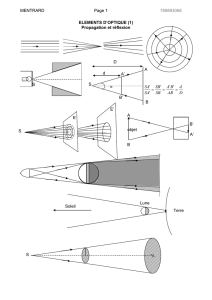

Aujourd’hui, avec tous les progrès scientifiques cumulés depuis des

années, des chercheurs veulent ériger un observatoire astronomique géant sur

la lune, rien de moins. Et c’est grâce au miroir liquide qu’ils sont prêts du but.

Cette invention a été faite en 1850 par Ernesto Cappocci, un astronome italien.

Ce dernier a remplacé un miroir normal par du mercure en rotation dans une

assiette. Il a découvert que la rotation donne au liquide une forme concave et

lui confère donc les mêmes propriétés que les miroirs concaves c’est-à-dire

converger la lumière vers le foyer. Cette invention est merveilleuse, car non

seulement les miroirs liquides sont moins lourds que ceux en verre, ils sont

moins chers et la gravité ne tend pas à les déformer, au contraire, elle leur sert

à conserver leur forme. Aussi, les liquides sont naturellement lisses et ne

requièrent donc pas un polissage interminable. Cependant, il reste un

problème à régler… sur la lune la température descend jusqu'à -231°C et le

point de fusion du mercure est de -39°C. Heureusement, Omar Seddiki et

Ermanno Borra ont découvert les liquides ioniques. Leur miroir liquide

fonctionne comme suit : il chauffe du chrome et de l’argent jusqu’à vaporisation,

par la suite, des nanogouttelettes retombe sur le ECOENG 212, un liquide

ionique. Cela donne une pellicule 2500 fois plus fine qu’un cheveu! Cette

dernière a aussi les mêmes propriétés réflectives que le mercure. Par contre,

ce liquide ionique n’est pas encore au point, car son point de fusion est de -

98°C. Mais ils sont quand même sur une bonne voie parce qu’il reste malgré

tout des millions d’autres liquides ioniques à découvrir. Grâce à cette

technologie, on pourra construire un observatoire sur la lune et plus le miroir

sera grand plus le télescope sera puissant. Avec un miroir liquide de 20m à

100m de diamètre, on pourra voir des images 100 à 1000 fois plus précises que

celles des plus puissants observatoires. Déjà sur la Terre, à l’aide des miroirs

liquides au mercure, on voie des étoiles situées à environ 10 000 années

lumières de nous. Néanmoins cette découverte permettrait des progrès

immenses dans le domaine de l’astronomie.

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

1

/

30

100%