Essai de remise a jour de la doc pour BRILL14-JL5

1

Josette Lecomte

INaLF/CNRS

décembre 1998

LE CATÉGORISEUR

BRILL14-JL5 / WINBRILL-0.3

(Catégoriseur d’Eric Brill, Université de Pennsylvanie, entraîné pour le Français à l’INaLF

PLAN provisoire :

Chapitre 1 : Présentation générale du Catégoriseur d’Eric Brill (U.Penn) p. 2

Chapitre 2 : Le Jeu d’Etiquettes retenu pour BRILL14-JL5 (INaLF) p. 4

Chapitre 3 : Critères d’assignation des étiquettes BRILL15-JL5 p. 7

Chapitre 4 : Ré-Apprentissages pour BRILL14-JL5 p. 22

Généralités p. 22

Apprentissage à l’INaLF p. 23

Chapitre 5 : BRILL14-JL5 : mode d’emploi à l’ INaLF p. 28

Appel du texte p. 28

Pré-Traitements p. 28

Etiquetage p. 29

Généralités p. 29

Modalités INaLF p. 29

Post-traitements p. 31

Index p. 33

Bibliographie p. 35

2

Chapitre 1

Présentation générale du catégoriseur d’Eric Brill entraîné à l’INaLF

1. PRÉLIMINAIRES

Un « assignateur de catégories », ou « catégoriseur » est un outil d’étiquetage automatique de textes.

C’est un « annotateur » d’un type un peu particulier, qui permet d’affecter à chaque « mot » (ou à chaque

« terme ») d’un texte, une étiquette représentative de sa catégorie grammaticale, en « langue » ou en « discours ».

Il traite donc de la classe des mots.

Il se distingue d’un « parseur » qui traite des constituants plus larges, syntagmes et propositions, au niveau de la

phrase.

2. POINT DE VUE LINGUISTIQUE

1.a - Fondements linguistiques

Le catégoriseur de Brill est fondé sur les travaux des structuralistes américains (Bloomfiels, 1933 ; Harris,

1946,1951).

E. Brill l’a décrit dans sa thèse , dirigée par Mitchell Marcus, et soutenue à l’Université de Pennsylvanie en 1993

L’idée structuraliste, reprise de Harris et de son contemporain Wells par Brill est la suivante : Il vaut mieux

approcher la description d’une langue sans idée préconçue, et se fonder sur l’observation des faits linguistiques

rencontrés. On pourra ainsi découvrir les morphèmes à partir des phonèmes, les classes de mots à partir des mots,

etc. Par des procédures de classification, on pourra repérer des distinctions significatives, et si, de plus, on utilise

des techniques d’approximation, on arrivera à affiner le repérage.

Dans l’approche de Brill, une fois qu’un « informateur humain » (linguiste de préférence) a étiqueté un petit

texte-échantillon sélectionné au hasard dans un grand corpus à étiqueter, tout l’apprentissage est automatique. Il

n’y a pas de linguiste « de terrain », expert confirmé, qui travaille avec l’informateur et peut fournir une

information « intensionnelle » sur la langue à étudier. Le système utilise une distribution « extensionnelle »,

observée par lui dans le petit échantillon qui vient d’être manuellement annoté.

En plus, cette notion de distribution extensionnelle est, d’une certaine façon, élargie : Au lieu d’examiner

seulement la distribution des entités dans un corpus, une hypothèse dite « naïve » est lancée, concernant la

structure du langage (d’où un ériquetage des mots inconnus selon cette hypothèse), puis une analyse de la

distribution des erreurs est conduite, pour mettre en lumière des transformations à effectuer en vue d’éliminer ou

tout au moins de réduire les erreurs d’étiquetage.

1.b - Fonctionnement de l’étiqueteur

Cet outil de catégorisation peut fonctionner tel quel, si on lui fournit les « arguments » adéquats à faire figurer

dans la commande d’étiquetage (par exemple, si on veut réutiliser des fichiers pré-existants) .

Il est possible aussi de partir de rien, de laisser le système apprendre (selon le mode d’emploi fourni par E. Brill ,

dans un de ses fichiers « README » ) et créer tous les fichiers intermédiaires nécessaires à la bonne exécution

de la commande finale d’étiquetage.

Cet apprentissage se fait en deux étapes.

La première aboutit à la création d’un fichier de règles (dites « lexicales ») destinées à l’étiquetage des mots

inconnus. Elle peut être presqu’entièrement automatique, avec un rôle de l’humain réduit au minimum, c’est-à-

dire au codage du texte échantillon avec un ensemble d’étiquettes de PdeD (PdeD signifie ici « Parties du

Discours ») pré-établi par l’humain ou bien obtenu avec l’aide du système. L’information est ensuite extraite de

ce corpus échantillon étiqueté, par le système, avec les méthodes de l’analyse distributionnelle.

La seconde aboutit à la création d’un fichier de règles (dites « contextuelles ») nécessaires pour affiner

l’étiquetage, c’est-à-dire tenter de revenir sur des affectations erronées. Toujours à partir du même corpus

échantillon étiqueté manuellement, le système va déduire et apprendre une série de modèles de transformations

qui seront déclenchés cette fois par l’environnement contextuel du code précédemment assigné.

3

L’étiquetage se fait aussi en deux étapes, correspondant aux deux phases d’apprentissage :

Dans la première, chaque mot du texte (simple ou reconnu comme un composé) reçoit une étiquette

correspondant à sa PdeD la plus probable dans le contexte considéré, soit par consultation du Lexique où le mot

est connu, soit par application des « règles lexicales » si le mot est inconnu au Lexique.

Dans la seconde, le système revient sur ces premières affectations, examine le contexte local, et corrige

éventuellement les étiquettes précédemment affectées. A la fin de cette seconde étape, chaque mot aura reçu une

étiquette correspondant à sa classe « en discours », c’est-à-dire en contexte ( par exemple, un mot qui,

historiquement, est un adverbe, pourra se retrouver, en contexte, étiqueté comme un nom ou un pronom).

3. POINT DE VUE INFORMATIQUE

Ce catégoriseur est un outil dont l’intérêt essentiel réside dans un « auto-apprentissage » d’une sorte de Base de

Connaissances à partir de n’importe quel type de Corpus, avec n’importe quel type d’étiquettes de PdeD (ou

autres, car rien n’interdit d’utiliser des étiquettes sémantiques ou phonologiques pour préparer le corpus-

échantillon...) , puis dans l’application à un autre plus grand corpus des connaissances apprises.

La connaissance apprise par le système sur le petit corpus-échantillon est projetée comme « probable », par le

même système, sur le plus grand corpus.

Il est « portable » sur d’autres corpus, et même sur d’autres langues que l’anglais sur lequel Brill l’a expérimenté.

La quantité d’information à lui fournir est réduite, puisqu’il apprend lui-même et automatiquement ce qu’il

estime nécessaire à la catégorisation la plus probable.

Il se présente sous forme de séries de fichiers, rangés dans des répertoires aux noms explicites, avec des fichiers

README formant un mode d’emploi clair et rigoureux.

La version 1.14 utilisée actuellement à l’INaLF (Institut National de le Langue Française)

fait suite à des versions 1.0 puis 1.10 précédemment explorées. Chaque nouvelle version a apporté des

améliorations (avec des opérateurs nouveaux, une plus grande souplesse dans l’apprentissage), favorisant une

plus grande efficacité et une meilleure convivialité avec l’utilisateur. De plus, une troisième étape de traitement

est en développement, visant à améliorer les résultats de la deuxième étape.

Cette version 1.14, entraînée à l’INaLF, y fonctionne sous UNIX et a récemment été « portée » d’Unix sous

Windows95. D’autres tests sont en cours avec Linux.

Pour la version UNIX : le logiciel, qui est celui d’Eric Brill tel quel, sans aucun ajout ni modifications est libre

d’accès selon son Copyright. Les fichiers utilisés pour son application au Français sont produits par l’INaLF.

La version portée sous Windows95 par Gilles Souvay est distribuée sous le nom de WinBrill-0.3,

moyennant signature d’une convention avec l’INaLF.

Les paramètres linguistiques qui y sont associés sont les mêmes, quelle que soit la version : Unix ou

Windows.

4

Chapitre 2 Le jeu d’étiquettes retenu pour la version BRILL14-JL5

1. LANGUE ET DISCOURS

Un de nos problèmes a été de définir à quel niveau nous allions coder le texte : Langue ? ou Discours ?

Un codage en "langue" va offrir un éventail de possibilités, en quelque sorte poser les ambiguïtés, hors contexte.

Un codage en "discours" va affecter une étiquette de PdeD selon l'emploi en contexte dans le message écrit

considéré.

Après de multiples tentatives,nous avons finalement opté pour un codage "en discours", "en contexte". Et ceci est

dû en grande partie au fait que nous voulons jouer le jeu du "taggueur" de Brill, qui se place dans cette optique.

2. QUEL SYSTÈME D'ÉTIQUETTES ?

Les analyseurs existants fonctionnent selon deux approches différentes : soit avec un ensemble d'étiquettes très

restreint, répondant aux besoins précis de l'utilisateur (ex. D.LABBE, qui travaille sur le français avec 16 codes

différents seulement), soit avec un ensemble d'étiquettes extensif, très complet, très précis, voulant fournir des

codes différents pour tous les mots ayant un comportement différent (ex. STEIN et DAMOVA à Stuttgart, avec

190 codes différents pour le traitement du français; ou encore les ensembles d'étiquettes utilisés pour l'anglais et

le codage du LOB Corpus (135) ou du London-Lund Corpus (197)).

Il y a donc deux approches : minimaliste et maximaliste, tout aussi intéressantes l'une que l'autre, et toutes deux

possibles avec un analyseur probabiliste tel que celui de Brill.

Le système d'étiquettes utilisé à l'INALF dans les Lexiques (TLFnome de MAUCOURT + PAPIN + REIMEN )

contient environ 100 codes différents pour 5 grandes catégories du discours (45 pour les verbes conjugués, 3

pour les verbes non conjugués, 4 pour les adjectifs, 4 pour les substantifs, et 47 pour la maxi-classe des "mots

grammaticaux"

(englobant pronoms, adverbes, prépositions, conjonctions, etc ...).Nous nous sommes servi de cet ensemble

d'étiquettes pour en dériver la nôtre, à partir de certaines recommandations d'E.Brill aux utilisateurs de son

catégoriseur:

Ces recommandations, (lues dans "Building a large annotated Corpus of English : The Penn Treebank" de -

Marcus, Santorini, Marcinkiewicz, 1993) sont fondées sur le codage d'un corpus de plus de 4,5 millions de mots;

cette tâche de codage selon les PdeD s'étant faite en 2 étapes : un première phase d'assignation automatique et

une seconde phase de correction par des humains.

On peut les résumer comme suit :

En fait, on peut utiliser un ensemble d'étiquettes réduit ou très détaillé si on le souhaite: tout dépend de la

stratégie choisie:

Si on pense faire de l'analyse logique et de la reconnaissance de syntagmes et de propositions

("parsing") plus tard, on peut laisser en attente des choses qu'on récupérera plus tard (par exemple, avoir

au niveau du "tagging" un code syncrétique pour englober Prépositions/Subordonnants/Coordonnants,

code que l'on désambiguïsera plus tard).

Donc, ne pas coder des subtilités récupérables par la suite dans une étape ultérieure du travail.

Si on veut pouvoir être cohérent lors de l'étape de codage manuel du corpus échantillon, il vaut mieux

réduire le nombre des étiquettes.Mais il faut que l'ensemble d'étiquettes retenu soit "optimal", avec des

codes distincts pour chaque classe de mots ayant un comportement grammatical différent en discours. Par

ex : inutile d'avoir pour l'anglais 20 codes de verbes rendant compte de cas particuliers quand 5 codes plus

généraux suffisent.

5

Il faut, si l'on veut que le système apprenne certaines règles de désambiguïsation, coder le mot selon la

fonction "syntaxique" qu'il occupe en contexte.

Par exemple : "Si" sera codé Subordonnant quand il fonctionne comme conjonction de subordination, et

Adverbe quand il fonctionne comme adverbe intensif.

Si tu veux venir -> SUB

il est si gentil -> ADV

et non avec un code syncrétique disant qu'il peut être SUB ou ADV.

Les ambiguïtés de PdeD seront résolues en contexte (le plus souvent) et s'il existe une "indécidabilité" de

la part du codeur, le système affecte l'étiquette la plus probable en fonction de ce qui se trouve au lexique,

ou de ce qui se trouve dans les règles concernant les mots inconnus.

Ceci nous a fait opter pour un jeu d’étiquettes relativement réduit, avec des critères précis pour l'affectation des

codes.

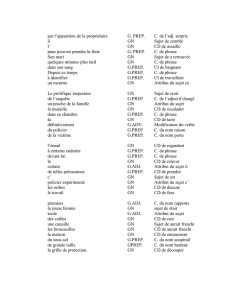

3. LES PARTIES DU DISCOURS RETENUES :

Elles sont au nombre d'une cinquantaine, non incluses les ponctuations.

Les critères définis pour leur utilisation se trouvent au chapitre suivant.

Voici la liste des étiquettes PdeD adoptées pour notre expérience BRILL14-JL5 / WINBRILL-0.3

Etiquettes

signification

ABR

Abréviation

ADJ :sg

Adjectif (sauf Participe passé) au singulier

ADJ :pl

Adjectif (sauf Participe Passé) au pluriel

ADV

Adverbe

CAR

Cardinal (en chiffres ou en lettres)

COO

Coordonnant

DTN :sg

Déterminant de groupe nominal, au singulier, non contracté

DTN :pl

Déterminant de groupe nominal, au pluriel, non contracté

DTC :sg

Déterminant de groupe nominal, au singulier, contracté

DTC :pl

Déterminant de groupe nominal, au pluriel, contracté

FGW

Mot étranger

INJ

Interjection, Onomatopée, etc.

PFX

Préfixe détaché

PREP

Préposition

PRV :sg

Pronom « supporté » par le verbe (conjoint, clitique) au singulier

PRV :pl

Pronom « supporté » par le verbe (conjoint, clitique) au pluriel

PRV :++

Pronom « supporté » par le verbe (clitique, réfléchi) genre indéterminé

PRO :sg

autre Pronom, singulier

PRO :pl

autre Pronom, pluriel

PRO :++

autre Pronom, genre indéterminé

PUL

Particule non indépendante

REL

Relatif (Pronom, Adjectif ou Adverbe)

SUB

Subordonnant

SUB$

Subordonnant possible. = Code par défaut de « que »

SBC :sg

Substantif, nom commun, singulier

SBC :pl

Substantif, nom commun pluriel

SBP :sg

Substantif, nom propre ou à majuscule, singulier

SBP :pl

Substantif, nom propre ou à majuscule, pluriel

SYM

Symbole ou Signe mathématique

ACJ :sg

Verbe « avoir », conjugué, singulier

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

34

34

35

35

36

36

1

/

36

100%