dossier initial sur l`eau volume 1

1

L’eau en France

Dossier documentaire 1

Documents rassemblés par JM Dauriac – 2014

2

Généralités sur l’eau

1. Eau (ressources et utilisation) p.3 à 14

2. Eau (approvisionnement et traitement) p. 15 à 35

3. Eau (les défis de l’eau) p. 36 à 49

4. Hydrologie p. 49 à 67

5. Hydrologie urbaine p. 67 à 72

6. Glaciers p. 72 à 98

7. Fleuves p. 98 à 118

8. Lacs et limnologie p. 118 à 136

9. Hydrogéologie p. 136 à 155

3

EAU (Ressources et utilisations) notions de base

Article écrit par Jean-Paul DELÉAGE

Prise de vue

De toutes les planètes du système solaire, la Terre est la seule à être pourvue d'une hydrosphère. Celle-ci

recouvre plus des deux tiers de sa surface. Les propriétés de l'eau sont tout à fait exceptionnelles :

condition de la vie, solvant quasi universel, vecteur de chaleur, puissant régulateur thermique, etc. La

disponibilité en eau est l'une des clés de la distribution des êtres vivants à la surface de la Terre. Les

sociétés humaines elles-mêmes en sont totalement tributaires : elles l'utilisent pour les besoins de leur vie

quotidienne, pour leur agriculture et leur industrie, mais aussi comme moyen de transport, pour produire

leur énergie ou évacuer leurs déchets. La multiplication des conflits géopolitiques liés à l'eau ainsi que

la montée rapide des coûts de production de l'eau potable dans la plupart des pays industrialisés sont les

indices d'une crise majeure de cette ressource.

Patrimoine naturel le plus précieux de l'humanité, l'eau est très inégalement répartie dans le monde. Pour

des raisons climatiques, tout d'abord : les zones arctiques, tempérées et tropicales humides se partagent

98 p. 100 des eaux qui circulent sur l'ensemble des terres émergées, tandis que les zones arides et semi-

arides ne disposent que des 2 p. 100 restants. Mais les écarts dans les modes et les niveaux de

développement socio-économique jouent aussi un rôle déterminant dans les disparités des ressources en

eau réellement disponibles. Ainsi, au Sud (au sens géopolitique du terme), plus de 1,5 milliard d'individus

sont privés d'eau potable. Quant aux pays industrialisés, ils connaissent une crise latente, notamment en

raison des pollutions qui mettent en danger cet élément longtemps considéré comme indéfiniment

renouvelable. Les ressources naturelles en eau, potentiellement utilisables, varient suivant les régions de

200 litres à 2 millions de litres par jour et par habitant.

L'eau de notre planète (environ 1 385 millions de kilomètres cubes) est répartie dans cinq réservoirs

interconnectés. Le plus important d'entre eux est constitué par les océans (environ 97,4 p. 100). Les glaces

représentent environ 2 p. 100 du réservoir mondial, les eaux douces terrestres (lacs, fleuves, eaux

souterraines et humidité des sols) 0,6 p. 100 et la vapeur d'eau atmosphérique moins de 0,001 p. 100.

Quant à la totalité de l'eau contenue dans les cellules vivantes, elle correspond à moins de 0,000 1 p. 100

de l'ensemble, soit tout de même 1 100 kilomètres cubes.

I - Ressources

4

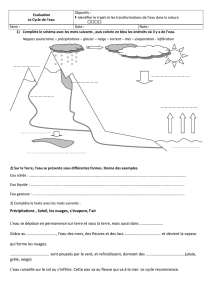

Le cycle de l'eau

Les cinq réservoirs d'eau de la planète subissent des transferts incessants selon un cycle bien connu

dont la phase initiale est l'évaporation des eaux de surface des océans et des continents. Chaque jour, plus

de 1 000 milliards de tonnes d'eau passent ainsi dans l'atmosphère, qu'elles quitteront un peu plus tard

sous forme de précipitations. La fraction P de ces précipitations qui retombe sur les continents se répartit

en deux flux. Une partie (Ev) de l'eau retombée subit à nouveau les phénomènes d'évapotranspiration,

après avoir, pour une part, transité par les êtres vivants ; le reste (Dr) est drainé vers les océans. Le bilan

s'écrit : P = Ev + Dr.

Les ressources en eau Dr, dites renouvelables, se répartissent elles-mêmes, en fonction de la perméabilité

du sol, en trois flux secondaires : le ruissellement, qui alimente les rivières et les fleuves ; le drainage par

infiltration superficielle, qui recharge les nappes aquifères ; le drainage souterrain profond, qui fournit les

nappes les plus profondes (plusieurs centaines de mètres de profondeur).

Au cours de ce cycle, la surface de l'océan fonctionne comme un immense distillateur. Cet évaporateur à

basse température joue le rôle d'une station d'épuration géante qui débarrasse l'eau de tous les déchets,

toxines et bactéries qui la polluent et remet l'eau douce à la disposition de la biosphère. À cette eau

évaporée viennent se joindre les eaux thermales et volcaniques mises en mouvement par la chaleur interne

du globe. À la distillation naturelle s'ajoute le flux des eaux douces obtenues artificiellement par les

usines de dessalement des eaux de mer, soit environ 15 millions de mètres cubes par jour.

Le cycle de l'eau comporte donc deux branches principales : une branche atmosphérique (réservoir

atmosphérique) et une branche « terrestre » (les quatre autres réservoirs). L'étude de la première relève de

la météorologie, la seconde de celle de l'hydrologie. La météorologie permet de comprendre le rôle de la

circulation générale de l'atmosphère dans le cycle de l'eau et donc la distribution géographique inégale

des précipitations. Dans les zones subtropicales et polaires, l'évaporation est plus importante que les

précipitations, tandis que les précipitations dépassent l'évaporation dans les ceintures de précipitation, à

savoir la zone de convergence intertropicale et les latitudes moyennes soumises aux perturbations

associées aux fronts polaires. Le bilan précis des processus d'apport et d'élimination de l'eau dans une

région donnée permet de connaître la répartition spatiale et temporelle de cet élément.

Les trois paramètres principaux caractérisant les précipitations – volume, intensité et fréquence – varient

selon les lieux et les saisons. Le volume des précipitations s'évalue en hauteur d'eau sur une période

donnée. Une fraction de la pluie est directement évaporée, une autre est interceptée par la végétation, une

autre enfin frappe directement le sol. Dans ce dernier cas, une partie s'infiltre, une autre peut stagner en

surface, une dernière est emportée par le ruissellement. On fait appel à la notion de pluie efficace pour

définir la fraction de pluie qui est effectivement utilisée par la végétation. Cette notion est essentielle,

5

puisque les végétaux constituent le premier niveau trophique des écosystèmes, celui de la photosynthèse

du vivant.

Une ressource primordiale pour la vie

L'eau de pluie est essentielle pour toute la chaîne du vivant, dont les végétaux constituent le premier

maillon. Ces derniers sont responsables des processus d'évapotranspiration en rejetant des masses

considérables d'eau par leur système foliaire. Leurs racines, qui peuvent aller chercher l'eau à plusieurs

mètres de profondeur dans le sol, accélèrent les mouvements ascendants sol-atmosphère. Le transit de

l'eau dans les végétaux est un phénomène d'une ampleur considérable. Ainsi, un hectare de forêt, en

région tempérée, peut absorber jusqu'à 4 000 tonnes d'eau par an (chiffre obtenu en Suède pour une forêt

d'épicéas sur sol humide). Le flux de vapeur d'eau provient de la transpiration des plantes et de

l'évaporation des surfaces de contact plante-atmosphère et sol-atmosphère. La valeur maximale de ce flux

constitue l'évapotranspiration potentielle, ou ETP, paramètre qui constitue l'un des fondements de la

classification biologique des climats.

Indépendante de la disponibilité réelle en eau et comparée au volume mesuré P des précipitations, l'ETP

permet d'établir, pour toute station, l'existence ou non d'un déficit climatique en eau DE. En termes très

simplifiés : DE = ETP − P.

Il y a déficit si ETP est supérieur à P, excédent dans le cas contraire. Avec ce type de calcul, on peut

estimer les besoins en eau des cultures en remplaçant dans l'expression précédente le facteur DE par le

terme ETR, représentant l'évapotranspiration réelle, autrement dit la quantité d'eau réellement

évapotranspirée au niveau d'une culture. Cette dernière dépend des conditions climatiques, de la

disponibilité en eau de surface et des caractéristiques aériennes des végétaux.

Élément fondamental de la croissance des végétaux, l'eau est plus généralement le constituant majeur de

toute matière vivante, le milieu où s'effectuent de multiples réactions métaboliques, chez les êtres vivants

terrestres aussi bien que chez les êtres vivants aquatiques. Si ces derniers ont toujours de l'eau à leur

disposition, il n'en va pas de même en milieu terrestre, où plantes et animaux doivent s'adapter à diverses

conditions hydriques pour assurer leur autorégulation.

À l'état liquide, l'eau solubilise les molécules motrices de la physiologie du vivant, et son mouvement

permet de structurer ce dernier. L'osmose de l'eau et la diffusion des sels assurent les échanges internes et,

ainsi, la vie elle-même. La vie est donc impossible sans la présence d'une certaine quantité d'eau dans les

organismes. Ces derniers mettent en œuvre diverses stratégies adaptatives, particulièrement sollicitées

dans les régions froides, où le gel peut provoquer la mort en entraînant l'immobilité du « milieu

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

34

34

35

35

36

36

37

37

38

38

39

39

40

40

41

41

42

42

43

43

44

44

45

45

46

46

47

47

48

48

49

49

50

50

51

51

52

52

53

53

54

54

55

55

56

56

57

57

58

58

59

59

60

60

61

61

62

62

63

63

64

64

65

65

66

66

67

67

68

68

69

69

70

70

71

71

72

72

73

73

74

74

75

75

76

76

77

77

78

78

79

79

80

80

81

81

82

82

83

83

84

84

85

85

86

86

87

87

88

88

89

89

90

90

91

91

92

92

93

93

94

94

95

95

96

96

97

97

98

98

99

99

100

100

101

101

102

102

103

103

104

104

105

105

106

106

107

107

108

108

109

109

110

110

111

111

112

112

113

113

114

114

115

115

116

116

117

117

118

118

119

119

120

120

121

121

122

122

123

123

124

124

125

125

126

126

127

127

128

128

129

129

130

130

131

131

132

132

133

133

134

134

135

135

136

136

137

137

138

138

139

139

140

140

141

141

142

142

143

143

144

144

145

145

146

146

147

147

148

148

149

149

150

150

151

151

152

152

153

153

154

154

155

155

156

156

157

157

158

158

159

159

160

160

161

161

162

162

163

163

164

164

165

165

166

166

167

167

168

168

169

169

170

170

1

/

170

100%