novembre 2007 - Université Paul Sabatier

Magazine scientifique - numéro

Novembre 2007

Paul Sabatier

Dossiers

L’astrophysique

Les systèmes

embarqués

www.ups-tlse.fr

Délégation

Midi-Pyrénées du CNRS

Avec la

participation de

Administration déléguée

Midi-Pyrénées, Limousin de l’Inserm

11

MAGAZINE UPS

N° 11 — NOVEMBRE 2007

Illustration

de couverture:

Aurore boréale de Saturne,

vue depuis le télescope

spatial Hubble

(copyright NASA, ESA)

Directeur

de la publication:

Jean-François Sautereau

Rédacteur en chef :

Daniel Guedalia

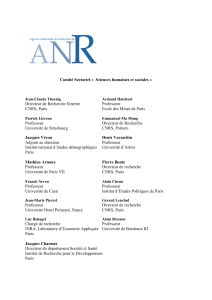

Comité de rédaction:

Isabelle Berry

Patrick Calvas

Jean-Pierre Daudey

Daniel Guedalia

Alexandra Guyard

Guy Lavigne

Fréderic Mompiou

Carine Desaulty,

délégation Midi-Pyrénées

du CNRS

Christine Ferran,

administration déléguée

Midi-Pyrénées de l’Inserm

Conseillère de rédaction:

Anne Debroise

Diffusion:

Joëlle Dulon

Coordination dossiers

scientifiques:

Astrophysique :

Sylvie Roques et

Jean-André Sauvaud

Systèmes embarqués :

Jean Arlat

Conception graphique

et impression:

Ogham-Delort

05 62 71 35 35 n°8401

dépôt légal:

Novembre 2007

ISSN: 1779-5478

Tirage: 2000 ex.

Université Paul Sabatier

118, route de Narbonne

31062 Toulouse cedex 9

édito

Des prix et

des médailles…

On associe de plus en plus la recherche scientifique à

de grands équipements, de gros moyens scientifiques,

des infrastructures…mais il faut rappeler que la qualité

de la recherche dépend en premier lieu de la qualité et

des compétences des hommes et des femmes dont

c’est le métier. De même, alors qu’il n’y a pas de véritable

université sans recherche, la liaison entre la recherche et

l’enseignement, fondement de l’université, se fait par

l’intermédiaire des personnes.

On entend dire d’habitude que la recherche est un travail

d’équipe, ce qui n’empêche pas de constater que

la plupart des récompenses scientifiques sont attribuées

à des chercheurs individuellement et rarement

à des équipes ; ceci, et malgré la complexité croissante

des travaux, parce qu’il y a toujours un leader.

Nous avons choisi de vous présenter dans ce numéro un

certain nombre de chercheurs de notre université, souvent

de jeunes chercheurs, qui ont été distingués récemment par

des médailles du CNRS, des prix de l’Académie des Sciences

ou des prix européens. A travers eux, ce sont leurs équipes

et l’ensemble de l’université qui se sentent honorés.

On peut espérer que ces récompenses viendront aussi

mettre du baume au cœur à des chercheurs et enseignants-

chercheurs confrontés à des difficultés dans l’exercice de leur métier et dans le

déroulement de leurs carrières, à un moment où l’organisation de la recherche est soumise

à de fortes turbulences.

Vous trouverez aussi dans ce numéro les rubriques habituelles avec deux dossiers

scientifiques. Ils correspondent à des thématiques où les chercheurs toulousains sont

reconnus parmi les meilleurs au niveau national et international.

Le premier dossier est celui des recherches en astrophysique. C’est un domaine scientifique

parmi les plus anciens (on trouve des traces d’études astronomiques qui datent de

plusieurs milliers d’années). L’objectif de cette discipline est avant tout d’améliorer nos

connaissances sur l’origine de l’univers, sur l’origine de la vie. L’astrophysique est tout

d’abord une science d’observation et les instruments utilisés, depuis le sol ou dans l’espace,

font appel aux dernières avancées de l’optique, de l’informatique, du traitement du signal.

Peu d’applications industrielles sont attendues de ces recherches, sauf dans le domaine des

instruments, ce qui n’empêche pas une forte attirance des jeunes scientifiques pour

l’astrophysique et une grande curiosité du grand public pour ces découvertes.

Le deuxième dossier concerne les recherches sur les systèmes embarqués. C’est,

contrairement au précédent, un domaine où les applications sont présentes à tous les

stades des travaux. Les systèmes embarqués sont en particulier une des clefs du succès des

nouvelles avancées dans les transports terrestres et aéronautiques, ainsi que dans plusieurs

autres secteurs d’activité. Les avancées, dont un certain nombre vous est présenté dans ce

numéro, ont apporté une réelle révolution dans l’automatisation des processus, dans la

sécurité, dans le dialogue homme-machine. Les enjeux économiques sont considérables.

Ces études bénéficient des compétences remarquables et reconnues des équipes

toulousaines des sciences de l’information et de la communication.

Je vous souhaite une très agréable lecture.

Jean-François SAUTEREAU

Président de l’Université Paul Sabatier

Vos encouragements, vos critiques, vos suggestions, une seule adresse :

Vous pouvez consulter et télécharger ce magazine et les numéros antérieurs

sur le site www.ups-tlse.fr (rubrique «Recherche»)

sommaire

Dossier:

Astrophysique

Vie des laboratoires

- Quand les physiciens se penchent sur l’ADN

- Mieux prévoir les orages…

- Dans le secret des bactéries transformantes

- Un sérieux pas de plus vers l’ordinateur moléculaire

Dossier:

Les systèmes

embarqués

Prix et médailles

- Des médailles et des prix… 2007

- Deux prix de l’Académie des sciences

à des chercheurs toulousains

4

12

16

24

page 4 Paul Sabatier — Le magazine scientifique — numéro 11

L’astronomie en tant que science a une

influence directe sur nos vies. Elle traite par

exemple de l’effet du Soleil et de l’inclinaison

de l’axe de rotation de la Terre sur les saisons,

sur les climats, de l’effet de la Lune sur les

marées. Cette science est aussi indispensable

aux systèmes de navigation par satellite qui,

utilisant la gravité, la rotation de la Terre et la

relativité générale, permettent aux avions

d’atterrir et aux balises de détresse d’être

repérées. Par ailleurs, la compréhension de

l’activité solaire, et celle des effets orbitaux de

la Terre sont cruciales pour prédire les

changements climatiques à long terme. De

même, des progrès dans l’observation et la

compréhension du soleil devraient conduire à

prédire les orages solaires et à prévenir leurs

effets sur les satellites, et sur les astronautes en

mission dans l’espace.

Autres mondes

L’astronomie a aussi une immense dimension

culturelle. Elle traite de questions

fondamentales pour l’humanité, telle que

l’origine de l’univers, du temps et de l’espace,

celle de notre galaxie et des étoiles qui la

forment, celle de notre système solaire, de

notre planète et même de la vie. Depuis une

dizaine d’année, en effet, les astronomes ont

entrepris la recherche d’autres mondes au-delà

de notre système solaire, d’autres systèmes

planétaires autour de soleils distants. Il en

résulte une coopération intense entres

astronomes, chimistes et biologistes pour tenter

de comprendre les conditions dans lesquelles la

vie pourrait s’être développée ailleurs et

comment cette vie extrasolaire pourrait être

détectée.

Astronomie et technologie sont étroitement

liées. En effet la nécessité d’accroître toujours la

qualité des mesures, en terme de sensibilité et

de précision, a souvent poussé au

développement de nouvelles technologies avec

un impact sociétal fort. C’est ainsi que les

télescopes optiques et infrarouges au sol ont

des tailles de plus en plus grandes et peuvent

maintenant être installés à des altitudes

extrêmes. Si les télescopes radio, utilisés depuis

le milieu de siècle dernier, ont ouvert une

nouvelle fenêtre sur l’univers, la possibilité

d’utiliser les satellites a permis de couvrir la

totalité du spectre électromagnétique.

Big Bang

L’origine de l’univers est donc la question

essentielle que voudrait résoudre

l’astrophysique. La description des premiers

instants est toujours impossible faute de

théorie. Les cosmologistes utilisent un modèle

dit standard (celui du Big Bang) qui retrace

convenablement l’histoire de l’univers après sa

première seconde, en utilisant la relativité

générale. Avec cependant des lacunes

importantes concernant l’origine de la matière

et de l’énergie noire. En effet toutes les

structures de l’univers organisées par la gravité,

galaxies, amas de galaxies…, sont dominées

par une matière invisible. En outre l’expansion

de l’univers s’accélère avec le temps. Une forme

d’énergie inconnue, dite noire est nécessaire à

cette expansion. Observations et théories sont

confrontées à ce problème, posé depuis une

dizaine d’années, qui révolutionne

l’astrophysique et la physique.

C’est l’astrophysique qui décrit tant le cycle de

la matière dans l’univers que la formation des

étoiles et des planètes. En effet, les réactions

nucléaires à l’intérieur des étoiles sont à

l’origine de l’évolution de la matière dite

‘visible’ de l’univers, permettant la création de

métaux en partant des éléments légers initiaux.

Les éléments les plus lourds sont générés au

moment de l'explosion cataclysmique d'étoiles

massives. L’explosion survient quand l’étoile a

épuisé tout son combustible nucléaire,

provoquant ainsi l'effondrement du coeur et

l’expulsion d'une quantité d'énergie

considérable qui souffle les couches externes de

L’Astrophysique… de l’origine

de l’univers à l’origine de la vie

C’est un sentiment profondément humain que la curiosité pour notre

univers. C’est elle qui conduit à son étude et à son exploration.

dOSSIER

ASTROPHYSIQUE

>>> Sylvie ROQUES, directeur de recherche au

CNRS et directrice du Laboratoire

d’Astrophysique de Toulouse Tarbes

(LATT, unité mixte UPS/CNRS).

>>>

>>> Jean-André SAUVAUD, directeur de recherche

CNRS et directeur du Centre d’Etudes

Spatiales du rayonnement

(CESR, unité mixte UPS/CNRS).

l'étoile, pour ne laisser qu'une étoile à neutron

ou un trou noir. C’est cependant dans le milieu

interstellaire et dans les disques

circumstellaires que se forment les molécules

complexes nécessaires à la vie. Dans ce milieu

interstellaire, immense réacteur chimique, des

molécules organiques se forment au voisinage

des protoétoiles et une branche de

l’astrophysique traite avec des chimistes du

cycle de la matière dans les étoiles et le milieu

interstellaire.

Coopérations internationales

Cet éclairage très partiel, donne une idée de la

complexité de la tâche des astrophysiciens dont

les disciplines couvrent des champs de

connaissance particulièrement vastes et traitent

de sujets allant de l’origine de l’univers, la

formation des étoiles et des planètes jusqu’au

cycle de la matière. Ces disciplines ont besoin

d’une forte structuration et doivent s’appuyer

sur d’intenses coopérations internationales. Au

niveau européen l’astrophysique est structurée

par l’ESO (European Southern Observatory) et

par l’ESA (European Space Agency). Au niveau

français, c’est l’INSU (Institut National des

Sciences de l’Univers) qui regroupe et fédère

l’action des laboratoires, avec pour l’espace

le support du CNES (Centre National d’Etudes

Spatiales). A Toulouse, les recherches en

astrophysique se font dans deux laboratoire,

le CESR (Centre d’étude spatiale des

rayonnements) et le LATT (Laboratoire

d’astrophysique de Toulouse-Tarbes),

tous deux unités mixtes du CNRS et de l’UPS.

Contacts : sylvie.roques@ast.obs-mip.fr et

Jean-andre.sauvaud@cesr.fr

dOSSIER

Astrophysique

page 5

>>>

Les filières de formation dans le domaine

de l’astrophysique

L’Université Paul Sabatier propose à des étudiants issus des licences de

physique une formation de niveau master conduisant à une spécialité

recherche «Astrophysique, sciences de l'espace et planétologie» et à

une spécialité professionnelle « Sciences et techniques spatiales».

La poursuite en thèse s’effectue dans le cadre de l’Ecole doctorale

Sciences de l’univers, de l’environnement et de l’espace (SDUEE,

cohabilitée avec SupAéro) dans un des laboratoires d’astrophysique.

>>> Interaction entre deux galaxies, vue par le télescope

spatial Hubble (copyright NASA, ESA).

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

1

/

28

100%