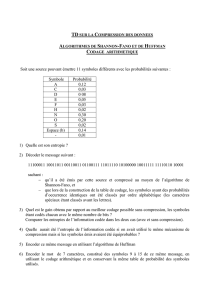

Codage Source : Compression de Données - Cours Complet

Telechargé par

marrhichmaryam2004

01/05/2025

1

67

Pr. A. BOU-EL-HARMEL EPS-Fès

CODAGE SOURCE

68

Définition

Le codage source est une technique de compression qui vise à réduire la taille des

données (représenter une information avec un nombre minimal de bits) pour économiser

de l'espace de stockage ou accélérer la transmission et améliorer l'efficacité du système

de communication.

Par exemple :

Soit un film FHD de (sans considérer le son), pour que les images sont

suffisamment fluides, on met 24 images par seconde. Donc, on va avoir

images. Une image FHD contient 1920 pixels en largeur et 1080 en hauteur, alors

de pixels par image. Si chaque pixels et codé sur 24 bits, on va avoir

,. , ce qui de l’ordre de .

ØC’est impossible de le stocker par exemple dans un DVD, car sa capacité est de

l’ordre de 4Go.

ØC’est compliqué de le transmettre par exemple sur une ligne ADSL, car il va prendre

une centaine d'heures pour arriver.

La solution est donc la compression de données, c’est le rôle du codage source.

Codage source

Pr. A. BOU-EL-HARMEL EPS-Fès

01/05/2025

2

69

Définition

La compression des données est une opération qui peut être effectuée quelque soit le

mode de transmission (parallèle ou série). C.-à-d. la compression des données peut être

effectuée directement sur les données provenant d’un CAN parallèle, sans nécessiter

d’un registre de décalage (convertisseur parallèle-série).

La compression des données avant la transmission se fait généralementà l'aide de :

ØProcesseurs de traitement de signal numérique (DSP)

ØProcesseur généraliste (CPU/GPU)

ØRéseau de portes programmables par l'utilisateur(FPGA)

ØMicrocontrôleur

Codage source

Pr. A. BOU-EL-HARMEL EPS-Fès

70

Type de codage source

Il existedeux grandes catégories de codage source :

ØCodage sans perte (Entropique) : Permet de retrouver exactement les données

originales après décompression. Donc, aucune donnée n'est perdue.

Exemples : Codage de Huffman,Shannon-Fano,RLE,LZW …

ØCodage avec perte (Irréversible) : Réduit davantage la taille des données en

supprimant des informations jugées moins importantes. Certaines données sont

éliminées, ce qui implique une perte de qualité.

Exemples : JPEG pour les images, MP3 pour l’audio, et H.264, H.265 pour la vidéo …

Codage source

Pr. A. BOU-EL-HARMEL EPS-Fès

Codeur source

sans perte Décodeur source

sans perte

Données

originales Données

reconstruites

Y

Données compressées

XX

Codeur source

avec perte Décodeur source

avec perte

Données

originales Données

reconstruites

Y

Données compressées

XX’≠

01/05/2025

3

71

Quantité d’information

Soit une sortie de source émis une séquence de symboles comme étant une variable

aléatoire discrète qui prend des symboles à partir d’un ensemble (alphabet) fini

avec: A=

,,…,.

Chaque apparait dans la séquence a une probabilité 0<

<1 telque

∑

=1.

Donc, la quantité d'information d’un symbole est exprimée en bits et donnée par :

= −

La quantité d’information nous permet de mesurer l’importance d’un symbole. Plus un

symbole est rare (fréquent),plus sa quantitéd'information est élevée (faible).

Exemple:

Soit la séquence = , donc chaque symbole appartient à l’alphabet A= ,,

Les probabilités pour que L, A, V apparaissent dans la séquence sont respectivement :

=

2

5

=

2

5

=

1

5

Donc la quantité d’information de L, Aet V sont respectivement :

=

1

.

32

=

1

.

32

=

2

.

32

Codage source

Pr. A. BOU-EL-HARMEL EPS-Fès

72

Apres le calcul de la quantité d’information de chaque symbole , nous pouvons

calculer la quantité d’information moyenne produite par une source. Cette dernière est

calculé par l’entropiequi s′exprime par :

=

()

L’entropie d’une source nous permet de :

ØCompresser les données sans perte le plus possible, c.-à-d. combien de bits

minimum nous devons utiliser. Autrement dit, la limite de débit binaire minimal

du codage d’une source sans perte.

ØComparer et analyser différentes sources, c.-à-d. quelle source la plus complexe

ou plus compressible :

•est grande →difficile à compresser

• est petite →facile à compresser

Exemple précédent :

Soit la séquence

=

donc :

=

∑

=

1

.

52

/

Codage source

Pr. A. BOU-EL-HARMEL EPS-Fès

Quantité d’information

01/05/2025

4

73

La longueur moyenne d’un code est le nombre moyen de bits utilisés par symbole dans

un code donné.

()=

()

Avec:

§

est la probabilitédu symbole .

§()est la longueur du code (en bits) attribué au symbole .

On utilisegénéralement cette longueur pour la comparer avec l’entropie().

≤()<+1

Si est proche de (), plus le codage est optimal.

Exemple précédent :

Soit le codage de chaque symbole de la séquence = est:

L=1, A= 01 et = 00

Donc la longueur moyenne du code est de :

(

)

=

1

.

6

/

Codage source

Pr. A. BOU-EL-HARMEL EPS-Fès

Longueur moyenne d’un code

74

On peut calculer l’efficacité du codage par :

=()

()

Généralementl’efficacité est représenté en pourcentage :

[%]=()

()×100

Exemple précédent :

Nous avons déjà calculer l’entropie de la séquence = :

= 1.52 /

Nous avons aussi déjà calculer la longueur moyenne du code :

() = 1.6 /

Donc, l’efficacité du codage (compression) est de :

=()

()= 0.95

Ce qui impliqueque l’efficacité de la compression que nous avons utilisé est de

95

%

Codage source

Pr. A. BOU-EL-HARMEL EPS-Fès

Efficacité du codage

01/05/2025

5

75

Le taux de compression indique combien de fois la taille des données a été réduite

grâce à un codage ou une compression.

=()

()

Avec:

§

est la langueur moyenne d’un code original.

§est la longueur moyenne d’un code compressé.

Exemple précédent :

Soit le codage de chaque symbole sans compression de la séquence = :

= 00,= 01 et = 10

Alors, la longueur moyenne original est de : () = 2 /

Le taux de compression est donc :

=()

()=2

1.6 = 1.25

Ce qui implique la taille moyenne d’un symbole a été réduite de

20

%

Codage source

Pr. A. BOU-EL-HARMEL EPS-Fès

Taux de compression

76

Un codage préfixe est un codage dans lequel aucun code de chaque symbole n’est le

préfixe (début) des autres codes des symboles. Ce codage nous permet de décoder

instantanémentsans attendre la suite du message.

Exemple précèdent :

On peut codé chaque symbole de la séquence = de différentes manières :

ØLe code 1 n’est pas un code préfixe, car on ne peut pas savoir si 0 est L, ou le début de

V.

ØLe code 2 est n’est pas un code préfixe, car on ne peut pas savoir si 0 est L, ou le

début deA.

ØLe code 3 est un code préfixe, aucun code de chaque symbole n’est le préfixe des

autres codes.

Codage source

Pr. A. BOU-EL-HARMEL EPS-Fès

Codage préfixe

Symbole Probabilité Code 1 Code 2 Code 3

L 0.4 0 0 1

A 0.4 1 01 01

V0.2 01 11 00

6

6

7

7

8

8

9

9

10

10

1

/

10

100%