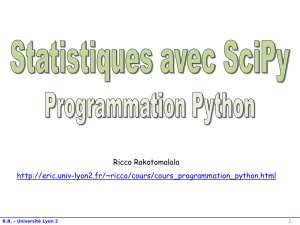

Statistiques sous Python avec le

package SciPy

Représenté par:

Tlati Noureddine

Fardouz Redouane

Plan

Définition de Scipy

Différents domaines traité par Scipy

Statistique sous python avec Scipy

Pratique

SciPy est une bilbilothèque de calcul scientifique pour Python.

fournit des implémentations efficaces d'algorithmes standards.

Elle couvre de nombreux domaines.

SciPy s’appuie sur les structures de données de NumPy (vecteurs, matrices).

Il offre également des possibilités avancées de visualisation grâce au module matplotlib.

C’est quoi Scipy?

Le langage Python seul ne sait pas faire grand chose dans le domaine mathématique, comment tracer une fonction,

calculer des valeurs de fonctions usuelles, réaliser des opérations matricielles,...

Cependant, de nombreux modules ont été développés pour pallier ce manque, parmi lesquels en convient de citer :

–scipy

–numpy

–matplotlib

A noter que le module pylab intègre ces trois modules et ipython.

La plupart des fonctions présentées dans cette section nécessitent l’import

du module Numpy et de sous-modules du module Scipy.integrate.

interpolation:

Pour cela, il faut charger le module Scipy.interpolate.

intégration numérique:

Différents domaines traité par Scipy

optimisation:

Une branche des mathématiques cherchant à modéliser, à analyser et à résoudre

analytiquement ou numériquement les problèmes qui consistent àminimiser ou maximiser

une fonction sur un ensemble.

Pour cela, il faut charger le module Scipy.Optimize.

traitement d’images:

une discipline de l’informatique et des mathématiques appliqués qui étudie les images

numériques et leurs transformations, dans le but d'améliorer leur qualité ou d'en extraire

de l'information.

Pour cela, il faut charger le module Scipy.ndimage.

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

1

/

18

100%