139

Codes représentatifs

es codes forment de cet ouvrage l’objet d’étude le plus familier à tous les lecteurs. On manipule

les codes au quotidien, et leur compréhension est quasi instinctive. Le seul fait de lire fait appel au

codage alphabétique, auquel la civilisation moderne doit son développement rapide. Les nombres

aussi sont représentés par des codes, et ces codes sont formés par des chiffres. Il existe d’ailleurs de multiples

codes pour représenter les nombres, c’est ainsi que l’on peut représenter vingt par les symboles graphiques

‘XX’ ou ‘20’. Nous verrons dans ce chapitre différents types de codes, que nous avons classés en

représentatifs (les codes alphanumériques) et analytiques (représentant des quantités numérales).

Les systèmes numériques que conçoivent ou utilisent les ingénieurs manipulent pour la plupart ces codes.

7.1 Codes

On entend le mot code dans sa définition représentative, associant un objet à un symbole. Nous manipulons

les codes au quotidien. Remarquons que ‘123’ n’est pas ‘cent vingt trois’, de la même façon que ‘oie’ n’est

pas l’animal. Ce ne sont que des représentations des objets à l’aide de symboles (codes). Et l’association entre

l’objet et ce qui le représente est concevable à compter du moment que la codification est admise. Ainsi, ‘oca’

ne signifie rien pour nous puisque nous ne l’admettons pas comme un code valide. Ce n’est pourtant

qu’une autre représentation (c’est le mot italien) de ‘oie’.

Dans notre cas, nous considérons les codes sous une représentation binaire. C’est à dire que nous

représenterons tout code avec un ensemble de ‘0’ et de ‘1’. Ces deux symboles représentent les formes

possibles d’un bit.

7.1.1 Bit

Bit : Le mot fut utilisé pour la première fois par Claude Shannon dans un article publié en 1948. On attribue

cependant son origine à John Wilder Tukey, mathématicien américain, qui inventa également le mot software.

Bit est une contraction des mots binary digit, ou également binary unit. Un bit peut prendre deux valeurs

possibles, ‘0’ ou ‘1’. Il est à la base des codes que nous allons présenter.

7.1.2 Mot

Un mot est un ensemble de bits agencés de sorte à représenter un objet dans un code. Le mot ‘0011000’

représente le caractère ‘0’ (zéro) en code Ascii (voir section suivante), ou le nombre 48 dans la représentation

dite binaire naturel des entiers (voir section sur les codes analytiques).

Chapitre

7

L

2-CODES REPRÉSENTATIFS ET ANALYTIQUES

140

7.2 Codes représentatifs

7.2.1 Code Ascii

On désigne par code représentatif un ensemble de mots binaires utilisés pour représenter des objets non

analytiques, c’est-à-dire non numéraux. Le Code ASCII (acronyme de Américan Standard Code for

Information Interchange) est l’un des plus anciens et certainement le plus largement utilisé.

Le tableau suivant illustre quelques exemples de mots du code ASCII

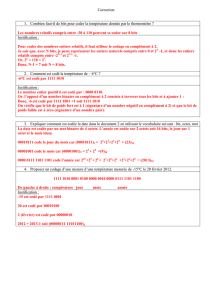

Caractère Code Caractère Code Caractère Code Caractère Code

0

1

2

3

4

5

6

7

8

9

A

B

C

D

E

F

G

H

0110000

0110001

0110010

0110011

0110100

0110101

0110110

0110111

0111000

0111001

1000001

1000010

1000011

1000100

1000101

1000110

1000111

1001000

I

J

K

L

M

N

O

P

Q

R

S

T

U

V

W

X

Y

Z

1001001

1001010

1001011

1001100

1001101

1001110

1001111

1010000

1010001

1010010

1010011

1010100

1010101

1010110

1010111

1011000

1011001

1011010

a

b

c

d

e

f

g

h

i

j

k

l

m

n

o

p

q

r

1100001

1100010

1100011

1100100

1100101

1100110

1100111

1101000

1101001

1101010

1101011

1101100

1101101

1101110

1101111

1110000

1110001

1110010

s

t

u

v

w

x

y

z

1110011

1110100

1110101

1110110

1110111

1111000

1111001

1111010

Le code ASCII a été créé pour représenter les caractères alphanumériques usuels de l’anglais. Cette

représentation première, initiée par la compagnie américaine Bell, comportait 7 bits par mot. Ceci permettait

donc 27 = 128 mots possibles. Des versions standardisées et rendues internationales suivirent, aboutissant à

une représentation sur 8 bits, permettant d’obtenir 28 = 256 mots possibles.

Néanmoins, avec le développement des technologies de l’information, des représentations plus évoluées ont

vu le jour, dont le code Unicode, comportant 16 bits, pour un total de 65 536 mots possibles et permettent

de représenter différents caractères des nombreux alphabets utilisés un peu partout dans le monde.

Le code ASCII s’est depuis plié au bonheur des artistes, donnant naissance à ce qu’on appelle

le Art-ASCII. Ainsi, on dessine des choses simples du type :

(__)

(oo)

/-------\/ __ O

/ | || /o)\ /|\

* ||----|| \(o/ / \

~~ ~~

Vache Yin/Yang Personne

2-CODES REPRÉSENTATIFS ET ANALYTIQUES

141

Ou des choses plus compliquées comme cette amusante figure :

Oooo$$$$$$$$$$$$oooo

oo$$$$$$$$$$$$$$$$$$$$$$$$o

oo$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$o o$ $$ o$

o $ oo o$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$o $$ $$ $$o$

oo $ $ "$ o$$$$$$$$$ $$$$$$$$$$$$$ $$$$$$$$$o $$$o$$o$

"$$$$$$o$ o$$$$$$$$$ $$$$$$$$$$$ $$$$$$$$$$o $$$$$$$$

$$$$$$$ $$$$$$$$$$$ $$$$$$$$$$$ $$$$$$$$$$$$$$$$$$$$$$$

$$$$$$$$$$$$$$$$$$$$$$$ $$$$$$$$$$$$$ $$$$$$$$$$$$$$ """$$$

"$$$""""$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$ "$$$

$$$ o$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$ "$$$o

o$$" $$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$ $$$o

$$$ $$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$" "$$$$$$ooooo$$$$o

o$$$oooo$$$$$ $$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$ o$$$$$$$$$$$$$$$$$

$$$$$$$$"$$$$ $$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$$ $$$$""""""""

"""" $$$$ "$$$$$$$$$$$$$$$$$$$$$$$$$$$$" o$$$

"$$$o """$$$$$$$$$$$$$$$$$$"$$" $$$

$$$o "$$""$$$$$$"""" o$$$

$$$$o o$$$"

"$$$$o o$$$$$$o"$$$$o o$$$$

"$$$$$oo ""$$$$o$$$$$o o$$$$""

""$$$$$oooo "$$$o$$$$$$$$$"""

""$$$$$$$oo $$$$$$$$$$

""""$$$$$$$$$$$

$$$$$$$$$$$$

$$$$$$$$$$"

"$$$""

7.2.2 Code BCD

Le code BCD est un autre code représentatif très en usage. Il permet de représenter des nombres sous leur

écriture décimale. L’acronyme BCD est pour Binary Coded Decimal, en français décimal, codé binaire. Il

s’agit de coder les chiffres de 0 à 9 en binaire. Le code 8421 est le plus répandu. Le tableau suivant en résume

la correspondance :

Chiffre Bits Chiffre Bits

0 0000 5 0101

1 0001 6 0110

2 0010 7 0111

3 0011 8 1000

4 0100 9 1001

Code BCD : 8421

On appelle ce code 8421 car les 4 bits pondèrent les nombres 8, 4, 2 et 1 respectivement. Ainsi, 0111

correspond à 7 puisque 7 = 0 x 8 + 1 x 4 + 1 x 2 + 1 x 1.

Cela permet d’écrire 123 : 0001 0010 0011.

2-CODES REPRÉSENTATIFS ET ANALYTIQUES

142

D’autres codes BCD existent, certains fonctionnant selon le même principe de pondération, comme le code

2421 ou le code 5421, dont les tables suivent :

Chiffre Bits Chiffre Bits

0 0000 5 1011

1 0001 6 1100

2 0010 7 1101

3 0011 8 1110

4 0100 9 1111

Code BCD : 2421

Chiffre Bits Chiffre Bits

0 0000 5 1000

1 0001 6 1001

2 0010 7 1010

3 0011 8 1011

4 0100 9 1100

Code BCD : 5421

Il existe également des codes non basés sur la pondération, dont l’exemple le plus connu est certainement

le code-barres. Pour l’instant, il suffit de retenir du code BCD son but utilitaire, à savoir la représentation

des chiffres 0 à 9 en code binaire, et noter que l’écriture la plus répandue est le code BCD 8421. Le grand

intérêt du système BCD pour l’électronicien est la possibilité de manipuler les chiffres en base dix pour

différentes fins, notamment l’affichage, comme ce sera illustré dans les chapitres subséquents.

7.2.3 Code de Gray

Comme nous aurons le temps de l’apprécier plus tard, un des problèmes importants des systèmes

numériques tient dans la synchronisation des différents signaux numériques. Lorsque l’on conçoit

un compteur, ce problème devient important car dans la représentation binaire des nombres entiers, il arrive

souvent que plusieurs bits changent en même temps. Dans ce cas, il est possible que des nombres non

désirés apparaissent dans le compte.

Considérons l’exemple suivant. Nous voulons concevoir un compteur trois bits, en faisant varier trois

signaux, v0, v1, v2 :

2-CODES REPRÉSENTATIFS ET ANALYTIQUES

143

Lorsque le compteur passe de 001 à 010, il doit modifier deux bits. Si il y a un problème de synchronisation

entre les bits v1 et v0, le nombre 011 s’affiche pendant un court laps de temps, bien que ce ne soit pas

le résultat recherché.

Pour remédier à ce problème il est possible d’utiliser le code de Gray, inventé aux Bell Labs par Frank Gray et

breveté en 1953. Le code de Gray encode les entiers de telle façon que le passage d’un nombre au suivant ne

change qu’un seul bit à la fois, comme l’illustre le tableau suivant où les entiers ont été encodés sur 4 bits :

Décimal Binaire Gray

0

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

00000

00001

00010

00011

00100

00101

00110

00111

01000

01001

01010

01011

01100

01101

01110

01111

0000

0001

0011

0010

0110

0111

0101

0100

1100

1101

1111

1110

0110

0111

0101

0100

Le code de gray règle le problème de compte que nous avons vu précédemment, comme l’illustre la figure

suivante :

On construit le code de Gray en recopiant les bits de façon symétrique (effet miroir) et en procédant de

façon itérative jusqu’au bit désiré.

0

1

0

0

0

1

1

1

1

0

0

0

0

0

00

01

11

10

1

1

1

1

10

11

01

00

Itération 1 Itération 2 Itération 3

6

6

7

7

8

8

9

9

10

10

11

11

12

12

1

/

12

100%