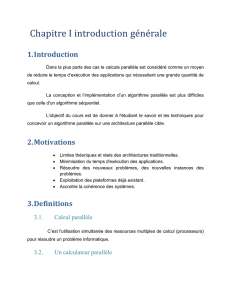

8. Méthodologie pour la programmation parallèle et

8. Méthodologie pour la

programmation parallèle et patrons

d’algorithmes

8.2 Approche PCAM

L’approche PCAM a été conçue pour un modèle de

programmation parallèle par échanges de messages.

On peut quand même s’en inspirer pour la program-

mation avec threads et variables partagées.

8.2.1 Objectifs

Les objectifs (contradictoires) qui sont visés :

•Réduire les coûts de synchronisation.

•Distribuer le travail de façon uniforme — «équili-

brer la charge».

•Conserver une flexibilité quant à la scalability

— si on ajoute des processeurs, on devrait aug-

menter l’accélération.

8.2.2 Étapes de l’approche PCAM

Les étapes de l’approche PCAM sont :

1. P artitionnement : On identifie tout le paral-

lélisme disponible.

Tâches de très fine granularité — aussi paral-

lèle que possible.

2. C ommunication : On identifie les dépendances

entre les tâches.

3. A gglomération : On regroupe les tâches pour

obtenir des tâches plus grosses.

4. M apping : On associe les tâches à des threads.

8.3 Méthodologie de programmation

parallèle avec threads inspirée de

l’approche PCAM

1. On commence par identifier les tâches les

plus fines possibles — on suppose une ma-

chine «idéale».

Stratégies typiques (prochaine section) :

•Parallélisme de données

•Parallélisme de résultat

•Parallélisme récursif diviser-pour-régner

•Etc.

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

34

34

35

35

36

36

37

37

38

38

39

39

40

40

41

41

42

42

43

43

44

44

45

45

46

46

47

47

48

48

49

49

50

50

51

51

52

52

53

53

54

54

55

55

56

56

57

57

58

58

1

/

58

100%