Descriptif du sujet

!

Titre!"!#$%&'%()*+!,-.!/-01*02%+3-.!,-!4-50*'/-2-+(!,-!,*++6-.!%$-3!7/%38-!9!Mahout!

!

Encadrants!"!:8%&-,!;%++)0<!=%0)%!=%&-><!?'@-0(!:%,)%2!

!

Introduction!"!

!

7/%38-!=%8*'(!-.(!'+!.*'.9/0*A-(!,-!B'3-+-!%C%+(!/*'0!@'(!,-!1*'0+)0!,-.!&)@0%)0)-.!,D%//0-+()..%5-!

%'(*2%()E'-! F2%38)+-! &-%0+)+5G! -H(-+.)@&-.I! =%8*'(! %! 6(6! 3*+J'! /*'0! 1*+3()*++-0! .'0! &%! @%.-! ,-!

?%,**/<! '+! 10%2-K*0>! L%$%! ,-.()+6! %'H! %//&)3%()*+.!,).(0)@'6-.! -(! )+(-+.)$-.! -+! (-02-.! ,-!

(0%)(-2-+(!,-!,*++6-.I!

!

B-! /*)+(! /%0()3'&)M0-2-+(! )+(60-..%+(! ,-! 3-(! *'()&! -.(! &%! ,)./*+)@)&)(6! ,D%&5*0)(82-.!/-02-((%+(! ,-!

1)&(0-0<!,-!0-50*'/-0!-(!,-!3&%..-0!,-.!,*++6-.!-+(0-!-&&-.I!N-.!%&5*0)(82-.!/-'$-+(!O(0-!-H63'(6.!-+!

/%0%&&M&-!6(%+(!,*++6!E'-!=%8*'(!-H/&*)(-!&%!/')..%+3-!,'!2*,M&-!,-!/%0%&&6&).%()*+!,-.!(0%)(-2-+(.!

=%/4-,'3-I!P%+.!&-!3%,0-!,-!3-!(0%$%)&!+*'.!+*'.!)+(60-..*+.<!/*'0! &-! 2*2-+(<! '+)E'-2-+(! %'H!

%&5*0)(82-.!,-!0-50*'/-2-+(!,-.!,*++6-.!%//-&6.!%'..)!Q!N&'.('0)+5!RI!

!

#+!/06.-+3-!,D'+!50*.!$*&'2-!,-!,*++6-.<!E'S)&!.*)(!,'!(-H(-!*'!+'260)E'-<!)&!-.(!.*'$-+(!'()&-!,-!

0-50*'/-0!-+.-2@&-! &-.! 6&62-+(.! .)2)&%)0-.! %'(*2%()E'-2-+(I! T%0! -H-2/&-!0-50*'/-0!(*'(-.! &-.!

+*'$-&&-.!,D'+-!A*'0+6-! ,-! (*'.! &-.! A*'0+%'H! ,-.! U(%(.9V+).I! 7)+.)<! +*'.! %$*+.! &%! /*..)@)&)(6! ,-!

50*'/-0! (*'.! &-.! %0()3&-.! .'0! &%! 2O2-! 8).(*)0-! -+.-2@&-I! W*'.! /*'$*+.!%&*0.!38*).)0!,-! +*'.!

3*+3-+(0-0! .'0! ,-.! 50*'/-.! ./63)1)E'-.! -(! ,-.! 8).(*)0-.! .%+.! %$*)0! X! /%03*'0)0! '+! 50%+,! +*2@0-!

,D8).(*)0-.!%$-3!%'3'+!0%//*0(I!

!

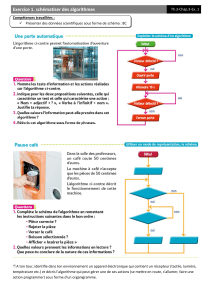

B-!Q!3&'.(-0)+5!R!3%&3'&-!&%!.)2)&%0)(6!-+(0-!6&62-+(.!,-!&%!3*&&-3()*+<!%$-3!'+-!.-'&-!(Y38-!3-&&-!,-!

0-50*'/-0!,-.!6&62-+(.!.)2)&%)0-.I!P%+.!,-!+*2@0-'.-.!)2/&62-+(%()*+.!,-!3&'.(-0)+5<!&-.!6&62-+(.!

,-!&%!3*&&-3()*+!.*+(!0-/06.-+(6.!/%0!,-.!$-3(-'0.!,%+.!'+!-./%3-!X!+!,)2-+.)*+.I!Z'.!3*22-!,-.!!

$-3(-'0.<! *+! /-'(! %&*0.! 3%&3'&-0! &%! ,).(%+3-! -+(0-! ,-'H! 6&62-+(.! X! &S%),-! ,-! 2-.'0-.! (-&&-.! E'-! &%!

,).(%+3-!,-!=%+8%((%+<!&%!,).(%+3-!-'3&),)-++-<!*'!&%!.)2)&)(',-!,'!3*.)+'.I!#+.')(-<!&-.!3&'.(-0.!F*'!

50*'/-.G!/-'$-+(!O(0-!3%&3'&6.!-+!0-50*'/%+(!&-.!6&62-+(.!E')!.*+(!/0*38-.!-+!,).(%+3-I!

!

=%8*'(! .'//*0(-! /&'.)-'0.! )2/&62-+(%()*+.! ,D%&5*0)(82-.! ,-! 3&'.(-0)+5<! (*'(-.! 630)(-.! /*'0!

-H/&*)(-0!=%/94-,'3-<!38%3'+-!/*..M,-!.*+!/0*/0-!-+.-2@&-!,S*@A-3()1.!-(!,-!30)(M0-.!"!

!

• Canopy3"!'+!%&5*0)(82-!,-!3&'.(-0)+5!0%/),-!.*'$-+(!'()&).6!/*'0!306-0!,-.!6&62-+(.!,-.()+6.!

X!,D%'(0-.!%&5*0)(82-.!,-!3&%..)1)3%()*+I!

• k5means3(et3fuzzy3K5means)3"!0-50*'/-!&-.! *@A-(.! -+!>93&'.(-0!-+!.-! @%.%+(!.'0!&%!,).(%+3-!

-+(0-!&-.!*@A-(.!X!/%0()0!,-.!3-+(0*[,-.!F*'!3-+(0-.G<!,-!&%!/0636,-+(-!)(60%()*+I!

• Mean5Shift!"!'+!%&5*0)(82-!E')!+-!+63-..)(-!%'3'+-!3*++%)..%+3-!%!/0)*0)!.'0!&-!+*2@0-!,-!

3&'.(-0.!-(!/-'(!/0*,')0-!,-.!50%//-.!,-!1*02-!%0@)(0%)0-I!

• Dirichlet3"!3&'.(-0.!@%.6.!.'0!&-!26&%+5-!,-!/&'.)-'0.!2*,M&-.!/0*@%@)&).(-.I!N-3)! &')!,*++-!

&S%$%+(%5-! ,-! +-! /%.! %$*)0!@-.*)+!,-!.S-+5%5-0!,%+.! '+-! $'-! /%0()3'&)M0-!,-.! 50*'/-.! ,-!

1%J*+!/062%('06-I!

!

P%+.!&-!3%,0-!,-!3-!(0%$%)&!*+!.D)+(60-..-0%!X!&D%&5*0)(82-!Q!>92-%+.!R!-+!/%0()3'&)-0I!

!

Motivation-"!

!

P%+.!&-!3%,0-!,-.!(0%$%'H!,-!0-38-038-<!+*'.!.*'8%)(*+.!"!

• #$%&'-0!&-.!3%/%3)(6.!,'!\0%2-K*0>!=%8*'(!X!0-50*'/-0!,-.!,*++6-.!!

• #$%&'-0!&-.!(-2/.!,-!(0%)(-2-+(.!-+!$%0)%+(!&-!$*&'2-!,-!,*++6-.!-+!-+(06-I!

• N*2/%0-0!&-.!06.'&(%(.!*@(-+'.!%$-3!3-'H!,-!B)@N&*',!

!

N-.!(0%$%'H!.-0$)0*+(!X!&D%,*/()*+!*'!+*+!,'!10%2-K*0>!=%8*'(!,%+.!&-!3%,0-!,'!/0*A-(!=%05'-0)(-I!

!

B)-+.!'()&-.!"!

!

8((/"]]2%8*'(I%/%38-I*05]!

!

8((/."]]3K)>)I%/%38-I*05]=7?^V;]>92-%+.93&'.(-0)+5I8(2&!

!

8((/"]]KKKIA%$%@-%(I+-(]%0()3&-.]__`9>92-%+.93&'.(-0)+59%&5*0)(82.9)+92%8*'(9`I8(2&!

!

8((/"]]@)3>.*+I@&*5./*(I3*2]ab``]bc]'+,-0.(%+,)+592%8*'(9>92-%+.93&'.(-0)+5I8(2&!

!

!

1

/

2

100%