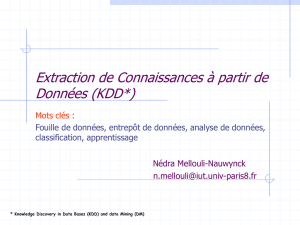

DATA MINING ou KNOWLEDGE DISCOVERY IN DATABASES (KDD)

DATA MINING

ou

KNOWLEDGE DISCOVERY IN

DATABASES (KDD)

Besoin de retrouver toutes les

informations associées à un

sujet donné, par exemple un

consommateur, un vendeur, un

produit ou une activité.

Extraire des connaissances des

« grandes BD » historisées, en

dégageant des tendances de

fond et les règles de l’entreprise

et du marché.

Entrepôt de données

(Data Warehouse)

Ensemble de données

historisées, constitué par

extraction à partir de bases

applicatives ou fichiers,

organisé par sujets

spécifiques, consolidé dans

une BD unique, géré dans

un environnement de

stockage particulier, aidant

à la prise de décision de

l’entreprise.

Les outils d’exploitation d’un data

warehouse peuvent être classés en

deux catégories:

-outils d’aide à la décision

permettant d ’interroger et

d’analyser l’évolution des données

- outils de DM permettant de

comprendre les relations entre les

données (problème très ouvert) afin

de déterminer des modèles

implicites, et de remonter de

l’information non prévisible à

l’utilisateur.

Méthodes et Outils de

Data Mining (Fouille des

données)

•DM : Ensemble de techniques

d’explorations de données afin

d’en tirer les liens sémantiques.

La découverte des règles à partir des

données permet d’améliorer le processus.

Les mécanismes de base sont les méthodes

de déduction issues de la logique,

permettant de déduire un théorème à partir

d’axiomes.

Le résultat est sûr, mais la méthode

nécessite la connaissance de règles a

priori.

La logique floue gagnerait à être

considérée.

Les méthodes d’induction permettent de

tirer des conclusions à partir d’une série de

faits.

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

34

34

35

35

36

36

37

37

38

38

39

39

1

/

39

100%