Amélioration du stratège par Amélioration du stratège par

Amélioration du stratège par

Amélioration

du

stratège

par

Apprentissage

A

pp

rendre la fonction d’évaluation

pp

Définition de la fonction d’évaluation

z

Définition

de

la

fonction

d’évaluation

Eval(s) = w1f1(s) + w2f2(s) + … + wnfn(s)

–Fonction dépendante ou non du temps (du n° de

coup)

El(t)

(t) f

()

(t) f

()

(t) f

()

E

va

l(t

, s

)

= w1

(t)

f

1

(

s

)

+ w2

(t)

f

2

(

s

)

+ … + wn

(t)

f

n

(

s

)

zApprendre les w ou les w(t)

A

pp

rendre à ex

p

lorer ?

pp p

z

Paramétrisation de l

’

algorithme de recherche

z

Paramétrisation

de

l algorithme

de

recherche

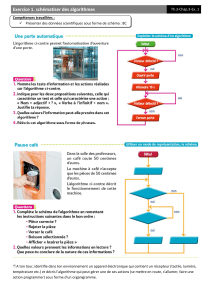

–Algorithme à profondeur fixée

zTendance à favoriser des

p

rises im

p

ortantes au dernier cou

p

pp p

–Algorithmes à profondeur variable

zNécessite un critère d’arrêt

St bilité d l it ti

–

St

a

bilité

d

e

l

a s

it

ua

ti

on

–Validité de la fonction d’évaluation

–Algorithmes dépendants des contraintes temporelles

zPrise en compte du temps

–Profondeur fixée dépendante du temps

Comment apprendre ?

Mise au

p

oint du stratè

g

e

pg

Alamain

z

A

la

main

zPar apprentissage supervisé

zPar apprentissage faiblement supervisé

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

1

/

15

100%