Entropie statistique

Notion d’entropie statistique

Jusqu’à maintenant en thermodynamique, nous avons utilisé le fait qu’il est possible de caractériser

macroscopiquement un système en connaissant un nombre restreint de paramètres. La donnée des

paramètres d’états caractérise ce qu’on appelle un macro-état (système macroscopique décrit par un

volume, une pression, une température, …). Toutefois, si l’on regarde plus en détails, il est facile

d’imaginer qu’à ce macro-état correspond un très grand nombre de micro-états (arrangement des

molécules à un instant donné dans le système thermodynamique avec chacune une position, une

vitesse, une énergie, … propres).

Exemple

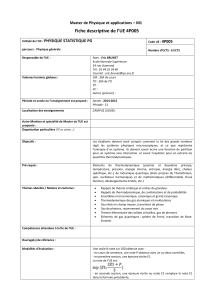

On considère deux molécules discernables (carré, rond) pouvant avoir accès à seulement deux niveaux.

Du point de vue macroscopique, on n’est pas capable de dire si telle ou telle molécule est sur tel ou tel

niveau. Il n’existe donc qu’un seul macro-état : les deux molécules ayant accès aux deux niveaux. Par

contre, en décrivant le système dans son détail (par une expérience de pensée), on peut définir 4

micro-états correspondant aux 4 configurations qui répartissent les deux molécules sur les deux

niveaux (cf schéma ci-dessous).

Généralement on note Ω le nombre de micro-états (aussi appelés nombre de complexions du

système).

Dans l’hypothèse du chaos moléculaire, rien ne permet de distinguer les divers micro-états associés à

un même macro-état. On dira donc que tous les micro-états sont équiprobables et on exprimera

naturellement la probabilité p d’accéder à un micro-état donné par

(nombre d’occurrences de

l’évènement que l’on décrit / nombre total d’occurrences, cf cours proba)

Par ailleurs, un macro-état (équilibre macroscopique) est d’autant plus probable qu’il est associé à un

grand nombre de micro-états. Ainsi l’état d’équilibre est celui qui maximise le nombre de

complexions du système, autrement dit celui qui minimise l’information que l’on en a. L’état

d’équilibre maximise donc le désordre du système.

A travers sa contribution Sc (entropie crée (positive)), on peut voir l’entropie S thermodynamique

comme une mesure de la méconnaissance (ou désinformation) que l’on a d’un système. C’est donc en

quelque sorte une mesure de son désordre. On définit alors l’entropie statistique par :

Le choix de kB=1.38 10-23 J.K-1 permet de faire coïncider l’entropie statistique avec l’entropie

thermodynamique vue en cours.

Niveau 2

Niveau 1

4 micro-états

1 macro-état

3ème principe de la thermodynamique

Pour tous les corps purs :

à T=0 K, S=0.

L’interprétation en termes de désordre est aisée. A T=0 K, la structure d’un corps pur est cristalline, il

n’y a plus d’agitation thermique (vibrations des atomes à cause de la température), l’état du système

est donc parfaitement connu. L’information sur le système est totale donc S=0.

Détente de Joule-Gay-Lussac

Il s’agit de la détente d’un gaz initialement confiné dans un volume V0 vers un volume 2V0.

A l’état final, si une choisit une molécule, la probabilité p1 pour qu’elle se trouve dans le compartiment

de gauche (ou de droite) est bien entendu ½. La probabilité pour que les N particules indépendantes

soient toutes dans le compartiment de gauche (ou de droite) est

.

Or par définition

et on retrouve (résultat obtenu en TD) :

Transition de phase

S est une mesure du désordre. Pour une transition de phase liquide vapeur, on imagine

intuitivement que le désordre associé à l‘état vapeur est plus grand que celui associé à l’état liquide

(lui-même plus grand que celui associé à l’état solide). On verra effectivement dans les tables

thermodynamiques (TD 26 exercice 4) que :

sVapeur(T) > sliquide(T) > ssolide(T)

1

/

2

100%