Moindres carrés récursifs et algorithme adaptatif

Introduction

LMS

Moindres Carr´es R´ecursifs (MCR)

Estimation Bay´esienne

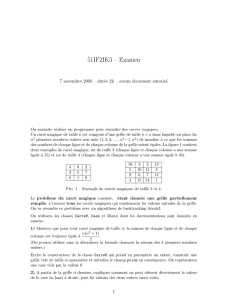

Exemple : Annulation d’´echo acoustique

Figure:Annulation d’´echo acoustique

En pratique, les coefficients du “filtre” doivent ˆetre modifi´es de

fa¸con `a suivre les variations du canal acoustique.

En l’absence du signal s(n), le signal en sortie de l’annuleur d’´echo

doit ˆetre nul.

Introduction

LMS

Moindres Carr´es R´ecursifs (MCR)

Estimation Bay´esienne

Estimation de la moyenne : convergence

On veut estimer la moyenne m=E[x1]d’une suite de v.a. xn

suppos´ees i.i.d. On utilise l’estimateur

ˆmn=1

n

n

X

i=1

xi

Acquisition/convergence : la loi des grands nombres assure · · ·

Mis sous forme r´ecursive . . . il vient

ˆmn= ˆmn−1+µn(xn−ˆmn−1)

o`u m0= 0 et o`u

µn=1

n

Le pas tend vers 0 quand ntend vers l’infini.

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

1

/

33

100%