1 Notion de variable aléatoire

©Arnaud de Saint Julien - MPSI Lycée La Merci 2015-2016 1

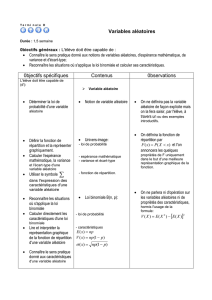

Variables aléatoires sur un espace probabilisé fini

Dans tout ce chapitre, on considère (Ω, P ) un espace probabilisé fini.

Démos de cours

1. V(X) = E(X2)−E(X)2

2. Espérance et variance d’une loi binomiale en écrivant X=X1+···+Xn.

3. Si Xet Ysont indep, E(XY ) = E(X)E(Y)

4. inégalité de Bienayme-Tchebychev

1 Notion de variable aléatoire

1. Définition : une variable aléatoire est une application de Ω dans un ensemble E. En général,

Eest égal à R(on parle alors de variable aléatoire réelle, en abrégé var) ou à Rk(on parle alors

de vecteur aléatoire). Si rien n’est précisé, les variables aléatoires considérées seront à valeurs

dans R.

Si Aest une partie de E, l’ensemble {w∈Ω|X(w)∈A}est un évènement que l’on note

(X∈A) ou [X∈A]. En particulier (X610) = {w∈Ω|X(w)610). Comme Ω est fini 1,X

ne prend qu’un nombre fini de valeurs. On dit alors que Xest une variable aléatoire finie.

Déterminer la loi de probabilité de Xc’est déterminer les valeurs x1,...,xnque prend Xet

calculer les probabilités associées P(X=x1),...,P(X=xn).

Remarque :

• les évènements [X=x1],...,[X=xn] forment un système complet d’évènements de

Ω. En particulier,

n

X

i=1

P(X=xi) = 1 .

• Si Aest une partie de X(Ω), on pose PX(A) = P(X∈A). L’application PXest alors

une probabilité sur X(Ω). Déterminer PXrevient à déterminer la loi de X. Elle mesure la

vraisemblance des valeurs de X(Ω), c’est-à-dire des valeurs que prend X.

Exemple : on lance successivement deux dés, on note Sla somme des deux dés. Alors Ω = J1,6K2

muni de la probabilité uniforme. On a S(Ω) = J2,12K.

2. Fonction de répartition : si Xest une variable aléatoire finie, on appelle fonction de répartition

de Xla fonction notée FXde Rdans Rdéfinie par :

∀x∈R, FX(x) = P(X6x).

C’est une fonction en escalier, croissante.

1. l’année prochaine, on généralisera avec X(Ω) dénombrable, la variable aléatoire est dite alors discrète.

©Arnaud de Saint Julien - MPSI Lycée La Merci 2015-2016 2

Elle détermine totalement la loi d’une variable aléatoire discrète (cad lorsque X(Ω) est dénom-

brable ou fini). En effet, si par exemple Xprend les valeurs x0<···< xn, on a

P(X=x0) = P(X6x0) et ∀k∈J2, nK, P (X=xk) = P(X6xk)−P(X6xk−1).

Astuce : la fonction de répartition pêut être par exemple utile pour déterminer la loi du maximum

de plusieurs variables aléatoires. En effet, par exemple

P(max(X, Y )6k) = P((X6k)∩(Y6k)).

3. Un exercice modèle : on tire successivement sans remise deux boules dans une urne contenant

des boules numérotés de 1 à n. On note Xle plus grand numéro des deux boules tirées. On a

pour k∈X(Ω) = J2, nK,P(X6k) = P(X16k)P(X16k)(X26k) = k

n×k−1

n−1ou P(X6k) = (k

2)

(n

2)

d’où P(X=k) = 2(k−1)

n(n−1) .

2 Deux indicateurs fondamentaux : l’espérance et la variance

1. Espérance :

Définition 1 Si Xest une variable aléatoire réelle prenant les valeurs x1,...,xn, on appelle

espérance de Xle réel

E(X) =

n

X

i=1

xiP(X=xi)ou E(X) = X

x∈X(Ω)

xP (X=x).

Quelques remarques :

• L’espérance est la moyenne des valeurs xipondérés par les probabilités P(X=xi). C’est

un indicateur de position. Elle est en particulier comprise entre les valeurs extrêmes des xi.

• Si Xest une vecteur aléatoire, c’est-à-dire une varaible aléatoire à valeurs dans un espace

vectoriel E, alors on définit de même E(X) qui est un vecteur de E.

• Si Xreprésente le gain à un jeu de hasard, on dit que le jeu est équitable si E(X) = 0,

favorable si E(X)>0 et défavorable si E(X)<0. Par exemple, dans le jeu de la roulette

(18 numéros rouges, 18 noires et une verte), l’epérance de gain vaut −1

37 sa mise, soit une

perte pour le joueur en moyenne d’environ ∼2.7% sa mise.

On peut exprimer l’espérance à l’aide des probabilités des évènements élémentaires :

Proposition 2

E(X) = X

w∈Ω

X(w)P({w}).

On en déduit les propriétés suivantes :

Proposition 3 (Propriétés fondamentales)

©Arnaud de Saint Julien - MPSI Lycée La Merci 2015-2016 3

• Linéarité de l’espérance : si Xet Ysont des variables aléatoires réelles et aet bdes réels

on a :

E(aX +bY ) = aE(X) + bE(Y).

• Théorème de transfert : si Xest une variable aléatoire réelle prenant les valeurs x1,...,xn,

et gest une fonction de X(Ω) dans R, alors

E(g(X)) =

n

X

i=1

g(xi)P(X=xi).

• Si Aest un évènement, on a E(1A) = P(A).

• Positivité et croissance : soit Xet Ydeux variables aléatoires réelles.

Si X>0, alors E(X)>0et si X>Y, alors E(X)>E(Y).

Remarques :

• En particulier E(aX +b) = aE(X) + bcar E(b) = b(comprendre pourquoi) !

• En général, E(XY )6=E(X)E(Y) (si Xprend les valeurs ±1 de manière équiprobable,

alors X2= 1, d’où E(X2) = 1 mais E(X) = 0, d’où E(X2)6=E(X)2). Nous verrons par la

suite que cette égalité est vraie si Xet Ysont des variables aléatoires indépendantes.

• L’intérêt du théorème de transfert est de calculer l’espérance de f(X) sans avoir à connaître

la loi de f(X) (qui est plus délicat).

Exemple : si S=X1+X2est la somme de deux dés, E(S) = 7, par linéarité car E(X1) =

E(X2) = 1 ×1

6+ 2 ×1

6+...+ 6 ×1

6=7×6

2×1

6=7

2

2. Variance

Définition 4 Si Xest une variable aléatoire réelle prenant les valeurs x1,...,xn, on appelle

variance de Xle réel V(X) = E(X−E(X))2et écart-type de Xle réel σX=qV(X).

La variance est «la moyenne des carrés des écarts à la moyenne», elle mesure donc la dispersion

des valeurs xipar rapport à la moyenne E(X). La variance est un nombre toujours positif.

La variance peut se calculer avec la formule suivante

V(X) =

n

X

i=1

(xi−E(X))2P(X=xi)

qui découle du théorème de transfert. Mais en général, on la calculera avec la formule dite de

Huygens :

Proposition 5 On a

V(X) = E(X2)−E(X)2.

De plus, pour tous réels aet b, on a V(aX +b) = a2V(X)

En particulier, la variance n’est pas linéaire 2et on a V(a+X) = V(X) et V(b) = 0.

2. Nous verrons par la suite que si Xet Ysont des variables aléatoires indépendantes, on a quand même V(X+Y) =

V(X) + V(Y).

©Arnaud de Saint Julien - MPSI Lycée La Merci 2015-2016 4

Remarques :

• si Xest une variable aléatoire de variance non nulle, alors la variable aléatoire Y=X−E(X)

√V(X)

a une espérance nulle et une variance égale à 1. On dit que Yest centrée et réduite.

• si Xa une variance nulle, donc un écart-type nul, alors Xest presque sûrement constante,

c’est-à-dire P(X=E(X)) = 1.

• Plus généralement, on appelle moment d’ordre kd’une variable aléatoire Xle nombre

E(Xk).

Exercice : On pose X=1A+2×1Boù Aet Bsont deux évènements tels que P(A) = 1

2, P (B) = 1

3

et P(A∩B) = 1

4. Calculer l’espérance et la variance de X.

3 Lois usuelles finies

Nous allons lister les lois usuelles des variables aléatoires finies. 3Lorsque vous reconnaissez l’une

de ces lois, vous pouvez ainsi utiliser sans les redémontrer les résultats de ce paragraphe.

1. Loi uniforme : si Xest une variable aléatoire qui prend les valeurs 1,...,n de façon équipro-

bable, on dit que Xsuit une loi uniforme sur J1, nK, on note X ֒→ U(J1, nK) et on a :

∀k∈ {1,...,n}, P (X=k) = 1

n, E(X) = n+ 1

2, V (X) = n2−1

12 .

Exemple modèle : une urne contient nboules numérotées de 1 à n. On en prend une au hasard.

Si Xest le numéro de la boule tirée, on a X ֒→ U(J1, nK).

2. Loi de Bernoulli : si Xest une variable aléatoire prenant uniquement les valeurs 0 et 1, et que

P(X= 1) = p, on dit que Xsuit une loi de Bernoulli de paramètre p. Alors

E(X) = pet V(X) = p(1 −p).

On dit qu’une expérience aléatoire est une épreuve de Bernoulli lorsqu’elle admet seulement

deux issues possibles, moralement échec ou succès. L’exemple classique est le lancer d’une pièce

(équilibrée ou non).

Remarque : si Aest un évènement, la fonction indicatrice 1Aest une variable aléatoire qui suit

une loi de Bernoulli de paramètre p=P(A).

3. Loi Binomiale : on répète nfois de manière indépendante une épreuve de Bernoulli de

paramètre p. On note Xla variable aléatoire donnant le nombre de succès au cours des n

épreuves. Alors Xpeut prendre les valeurs 0,1,...,n et on montre que

∀k∈ {0,...,n}, P (X=k) = n

k!pk(1 −p)n−k.

3. L’année prochaine, vous verrez les lois discrètes mais infinies : loi géométrique et loi de Poisson. Il existe aussi des

lois dites continues ou à densité (les variables aléatoires ne prennent alors pas seulement des valeurs entières, mais toutes

les valeurs d’un intervalle), telles que la loi normale, ou loi exponentielle. Mais elles ne sont pas au programme de prépa.

©Arnaud de Saint Julien - MPSI Lycée La Merci 2015-2016 5

On dit que Xsuit une loi binomiale de paramètres net p, on note X ֒→ B(n, p). On montre

que 4

E(X) = np et V(X) = np(1 −p).

Exemple modèle : une urne contient des boules blanches et noires avec une proportion pde

boules blanches. On tire nboules avec remise et on note Xla variable aléatoire donnant le

nombre de boules blanches tirées après les ntirages. Alors Xsuit une loi B(n, p).

Contre-exemple : un tireur à l’arc tire nfois sur une cible avec pla probabilité qu’il touche

la cible au cours du permier tir. On note Xla variable aléatoire donnant le nombre de fois

qu’il touche la cible au cours des ntirs. Si on suppose que le tireur n’a «aucune psychologie» à

savoir que rater ou réussir son tir n’influe pas sur son tir suivant, alors Xsuit une loi binomiale

de paramètres net p. Sinon, s’il prend confiance en réussissant un tir (ou stresse s’il a raté), la

probabilité de toucher la cible est modifiée à chaque épreuve, et Xne suit plus une loi binomiale.

Exercice : «Surbooking» Un restaurant possède 50 places. La probabilité pour qu’une personne,

ayant réservé, ne vienne pas est de 20%. Un jour, le patron a pris 53 réservations. Quelle est la

probabilité qu’il se retrouve dans une situation embarassante ?

4. Loi hypergéométrique (hors-programme) :

Situation modèle : une urne contient Nboules, des blanches et des noires. On note pla

proportion de boules blanches. On effectue ntirages sans remise et on note Xle nombre de

boules blanches obtenues. Alors,

∀k∈N, P (X=k) = Np

kN−Np

n−k

N

n.

Dans ce cas, on dit que Xsuit une loi hypergéométrique de paramètres N,net p, on note

X ֒→ H(N, n, p). Quelques remarques :

• Dans cette formule un peu compliquée, Np est le nombre total de boules blanches et N−Np

le nombre total de noires.

• «preuve de la loi de probabilité» : on modélise l’expérience aléatoire par des tirages simul-

tanés (c’est bien équilent à des tirages sans remise). Il y en a N

n, et ils sont équiprobables,

on peut donc écrire P(X=k) = Card(X=k)

N

n. Enfin, l’évènement [X=k] est réalisé si

l’on tire kblanches parmi les Np blanches et si l’on tire n−knoires parmi les (N−Np)

noires, donc Card(X=k) = Np

kN−Np

n−kd’où le résultat.

• On a écrit P(X=k) pour tout k∈N. En fait Xne peut évidemment prendre toutes

ces valeurs, par exemple , on est sûr que X6n. Mais la formule précédente reste valable

lorsque kest une valeur que Xne peut prendre car on a alors P(X=k) = 0.

• Si les ntirages étaient effectués avec remise, on pourrait les considérer comme indépen-

dants et ainsi Xsuivrait une loi binomiale de paramètres net p.

4. Pour se souvenir de ce résultat, on écrit X=X1+· · · +Xnoù pour tout i∈ {1, . . . , n},Xiest la variable aléatoire

qui vaut 1 si on réalise un succès à la i-ème épreuve et 0 sinon. Xisuit une loi de Bernoulli de paramètre p, donc

E(Xi) = painsi par linéarité E(X) = np. De plus comme les variables aléatoires X1, . . . , Xnsont indépendantes, on a

V(X1+···+Xn) = V(X1) + ···+V(Xn) et on obtient ainsi V(X) = nV (X1) = np(1 −p).

6

6

7

7

8

8

1

/

8

100%