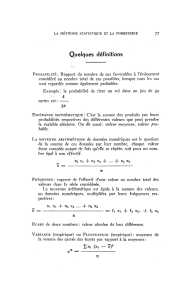

Tests paramétrique et non paramétrique

Tests paramétrique et non paramétrique

La plupart des tests statistiques sont construits à partir d'hypothèses sur les

distributions des variables étudiées chez les individus. Dans un grand nombre de

situations, la distribution utilisée est la loi normale. Si l'on dit : la glycémie suit

une loi normale, cela signifie que la densité de probabilité de la variable glycémie

est gaussienne ou normale. D'autres distributions de probabilités peuvent être

plus adaptées comme par exemple une distribution binomiale ou une distribution

de Poisson pour les variables catégorielles. L'utilisation d'un test paramétrique

suppose de connaître la loi (ou la famille de lois) sous-jacente et que les densités

de probabilités associées dépendent de paramètres donnés de la loi tels la

moyenne et la variance pour la loi normale [19]. Lorsque la famille à laquelle

appartiennent les densités de probabilités est inconnue, on optera pour un test

non paramétrique.

Par exemple, le test de comparaison de 2 moyennes sur des petits échantillons

suppose que la loi parente soit normale. Si on ne peut le prouver directement ou

par transformation de variable, on utilisera alors par exemple un test de rang. Ce

type de tests ne traite pas des valeurs numériques mais de leurs rangs. On

rappellera que le terme non-paramétrique s'applique aux méthodes statistiques

utilisées et que ce n'est pas une propriété des données [19]. Un exemple de

tests paramétriques et des équivalents non paramétriques est donné au tableau

2.

Tableau 2 : Exemple de tests paramétriques et de leurs équivalents non paramétriques

Test paramétrique

Test non paramétrique

Test t de Student non apparié

Test de Mann et Whitney

Test t de Student apparié

Test de Wilcoxon

Analyse de variance

Test de Kruskall et Wallis*

Corrélation linéaire

Test de Spearman

* cas particulier de 2 variables

Type de variable considéré

On distingue plusieurs types de variables, schématiquement les variables

qualitatives et les variables quantitatives. Les variables qualitatives comprennent

les variables nominales et ordinales. Les variables nominales ont deux modalités

(homme/femme), ou plus de deux modalités (insuffisance rénale aiguë

prérénale/rénale/post rénale). Si il y a une structure d'ordre entre les catégories

d'une variable on parle de variable ordinale (stades TNM des tumeurs). La

différence entre deux catégories adjacentes n'est pas forcément homogène sur

toute l'étendue de la variable (score d'Apgar). Les variables qualitatives sont

généralement représentées sous forme de pourcentages ou de proportions.

Les variables quantitatives sont de deux types, soient continues lorsqu'elles

peuvent prendre toutes les valeurs d'un continuum (âge, glycémie, pression

artérielle), soient discrètes lorsqu'elles prennent des valeurs entières (nombre de

transfusions, nombre de grossesses). Elles peuvent aussi être censurées lorsqu'il

s'agit d'analyser des durées. Si au cours du suivi l'événement étudié (décès, ou

récidive, ou rechute, …) n'est pas survenue la variable est dite censurée.

Selon le type de variable analysé, des tests différents sont utilisés, un test du

Chi2 par exemple pour comparer des pourcentages, un test t de Student pour la

comparaison de deux moyennes de lois normales.

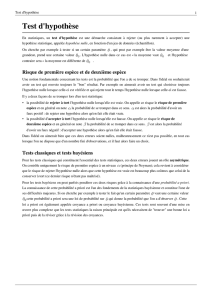

Définition des hypothèses testées.

Nous l'avons vu, il est nécessaire de définir les conditions dans lesquelles le ou

les tests statistiques seront employés. Ceci impose donc de définir a priori les

hypothèses testées, et les risques et consentis. On se donne ensuite une

valeur (cliniquement pertinente) de pour calculer le nombre d'observations

nécessaire qu'il faudra étudier.

On définira dans le protocole si des analyses intermédiaires seront réalisées et

leur périodicité. De la même façon, des tests appropriés doivent être choisis en

cas de comparaisons multiples.

Vérification des conditions d'application des tests choisis

La plupart des tests statistiques ne sont utilisables que dans des conditions bien

définies, desquelles on peut être autorisé ou non à s'écarter. Il s'agit de la nature

de la distribution de la variable, des effectifs, ou de conditions plus particulières

comme l'égalité des variances, l'indépendances ou non des variables, ...

Pour les variables a priori normales (une pression artérielle, une glycémie), on

vérifie si l'hypothèse de normalité de la distribution est acceptable. Plusieurs

procédures permettent d'accomplir cette tâche. Deux situations extrêmes

peuvent être illustrées. Soit l'effectif considéré est faible et la puissance associée

sera faible. Soit l'effectif est important, et les tests de normalité ont des chances

de mettre en évidence un écart à la normalité modeste (mais statistiquement

significatif) qui n'aurait pas vraiment gêné l'application de tests paramétriques.

Aussi, de nombreux auteurs conseillent-ils de se contenter de vérifications

graphiques de la normalité. Il est probablement nécessaire de limiter cette

vérification aux situations où la nature même de la variable fait suspecter une

distribution non normale. Des transformations de variables, par exemple de type

logarithmique (log x) ou inverse , peuvent permettre de se ramener à une

distribution normale.

Séries appariées

La comparaison de deux moyennes (de lois normales) entre deux groupes de

patients peut faire appel au test t de Student. Que se passe-t-il si ces moyennes

proviennent du même groupe, mesurées à deux temps différents ? On dit que

ces mesures sont appariées. L'utilisation du test t de Student usuel n'est plus

approprié car les deux séries de mesure ne sont pas indépendantes sur le plan

statistique. Il convient d'utiliser un test qui prenne en compte le fait que la

mesure a été effectuée deux fois sur les mêmes patients comme un test t de

Student pour séries appariées (ou un test de Wilcoxon dans le cas non

paramétrique). Dans le cas de plusieurs mesures répétées au cours du

temps, des stratégies variées peuvent être retenues

Comparaisons entre plusieurs traitements

La deuxième situation concerne la comparaison de plusieurs traitements par

exemple la comparaison de trois agents anesthésiques (B, C et D) à un agent

anesthésique A sur l'incidence des vomissements post opératoires. Cette

incidence est de 40 % avec B, 30 % avec C, et 20 % avec D (n=100 dans

chaque groupe). L'analyse statistique réalisée en comparant A vs B, A vs C, A vs

D conduit à conclure que seul D est différent de A. Du fait des comparaisons

multiples, il faut bien noter que le risque de première espèce consenti n'est plus

de 0,05 mais de 0,11 (3 comparaisons). Si l'on comparait 100 agents

anesthésiques à l'agent A, avec un risque , on pourrait attendre que 5

d'entre eux soient différents de A, seulement par hasard ! L'analyse statistique

doit tenir compte des comparaisons multiples afin de garantir in fine un risque

global de première espèce de 0,05 [23].

Le risque étant considéré comme essentiel dans les tests d'hypothèses, il est

important de s'assurer que le risque consenti lors de l'analyse est effectivement

celui qui était prévu initialement. Cinq situations seront examinées.

A partir du moment où la comparaison statistique est effectuée sur plusieurs

moyennes (plus de 2), il n'est pas possible d'utiliser un test prévu pour comparer

deux moyennes une seule fois. Il convient d'utiliser une méthode statistique qui

garantisse la conservation du risque . Sans entrer dans le détail des

nombreux choix possibles, on peut indiquer quelques pistes. L'analyse de

variance qui permet sous certaines hypothèses (mesures obtenues dans des

conditions indépendantes, données de moyennes distribution gaussienne, même

variance entre groupes) de tester si n moyennes différentes entre elles. Si c'est

le cas on peut s'interroger alors pour savoir quelle moyenne diffère de quelle

autre. On comprendra qu'en fonction du nombre de groupes testés, le nombre de

comparaisons peut être important. Aussi des tests particuliers ont été proposés

pour la réalisation de ces comparaisons dites a posteriori ou post hoc. Si on

compare plusieurs groupes à un groupe de référence on utilisera le test de

Dunnett. Si on compare plusieurs groupes entre eux, on utilisera un test de

Tukey ou un test de Newman-Keuls. Il est toujours possible aussi d'utiliser la

correction dite de Bonferroni. Elle consiste à diviser le risque par le nombre n

de comparaisons à tester. Si on compare 3 valeurs de pression artérielle entre

elles (1 avec 2, 1 avec 3 et 2 avec 3), le risque sera de . Si une

valeur de p est inférieure à 0,016, on écrira alors que la différence est

significative au risque de 0,05.

Mesures répétées

Imaginons que nous comparions les vomissements induits par A ou B toutes les

heures pendant les 24 premières heures post-opératoires. Là encore, si on désire

maintenir un risque de 0,05, il faut tenir compte du fait que 24 comparaisons

successives ont été effectuées, ou se contenter d'une analyse globale sur

l'ensemble des 24 heures. Plusieurs stratégies d'analyse sont envisageables dans

le cadre de mesures répétées [22].

Analyse par sous-groupes

Nous avons comparé l'incidence de vomissements entre A et B et conclu à

l'absence de différence significative. Il vient alors l'idée de répartir les patients en

différents sous-groupes (hommes et femmes, patients de plus ou moins de 60

ans, suivant la classe ASA (American Society of Anaesthesiology) ou le type de

chirurgie réalisé). Là encore, l'analyse par sous-groupes expose au risque de

conclure à tort à une différence significative si des tests séparés sont réalisés par

sous-groupes et doit donc tenir compte de la multiplicité des comparaisons. De

plus, une analyse par sous-groupes suppose que ceux-ci soient comparables

(selon A et B), que ceci ait été prévu à l'avance dans l'élaboration du protocole et

que les interactions soient prises en compte dans l'analyse. Une interaction, au

sens statistique, décrit une situation pour laquelle l'impact d'un facteur sur la

réponse mesurée dépend de la valeur d'un autre facteur [24, 25, 26].

Critères de jugement multiples

Dans une même étude comparant les agents anesthésiques A et B, nous

étudions plusieurs paramètres différents (dont l'incidence des vomissements) au

risque =0,05. La réalisation de tests séparés pour chaque critère de jugement

augmente le risque de faux résultats positifs [27]. C'est pourquoi une bonne

étude s'efforce de ne répondre qu'à une seule question principale (l'IEC ralentit-il

la progression de l'IRC?) avec un seul critère de jugement (la mesure du débit de

filtration glomérulaire), dit critère de jugement principal. Si toutefois l'on veut

tenir compte de plusieurs critères de manière concomitante il est possible de

définir à l'avance des priorités dans l'analyse des critères de jugement. Un critère

est par exemple privilégié par rapport aux autres. Il est possible aussi de

combiner la réponse à plusieurs critères dans un score global. Toutefois, la

constitution d'un tel score est une tâche délicate en particulier pour fixer le poids

relatif de chacun des critères de jugement au sein de ce score global.

C'est pour ces raisons qu'une bonne analyse statistique doit être définie a priori

et non a posteriori. La méthodologie statistique d'une investigation clinique ou

expérimentale doit être définie lors de la conception initiale du projet. L'avis d'un

statisticien est envisagé selon le degré de complexité du problème abordé dès la

conception du projet.

Analyses intermédiaires

Dans un protocole où l'on compare deux agents anesthésiques, une analyse est

réalisée tous les 50 patients inclus. Ce type d'analyse séquentielle groupée

permet de ne pas prolonger indûment une étude dont les résultats apparaissent

significatifs avant que l'ensemble de l'effectif total prévu ait été inclus. Après 200

patients inclus, les vomissements sont survenus chez 40 patients ayant reçu A et

chez 25 patients ayant reçu B. On rejette l'hypothèse nulle et on conclut que B

est meilleur que A. Cependant, pour cette analyse finale, les 3 analyses

précédentes infructueuses ont été oubliées. Tous calculs faits, le risque de

première espèce consenti (tableau 4) n'est pas de 0,05 mais en fait de 0,13 [27].

L'analyse statistique aurait dû tenir compte des comparaisons multiples

effectuées dans cet essai et retenir une valeur nominale de de 0,018 (tableau

5). L'utilisation d'une valeur seuil identique pour chaque analyse intermédiaire a

l'avantage de la simplicité sinon celui de l'optimisation [28]. Ces analyses

intermédiaires doivent être prévues a priori dans le protocole d'un essai ce qui

était le cas de l'étude ramipril [8]. Cinq analyses intermédiaires avaient été

prévues, une conclusion a pu être portée à la deuxième analyse pour le strate 2.

Tableau 4 : Tests de signification répétés à intervalles équidistants dans le cas de 2

traitements,

pour une réponse gausienne et de variance connue [27].

Nombre de tests répétés

au seuil de 5 %

Niveau global de signification

1

0.05

2

0.08

3

0.11

4

0.13

5

0.14

10

0.19

20

0.25

50

0.32

100

0.37

Tableau 5 : Niveau de signification requis dans le cas de tests bilatéraux répétés pour un

seuil global de =5 % (réponse de distribution normale avec une variance connue pour

un global de 0.05 [27].

Nombre de tests

Valeur pour chaque test

2

0.029

3

0.022

4

0.018

5

0.016

10

0.0106

Puissance d'un test et nombre de sujets nécessaire

Seulement 30 % d'un échantillon de 71 essais thérapeutiques publiés dans 20

journaux en 1978-79 étaient de taille suffisante pour avoir 90 % de chances de

mettre en évidence une différence de 50 % d'efficacité entre traitements [13].

Dix ans plus tard, selon une approche analogue, les auteurs constataient le

même phénomène lié à une inadaptation de la puissance de l'analyse par

insuffisance d'effectif. L'absence d'évidence d'un effet n'est pas l'évidence de

l'absence de cet effet. Ne pas mettre en évidence un effet dans un échantillon ne

signifie pas qu'aucun effet n'existe en réalité. Tout essai thérapeutique doit faire

état du calcul préalable du nombre de patients nécessaire et de la puissance de

l'essai. C'est un des critères de bonne pratique méthodologique

Puissance d'un test, différence attendue et variance de l'effet

Sur la figure 2, trois situations sont représentées. La première (figure 2a) décrit

un test d'hypothèse et la distribution sous H0 et sous H1 des moyennes de 2

groupes de sujets représentées en coordonnées normales centrées réduites. Si

l'on diminue la différence à observer de 3 (figure 2a) à 1 (figure 2b) sans

changer la variance des distributions, on note que croit et que la puissance du

test diminue. Maintenant pour une même différence de 3, si on modifie la

6

6

7

7

8

8

9

9

10

10

11

11

12

12

1

/

12

100%