sniadecki ke pe s 2

1

François Képès,

rationalisateur

des machines vivantes

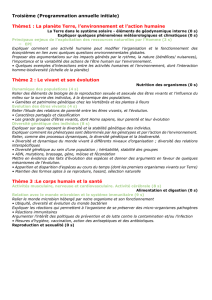

Le magazine scientifique Pour la

science de juin 2014 a fait sa première

de couverture avec le titre accrocheur

Réinventer le vivant, quels enjeux pour la

biologie de synthèse ? qui annonce le

dossier

1

consacré à cette nouvelle

technoscience. Comme il se doit,

l’illustration de cette couverture est

une molécule d’ADN, mais cette fois

constituée de circuits électroniques…

L’article le plus intéressant est sans

conteste celui du généticien François

Képès

2

intitulé “La biologie de

synthèse : vers une ingénierie du

vivant”.

Or François Képès est avant tout un ingénieur et en ce qui concerne la

biologie de synthèse, il sait ce qu’il veut : faire du vivant – pour le

moment surtout des bactéries les plus élémentaires – la nouvelle

machine-outil de l’industrie des biotechnologies.

1

Pour la science n°440, juin 2014. Ce dossier est constitué de trois articles. Les citations

issues de l’article de François Képès sont référencées : (PLS).

2

« François Képès est directeur de recherche à l’institut de Biologie des Systèmes et de

Synthèse (ISSB, Genopole, UEVE, CNRS) et directeur du Programme d’épigénomique à

Genopole, à Évry. Il est professeur invité permanent au Collège impérial de Londres. ».

Il est également l’auteur de la brochure de 64 pages, qui fait dans la vulgarisation assez

vulgaire, La biologie de synthèse plus forte que la nature ? éd. Le Pommier, 2011. Son

article de Pour la science reprend et complète cette brochure sur certains points.

2

Ingénierie rationnelle

Rappelant que « au début des années 1960, l’invention des circuits

intégrés a métamorphosé l’ingénierie électronique » (phrase qui a

manifestement inspiré l’illustration de la couverture de ce magazine), il

file l’analogie :

« Et si une telle combinaison de technique et de méthode était

transposable en biologie ? S’il était possible, en biologie aussi, de disposer

d’une banque d’outils et de règles rationnelles qui, combinés selon les

besoins, aideraient à comprendre le vivant en le fabriquant, ou à concevoir

et produire à la demande de nouvelles fonctions biologiques n’existant pas

dans la nature ? Depuis quelques années, cette idée fait son chemin parmi

les biologistes. Rassemblées sous le nom de biologie de synthèse, leurs

approches se construisent aux interfaces de la biologie et de l’ingénierie,

avec des apports de la chimie, de la physique, des mathématiques et de

l’informatique. Elles ont pour objectif d’injecter en biologie les principes

fondant toute ingénierie. De quoi s’agit-il ? Quelles sont les ambitions de la

biologie de synthèse ? Que permet-elle aujourd’hui ? Quelles sont ses

perspectives et limites ? Telles sont les questions que nous examinerons

ici. » (PLS)

Pour ensuite proposer une définition claire et précise :

« La biologie de synthèse est l’ingénierie rationnelle de la biologie. En

d’autres termes, elle vise à la conception rationnelle et à l’ingénierie de

systèmes complexes fondés sur le vivant ou inspirés par le vivant, et dotés

de fonctions absentes dans la nature. » (PLS)

Pour mettre en œuvre cette « ingénierie rationnelle », il faut des

bases solides :

« Qu’est-ce que cela signifie ? Les ingénieries de systèmes électroniques

ou mécaniques nécessitent des cadres bien établis pour gérer la

complexité, des outils fiables pour manipuler les états du système, et des

plateformes de tests. La biotechnologie, en revanche, est encore dépourvue

de tels cadres, outils et plateformes. » (PLS)

Or, comme l’avait déjà constaté en 2012 Geneviève Fioraso

3

dans son

Rapport sur les enjeux de la biologie de synthèse : « La complexité du

vivant : un verrou à lever pour la biologie de synthèse »

4

. Il est donc

3

Avant de devenir ministre de la Recherche et de l’Enseignement Supérieur dans le

gouvernement de François Hollande. Voir son portrait au vitriol en tant que députée et

adjointe à la Ville de Grenoble “Geneviève Fioraso™, l’élue augmentée” dans Le Postillon,

journal de Grenoble et de sa cuvette n°14, février-mars 2012.

4

C’est le titre d’un chapitre de ce rapport, réalisé à partir d’auditions publiques

organisées par l’Office Parlementaire d’Évaluation des Choix Scientifiques et

3

nécessaire de simplifier tout cela, afin de faire en sorte que le vivant,

par trop instable, fantasque et imprévisible, se comporte enfin comme

une machine-outil régulière, fiable et prévisible. C’est ce sur quoi

s’achève son article :

« Une barrière, enfin, est la taille limite des circuits biochimiques que

l’on réussit à construire. […] Comment briser ce plafond pour construire

des circuits biochimiques plus complexes et augmenter d’autant les

possibilités de la biologie de synthèse ? Pour une part, ce plafond tient à

notre incapacité à concevoir un génome complet. Pour étendre fortement

la taille et la complexité des circuits, il faudrait pouvoir introduire un

nombre arbitraire de gènes qui coopéreraient de façon optimale selon un

cahier des charges fixé par avance. […]

Plusieurs équipes se sont ainsi lancées dans des recherches visant à

synthétiser ou à réduire des génomes complets d’organismes

unicellulaires. C’est le cas, par exemple, de l’équipe de l’Institut J. Craig

Venter, à Rockville aux États-Unis, et de celle de Fred Blattner, de

l’Université du Wisconsin, à Madison, pour les bactéries, ou encore de celle

de Jef Boeke et Joël Bader, de l’Université Johns Hopkins, à Baltimore, pour

la levure. […]

Dans mon équipe, nous cherchons précisément à exploiter les

contraintes connues des génomes de micro-organismes pour la conception

ab initio de génomes porteurs de grands circuits de synthèse. » (PLS)

La « conception ab initio d’un génome » revient en fait à chercher

quel est le « génome minimal – un génome qui ne contiendrait que les

gènes nécessaires au fonctionnement de la cellule » et qui servirait

donc de « plateforme » sur laquelle des « extensions » pourraient être

ajoutées, des « constructions génétiques » plus ou moins complexes

seraient greffées afin de produire les molécules ou réaliser les fonctions

biologiques souhaitées.

Révolution industrielle

François Képès veut donc, avec son « ingénierie rationnelle »

appliquée à la biologie de synthèse, faire ce que les ingénieurs du XIX

e

siècle ont réalisé dans la conception des machines qui ont été le vecteur

de la révolution industrielle : normaliser les mesures, standardiser les

dimensions afin de rendre possible l’interchangeabilité des pièces et

rationaliser la conception des machines.

Technologiques (OPECST) le 4 mai 2012. Document en deux volumes disponible sur

Internet.

4

C’est là un aspect de la révolution industrielle qui est souvent oublié :

on présente couramment l’invention de la machine à vapeur comme

l’acte fondateur de cette période ; et ce n’est certes pas complètement

faux. Car il faut bien un moteur indépendant des éléments naturels

5

pour animer de manière régulière et continue un grand nombre de

machines engagées dans une production de masse

6

. Mais cette

révolution dans la production repose avant tout sur la généralisation de

l’emploi des machines ; machines qu’il faut donc produire en grand

nombre, voire en masse, c’est-à-dire de manière qui soit elle-même

industrielle.

Or, avant la révolution industrielle, toutes les machines, des plus

simples aux plus complexes (les horloges et les moulins à vent, pour

n’évoquer que les plus courantes depuis le XIII

e

siècle jusqu’au XVIII

e

siècle) étaient produites de manière artisanale. Un atelier ne produisait

pas en série une pièce pour qu’ensuite un autre atelier assemble les

machines. Un artisan et ses ouvriers fabriquaient eux-mêmes toutes les

pièces d’une machine et les ajustaient les unes aux autres en sorte

qu’au final, elle fonctionne. Chaque machine était donc unique ; en

conséquence une pièce d’une machine ne pouvait pas servir à

remplacer une pièce défectueuse d’une autre machine. Ce n’est qu’à la

fin du XVIII

e

siècle dans l’horlogerie (industrie de luxe à l’époque) que

des dimensions standardisées seront adoptées pour la réalisation des

engrenages et des vis, afin de faciliter une production qui reste encore

totalement artisanale.

L’idée de l’interchangeabilité des pièces d’une machine remonte à

l’invention des caractères mobiles pour l’imprimerie, mais elle n’a

jamais vraiment été étendue à d’autres mécaniques, probablement à

cause de la difficulté qu’il y a à mouler des métaux autres que ductiles

(or, argent, laiton, plomb). Au début du XVIII

e

siècle, Guillaume

Deschamps propose un fusil dont les pièces sont interchangeables et

réalise une démonstration devant le Roi de France en 1726 avant de

créer une fabrique qui fournira 12 000 fusils à la marine. Toutes les

pièces de ce fusil sont réalisées par des artisans, ce qui fait dire à un

commentateur :

5

Comme peuvent l’être le débit de l’eau d’une rivière, le vent ou les animaux pour les

moulins ; cf., Chris de Decker, “Des fabriques mues par le vent: histoire (et avenir) des

moulins à vent”, Low-Tech Magazine, octobre 2009.

6

Production de masse qui implique aussi, à l’intérieur de l’usine, une discipline du travail

qui plie la main d’œuvre au rythme des machines, ne l’oublions pas.

5

« L’idée de faire convenir toutes les pièces des platines, les unes avec les

autres, est ingénieusement imaginée, mais ceux qui connoissent l’usage de

la forge, sçavent qu’elle ne peut former ces pièces en perfection, qu’elle

peut seulement les disposer et que ce n’est que la lime qui peut les

approprier au model, ainsy le temps qu’on y employ est de grande

dépence. »

En d’autres termes, il est difficile et coûteux de chercher à produire

des pièces interchangeables de manière entièrement artisanale, et c’est

pourquoi cette livraison à la marine n’aura pas de suite

7

.

Pourtant, le maître arquebusier Honoré Blanc (1736-1801) propose

en 1777 au Roi de France, puis à l’État issu de la Révolution française,

un nouveau modèle de fusil aux pièces interchangeables

8

. Pour lui, la

solution réside dans la standardisation. Dans un « règlement », il

précise les dimensions de toutes les pièces de son nouveau modèle.

« L’interchangeabilité implique que la précision de la fabrication des

pièces d’un produit donné soit telle que leur assemblage ne nécessite

aucun ajustement final. A son niveau, la méthode de Blanc atteint cet idéal :

il met au point des matrices pour remplacer le forgeage des pièces, il

invente des gabarits pour les raboter et des machines à forer les trous pour

les façonner, il fabrique des calibres pour vérifier que les pièces s’ajustent

selon une certaine marge de tolérance. Bien que ce procédé soit mis en

œuvre à l’aide d’outils manuels, l’exécution dépend en principe de guides

mécaniques. Chaque ouvrier est obligé de faire des pièces qui s’ajustent

parfaitement lors de l’assemblage final. Le procédé de fabrication contrôle

le travail de l’artisan et, de ce point de vue, l’ajustement final du produit

témoigne de la rigueur avec laquelle l’ordre social est policé. […]

En 1777, [le chef de l’artillerie Jean-Baptiste de] Gribeauval et ses

partisans introduisent ainsi non seulement un nouveau modèle de fusil,

mais aussi de nouveaux rapports d’encadrement avec les armuriers [qui

sont des artisans indépendants]. Pour la première fois, au lieu d’acheter

des produits finis, l’État fixe les prix de pièces détachées qui, soulignons-le,

ne sont pas encore interchangeables. Les tests de qualité sont renforcés et

de nouvelles techniques de production sont introduites. Honoré Blanc est

chargé de faire en sorte que “soient pourvus les différents outils et

instruments nécessaires pour assurer l’uniformité dans les trois

manufactures”. »

7

Jean-Louis Peaucelle, “Du concept d’interchangeabilité à sa réalisation, le fusil des XVIII

e

et XIX

e

siècles”, revue Gérer et comprendre n°80, Juin 2005 (article disponible sur

Internet).

8

Ken Adler, “L’amnésie des armuriers français, comment une innovation technologique

majeure peut-elle tomber dans l’oubli ?”, magazine La Recherche n°308, avril 1998. Les

citations qui suivent sont issues de cet article.

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

1

/

24

100%