Cours 4 d'Hugo Gimbert sur les Jeux Stochastiques

Algorithmes pour les jeux stochastiques

Hugo Gimbert

27 novembre 2009

2

Table des matières

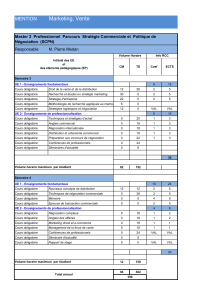

1 Jeux à 0joueur 5

1.1 ChaînesdeMarkov........................ 5

1.1.1 Distributions de probabilités et leurs limites . . . . . . 5

1.1.2 Chaînes de Markov . . . . . . . . . . . . . . . . . . . . 5

1.2 Calcul des probabilités d’accessibilité . . . . . . . . . . . . . . 7

1.3 Conditions de Büchi . . . . . . . . . . . . . . . . . . . . . . . 9

1.4 Vérification des systèmes probabilistes . . . . . . . . . . . . . 11

1.4.1 Approche naïve par automates . . . . . . . . . . . . . 12

1.4.2 Approche optimale . . . . . . . . . . . . . . . . . . . . 16

2 Jeux stochastiques à 2joueurs à information parfaite 19

2.1 Jeux d’accessibilité stochastiques à information parfaite . . . 19

2.1.1 Jeux et stratégies . . . . . . . . . . . . . . . . . . . . . 19

2.1.2 Valeurs et stratégies optimales . . . . . . . . . . . . . 21

2.2 Calcul des valeurs . . . . . . . . . . . . . . . . . . . . . . . . . 26

2.2.1 Polynomial dans le cas à un joueur . . . . . . . . . . . 26

2.2.2 Un problème dans NP ∩co −NP ........... 27

2.2.3 Algorithme d’amélioration des stratégies . . . . . . . . 27

2.2.4 Algorithme des permutations . . . . . . . . . . . . . . 28

3

TABLE DES MATIÈRES

4

Chapitre 1

Jeux à 0joueur

1.1 Chaînes de Markov

1.1.1 Distributions de probabilités et leurs limites

Pour mesurer les probabilités d’un nombre fini ou dénombrable d’événe-

ments, on utilise des distributions de probabilités.

Définition 1 (Distributions de probabilités).Etant donné un ensemble S

fini ou dénombrable, on note D(S)l’ensemble des distributions de probabilités

sur Sdéfini par D(S) = {δ:S→[0,1] |Ps∈Sδ(s)=1}.

Par exemple, Speut être l’ensemble {pile,face}et δ(pile) = δ(face) = 1

2.

Exercice 1. Supposons qu’on lance une pièce jusqu’à obtenir face. On peut

représenter cette expérience en utilisant l’ensemble d’états pile∗face ∪{pileω}.

Montrer que δdéfini par δ(pilenface) = 1

2n+1 et δ(pileω)=0est une distri-

bution de probabilités sur pile∗face ∪{pileω}.

Exercice 2. Est-il possible de choisir un entier n∈Nau hasard ?

Exercice 3. Supposons maintenant que S={pile,face}ω. Quelle particula-

rité ont les fonctions δ:S→[0,1] telles que Ps∈Sδ(s) = 1 ?

1.1.2 Chaînes de Markov

Pour pouvoir définir des probabilités sur des ensembles d’événements non-

dénombrables comme toutes les suites possibles de pile ou face, l’exercice 3

montre que les distributions de probabilités ne sont pas un outil mathéma-

tique adapté. Il faut utiliser la notion de mesure de probabilité. Dans ce

cours, on n’introduira pas la notion générale de mesure de probabilité, on se

bornera à mesurer la probabilité d’événements dans des chaînes de Markov.

Définition 2 (Chaînes de Markov).Soit Sun ensemble fini ou dénombrable.

Une chaîne de Markov est un triplet M= (S, s0∈S, p :S→ D(S).

5

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

1

/

29

100%