(BI) pour l`intégration

U

U

UN

N

NI

I

IV

V

VE

E

ER

R

RS

S

SI

I

IT

T

Té

é

é

S

S

SI

I

ID

D

DI

I

I

M

M

MO

O

OH

H

HA

A

AM

M

ME

E

ED

D

D

B

B

BE

E

EN

N

N

A

A

AB

B

BD

D

DE

E

EL

L

LL

L

LA

A

AH

H

H

F

F

Fa

a

ac

c

cu

u

ul

l

lt

t

té

é

é

D

D

De

e

es

s

s

S

S

Sc

c

ci

i

ie

e

en

n

nc

c

ce

e

es

s

s

E

E

Et

t

t

T

T

Te

e

ec

c

ch

h

hn

n

ni

i

iq

q

qu

u

ue

e

es

s

s

F

F

Fè

è

ès

s

s

d

d

dé

é

ép

p

pa

a

ar

r

rt

t

te

e

em

m

me

e

en

n

nt

t

t

d

d

d’

’

’I

I

In

n

nf

f

fo

o

or

r

rm

m

ma

a

at

t

ti

i

iq

q

qu

u

ue

e

e

P

P

Pr

r

ro

o

oj

j

je

e

et

t

t

d

d

de

e

e

F

F

Fi

i

in

n

n

d

d

d’

’

’E

E

Et

t

tu

u

ud

d

de

e

es

s

s

M

M

Ma

a

as

s

st

t

te

e

er

r

r

S

S

Sc

c

ci

i

ie

e

en

n

nc

c

ce

e

es

s

s

e

e

et

t

t

T

T

Te

e

ec

c

ch

h

hn

n

ni

i

iq

q

qu

u

ue

e

es

s

s

S

S

Sy

y

ys

s

st

t

tè

è

èm

m

me

e

es

s

s

I

I

In

n

nt

t

te

e

el

l

ll

l

li

i

ig

g

ge

e

en

n

nt

t

ts

s

s

&

&

&

R

R

Ré

é

és

s

se

e

ea

a

au

u

ux

x

x

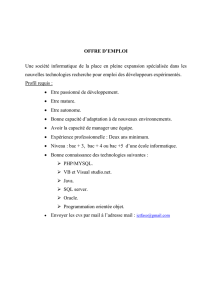

Développement et mise en production d’une solution

Business Intelligence (BI) pour l’intégration des données

de performances du Backbone IP 3G de Méditel.

Lieu de stage : CASABLANCA

Réalisé par : BOURAS Hicham

Soutenu le 22/06/2012

Encadré par : Devant le jury composé de :

Mr Mehdi MOUHIB Mr A. Benabbou

Mme Loubna LAMRINI Mme L.Lamrini

Mme A.Begdouri

Mr A.Ezzouhairi

Année Universitaire 2011-2012

Remerciement

Je tiens à remercier tout d’abord les professeurs de la faculté des Sciences et Technique

(FST) de Fès, notamment mes professeurs de l’équipe Master Système Intelligents &

Réseaux qui n’ont ménagé aucun effort afin de nous assurer ce parcours et nous transmettre

leurs connaissances, leur expérience et leurs valeurs.

Je tiens à remercier ensuite l’entreprise MEDITEL pour m’avoir permis d’effectuer quatre

mois de stage de fin d’études au sein de la Direction Qualité et Supervision.

Je tiens à remercier toute l’équipe de la Direction Qualité et Supersion de MEDITEL pour

leur accueil et leur collaboration.

Je tiens à remercier tout particulièrement et à témoigner toute ma reconnaissance à mon

encadrant Mr Mehdi MOUHIB de MEDITEL et mon encadrante Mme Loubna

LAMRINI de FST pour le temps qu’ils m’ont consacré tout au long de cette période et pour

l’expérience enrichissante et pleine d’intérêt qu’ils m’ont fait vivre durant ce stage.

Je tiens à remercier aussi les membres du service "Plateformes Qualité et Projets Support"

où j’ai effectué mon stage, Mme Sanaa (Manager du service) et Mme Asmaa, pour

l’accueil, la confiance et la collaboration qu’elles m’ont accordés dès mon arrivée à

l’entreprise afin de m’assurer une intégration facile et rapide.

Résumé

Le présent rapport est le fruit de quatre mois de stage effectué au sein de la Direction

Qualité & Supervision de l’opérateur Méditel.

En effet Une entreprise moderne et de l’envergure d’un opérateur comme Meditel brasse

dans son système d’information d’immenses volumes de données et par suite il est souvent

très difficile de les assimiler, les exploiter et d’optimiser leur accès afin de prendre les

bonnes décisions là où il faut et quand il le faut.

Parmi les données très importantes pour la vie d’un opérateur figurent les données de suivi

des performances de son réseau. Ainsi, le thème de ce stage porte sur le développement et

mise en production d’une solution Business Intelligence (BI) pour l’intégration des données

de performances du backbone IP 3G de Méditel.

L’objectif principal de ce projet est de permettre aux utilisateurs d’avoir un reporting

assurant une bonne aide pour la prise de décision et une visibilité fiable et efficace sur les

performances du Backbone IP 3G.

Mon intervention a porté sur les différentes phases de réalisation d’un projet informatique

depuis la rédaction du cahier des charges jusqu’à la présentation de la recette finale tout en

respectant les normes de développement de Méditel mettant ainsi en pratique l’ensemble des

connaissances théoriques et pratiques apprises à la faculté des sciences et technique (FST)

de Fès.

Mots clé : BI, Java, Oracle 10 g, PL /SQL, BO XIR2, UML, 2TUP.

Liste des abréviations

Abréviation

Désignation

Description

DQS

Direction Qualité et Supervision

Direction d’accueil

2TUP

Two Track Unified Process

Processus de développement

BI

Business Intelligence

ensemble de solutions

informatiques permettant de

mettre en œuvre des moyens pour

collecter, consolider et restituer

des données afin d'offrir à une

entreprise une meilleure aide à la

décision.

BO XIR2

Business Objects XI R2

Outil d’aide à la décision

NNM

Network Node Management

Système de supervision des plates-

formes et du Backbone IP 3G

SNMP

Simple Network Management

Protocol

Protocol permet de collecter les

données du Backbone IP 3G

DW

Data warehouse

Le Data warehouse ou l’entrepôt

de données est une collection de

données orientées sujet, intégrées,

non volatiles et historisées,

organisées pour le support d’un

processus d’aide à la décision.

TB

Tableau de bord

Il s’agit d’une forme particulière

d’un rapport

OLAP

On Line Analytical Processing

Technologie permettant de faire

l’analyse multidimensionnelle

CMC

Central Management Consol

Module de Business Objects XI

R2, conçu pour déployer et

d’administrer BO au sein d’une

entreprise.

ETL

Extract Transform Load

Ensemble des programmes pour

extraire, transformer et charger les

données vers le DW.

Sommaire

Introduction ................................................................................................................................... 1

Chapitre 1 - Présentation du cadre du stage .............................................................. 3

I. Présentation de l’entreprise d’accueil ..................................................................................... 3

II. Concepts, outils et technologie utilisées ............................................................................... 7

1. Business Intelligence (BI) ................................................................................................ 7

2. Data warehouse (DW) ...................................................................................................... 7

3. Business Objects (BO) ..................................................................................................... 8

4. Oracle 10 g & Java .......................................................................................................... 10

Chapitre 2 – Conduite du projet & Spécifications ................................................ 16

I. Note de cadrage de projet ....................................................................................................... 16

II. Processus de développement ................................................................................................. 18

1. Importance des processus de développement ................................................................. 18

2. Définition du processus 2TUP ....................................................................................... 18

3. Diagrammes UML............................................................................................................ 20

III. Spécification ..................................................................................................................... 161

1. Etude de l’existant ........................................................................................................ 161

2. Spécification des besoins ............................................................................................ 163

Chapitre 3 – Concepton & développement de la solution ............................................ 26

I. Processus d’intégration ......................................................................................................... 26

II. ETL du traitement et du chargement des données ............................................................. 27

1. Traitement de données ..................................................................................................... 27

2. Chargement des données ................................................................................................. 27

III. Conception et création de la base de données multidimentionnelle ................................. 29

1. Gestion et création des tables externes .......................................................................... 29

2. Création des tables intermédiaires .................................................................................. 30

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

34

34

35

35

36

36

37

37

38

38

39

39

40

40

41

41

42

42

43

43

44

44

45

45

46

46

47

47

48

48

49

49

50

50

51

51

52

52

53

53

54

54

55

55

56

56

57

57

58

58

59

59

60

60

61

61

62

62

63

63

64

64

65

65

66

66

67

67

1

/

67

100%