lien vers le compte rendu du TP 2

Réalisé par : Encadré par :

MAADOUR Soufiane Pr. MAJDA Aicha

ZYATE Mahmoud

KAMRANI Abdelhalim

HAMOUT Hamza

BOUTAYEB Aymane

Date début du projet : 18/02/2015 Date Fin du projet : 05/05/2015

Lien du Blog : www.gsirx.wordpress.com

2014 – 2015

Université Sidi Mohamed Ben Abdellah

Faculté Des Sciences et Techniques

Fès

Objectifs

Détailler le fonctionnement de l’application du TP N°2 des réseaux de neurones – Perceptron multicouche.

Compte Rendu du TP N°2

Réseau de neurones

GROUPE SIRX MSIR 2014

2

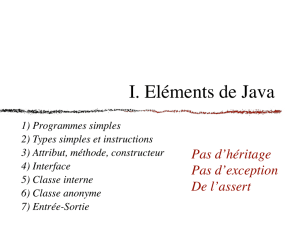

Sommaire

SOMMAIRE ......................................................................................................................................................... 2

INTRODUCTION .................................................................................................................................................. 3

PARTIE 1 ............................................................................................................................................................. 4

Application du calcul effectué dans un PCM ...................................................................................................... 4

QUESTION 1 : ............................................................................................................................................................ 4

QUESTION 2 : ............................................................................................................................................................ 6

PARTIE 2 ............................................................................................................................................................. 7

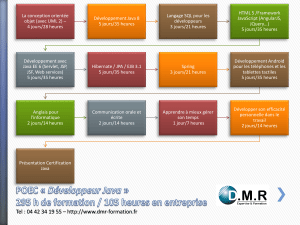

Implémentation de perceptron multicouche ..................................................................................................... 7

VUE GENERALE DE LA CONCEPTION ................................................................................................................................. 7

DESCRIPTION DES CLASSES UTILISEES ............................................................................................................................... 8

L’interface graphique ......................................................................................................................................... 8

Main.java ......................................................................................................................................................................... 8

GraphPanel.java ............................................................................................................................................................ 10

NetworkGraph.java ....................................................................................................................................................... 12

Structure de donnée ........................................................................................................................................ 12

Character.java................................................................................................................................................................ 12

Data.txt .......................................................................................................................................................................... 12

DataHandler.java ........................................................................................................................................................... 12

Implémentation de l’algorithme de rétropropagation .................................................................................... 12

BackPropagation.java .................................................................................................................................................... 12

Apprentissage ........................................................................................................................................................... 13

Test de classification ................................................................................................................................................. 15

GROUPE SIRX MSIR 2014

3

Introduction

Un réseau de neurones artificiels est un modèle de calcul dont la conception est très schémati-

quement inspirée du fonctionnement des neurones biologiques, ils sont généralement utilisés

dans des méthodes d'apprentissages afin de prendre des décisions.

Notre objectif et d'arriver à concevoir un programme capable d’identifier des objets, plus exacte-

ment des lettres latins. On a utilisé dans un premier temps les réseaux bayésiens qui sont déjà

expliqué et détaillé dans le premier projet, alors que dans ce projet nous allons opter pour les

réseaux de neurones, plus exactement le perceptron multi couche et son algorithme de rétropro-

pagation.

Ce document est divisé en deux partie, dans la première on montre le calcule effectuer dans une

seule itération de l’algorithme de rétropropagation. Ensuite nous allons implémenter l’algorithme

et l’utiliser dans une application pour classifier les lettres.

GROUPE SIRX MSIR 2014

4

Partie 1

Application du calcul effectué dans un PCM

On considère le PCM suivant

Avec :

xi : Les entrées du réseau.

hj : Les sorties de la couche cachée.

y : La sortie du réseau.

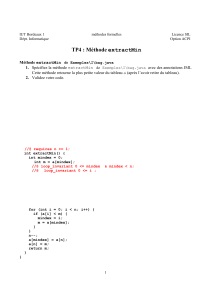

Question 1 :

Fonction XOR-logique

En utilisant l’algorithme de la rétro-propagation pour l’apprentissage de la fonction logique XOR, on calcule

les nouveaux poids synaptiques wij pour une seule itération.

On prend comme exemple d’apprentissage le vecteur (x1=0, x2=1).

Les données de notre réseau sont :

La fonction de transfert sigmoïde:

f(x)=1/ (1+e(-x))

Le taux d’apprentissage

α = 0.7

GROUPE SIRX MSIR 2014

5

Les biais

b1 = 0.4 b2 =0.6 b3 = -0.3

Les poids

W11 = 0.7 W21 = -0.4 W12 = -0.2

W22 = 0.3 W1 = 0.5 W2= 0.1

L’apprentissage de notre fonction comporte 3 phases :

La propagation en avant

-Cette étape consiste à calculer les valeurs des neurones de la couche cachée et ceux de la couche de sortie

par la fonction sigmoïde calculée pour la somme pondéré de chaque neurone.

Somme pondérée du neurone i : Si = Σ Wj Xj + bi avec Wj les poids synaptiques entrants au neurone

Fonction sigmoïde : f(x)=1/ (1+e(-x)) pour tout réel x

Neurones

H1 (couche cachée)

H2 (couche cachée)

Y (couche de sortie)

Valeurs des neurones

0.55

0.71

0.51

Le calcul de l’erreur

La formule utilisée pour calculer l’erreur est :

Neurones

H1 (couche cachée)

H2 (couche cachée)

Y (couche de sortie)

Erreur des neurones

0.12

0.015

0.025

La rétro-propagation de l’erreur

On doit maintenant ajuster les poids en rétro-propageant l’erreur observée par le biais de la relation sui-

vante :

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

1

/

15

100%