La dictature du modèle

249

en est de même pour l’estimation du taux d’expansion de l’Univers. Alors

que nous ne savons pas ce qui est réellement en expansion dans l’Univers,

par rapport aux structures qui ne la subissent pas, alors que nous ne savons

pas si cette expansion est isotrope, les cosmologistes ont le toupet de pré-

tendre pouvoir la donner au dixième près. Cela n’a pas plus de sens que

de donner le rayon d’une pomme de terre à la précision du millimètre. La

faute dans l’utilisation du modèle homogène et isotrope consiste à vouloir

tirer du modèle des informations qu’il ne contient pas. La pomme de terre

n’est pas une sphère parfaite ; l’Univers n’est pas homogène et isotrope.

La dictature du modèle

Nous touchons là au cœur du mal qui mine l’astrophysique moderne.

Comme le sculpteur légendaire Pygmalion était tombé amoureux de

Galatée, la statue qu’il avait ciselée, priant la déesse Aphrodite de lui

donner vie, les astrophysiciens en sont venus à idolâtrer leurs modèles

numériques et à les prendre pour la réalité. Le mot « idolâtrie » est formé

de « idole », du grec eidôlon (« image »), et du sufxe « – lâtrie », de

latreuein (« servir, adorer »). Idolâtrer le modèle est lui vouer un véri-

table culte en oubliant la réalité. La maladie est grave. Elle se traduit par

une quasi-sacralisation de schémas numériques pourtant incapables de

décrire la complexité des objets réels et auxquels les chercheurs ajoutent

arbitrairement le nombre voulu de paramètres pour tenter néanmoins de

faire coller les prévisions théoriques aux observations (et, comme ils y

parviennent, leur numéro d’illusionniste est réussi et ils arrivent à trom-

per les esprits). Les astrophysiciens n’étudient plus les étoiles, ils étu-

dient des modèles d’étoiles. Lorsque dans un séminaire le conférencier

vous parle de l’évolution d’une étoile de 5 masses solaires, il faut enten-

dre l’évolution d’un modèle d’étoile dont la masse est de 5 fois la masse

solaire. Il ne s’agit pas de l’évolution d’étoiles réelles. C’est l’occasion

de rappeler gentiment aux théoriciens de l’espace-temps mathématique

que jusqu’à nouvel ordre le monde connaissable est fait d’étoiles et que

par conséquent toute la cosmologie (y compris les divagations sur la

matière noire) repose sur la connaissance des étoiles : c’est pourquoi je

m’attache à leur étude dans ce qui suit.

250

Un modèle d’étoile est déterminé par les trois paramètres fonda-

mentaux que sont la masse, la température et le rayon, auxquels on doit

adjoindre des paramètres supplémentaires comme la vitesse de turbu-

lence, la vitesse de rotation de l’objet, la composition chimique (notam-

ment l’abondance en éléments plus lourds que l’hydrogène et l’hélium,

désignés brièvement en astronomie sous le nom de métaux), etc.

L’importance de ces autres paramètres est d’ailleurs déterminante pour

la structure de l’étoile. Pour l’astrophysique, analyser une étoile revient

à déterminer ses paramètres fondamentaux. Un article parmi des milliers

d’autres semblables s’intitulera par exemple : « Détermination précise

des paramètres fondamentaux de vingt-trois étoiles brillantes de type

solaire ». Mais il y a un souci : s’ils ont un sens bien déni dans le cadre

du modèle, ces paramètres fondamentaux perdent leur signication dans

la réalité des choses.

Le premier point litigieux concerne la notion de rayon et donc de sur-

face : une vraie étoile n’a pas de vraie surface. Une étoile ne s’arrête pas

brusquement sur l’espace interstellaire. La zone de transition entre les

deux milieux en contact, l’étoile et le milieu interstellaire, plus ou moins

étendue selon les cas, est toujours d’une complexité désespérante pour

l’astrophysicien (la nature, elle, maîtrise magistralement la question). En

effet, une étoile réelle est un objet ouvert sur l’extérieur, non un sys-

tème clos et isolé comme l’aime la physique. Ainsi que l’attestent sans

ambiguïté les observations, elle entretient avec son environnement des

échanges dynamiques accompagnés de mouvements de matière à toutes

les échelles (turbulence, pulsations, perte de masse, éruptions, etc.). Le

caractère non statique d’une atmosphère stellaire résulte en partie de ce

que la gravité dans les régions externes est insufsante pour retenir ef-

cacement la matière. L’effet est particulièrement marqué pour les étoiles

de grande taille, géantes ou supergéantes, dont les couches extérieures

ne ressentent qu’une faible gravité par suite de leur grande distance au

centre, une situation favorisant la fuite des particules.

L’état dynamique des étoiles n’est d’ailleurs pas réservé à leur surface.

Les mouvements de matière sont également présents à l’intérieur, de

251

nouveau à toutes les échelles. Aléatoires, ils constituent la turbulence ;

plus organisés, ils manifestent l’existence de courants de matière. Or

aucun modèle ne sait inclure ces mouvements de façon correcte, même

approchée. Pour les simuler dans l’apparence des spectres (car au nal

on compare un spectre observé à un spectre calculé), on se contente d’in-

troduire deux paramètres : la vitesse de microturbulence et la vitesse

de macroturbulence. La microturbulence est censée représenter les mou-

vements aléatoires à toute petite échelle (ce qui revient grosso modo

à augmenter la température du gaz, mais pas tout à fait). La macro-

turbulence vise à reproduire les mouvements d’ensemble à grande échelle.

L’ajustement empirique des calculs à la forme des raies spectrales obser-

vées fournit la valeur de ces paramètres de turbulence. Je ne rejette pas

catégoriquement cette façon de faire : après tout, elle peut donner une

certaine idée de l’importance des mouvements de matière. Mais l’erreur

est de prendre ces paramètres pour argent comptant, comme s’ils avaient

une signication physique réelle, et de chercher à les déterminer avec

exactitude, comme si l’accroissement fallacieux de précision était gage

d’amélioration qualitative. L’illusion est de penser que grâce à l’utili-

sation des paramètres de microturbulence et de macroturbulence on a

traité, comme adorent le dire les astrophysiciens, les champs de vitesse.

Maltraité serait plus juste.

Autre exemple éloquent de l’inadéquation des modèles : la variation

réelle de la température du plasma stellaire en fonction de la distance au

centre de l’étoile n’est pas conforme à la prévision théorique. Tandis que

les modèles prédisent que la température décroît du centre vers l’exté-

rieur, la nature agit autrement. Dans le Soleil, elle diminue bien, comme

l’annonce la théorie, depuis les quelque 15 millions de degrés du centre

jusqu’aux quelque 5 000 degrés de sa surface visible, nommée photo-

sphère, mais se met à croître au-delà pour atteindre les dizaines de milliers

de degrés de la chromosphère et les millions de degrés de la couronne,

cette couche extérieure dont la magnicence nous éblouit lors des éclipses

totales de Soleil. Or – cela pourra légitimement en étonner certains –

aucun modèle d’étoile ne prévoit l’existence de chromosphères et de

couronnes. Selon les besoins, on les accolera aux modèles d’étoiles en

252

les paramétrant de façon ad hoc, mais sans y inclure la physique conve-

nable, pour la bonne raison que nous sommes incapables de comprendre

vraiment de quoi il s’agit. Paradoxalement, la précision extraordinaire

de la vision du Soleil que les instruments modernes nous offrent est d’un

certain côté plutôt un handicap qu’une aide car on a accès à tellement de

détails que toute modélisation semble miséreuse. Sur la structure de la

chromosphère et de la couronne, s’il est bien une chose que les observa-

tions nous apprennent du Soleil (et par extension des étoiles), c’est l’im-

portance du champ magnétique. Les taches solaires et les protubérances

sont des manifestations directes de l’activité magnétique du Soleil. Les

jets de matière sont provoqués et canalisés par le champ magnétique. Or

aucun modèle d’étoile ne sait inclure ce champ magnétique, l’une des

bêtes noires les plus redoutées des astrophysiciens. La discipline de la

magnétohydrodynamique (MHD en jargon astrophysique) est consacrée

à l’étude du comportement d’un plasma en présence d’un champ magné-

tique, mais elle n’a pas atteint ce niveau de résultats capable de conduire

à une modélisation (ce qui d’ailleurs n’est pas forcément possible ou

même souhaitable).

Avec la remontée de température dans la chromosphère et les mani-

festations faramineuses de l’énergie magnétique, nous retrouvons le fait

que la surface d’une vraie étoile est le siège d’une physique complexe

et violente. C’est l’endroit où se déchaînent à plein régime les effets

hors équilibre. Bon nombre d’astres subissent des pulsations, la plupart

voient leur éclat varier, tous perdent une partie plus ou moins impor-

tante de leur masse en éjectant leur matière dans le milieu environnant.

Comme les modèles sont fondés sur des hypothèses d’équilibre, aucun

d’entre eux n’est capable d’expliquer ces phénomènes et on a recours

à la paramétrisation pour en reproduire vaguement quelques caractéris-

tiques observées, mais sans introduire de théorie physique sérieuse. Parmi

les approximations faites, les représentations de perte de masse sup-

posent que l’éjection de matière possède une symétrie sphérique autour

de l’étoile alors que les observations prouvent que ce n’est pas le cas.

Il faut noter à ce propos que cette même symétrie sphérique est égale-

ment l’hypothèse sur laquelle se fondent les modèles pour l’ensemble de

253

l’étoile. Elle postule que l’astre est formé d’une série de couches sphé-

riques superposées, chacune étant supposée homogène dans sa consti-

tution. Or les astronomes savent pertinemment que les vraies étoiles ne

possèdent pas cette symétrie sphérique. Déjà elles tournent toutes sur

elles-mêmes, de sorte que les propriétés de la matière à l’équateur ne

sont pas les mêmes qu’aux pôles. Ensuite les mouvements de matière

n’épargnent aucun point et contribuent à développer les dissymétries.

L’hypothèse de la symétrie sphérique est certes commode, mais elle est

impropre à représenter la réalité. Plus on découvre les étoiles, plus on

s’aperçoit qu’elles se distinguent des modèles. Ainsi la brillante étoile

Véga, l’un des sommets du fameux triangle d’été, a longtemps été consi-

dérée comme une étoile de référence permettant de calibrer les luminosi-

tés stellaires. Or les astronomes se sont aperçus vers les années 2005 que

l’astre tournait très rapidement sur lui-même, avec un renement équa-

torial prononcé. Cette circonstance inrme l’hypothèse de la symétrie

sphérique et rend difcile la détermination de sa luminosité totale vraie

(comme nous allons l’expliquer maintenant), invalidant du même coup le

choix de Véga comme étoile standard.

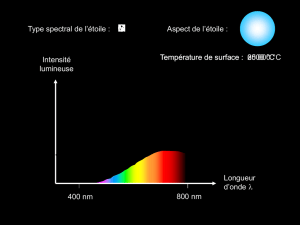

La température des étoiles

Si le rayon d’une étoile, paramètre fondamental du modèle, devient dans

la réalité une notion oue, le concept de température présente aussi de

sérieuses difcultés à se transposer au réel. Le spectre d’une étoile n’a

pas la forme de celui d’un corps noir, sinon la question serait vite réso-

lue : à tel corps noir correspondrait telle température. De façon profonde,

la notion de température suppose que le système à qui on l’applique soit

à l’équilibre ; or une étoile n’est pas à l’équilibre. Nous avons vu que

peu après le Big Bang, avant l’époque du découplage, le rayonnement

cosmique était à l’équilibre avec les particules matérielles du plasma

remplissant l’Univers, de sorte que la répartition des photons de lumière

suivait la loi d’un corps noir (celui même qui est devenu de nos jours,

par suite de l’étirement de l’espace, le fameux corps noir cosmologique

à 3 degrés Kelvin découvert par Penzias et Wilson). Pourquoi cet équi-

libre prévalait-il à l’époque ? Parce que, dans ces tout premiers instants

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

1

/

14

100%