Rapport du TP1 Problème Inverse Algorithme de Viterbi

−→

X= (X1, X2, ..., XT)

XtS= (s1, s2, ..., sN)

Xt−1

P(Xt=sk|X1, X2, X3, . . . , Xt−1) = P(Xt=st|Xt−1)

=P(X2=st|X1),

skP

Xtt

−→

X Yt

Xt

−→

X

−→

X= (X1, X2, ..., Xn)−→

Y= (Y1, Y2, ..., Yn)

−→

X−→

Y

b

X=ArgMax

−→

X

P(−→

X|−→

Y).

b

X

T= 100 N= 3 2100

P(−→

X|−→

Y) = P(−→

X , −→

Y)

P(−→

Y),

P(−→

Y)−→

X

b

X=ArgMax

−→

XhP(−→

Y|−→

X)P(−→

X)i

| {z }

PY(

−→

X)

−→

Y

−→

X

P(−→

Y|−→

X) =

n

Y

t=1

P(Yt=yt|Xt=xt),

PY(−→

X) = (

n

Y

t=1

P(yt|xt))(

n

Y

t=2

P(xt|xt−1))P(x1),

PY(−→

X) = P(y1|x1)(P(x1)(

n

Y

t=2

(P(yt|xtP(xt|xt−1),

PY(−→

X) =

x1

x1, x2

qx2, x3

qx3, x4

...

xn−1, xn

PY(−→

X) = f1(x1)f2(x1, x2)f3(x2, x3)f4(x3, x4)...fn(xn−1, xn).

log PY(−→

X)

b

X

L(−→

X) = log PY(−→

X)

= log(P(y1|x1)(P(x1)) +

n

X

t=2

log(P(yt|xtP(xt|xt−1).

L(−→

X) = L1(x1) +

n

X

t=2

Lt(xt, xt−1).

L(−→

X

b

X=Arg Max

−→

X=(x1,x2,x3)

L(x1, x2, x3)

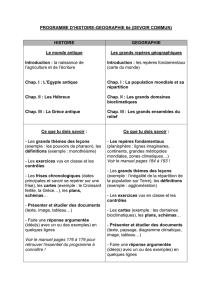

6

6

7

7

1

/

7

100%