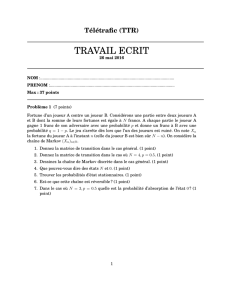

Chaînes de Markov

Chapitre 2

Chaînes de Markov

Résumé. Une chaîne de Markov est un processus aléatoire (Xn)n2Ndont

les transitions sont données par une matrice stochastique P(Xn,X

n+1).

Ces processus vérifient la propriété de Markov, c’est-à-dire qu’observés

àpartird’untemps(d’arrêt)T,(XT+n)n2Nne dépend que de XTet est

de nouveau une chaîne de Markov. Les états d’une chaîne de Markov

peuvent être classés en deux catégories : les états transitoires,quine

sont visités qu’un nombre fini de fois p.s., et les états récurrents,quiune

fois atteints sont visités p.s. une infinité de fois, ainsi que tous les autres

états dans la même classe de récurrence. Pour une chaîne de Markov

irréductible récurrente, la mesure empirique et la loi marginale du pro-

cessus convergent soit vers l’unique mesure de probabilité P-invariante

(récurrence positive), soit vers le vecteur nul (récurrence nulle). Cette

théorie s’applique en particulier aux marches aléatoires et aux modèles

de files d’attente.

Dans ce qui suit, on fixe un espace d’états Xfini ou dénombrable, muni de la tribu de

l’ensemble des parties P(X).SiXest fini, on notera Nson nombre d’éléments.

1. Matrices stochastiques et propriété de Markov

1.1. Chaînes de Markov. Une matrice stochastique sur Xest une fonction P:

(x, y)2X7! P(x, y)2[0,1] telle que, pour tout x2X,

X

y2X

P(x, y)=1.

Autrement dit, tout x2Xdéfinit une mesure de probabilité P(x, ·)sur X,appelée

probabilité de transition àpartirdex.

Définition 2.1 (Chaîne de Markov).Une chaîne de Markov sur Xde matrice de

transition Pest une suite de variables aléatoires (Xn)n2Ndéfinies sur un espace (⌦,B,P)

et à valeurs dans X,tellequepourtoutn,ettouspointsx0,...,x

n+1,

P[Xn+1 =xn+1|X0=x0,...,X

n=xn]=P(xn,x

n+1).(??)

Ainsi, la loi conditionnelle PXn+1|(X0,...,Xn)est la probabilité de transition P(Xn,·).Il

est utile de représenter les mesures de probabilité ⇡sur Xpar des vecteurs en ligne

(⇡(x1),⇡(x2),...,⇡(xk),...).Alors,si⇡0est la loi de X0,quipeutêtrearbitraire,ona

P[(X0,X

1,...,X

n)=(x0,x

1,...,x

n)] = ⇡(x0)P(x0,x

1)···P(xn1,x

n)

7

8 2. CHAÎNES DE MARKOV

par conditionnement successif, de sorte qu’en particulier la loi ⇡nde Xnest donnée par

le produit matriciel ⇡n=⇡0Pn.D’un point de vue dual, si fest une fonction bornée sur

X,vuecommeunvecteurcolonne,alors

E[f(Xn+1)|X0=x0,...,X

n=xn]=(Pf)(xn);

E[f(Xn)] = ⇡nf=⇡0Pnf.

Notons que les produits matriciels considérés sont licites même lorsque l’espace d’états

est infini dénombrable, puisqu’on a des bonnes bornes sur les sommes de coefficients sur

chaque ligne de la matrice de transition.

Exemple. On représente usuellement une chaîne de Markov d’espace d’états Xpar

un graphe orienté étiqueté G=(V,E)dont les sommets sont les éléments de X,etdont

les arêtes étiquetées sont les couples (x, y)avec P(x, y)>0,lavaleurdelaprobabilité

de transition étant l’étiquette de l’arête x!y. Considérons par exemple la chaîne de

Markov d’espace d’états [[ 1 ,N]] ,etdematricedetransition

P=1

3

0

B

B

B

B

B

B

@

11 1

11...

.........

...11

111

1

C

C

C

C

C

C

A

;

1

31

3

1

3

9

Le graphe associé est dessiné ci-dessus, et la chaîne considérée est la marche aléatoire

sur le cercle Z/N Zoù, à chaque étape, on a probabilité 1/3de rester au même endroit, et

probabilité 1/3de sauter à gauche ou à droite. Les lois marginales de cette chaîne peuvent

être calculées comme suit. Pour tout vecteur v2(C)Z/N Z,notons

ˆv(k)= 1

pN

N

X

j=1

v(j)⇣jk

sa transformée de Fourier discrète, avec ⇣=e

2i⇡/N .D’autrepart,notonsCNla matrice

circulante

CN=0

B

B

B

@

01

0...

...1

10

1

C

C

C

A;P=I+CN+(CN)1

3.

Pour tout vecteur v,\

(vC

N)(k)=⇣kˆv(k),c’est-à-direquelaconjuguéedeCNpar la

transformée de Fourier discrète agit diagonalement, avec valeurs propres ⇣,⇣2,...,⇣N.Il

s’ensuit que si Dest la matrice diagonale

D= diag 1+2cos2⇡

N

3,1+2cos4⇡

N

3,...,1+2cos2N⇡

N

3!,

1. MATRICES STOCHASTIQUES ET PROPRIÉTÉ DE MARKOV 9

alors pour toute mesure initiale ⇡0,ona

⇡n=⇡0Pn=^

b⇡0Dn,

où e·indique la transformée de Fourier inverse :

ev(l)= 1

pN

N

X

k=1

v(k)⇣kl.

En particulier, comme Dnconverge vers la matrice diagonale diag(0,...,0,1),onvoitque

pour toute mesure initiale ⇡0,laloimarginale⇡nconverge vers le vecteur (1

N,..., 1

N).

C’est un cas particulier des théorèmes ergodiques qui seront évoqués au paragraphe 3.

On peut montrer que pour toute mesure initiale ⇡0sur X,ettoutematricedetransition

P, il existe effectivement une chaîne de Markov avec cette mesure initiale et cette matrice

de transition. On notera P⇡0et E⇡0les probabilités et espérances relatives à cette chaîne

de Markov, et dans le cas particulier où ⇡0=xest concentrée en un seul point x2X,

on notera Pxet Ex. Ces probabilités portent sur l’espace des trajectoires

(XN,P(X)⌦N)

muni de la tribu produit, et sur cet espace, on a unicité en lois trajectorielles d’une chaîne

de Markov de loi initiale et matrice de transition données : la loi P⇡0est entièrement dé-

terminée par l’équation (??). Cette propriété (??)assurequelestransitionsd’unechaîne

de Markov au temps nsont homogènes en temps (Pne dépend pas de n), et ne dépendent

que de l’état présent, c’est-à-dire que la loi conditionnelle de Xn+1 sachant toute la tra-

jectoire (X0,...,X

n)ne dépend en fait que de Xn.Unereformulationdecesobservations

est donnée par la propriété de Markov :

Proposition 2.2.Si (Xn)n2Nest une chaîne de Markov de loi P⇡0,alorspourtout

temps m0,lachaînedécaléeentemps(Xm+n)n2Nest aussi une chaîne de Markov,

de loi P⇡m.Deplus,lachaînedécaléeestconditionnellementàXmindépendante de

(X0,...,X

m1).

En effet, on peut calculer les lois trajectorielles de la chaîne de Markov décalée :

P[Xm=y0,X

m+1 =y1,...,X

m+n=yn]

=X

x0,x1,...,xm1

P[X0=x0,...,X

m1=xm1,X

m=y0,...,X

m+n=yn]

=X

x0,x1,...,xm1

⇡0(x0)P(x0,x

1)···P(xm1,y

0)P(y0,y

1)···P(yn1,y

n)

=(⇡0Pm)(y0)P(y0,y

1)···P(yn1,y

n)

=⇡m(y0)P(y0,y

1)···P(yn1,y

n),

et ce sont bien celles d’une chaîne de matrice Pet de mesure initiale ⇡m.

10 2. CHAÎNES DE MARKOV

1.2. Temps d’arrêt et propriété de Markov forte. Une généralisation de ce

principe à des temps aléatoires met en jeu la notion de temps d’arrêt, elle même dépendant

de la notion de filtration d’espace. Soit (⌦,B,P)un espace de probabilité ; une filtration

de cet espace est une suite croissante de sous-tribus

F0⇢F

1⇢F

2⇢···⇢B.

Tout processus aléatoire (Xn)n2Ndéfinit une filtration (Fn)n2Nen posant

Fn=(X0,X

1,...,X

n);

en particulier, une chaîne de Markov définit automatiquement une filtration. Il faut

comprendre Fncomme l’ensemble des événements qu’on peut mesurer entre les temps

0et n(à partir des observations de la chaîne de Markov X0,X

1,...,X

n). Dans ce

contexte, un temps d’arrêt (relativement à une filtration (Fn)n2N)estunevariablealéa-

toire T:(⌦,B,P)!Nt{+1}telle que pour tout n,l’événement{T=n}est dans

Fn. En d’autres termes, lorsque la filtration est celle associée à une chaîne de Markov,

un temps d’arrêt Test un temps aléatoire tel qu’on puisse décider de {T=n}(ou de

{Tn})àpartirdesseulesobservationsdeX0,...,X

n.Parexemple,siAest une partie

de X,alorsletempsd’atteinte

TA=inf{n2N,X

n2A}

est un temps d’arrêt ; par contre, le temps de dernier passage

QA=sup{n2N,X

n2A}

n’en est pas un.

On peut associer une sous-tribu FT={A2B|8n2N,A\{T=n}2F

n}àtout

temps d’arrêt T;c’estlatribudesévénementsobservablesjusqu’autempsT.Onnote

alors ⇡Tla loi de XT. Cette définition est ambiguë lorsque {T=+1}aprobabiliténon

nulle : on convient alors que XTn’est définie que sur l’événement FT-mesurable {T<1}.

Théorème 2.3 (Propriété de Markov).Soit (Xn)n2Nune chaîne de Markov de matrice

de transition P,etTun temps d’arrêt pour sa filtration canonique. Pour toute fonction

mesurable bornée fsur l’espace des trajectoires,

E⇡0[T<1f((XT+n)n2N)|FT]= T<1EXT[f((Xn)n2N)],

les deux membres de l’identité étant FT-mesurables. En particulier, si {T<+1}a

probabilité 1,alorslaloiconditionnellede(XT+n)n2Nsachant FTest PXT.

En particulier, si XT=xest presque sûrement une constante, et si l’événement {T<+1}

aprobabilité1,alors(XT+n)n2NaloiPxet est indépendante de FT. Plus généralement,

si {T<+1}aprobabiliténonnulleetsiXT=xp.s., alors conditionnellement à cet

événement, (XT+n)n2NaloiPxet est indépendante de FT.Lapreuvedecettepropriété

de Markov avec des temps d’arrêt découle immédiatement du cas classique T=m,en

décomposant les probabilités trajectorielles en fonction de la valeur du temps d’arrêt T.

1. MATRICES STOCHASTIQUES ET PROPRIÉTÉ DE MARKOV 11

Exemple. Étant donné un réel p2(0,1),onnoteq=1p. Considérons alors la

marche aléatoire sur X=Zissue de x0=0,etavecprobabilitésdetransition

P(i, j)=8

>

<

>

:

psi j=i+1;

qsi j=i1;

0sinon.

Z

ppp

qqq

14

Soit T1=inf{n2N,X

n=1}le temps d’atteinte de 1par la marche aléatoire ; c’est un

temps d’arrêt. On peut déterminer complètement la loi de T1. En effet, la marche issue

de 0occupe des états pairs aux temps pairs et des états impairs aux temps impairs, donc

T1est soit un nombre impair, soit +1.SupposonsT1=2n+1;alorslamarchejusqu’au

temps 2nest une excursion négative de taille 2n:

T1

15

Le nombre d’excursions de taille 2nest le nombre de Catalan

Cn=1

n+1✓2n

n◆=(2n)!

(n+1)!n!,

et chaque excursion a probabilité (pq)nsous la loi P0:ilyantransitions vers le bas

avec probabilité q,etntransitions vers le haut avec probabilité p.Ladernièretransition

P(0,1) ayant probabilité p,onobtientdonc:

P0[T1=2n+1]=pn+1 qn2n!

(n+1)!n!.

En particulier, la probabilité pour que T1soit fini est

P0[T1<1]=p1

X

n=0

Cn(pq)n=2p

1+|2p1|=(1si p1

2;

p

1psi p<1

2

puisque P1

n=0 Cnxn=2

1+p14x.Supposonsp1

2.Alors,lamarchealéatoire(XT1+n)n2N

est définie de façon non ambiguë, et elle suit la loi P1par la propriété de Markov ; de plus,

elle est indépendante de l’excursion (X0,...,X

T1).

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

1

/

26

100%