Séance 2

{Xi|i∈N0}Xiiid

p

{Nn|n∈N0}Nn

n

{Tn|n∈N0}Tn

n

Y1, Y2,· · · iid

P(Yn=k) = pk∀k∈N.

Xn

Xn=0n= 0,

Y1+Y2+· · · +Ynn≥1.

{Xn|n∈N}

{Xn|n∈N}E

P i ∈E τii X0=i τi

i

τi

N

N

{Xn|n∈N}Xn

n X0= 0

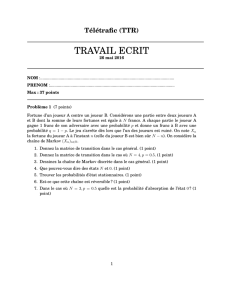

A B A

B

B

A B

XnA n

{Xn|n∈N}

p q p +q= 1

. . .

1p

q

p

q

p

q

p

q

p

q

p

q

i0

i

{Xn|n∈N}

P=

01

302

3

0 1 0 0

01

4

1

2

1

4

0 0 0 1

.

F R

{Xn|n∈N}

P=

0.4 0.3 0.300000

0 0.6 0.400000

0.5 0.5000000

00001000

0 0 0 0.8 0.2 0 0 0

000000.4 0.6 0

0.4 0.4000000.2

0.1 0.3 0 0 0 0.6 0 0

.

F R

P=

0.2 0.3 0.4 0.10000

0.1 0.400.50000

0 0.3 0.4 0.30000

00100000

0 0.500.3 0.1 0.1 0 0

0 0.2 0 0 0.1 0.1 0.3 0.3

00000001

00000010

.

{Xn|n∈N}

2

5

3

5

2

5

3

5

2

5

3

5

2

5

2

5

1

51

3

1

3

1

3

2

3

1

3

1

31

3

1

3

1

2

3

1

31

3

1

3

1

3

1

j i

(i, j)

p

0 0 j

j

T0E[T]

p q p +q= 1 N

. . .

qp p

q

p

q

p

q

p

q

p

q

p

q

limn→∞ Pn

ij ∀i, j ∈ {1,2,· · · , N}

{Xn|n∈N}P

k Q k k

P{Xn}

Qx=x

0≤xi≤1∀i

p q p +q= 1

. . .

1p

q

p

q

p

q

p

qq

6

6

7

7

8

8

1

/

8

100%