La physique du 21° siècle sera-t-elle ondulatoire?

L

LE

ES

S

R

RA

AD

DI

IO

OT

TE

EL

LE

ES

SC

CO

OP

PE

ES

S

D

DU

U

F

FU

UT

TU

UR

R

:

:

T

TE

EC

CH

HN

NO

OL

LO

OG

GI

IE

ES

S

E

ET

T

A

AV

VA

AN

NC

CE

EE

ES

S

S

SC

CI

IE

EN

NT

TI

IF

FI

IQ

QU

UE

ES

S

Titre

(français)

:

La physique du 21° siècle sera-t-elle ondulatoire?

Title

(English) : Will the 21° century physics be a wave’s physics?

Auteur :

Pierre Fuerxer

Ancien adjoint militaire au directeur de CENT.

Mots clés : Physique ondulatoire, fertilisation croisé;

Wave’s physics, cross fertilisation

Résumé

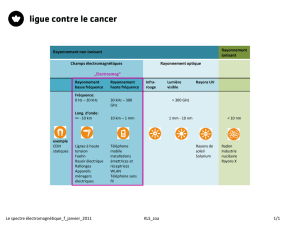

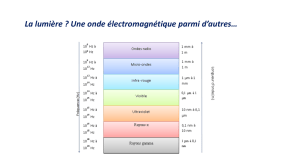

Les progrès de la physique ont été très importants au 19° siècle. Des avancées décisives en optique ont été

réalisées grâce à la découverte de la nature ondulatoire de la lumière.

Le début du 20° siècle est marqué par une mutation profonde due au développement des théories de la

relativité, mais aussi de la théorie des quanta.

Le 21° siècle devrait redonner aux ondes la place qui leur revient, le point de vue ondulatoire permettant une

approche concrète de nombreux phénomènes.

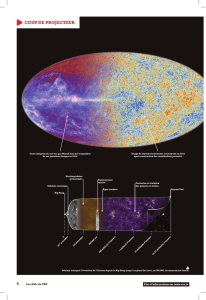

A un coût raisonnable, les radiotélescopes du futur, en améliorant leur résolution et en étendant le spectre

d’observation de l’espace à notre disposition, vont apporter à la physique des éléments essentiels au progrès de la

connaissance.

Ces résultats ne seront pleinement exploités que si nous savons décrire les phénomènes eux-mêmes, dans un

langage simple, et en entrant le moins possible dans les débats théoriques.

La fertilisation croisé des différents domaines de la science en sera grandement améliorée, et les étudiants de

nouveau attirés par les disciplines scientifiques.

L’ensemble du propos est illustré par un retour sur les articles fondateurs de la physique moderne et leur

comparaison avec des articles récents (par exemple modèle de Planck- modèle de calcul du bruit radioélectrique

proposé pour les systèmes ULB).

Introduction :

L’histoire n’est pas seulement un retour sur le passé. En mettant au jour les raisons qui ont été à l’origine des

événements anciens et qui expliquent leur l’enchaînement, elle permet de comprendre le présent et de pressentir les

grandes lignes du futur.

Nous allons donc faire un rapide retour sur l’évolution de la physique au cours des deux derniers siècles. Nous

considèrerons ensuite plus en détail, et avec le regard d’un radioélectricien moderne, les avancées faites au 20° siècle,

en nous appuyant sur les textes originaux, comme l’exige une démarche historique authentique.

1 - La physique du 19° siècle :

Les avancées scientifique faite au 19° siècle ont été nombreuses et importantes. Les progrès de l’optique et la

découverte de la nature ondulatoire de la lumière ont préparé, avant même la découverte expérimentale des ondes

radioélectriques, les bases théoriques qui ont permis, plus tard, le développement des radiocommunications et du

RADAR.

Il n’est pas nécessaire de rappeler les travaux de Fresnel dès 1818, de Fizeau puis de Maxwell qui établit dès

1854 les équations des ondes électromagnétiques.

Il était donc raisonnable de penser que la théorie corpusculaire de la lumière qui avait été adoptée de l’antiquité

à Newton avait définitivement été abandonnée au profit de la théorie ondulatoire. Tel n’a pas été le cas.

JS'11, Cnam Paris, 29-30 mars 2011

281

2 - La physique du 20° siècle :

Le vingtième siècle commence avec un incroyable foisonnement de théories souvent incompatibles entre elles

et avec les principes connus de la physique. Progressivement, ces théories ont été ajustées de façon à constituer un

ensemble pratiquement cohérent, les difficultés résiduelles étant passées sous silence. Pour s’en convaincre, il suffit de

lire ou relire les articles originaux dans lesquels ces théories ont été proposées pour la première fois.

Les grandes théories :

Sans vouloir être exhaustifs, nous allons considérer les plus emblématiques de siècle.

La théorie de la relativité :

Considérons tout d’abord la théorie de la relativité dont la genèse est remarquablement expliquée dans le livre

de Jules Leveugle [1]. Cette théorie n’a été que lentement acceptée par les physiciens en raison de son incompatibilité

avec certains des grands principes de la physique qui sont cités par Poincaré en 1904 lors de la conférence de Saint

Louis [2] : Le principe de conservation de l’énergie, le principe de la dégradation de l’énergie, le principe de l’égalité de

l’action et de la réaction, le principe de conservation de la masse, le principe de moindre action, auxquels il ajoute pour

la première fois le principe de relativité.

Cette théorie conçue pour conserver la vitesse de la lumière, ou plus exactement les équations de Maxwell,

n’est pas totalement compatible avec les principes de la physique cités par Poincaré. Pour rendre la vitesse de la lumière

indépendante du repère, fallait-il mettre les équations de Maxwell au dessus de tous les principes de la physique ? Etait-

il nécessaire d’abandonner la notion d’Ether, milieu supposé de propagation des ondes optiques, et sacrifier pour cela

plusieurs des principes de la physique comme celui de la conservation de l’énergie?

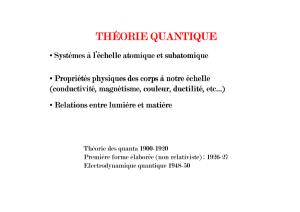

La théorie quantique :

Une autre théorie fondamentale du siècle est incontestablement la théorie quantique de Planck. La formule du

rayonnement thermique du corps noir proposée par Planck le 19 octobre 1900 introduisait la notion de quanta d’énergie

[3, 4]. La lecture de l’article original montre clairement que le modèle physique, très peu réaliste, proposé sans

justification par Planck avait pour seul objet d’illustrer, en faisant appel à la théorie des quanta, une formule décrivant

bien les résultats expérimentaux.

Malgré la notoriété de Planck, la notion de quanta n’a commencé à être acceptés qu’après l’article que Poincaré

a consacré à la théorie des quanta en 1912 [5]. Il y disait notamment : l’hypothèse des quanta est la seule qui conduise à

la loi de Planck, ce qui était bien la moindre des choses puisque Planck avait construit sa théorie du corps noir dans ce

but. On a seulement oublié les réserves de Poincaré sur la structure du modèle physique adopté par Planck.

Entre temps, Einstein avait envoyé le 18 mars 1905 un article dans lequel il introduit la notion de quanta

d’énergie localisés en des points de l’espace, chacun se déplaçant sans se diviser, c'est-à-dire de ce qui sera appelé plus

tard le photon [6]. Cette notion a évolué depuis de façon à mieux rendre compte des propriétés ondulatoires de la

lumière, mais l’assimilation du photon à un grain de lumière subsistera implicitement dans beaucoup d’esprits.

La physique des particules :

Des premières notes de Louis de Broglie en 1923 à sa thèse, la mécanique ondulatoire allait compléter cette

révolution conceptuelle. Associer à chaque particule une onde posait des problèmes nouveaux. Une onde

électromagnétique est transverse et ne peut avoir une symétrie de révolution. L’onde de louis de Broglie d’une particule

fixe pouvait être longitudinale et donc avoir une symétrie de révolution, mais restera mystérieuse, malgré les résultats

positifs de diffraction de particules réalisées depuis.

Parallèlement, Heisenberg proposa en 1925 une théorie baptisée mécanique des matrices ou mécanique

quantique, puis Schrödinger sa célèbre équation en 1926. Ce domaine de la physique, bien éloigné de la radioélectricité,

et dont la complexité dépasse le cadre de cet exposé ne sera pas abordé ici.

Nous noterons seulement que c’est à la suite de ces travaux qu’Heisenberg produit ses fameuses relations

d’incertitude. Avec l’école de Copenhague, il introduisit dans la physique l’indéterminisme.

Sur la base des relations d’incertitude, les physiciens admirent que ce qui ne s’observe pas n’existe pas. Ainsi

une particule n’a plus de trajectoire et sa position n’existe que si elle est mesurée à un instant donné avec une précision

limitée par les relations d’incertitude. Dès lors, la physique décide de ne pas s’intéresser aux transitions entre états

quantiques qui sont pourtant essentielles, en particulier dans les interactions entre matière et rayonnement.

La victoire de l’école de Copenhague marque la victoire d’une approche abstraite de la physique.

Aujourd’hui, dans le but de mieux connaître ses bases conceptuelles, la physique théorique s’intéresse de plus

en plus aux expériences sur des photons uniques. Celles-ci conduisent à des résultats de plus en plus surprenants, les

JS'11, Cnam Paris, 29-30 mars 2011

282

propriétés des photons apparaissant de jours en jours plus ésotériques : non localité, intrication de photons conduisant à

des interactions instantanées entre photons distants…

Ces travaux ont donné lieu au concept de cryptographie quantique, l’unicité des photons envoyés sur une fibre

optique étant supposée assurer, grâce à une procédure complexe, la confidentialité parfaite d’une transmission.

La course au gigantisme :

En particulier pour les besoins de la physique nucléaire, la physique moderne a dû construire des appareils de

plus en plus gros, en particulier pour l’étude de la matière. Monsieur Hubert Curien, avec l’humour qu’on lui connaît,

ne chiffrait-il pas lui-même dans une conférence prononcée à l’assemblée générale de la SEE le prix de ces équipements

en unités astronomiques ? Le 21° siècle ne verra-t-il pas la fin de ces grands instruments ?

L’étude de l’espace et les découvertes qui restent à faire grâce aux progrès de nos moyens d’observation

rendront sans doute inutiles des outils comme l’interféromètre VIRGO, construit pour détecter à partir d’expériences

terrestres d’éventuelles ondes de gravité (VIRGO a été réalisé à Cascina, près de Pise, par le CNRS et l'Institut national

italien de physique nucléaire, est un interféromètre dont les bras ont une longueur de3 Km).

Cet appareil, improprement désigné comme un interféromètre de Michelson, est d’une complexité extrême. Ses

très grandes dimensions devraient lui donner une très grande sensibilité, cependant, il souffre de limitations résultant de

nombreux phénomènes parasites.

En particulier, les vibrations sismiques, les marées terrestres et les dérives thermiques doivent être compensées

par des asservissements qui limitent l’étendue des fréquence observable à la bande 10Hz -10KHz.

Pourquoi l’existence des ondes de gravité, générées par des événement astronomiques rares et très lointains,

pourraient être détectées par un tel équipement sans que plane sur ce résultat la suspicion d’un fit accidentel ?

La radioélectricité :

Dans le même temps, le développement de la radioélectricité s’est fait indépendamment de l’évolution du reste

de la physique. Les recherches à la fois théoriques et appliquées ont porté sur un ensemble très varié de domaines. En

premier lieu le calcul des circuits, lignes de transmission, antennes. Ensuite, la propagation de ces ondes invisibles dans

des milieux d’indice inhomogène ou ionisés, enfin la diffraction et la diffusion par les obstacles …

A la suite de la découverte de l’effet transistor, les radioélectriciens investissent même le domaine de la

physique du solide.

Les recherches dans le domaine des radiocommunications visent le développement d’applications pratiques,

économiquement rentables. Bien évidemment, des solutions canoniques des équations de Maxwell, puis des calculs

numériques des circuits et antennes ont été mis en œuvre en fonction des besoins et des possibilités techniques, mais

sans jamais constituer un préalable au développement des applications.

Le bruit et les interférences, véritables limites techniques s’opposant au développement des systèmes, ont été

étudiés avec soin. La maîtrise des phénomènes aléatoires a été l’objectif essentiel des recherches dans les domaines des

télécommunications mais aussi du RADAR et des transmissions infrarouges [7]. Enfin, les contraintes temporelles

apparaissant dans les systèmes de transmission et de détection ont été prises en compte [8].

JS'11, Cnam Paris, 29-30 mars 2011

283

L’évolution de la physique théorique a été bien loin des préoccupations des radioélectriciens. La relativité

n’intervient dans les systèmes de localisation par satellite que sous la forme de corrections relativistes appliquées dans

un repère particulier lié à la Terre. Vus de la Terre, ces effets apparaissent comme des propriétés physiques comme les

autres et sont pris en compte sans référence aux transformations de Lorentz et aux considérations théoriques qui les

justifient.

La notion de bruit quantique n’apparaît que très récemment avec les liaisons optiques et les LIDARs. Même les

amplificateurs paramétriques ont pu être étudiés et mis au point en ne mettant en œuvre que des concepts classiques de

circuiterie hyperfréquence non linéaire.

Les expérimentateurs ont parfois observé des phénomènes imprévus. La mesure des surfaces équivalentes

RADAR a mis en évidence des ondes électromagnétiques de surface qu’il suffisait de modéliser, sans établir clairement

la théorie de leur fonctionnement, qui devrait découler de celle des lignes de Goubault. Ce sujet reste cependant à

étudier.

3 - La physique du 20° siècle vue par un radioélectricien :

En revenant sur les grandes innovations que le 20° siècle a apporté à la physique, nous allons maintenant

étudier comment un radioélectricien d’aujourd’hui pourrait les aborder et comment ses méthodes ouvrent de nouvelles

voies de recherche à la physique.

Le rayonnement du corps noir :

Au delà de son intérêt propre, le rayonnement du corps noir est important en raison du rôle qu’il a tenu dans

l’acceptation de la théorie des quanta par la communauté scientifique.

En 1900, Planck a proposé une modification de la formule proposée par Wien en 1896 par adjonction d’un

terme évitant la divergence de la formule aux longueurs d’onde courtes, connue sous le nom de catastrophe

ultraviolette.

Retenons la forme fréquentielle de cette formule:

( )

1

/

3

−

⋅= kThf

e

f

CtefP

T

A l’évidence, Planck a cherché à faire correspondre la formule théorique aux résultats expérimentaux. Il a fait

un rapprochement entre la thermodynamique statistique de Boltzmann et ses propres travaux sur les quanta.

Selon le modèle établi par Planck, le rayonnement lumineux serait dû à des résonateurs hertziens

rigoureusement monochromatiques ne pouvant émettre ou absorber de la lumière que de façon discontinue

conformément à la théorie des quanta.

Le rayonnement d’un solide serait dû à un très grand nombre de résonateur. Des échanges d’énergie entre ces

résonateurs pourraient avoir lieu par deux mécanismes :

- L’effet Doppler-Fizeau qui permettrait le décalage en fréquence permettant de changer une fréquence en une

autre et faire correspondre les quanta hν de valeurs différentes.

- Des chocs mécaniques entre ces résonateurs.

Ce modèle non physique n’est pas réellement satisfaisant, mais les différentes tentatives d’améliorations de

Planck n’ont pas été concluantes, comme l’indique Poincaré dans son article de 1912 [5]. En fait, ce modèle a ignoré le

rayonnement même qu’il prétendait calculer.

Des physiciens modernes réintroduisent un bruit gaussien préquantique qui reste nécessaire à la description

des phénomènes physiques [9]. C’est admettre, sans le dire, que le rayonnement est bien mieux décrit par la physique

classique, dite préquantique.

Supposons que Planck ait été un radioélectricien, connaissant parfaitement la théorie des antennes et des

circuits électroniques.

Il aurait pu représenter sa formule expérimentale sous la forme d’un produit de facteurs :

( )

kThf

e

kThf

e

f

c

CtefP

T

/

1

/

2

2

−

−

−

⋅⋅⋅=

λ

Le premier terme est un facteur liant la puissance rayonnée aux dimensions du pavage de la surface respectant

le théorème d’échantillonnage dit de Shannon, mais établi par Cauchy un siècle plus tôt. En effet, nous savons que pour

une fréquence donnée, le champ rayonné par une surface est entièrement déterminé par les valeurs observées au centre

JS'11, Cnam Paris, 29-30 mars 2011

284

de pavés élémentaires de côté λ/2. C’est cette approche que j’avais adopté lors de mon exposé lors des journées

scientifiques en 2006 [10].

2

2

λ

c

Cte

f G

Le terme central correspond à une dérivation. Ceci pourrait correspondre au fait que le rayonnement d’une

antenne correspond à la variation temporelle du courant, un courant constant ne produisant aucun rayonnement, mais,

comme nous le verrons plus tard, nous devrons rejeter cette interprétation.

Le troisième terme est un terme correspondant de façon surprenante au gain d’un système bouclé de gain de

boucle :

kThf

eG /

−

=

Ce gain a une valeur maximum unité à la fréquence nulle et présente une coupure de fréquence proportionnelle

à la température T.

La recherche d’un modèle radioélectrique :

Depuis le développement de l’électromagnétisme, il est possible de construire un modèle radioélectrique du

rayonnement du corps noir ayant une signification physique. Nous allons distinguer les cas des fréquences basses et des

fréquences hautes.

Cas des fréquences basses :

Un radioélectricien aurait sans doute cherché une interprétation de ces deux termes à partir de la statistique de

l’agitation thermique d’un nuage d’électrons dans un élément résistif. Connaissant le théorème d’échantillonnage, il

aurait sans doute adopté la démarche que j’ai retenu en 2006 pour comparer le rayonnement des émetteurs ULB au bruit

thermique.

Il aurait donc adopté pour les fréquences basses la formule :

( )

h

kTc

CtefP

T

⋅⋅=

2

2

λ

Cette formule correspond au courant de bruit d’agitation thermique dans une résistance de surface,

indépendante du pas du pavage et donc de la fréquence. Le produit de ce terme avec le facteur d’échelle donne alors le

rayonnement du corps noir pour ces fréquences. Bien évidemment, pour trouver le résultat exact, il faut prendre en

compte l’existence de deux polarisations.

Cas des fréquences hautes :

Aux fréquences élevées, il aurait sans doute admis la présence d’un filtre passe bas de gain G et cherché à en

comprendre la présence. Sa première idée aurait sans doute été d’attribuer ce filtrage passe bas à la durée non nulle des

chocs entre les charges mobiles et le substrat dans la résistance source du rayonnement.

Une statistique sommaire faite sur un ensemble de charges mobiles l’aurait conduit, pour un pavage donné, à

un filtrage passe bas de type exponentiel analogue à celui de la formule de Planck, et à la même dépendance en fonction

de la température. L’équation de la courbe expérimentale devient alors :

( )

kThf

ef

c

CtefP

T

/

2

2

−

⋅⋅⋅=

λ

Le terme f, ou c/λ, reste à justifier. Il peut être interprété de diverses façons. En effet, le rayonnement noir

résulte d’un équilibre entre émission et absorption de la lumière par le corps rayonnant. Le calcul peut se faire en

attribuant aux charges électriques mobiles ces deux phénomènes.

Le rayonnement du corps noir correspondant à un équilibre, il faut rendre égales ces deux quantités. La valeur

du champ est donc l’intégrale dans le temps du rayonnement dû aux chocs, les pertes correspondant à l’énergie

emmagasinée par les charges mobiles entre deux chocs successifs avec le substrat. Ceci correspond au schéma

équivalent suivant :

JS'11, Cnam Paris, 29-30 mars 2011

285

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

1

/

14

100%