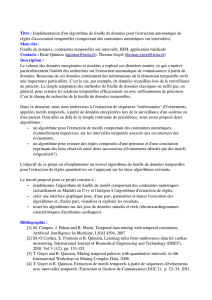

memoire de magister theme - Université d`Oran 1 Ahmed Ben Bella

Département Informatique

MEMOIRE DE MAGISTER

Option : Informatique et Automatique

THEME :

F

OUILLE DE DONNEES BIOLOGIQUES

:

E

TUDE COMPARATIVE ET

EXPERIMENTATION

.

Présenté par : Abdelhak MANSOUL

Soutenu devant les membres du jury :

Mr B. BELDJILALI Professeur à l’Université d’Oran

Président

Mr K. BOUAMRANE Maître de Conférences à l’Université d’Oran

Examinateur

Mr A. GHOMARI Maître de conférences à l’Université d’Oran

Examinateur

Mr M. MALKI Maître de conférences à l’UDL de Sidi Belabess

Examinateur

Mr B. ATMANI Maître de conférences à l’Université d’Oran

Rapporteur

2009-2010

Résumé

Le traitement des données biologiques est indispensable en recherches médicales et sciences de la vie. En

effet, les données biologiques sont de différents types, et souvent complexes, ce qui a induit une recherche

soutenue de nouveaux procédés d’exploitation parce que ceux existant ne suffisent plus ou ne sont plus

adaptés. Une nouvelle approche : l’Extraction de Connaissances à partir des Données biologiques est de

plus en plus envisagée. De là, notre étude qui porte sur la fouille de données biologiques sur un terrain

expérimental : une épidémie.

Le présent travail de recherche se situe dans le cadre de l’ECD Biologiques, à travers une étude

comparatives des outils existants et la proposition d’une nouvelle approche pour l’extraction des règles

d’association à partir de données biologiques, leur gestion et l’alimentation d’un système d’aide à la

décision.

D’où, la problématique abordée par notre étude qui est la fouille de données biologiques assistée par une

modélisation booléenne des résultats obtenus.

Nous proposons un processus d’extraction de motifs assez novateur pour générer des règles

d’association profitable et exploitable à deux niveaux :

•

Profitable au spécialiste du domaine, en particulier à travers les règles d’association qui aident à

mieux interpréter les données.

•

Le résultat de la fouille de données est optimisé par une modélisation booléenne des règles

d’association extraites. Cette amélioration se fait par la machine BRI (Boolean Rules Induction ).

En premier lieu nous présenterons un état de l’art, s’ensuit une étude comparative des différents outils et

méthodes existants afin d’en tirer bénéfice, et on continuera par exposer notre démarche et les résultats

obtenus.

Mots clés: Automate cellulaire, Fouille de données biologiques, Induction de règles, Règle d’association,

modélisation booléenne.

Abstract

The biological data processing is an indispensable tool in medical researches and life sciences. Indeed,

the biological data are various types, and often complex, what led a search of new exploitation processes

because those existing are not any more enough or are not any more adapted. A new approach : the

Extraction of Knowledge from the biological data is more and more envisaged. From there, our study which

concerns the Biological Data Mining on an experimental ground: an epidemic.

The present research work is situated within the framework of Knowledge Discovery from Biological

Data, through study comparative clauses of the existing tools and the proposition of a new approach for the

extraction of the association rules from biological data, there management and the supply of a system of

decision-making support.

Where from, the problem approached by our study which is the Data Mining of biological data assisted

by a boolean modeling for the obtained results.

We propose a rather innovative process of extraction of patterns for generating a profitable and

exploitable association rules at two levels:

•

Profitable, to the specialist of the domain, in particular through the rules of association which help to

interpret better the data.

•

The result of the data mining process is optimized by a boolean modelling of the extracted association

rules. This improvement is made by the machine BRI (Boolean Rules Rules Induction).

First of all we shall present a state of the art, follows a comparative study of the various existing tools

and the methods to benefit from it, and we shall continue to expose our approach and the obtained results.

Key words: Cellular automaton, Biological data mining, Rules Induction, Association Rules, Boolean

modelisation

Remerciements

Je remercie les membres du jury qui m’ont fait l’honneur d’avoir

accepté d’évaluer ce travail.

Je remercie vivement Monsieur Bouziane BELDJILALI, qui m’a

bien accueilli et m’a entretenu pour me diriger ensuite vers mon

encadreur. Ainsi que, Monsieur Baghdad ATMANI mon encadreur,

pour m’avoir dirigé pendant tout le long de ce travail, par ses

précieux conseils, ses pertinents commentaires, et ses orientations.

De plus m’a fait profiter de son expérience dans la direction de

travaux de recherche.

Mes remerciements vont aussi :

À Monsieur Abdelhafid HAFFAF, le chef du département

informatique de l’université d’Oran.

À Monsieur Karim BOUAMRANE pour m’avoir facilité les

démarches administratives au département informatique.

Et Monsieur Smain MAAZOUZI, le chef du département

informatique de l’université du 20 Août 55 de SKIKDA pour son

grand soutien.

TABLE DES MATIERES

Résumé

Liste des figures

Liste des tableaux

Glossaire

Introduction générale 1

Chapitre I.

L’Extraction de Connaissances à partir de Données Biologiques 6

I.1 Définition de l’extraction de connaissances à partir de données

biologiques 6

I.2 Le processus de l’ECD biologiques 7

I.3 Notre contribution 13

I.4 Etat de l’art de l’ECD biologiques 14

I.5 Les méthodes de fouille de données 20

I.6 Etude comparative 27

I.7 Discussion sur l’ECD Biologiques 30

I.8 Conclusion 31

Chapitre II.

Extraction de règles d’association 33

II.1 Les règles d’association 34

II.2 L’induction et l’évaluation des règles 35

II.3 Les algorithmes d’extraction des règles d’association 37

II.4 Conclusion 42

Chapitre III.

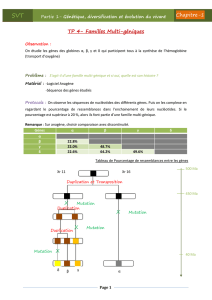

Modélisation booléenne des règles d’association 44

III.1 Le moteur d’inférence cellulaire : architecture et principe de 44

fonctionnement

III.2 La modélisation booléenne 47

III.3 Exemple d’illustration d’induction des règles booléennes 48

III.4 La dynamique du moteur d’inférence cellulaire 50

III.5 Conclusion 52

Chapitre IV.

Conception et expérimentation du système BIODM 54

IV.1 Etude et choix des données biologiques pour expérimentation 54

IV.2 Architecture du système BIODM (BIOlogical Data Mining) 55

IV.3 Le processus de l’ECD biologiques 57

IV.4 Le logiciel réalisé 63

IV.5 L’expérimentation 66

IV.6 Conclusion 70

Conclusion générale 71

Références bibliographiques 73

Annexe B 77

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

34

34

35

35

36

36

37

37

38

38

39

39

40

40

41

41

42

42

43

43

44

44

45

45

46

46

47

47

48

48

49

49

50

50

51

51

52

52

53

53

54

54

55

55

56

56

57

57

58

58

59

59

60

60

61

61

62

62

63

63

64

64

65

65

66

66

67

67

68

68

69

69

70

70

71

71

72

72

73

73

74

74

75

75

76

76

77

77

78

78

79

79

80

80

81

81

82

82

83

83

84

84

85

85

86

86

87

87

88

88

89

89

90

90

91

91

1

/

91

100%