Carte Blanche P Carrega

La Topoclimatologie :

pourquoi le climat varie-t’il

sur de très courtes distances?

Pierre CARREGA

Pierre CARREGA est Agrégé de Géographie, Docteur d’Etat et Professeur

d’Université. Généraliste par sa formation de Géographe, il s’est spécialisé

dans la géographie physique et

l’environnement, et en particulier

en climatologie et sur les risques

attenants.

Agé de 55 ans, et Doyen Honoraire

de Faculté, il exerce sa profession

d’enseignant-chercheur à l’Université

de Nice-Sophia Antipolis où il dirige

l’Equipe de recherche « Gestion et

Valorisation de l’Environnement »

(UMR « Espace » / CNRS).

Cette équipe a prioritairement axé ses

recherches depuis longtemps sur les thèmes de la variation du climat (dans

l’espace et le temps) et sur les risques climatiques et hydrologiques.

NB : Toute utilisation autre qu’à titre purement individuel de cet exposé est interdite sans le

consentement explicite de l’auteur : [email protected] Merci de votre compréhension

Qu’est-ce que le climat ?

Le climat est la résultante des types de temps quotidiens (beau, couvert, frais,

pluvieux, venté, etc) répétés sur des jours et des années (en principe on peut le définir

avec au moins 30 ans de mesures).

Il se décrit par des valeurs « centrales » (moyenne, médianes, etc ) mais aussi par sa

variabilité et ses valeurs extrêmes (écarts-types, « durée de retour » de telle intensité

de pluie, etc).

Naturellement plus ou moins inconstant selon les lieux, il varie cependant parfois

durablement dans le temps (changement climatique qui s’apprécie sur des dizaines et

des centaines d’années). Certains l’oublient, qui voudraient que tout écart à la

moyenne soit forcément signe de changement instantané : il existe des échelles

temporelles.

Il varie aussi dans l’espace, sur de grandes distances (quand on change de latitude),

mais aussi sur de plus petites distances, dès que le substrat géographique devient

complexe et contrasté : terre-mer, montagnes-plaines, sommet-vallée, forêt-prairie,

ville-campagne, etc…

Il existe donc aussi des échelles spatiales !

On demande souvent : « combien y a-t’il de microclimats à Nice

ou à Perpette les Olivettes ? ».

Réponse : une infinité … !!!

Tout dépend de l’échelle (spatiale) à laquelle on se place.

Pour schématiser, il existe 4 ou 5 niveaux d’échelles : le microclimat, le topoclimat,

le mésoclimat, et le macroclimat, plus le climat zonal (tempéré, tropical, etc).

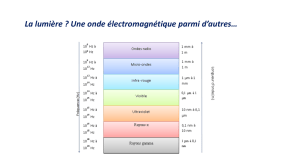

•Le microclimat concerne les environs très proches d’un point, son domaine d’action est

de l’ordre du centimètre à la dizaine de mètres. Il est influencé prioritairement par la

nature des roches et du sol, la végétation, les matériaux artificiels (béton, asphalte …).

•Le topoclimat intervient avec le relief et les formes du terrain (pentes, vallées, collines,

montagnes…). Il joue sur des distances d’environ 10 m à plusieurs kilomètres

C’est lui qui sera l’objet de ces pages dans lesquelles

on insistera sur la température

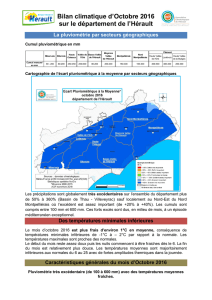

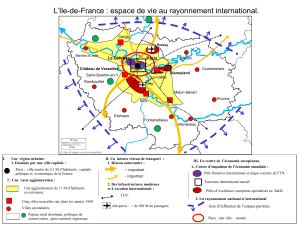

* Le mésoclimat est le climat régional, entre des dizaines et des centaines de kilomètres.

Par exemple : le climat du Languedoc, de l’Alsace, de l’Ile de France …

* Le macroclimat dépend en grande partie de l’échelle planétaire pour les mécanismes.

C’est par exemple celui de l’Europe de l’Ouest, de la Sibérie, etc

Micro Topo Méso

En fait, le climat à une échelle donnée, par exemple une région (échelle méso),

est le résultat de l’emboîtement de toutes les échelles inférieures …

Ces multitudes de microclimats s’associent-ils pour former un topoclimat, et les divers

topoclimats se combinent-ils pour donner un climat régional? Oui.

Mais les relations vont aussi dans le sens opposé, descendant : par exemple, le topo-climat

ne peut s’exprimer QUE parceque le mésoclimat et le macroclimat le laissent faire !

Exemple : Au contraire du sud-est de la France, en Lorraine, la fréquence des inversions

locales de températures nocturnes (entre vallées et plateaux) est trop rare pour que

ces inversions soient nettement perceptibles, statistiquement.

Pourquoi ?! Parce qu’à l’échelle régionale, le ciel est souvent couvert, ce qui empêche

Les particularités locales de s’exprimer, à l’inverse des régions méditerranéennes où les nuages

sont plus rares.

Nous y reviendrons.

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

34

34

35

35

36

36

37

37

38

38

39

39

1

/

39

100%