Oto - UQAM

Oto

Un outil générique et extensible pour

corriger les travaux de programmation

Guy Tremblay et Frédéric Guérin

Département d’informatique, UQAM

(Université du Québec à Montréal)

ESILV, 13 décembre 2005

2

Plan de la présentation

1. Pourquoi automatiser la correction des travaux de

programmation?

2. Quels sont quelques-uns des outils de correction

existants?

3. L’outil Oto :

• 3.1 Comment l’utilise-t-on?

•3.2 Comment peut-il être configuré et étendu?

•3.3 Comment est-il mis en œuvre?

4. Conclusion et travaux futurs

1. Pourquoi automatiser la

correction des travaux de

programmation?

4

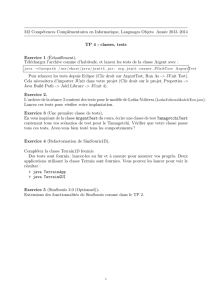

Étapes typiques d’un TP

Enseignant

et ses assistants Étudiants

6

Traiter

résultats

1

Composer TP 2

Distribuer TP 3

Faire TP

4

Rendre TP

5

Corriger TP

5

Correction d’un TP

•Divers aspects doivent être traités et corrigés

–Stylistiques :

•Bien présenté et bien indenté ?

•Commentaires présents et pertinents ?

•Identificateurs bien choisis ?

–Structuraux :

•Cohésion forte? Couplage faible?

• Bonne dissimulation d’information?

–Fonctionnels :

•Ça compile ?

•Ça marche correctement ?

•Imaginez 50, 100, 150 copies à corriger !!!

•Long, répétitif, ennuyant, résultats non-uniformes.

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

34

34

35

35

36

36

37

37

38

38

1

/

38

100%