Livre spss.book - E

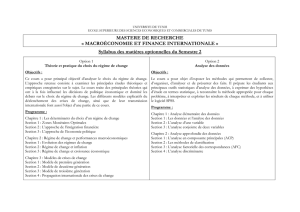

Sciences de gestion

&

Analyse

de données

avec SPSS

®

Manu Carricano

INSEEC Paris

Fanny Poujol

IAE Valenciennes

Directeur de collection : Roland Gillet

Université Paris I Panthéon-Sorbonne

Avec la contribution de Laurent Bertrandias

pour la relecture de fond

Institution d’Administration des Entreprises – Université Toulouse 1

collection

Synthex

Synthèse

de cours exercices

corrigés

prelim.fm Page I Vendredi, 25. janvier 2008 3:04 15

Livre spss.book Page IV Vendredi, 25. janvier 2008 12:04 12

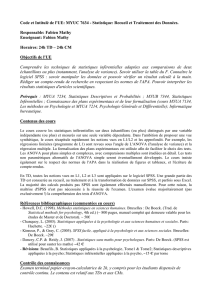

Sommaire

V

Sommaire

Préface

......................................................................... VII

Introduction

.................................................................. IX

Les auteurs

.................................................................... XI

Chapitre 1 • Analyser pour décider

.................................................. 1

Chapitre 2 • Décrire les données

...................................................... 29

Chapitre 3 • Simplifier les données

.................................................. 51

Chapitre 4 • Segmenter

................................................................... 79

Chapitre 5 • L’analyse de variance

.................................................. 107

Chapitre 6 • La régression linéaire

................................................... 133

Chapitre 7 • L’analyse conjointe

...................................................... 155

Chapitre 8 • Communiquer les résultats

........................................... 177

Bibliographie générale

.................................................. 195

Index

............................................................................ 197

Livre spssTDM.fm Page V Vendredi, 25. janvier 2008 3:06 15

Livre spss.book Page XII Vendredi, 25. janvier 2008 12:04 12

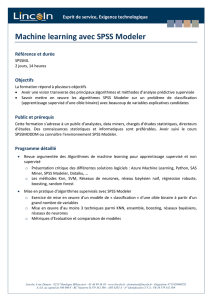

1

1

Analyser

pour décider

Une bonne décision consiste à choisir la plus optimale des

solutions parmi une série d’alternatives. Le marketing – et en

particulier sa dimension études – s’est longtemps cantonné à

un rôle purement descriptif. Mais les bonnes décisions n’arri-

vent pas par hasard : elles doivent être fondées sur des infor-

mations fiables et valides. Tour à tour, les outils d’études de

marchés et les techniques d’analyse se sont considérablement

enrichis. L’avènement d’Internet, la sophistication et l’exhaus-

tivité des données de panel, la montée en puissance des bases

de données clients et du data mining ont repoussé les limites

des études de marchés traditionnelles, favorisant l’émergence

d’une information marketing de grande qualité et d’analyses

explicatives, voire prédictives, des comportements.

Ce chapitre présente les grandes familles d’études de marchés

et pose les bases de l’analyse de données en marketing en

abordant les concepts de données, de variables et de mesure.

1. Études et recherche

en marketing...............................2

2. Des données aux variables...........7

3. Mesurer à l’aide

d’un questionnaire.....................16

Exercices

1. Quand Pampers collecte

des données..............................23

2. L’audience de la super star.........24

3. L’enquête « point de vente ».......25

Chapitre

Livre spss.book Page 1 Vendredi, 25. janvier 2008 12:04 12

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

34

34

35

35

36

36

37

37

38

38

39

39

40

40

1

/

40

100%