ELASTICSEARCH @SYNTHESIO

ELASTICSEARCH @SYNTHESIO

FRED DE VILLAMIL

BACKGROUND

•FRED DE VILLAMIL, 37 ANS, HEAD OF INFRASTRUCTURE

@SYNTHESIO

•LINUX / (FREE)BSD DEPUIS 1996

•CONTRIBUTEUR OPEN SOURCE DEPUIS 1998

•ELASTICSEARCH EN PRODUCTION DEPUIS LA 0.17.6

SYNTHESIO

•Leader du “social listening”

•Crawl le Web, enrichit les données avec de

l’analyse de sentiment et démographique

•Bureaux à Paris, Londres, New York et Singapour

ELASTICSEARCH CHEZ SYNTHESIO

•3 clusters, 116 serveurs, 271 TB de stockage, 7,25TB

de RAM

•60 milliards de documents indexés, 160TB de

données

•1,5 milliards de nouveaux documents par mois

•Utilisé pour agréger plusieurs clusters SQL de

dizaines de TB

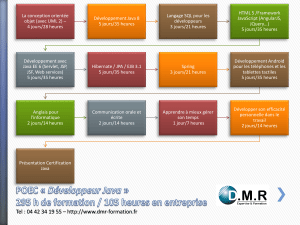

PHASE 1 : OFFLOADER LES MYSQL

•1 index global, 512 shards, 5 milliard de documents

•1000 documents / seconde en continu

•47 serveurs en RAID0, ES 1.3.2 puis 1.3.9

• Capacité : 40TB, dont, 24TB utilisés, 2.62 TB RAM

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

34

34

1

/

34

100%