Logiciel Statistique Complet

Logiciel Statistique Complet

PASW® Statistics Base 17.0 – Specifications

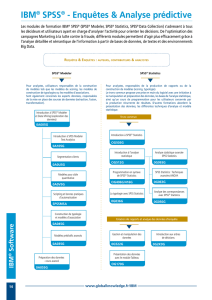

Résolvez les problèmes de gestion et de recherche avec

PASW Statistics, un progiciel de statistique et de gestion

de données destiné aux analystes et aux chercheurs.

Comparé à d’autres progiciels d’analyse de données, PASW

Statistics* est plus facile à utiliser, offre un coût de propriété

inférieur et gère entièrement la totalité du processus

analytique. PASW Statistics Base* fait partie intégrante de ce

processus, disposant de fonctions pour l’accès, la gestion,

la préparation, l’analyse et le reporting des données. PASW

Statistics Base permet de travailler en toute confiance avec

des modules additionnels et d’autres produits de la gamme

PASW Statistics pour bénéficier de capacités de planning,

de collecte de données et de déploiement. Ces modules

et produits développent en outre certaines des fonctions

déjà présentes dans PASW Statistics Base. La plupart des

fonctions [et des modules additionnels] sont disponibles sur

la plate-forme de votre choix : Microsoft® Windows®, Apple®

Mac® OS X, or Linux®.**

Access and analyze massive datasets quickly

PASW Statistics simplifie l’accès, la gestion et l’analyse

rapides de tout type d’ensemble de données : données

d’enquête, bases de données d’entreprise ou données

importées du Web. PASW Statistics Base peut traiter les

données Unicode. Cette approche élimine la variabilité, au

niveau des données, liée à des encodages spécifiques à la

langue utilisée et permet de visualiser, analyser et partager

les données écrites en plusieurs langues. Réalisez une

analyse aussi rapide que possible : laissez votre serveur

exécuter tout le travail de traitement lourd. Combinez

simplement PASW Statistics Base avec PASW Statistics

Base Server (proposé en option).

Préparation rapide et simple des données avant analyse

Avant de pouvoir analyser les données, vous devez les

préparer. De nombreuses techniques et fonctions intégrées

à PASW Statistics Base simplifient ce travail de préparation.

Voici quelques-uns des points forts de la gestion de

données sous PASW Statistics. Avec PASW Statistics Base,

vous définissez très facilement des informations pour

le dictionnaire de données (par exemple des libellés de

valeur et des types de variable). Avec l’outil Define Variable

Properties, vous préparez vos données à l’analyse plus

rapidement. PASW Statistics Base affiche une liste de

valeurs avec le nombre d’occurrences pour vous permettre

d’ajouter ces informations. Une fois le dictionnaire de

données configuré, vous pouvez l’appliquer avec l’outil Copy

Data Properties. Le dictionnaire de données agit comme

un modèle, vous pouvez l’appliquer à d’autres fichiers de

données et à d’autres variables à l’intérieur d’un même

fichier.

PASW Statistics Base simplifie l’identification des doublons,

ce qui permet de les éliminer avant l’analyse. Utilisez l’outil

Identify Duplicate Cases pour définir des paramètres et

repérer les doublons de façon à en garder la trace.

PASW Statistics Base simplifie en outre la préparation des

données continues pour l’analyse. Par exemple, le Visual

Binner permet de fractionner facilement le revenu par

“ bandes ” de 10 000 ou les âges par groupes d’âges. Une

lecture des données fournit un histogramme qui permet

de spécifier les points de rupture. Vous pouvez alors créer

* PASW Statistics et PASW Statistics Base, précédemment appelés SPSS Statistics et SPSS Statistics Base, font partie du portefeuille de

logiciels d’analyse prédictive de SPSS Inc.

** Amos™ 17.0, PASW Viz Designer, et PASW Exact Tests 17.0 sont uniquement disponibles sur la plate-forme Windows et

l’échange des données avec la gamme Dimensions™, composée de produits d’enquêtes, est supporté uniquement par la

version 17.0 de PASW Statistics qui s’exécute sous Windows.

automatiquement des libellés de valeur à partir des points

de rupture spécifiés (par exemple « 21-30 »).

Créez vos propres informations de dictionnaire pour les

variables avec Custom Attributes. Par exemple, créez un

attribut personnalisé représentant la totalité du texte d’une

question d’enquête avec un nom de code tel que « demo01

» comme nom de variable. Vous pouvez également créer

des attributs personnalisés décrivant les transformations

pour une variable dérivée avec des informations expliquant

comment vous avez transformé la variable.

Vous pouvez ouvrir plusieurs ensembles de données avec

une seule session PASW Statistics Base. Vous gagnez ainsi

du temps et vous réduisez le nombre d’étapes lors de la

fusion des fichiers de données. Cette approche garantit

en outre la cohérence lors de la copie des informations du

dictionnaire de données entre plusieurs fichiers. Si vous

le souhaitez, vous pouvez également réduire le nombre

d’ensembles de données actifs.

PASW Statistics Base vous permet de restructurer vos

fichiers de données pour les préparer à l’analyse. Vous

pouvez par exemple restructurer un fichier de données

comportant plusieurs cas par sujet en plaçant les données

de chaque sujet dans un seul enregistrement. Vous pouvez

également exécuter l’opération inverse : prendre un fichier

de données ayant un seul cas par sujet et subdiviser les

données en plusieurs cas.

Utilisez l’assistant Date and Time pour effectuer des calculs

de date et d’heure, créer des variables date/heure à partir

de chaîne contenant des variables de date (telles que «

03/29/06 ») et importer dans PASW Statistics les données

de date et d’heure de toute une variété de sources. Vous

pouvez également analyser chacune des unités de date et

d’heure, par exemple l’année, à partir des variables de date

et d’heure, pour appliquer les filtres.

Techniques d’analyse complètes

Allez au-delà des statistiques résumées et des calculs de

type ligne et colonne. PASW Statistics vous offre une vaste

gamme de procédures statistiques pour l’analyse de base,

dont les décomptes, les tableaux à double entrée, les

clusters, les descriptifs, l’analyse de facteurs, la régression

linéaire, l’analyse de clusters, la régression ordinale et

l’analyse du plus proche voisin. Une fois votre analyse

terminée, vous pouvez facilement réécrire les données

vers votre base de données avec l’assistant Export to

Database. Pour davantage de puissance analytique, utilisez

PASW Statistics Base avec toute une variété de modules

additionnels tels que SPSS Regression*** et SPSS Advanced

Statistics*** spécialisés dans l’analyse de données (des

informations détaillées sur ces produits sont fournies à

partir de la page 15).

Création simple de graphiques avec capacités de reporting

sophistiquées

Créez facilement les graphiques les plus courants

(matrices de nuages de points, histogrammes, pyramides

de population) avec le Chart Builder. Cette interface

extrêmement visuelle permet de créer un graphique en

déplaçant les variables et les différents éléments vers un

‘canevas’ de création. Vous pouvez également gagner du

temps en tirant parti d’un graphique déjà présent dans

la Galerie. Au fur et à mesure de sa construction, une

prévisualisation limitée du graphique est affichée. Les

utilisateurs avancés peuvent disposer d’une plus vaste

gamme de graphiques et de possibilités avec le Graphics

Production Language (GPL).

Ce système graphique de présentation vous donne à la

fois le contrôle sur les étapes de création et sur les étapes

d’édition. Dans un environnement de production, la charge

de travail s’en trouve allégée. Créez un graphique une fois,

puis utilisez vos spécifications pour créer des centaines de

graphiques du même type.

Présentation des données avec Report OLAP

La technologie OLAP transforme la façon dont vous créez

l’information et dont vous la et partagez. Report OLAP,

2

3

sous PASW Statistics, offre une méthode rapide et souple

pour créer, distribuer et présenter les informations en vue

d’une prise de décision pertinente. Créez des tableaux,

des graphiques et des cubes de rapport s’appuyant sur

une technologie de pivot unique et primée et découvrez

de nouvelles informations dans vos données. Permutez les

lignes, les colonnes et les couches des cubes de rapport –

ou modifiez rapidement les informations et les statistiques

dans les graphiques et affinez votre compréhension des

données. En quelques clics, vous pouvez même convertir un

tableau en graphique.

Générateur de boîtes de dialogue

PASW Statistics 17.0 est fourni avec Custom Dialog Builder,

un générateur de boîtes de dialogue personnalisé qui permet

aux utilisateurs plus expérimentés de simplifier les boîtes

de dialogue existantes pour les utilisateurs de l’entreprise

et de créer des boîtes de dialogue pour des fonctions

personnalisées intégrées via la capacité de programmation.

Pour les utilisateurs moins expérimentés, Custom Dialog

Builder permet d’apprendre rapidement à exécuter des

opérations de routine. Quant aux programmeurs, ils

bénéficient d’une méthode de déploiement efficace.

L’impact des résultats de l’analyse

Pour tirer le meilleur parti de vos conclusions analytiques,

vous devez être capable de gérer efficacement les résultats

et de les partager. Avec les capacités de collaboration de

PASW Statistics, vos analystes peuvent stocker toute une

variété de ressources techniques (telles que des fichiers de

syntaxe, des fichiers de sortie et des fichiers de données)

dans un environnement centralisés et sécurisé et développer

et partager les meilleures pratiques. De plus, ils peuvent

distribuer les conclusions afin de permettre aux utilisateurs

de l’entreprise de visualiser et d’interagir facilement avec les

résultats via un navigateur Web. Parce que votre équipe va

fonctionner au plus haut niveau possible, votre entreprise

bénéficiera d'un support rapide pour une prise de décision

basée sur les données.

*** PASW Regression et PASW Advanced Statistics, précédemment appelés

SPSS Regression et SPSS Advanced Statistics, font partie du portefeuille de

logiciels d’analyse prédictive de SPSS Inc.

Caractéristiques

General operations

■ Changez la langue de l’interface utilisateur

(possibilité par exemple de basculer entre

l’anglais et le japonais)

■ Appliquez des séparateurs (splitters)

via le Data Editor pour comprendre plus

rapidement et plus facilement les grands

ensembles de données.

■ Sélectionnez la fonction de barre d’outils

personnalisable pour :

– Insérer des procédures, des scripts ou

d’autres logiciels,

– Sélectionner à partir d’icônes de barre

d’outils standard ou créer des icônes

personnalisées.

■ Travaillez avec des tables pivot/des cubes

de rapport multidimensionnels pour :

– Réagencer les colonnes, les lignes et les

couches en déplaçant les icônes pour des

analyses spécifiques plus simples,

– Permuter entre les couches en cliquant

sur une icône pour une comparaison plus

simple entre les sous-groupes,

– Activer l’aide en ligne pour les statistiques

afin de choisir les procédures statistiques

ou les types de graphique et interpréter

les résultats ; des exemples d’application

réalistes sont fournis.

■ Changez les attributs de texte tels que

police, couleur, gras, italiques, etc.

■ Changez les attributs de tableau tels que

format de nombre, style de ligne, largeur

de ligne, alignement de colonne, trame

d’arrière plan et de premier plan, activation

ou désactivation des lignes, etc.

■ Affichez ou masquez sélectivement lignes,

colonnes ou libellés pour faire ressortir les

conclusions importantes.

■ Activez l’aide spécifique à une tâche avec

des instructions étape par étape pour :

– Visualiser les études de cas montrant

comment utiliser les statistiques

sélectionnées et interpréter les résultats,

– Sélectionner le Statistics Coach™ pour

choisir la meilleure procédure statistique

ou le meilleur graphique,

– Suivre le didacticiel pour apprendre à

utiliser le logiciel,

– Sélectionner les boutons “ Show me ”

(Expliquez-moi) qui sont des liens vers

le didacticiel et affichent une aide plus

ciblée,

– Utiliser l’aide « What’s this ? » (Qu’est-ce

que c’est) qui affiche des définitions, des

termes statistiques et des astuces.

■ Utilisez les capacités de formatage pour la

sortie :

– Transformez un tableau en graphique

pour une communication visuellement

plus attrayante.

– Montrez les coefficients de corrélation

avec leur niveau de signification (ainsi

que n) dans des corrélations en utilisant

l’affichage de sortie par défaut.

– Spécifiez si un tableau, une fois activé,

est ouvert sur place ou dans sa propre

fenêtre.

– Indiquez la date et l’heure dans le fichier

journal.

– Faites un clic droit sur l’icône du fichier de

syntaxe PASW Statistics pour exécuter un

fichier de commande sans passer par le

mode de production.

– Utilisez les listes déroulantes pour

accéder plus facilement aux différentes

couches.

– Définissez des paramètres de page

permanents.

– Définissez une largeur de colonne pour

toutes les tables pivot et définissez le

retour à la ligne pour le texte.

– Spécifiez la notation scientifique pour

afficher de plus petits nombres.

– Spécifiez le nombre de décimales dans

les présentations.

– Intervenez sur les rapports et utilisez des

modèles et du code créés par d’autres

utilisateurs de l’entreprise avec l’option

SPSS Predictive Enterprise Services.

– Ajoutez des notes de bas de page et des

annotations.

– Réagencez les catégories à l’intérieur

d’un tableau pour afficher les résultats de

façon plus efficace.

– Groupez ou dégroupez des catégories

multiples, en lignes ou en colonnes, sous

une seule rubrique couvrant les lignes ou

les colonnes.

– Utilisez l’un des seize TableLooks™

préformatés pour un formatage rapide et

cohérent des résultats.

– Créez et enregistrez des formats

personnalisés en tant que TableLooks.

– Affichez les valeurs ou les libellés.

– Faites pivoter les libellés de tableau.

■ Travaillez avec le Viewer pour organiser,

visualiser et parcourir les résultats

– Conservez un enregistrement de votre

travail en utilisant la valeur par défaut «

append » dans les fichiers journaux.

– Utilisez une représentation schéma¬tique

(outline) pour déterminer rapidement

l’apparence de la sortie .

– Sélectionnez une des icônes de l’aperçu

et affichez les résultats correspondants

dans le panneau de contenu.

– Réagencez les graphiques, les tableaux

et d’autres objets en déplaçant les icônes

sur l’aperçu.

– Réduisez ou développez l’aperçu pour

visualiser ou imprimer les résultats

sélectionnés.

– Placez des tableaux, des graphiques et

des objets dans un même panneau de

contenu pour pouvoir y accéder et les

vérifier facilement.

– Justifiez la sortie à droite, à gauche ou au

centre.

– Recherchez et remplacez des informations

dans le Viewer du panneau de contenu, le

panneau d’aperçu ou les deux.

■ Créez des spécifications d’analyse et

enregistrez-les pour les tâches répétitives ou

le traitement automatisé.

■ Utilisez le mode de production optimisé

avec boîtes de dialogue et macros pour un

reporting périodique plus simple.

■ Contrôlez entièrement le fractionnement

des tableaux avec pagination et impression

optimisées.

■ Sélectionnez l’option d’aperçu avant

impression.

■ Entrez vos propres commandes via

une fenêtre de saisie de type ligne de

commande.

■ Utilisez les explications du glossaire des

termes statistiques en ligne.

■ Travaillez plus facilement avec les données,

grâce à :

– Des boîtes de dialogue

redimensionnables,

– Des fonctions de type glisser-déposer

dans les boîtes de dialogue.

■ Exportez la sortie vers Microsoft Word

– Convertissez les tables pivot en tableaux

Word sans aucune perte de formatage.

– Convertissez les graphiques en images

statiques.

4

■ Retour automatique à la ligne et contraction

des grands tableaux.

■ Syntaxe pour automatiser la production de

rapports.

■ Exportez la sortie vers PowerPoint®

(Windows uniquement)

– Convertissez les tables pivot en tableaux

sous PowerPoint sans perte de formatage.

– Convertissez les graphiques en images

statiques.

– Retour automatique à la ligne et réduction

des grands tableaux.

– Syntaxe pour automatiser la production

de rapports.

– Modifiez un document existant en y

ajoutant lignes ou colonnes.

■ Exportez la sortie vers Excel®

– Placez des tableaux sur une même feuille

ou sur des feuilles séparées dans un

classeur Excel.

– Exportez la vue en cours uniquement ou

bien toutes les couches d’une table pivot

PASW Statistics.

– Placez toutes les couches de la table pivot

sur une seule feuille ou placez chaque

couche sur une feuille séparée dans un

classeur Excel.

■ Syntaxe pour automatiser la production de

rapports.

■ Créez une nouvelle feuille de calcul à

l’intérieur d’un classeur existant.

■ Modifiez une feuille de calcul existante en y

ajoutant des lignes ou des colonnes.

■ Exportez la sortie au format PDF

– Optimisez le fichier PDF pour visualisation

sur le Web.

– Faites correspondre les signets générés

par PDF aux entrées de Navigator Outline

de l’Output Viewer. Les marque-pag¬es

facilitent la navigation dans les grands

documents.

– Intégrez des polices au document. Avec

des polices intégrées, le lecteur visualise

votre document avec les polices d’origine,

ce qui évite toute substitution de polices.

■ Syntaxe pour automatiser la production de

rapports.

■ Ouvrez/enregistrez et créez facilement de

nouveaux fichiers de sortie via la syntaxe.

■ Faites défiler l’affichage à l’aide de la souris

dans l’Output Viewer.

■ Changez la langue d’affichage (par exemple

basculer entre le japonais et l’anglais).

■ Utilisez la fonction de script pour :

– créer, éditer et enregistrer des scripts,

– construire des interfaces de masque

personnalisées,

– assigner des scripts aux icônes de la

barre d’outils ou aux menus,

– exécuter automatiquement les scripts

lorsque certains évènements se

produisent,

– créer des scripts plus facilement et de

façon plus fiable grâce au support de

Python 2.5.

■ Utilisez l’automatisation pour :

– intégrer PASW Statistics à d’autres

applications bureautiques,

– construire des applications

personnalisées avec Visual Basic®,

PowerBuilder® et C++,

– intégrer PASW Statistics à d'autres

applications (telles que Word ou Excel).

■ Utilisez la commande HOST pour tirer parti

de la fonction de système d’exploitation de

PASW Statistics. Cette commande permet

aux applications « d’échapper » au système

d’exploitation et d’exécuter d’autres

programmes en synchronisation avec la

session PASW Statistics.

■ Evitez la subdivision des tâches de

syntaxe en créant un projet commun, ou

principal, pour y inclure des transformations

concernant plusieurs projets.

– Gérer mieux les projets, fichiers de

syntaxe et ensembles de données

multiples.

■ Spécifiez des règles de syntaxe interactives

avec la commande INSERT.

■ Créez facilement de la syntaxe avec l’Editeur

de syntaxe de commande et ses nouvelles

fonctions :

– Remplissage automatique (auto-

completion),

– Codage de couleur de la syntaxe,

– Codage d’erreur de la syntaxe,

– Gouttière pour afficher les numéros de

lignes et les points de rupture,

– Parcours étape par étape des tâches de

syntaxe,

– Auto-indentation.

■ Custom Dialog Builder permet de créer des

interfaces définies par l’utilisateur pour les

procédures existantes et les procédures

définies par l’utilisateur.

■ PASW SmartReader permet de partager

la sortie de PASW Statistics avec les

utilisateurs qui ne possèdent pas PASW

Statistics Base.

Capacités graphiques

■ Graphiques catégoriques

– Barres 3D : Simples, clusters, empilées

– Barres : Simples, clusters, empilées avec

ombre projetée et 3D

– Courbes : Simples, multiples et drop-lines

– Secteurs : Simples et empilés

– Aires : Simples, éclatées et 3D

■ Graphiques boursiers : max-min-clôture,

zone de différence et barre d’étendue

– Surfaces : Simples et clusters

– Barres d’erreur : Simples et clusters

– Barres d’erreur : Ajoutez des barres

d’erreur aux diagrammes à barres, aux

courbes et aux secteurs ; niveau de

confiance ; écart type et erreur standard

– Double axe Y et superposition

■ Nuages de points

– Simples, groupés, matrices de nuage de

points et 3D,

– Courbes d’ajustement : linéaires,

quadratiques ou régression cubique et

lissage LOWESS ; contrôle de l’intervalle

de confiance pour le total ou pour les

sous-groupes et étiquette des données,

– Représentation par couleur ou taille de

repère pour éviter les chevauchements.

■ Graphiques de densité

– Pyramides de population : axe en miroir

pour comparer les répartitions ; avec ou

sans courbe de Gauss,

– Graphiques à points : les points empilés

montrent la distribution ; symétrique,

empilé et linéaire,

– Histogrammes : avec ou sans courbe

de Gauss ; options de regroupement

(binning) personnalisés.

■ Graphiques de contrôle de qualité

– Pareto,

– X-Bar,

– Plage,

– Sigma,

– Individuels,

– Plage mobile,

– Le contrôle des optimisations de

graphique inclut le repérage automatique

des points qui violent les règles Shewhart,

la capacité à désactiver les règles et la

capacité à supprimer des graphiques.

5

Ces fonctions sont susceptibles d’être modifiées en fonction de la version finale du produit. Ce symbole indique une nouvelle fonction.

■ Graphiques de diagnostic et graphiques

exploratoires

– Graphes de cas et graphes de séries

temporelles,

– Graphes de probabilité,

– Graphes des fonctions d’autocorrélation

partielle et d’autocorrélation,

– Graphes de fonction de corrélation

croisée,

– Caractéristiques ROC (Receiver-Operating

Characteristics).

■ Graphiques à usage multiple

– Graphiques à courbes 2D (les deux axes

peuvent être des axes d’échelle),

– Graphiques pour des ensembles à

réponses multiples.

■ Graphiques personnalisés

– Graphics Production Language (GPL),

langage de création de graphiques

personnalisés, permet aux utilisateurs

avancés de disposer d’une gamme

plus vaste de possibilités en termes de

graphiques et d’options.

■ L’intégration de Graphboard permet

d’accéder aux modèles de graphique créés

dans PASW Viz Designer via PASW Statistics

Base.

■ Options d’édition

– Réagencez automatiquement les

catégories selon un ordre différent

(croissant ou décroissant) ou à l’aide de

méthodes de tri différentes (valeur, libellé

ou statistique résumée).

– Créez des libellés de valeur pour les

données.

– Déplacez les éléments vers toute position

du graphique, ajoutez des lignes de

connexion et faites correspondre la

couleur de la police au sous-groupe.

– Sélectionnez et éditez des éléments

spécifiques directement à l’intérieur d’un

graphique : couleurs, texte et styles.

– Choisissez à partir d’une vaste gamme de

styles et d’épaisseurs de ligne.

– Affichez des quadrillages, des lignes de

référence, des légendes, des titres, des

notes de bas de page et des annotations.

– Insérez une ligne de référence Y=X.

■ Options de présentation

– Graphiques en panneaux : créez un

tableau des graphiques secondaires,

un panneau par niveau ou condition,

montrant plusieurs lignes et colonnes.

– Effets 3D : rotation, modification de la

profondeur et affichage des arrière-plans.

■ Modèles de graphiques

– Enregistrez les caractéristiques

sélectionnées d’un graphique et

appliquez-les automatiquement à

d’autres graphiques. Vous pouvez

appliquer les attributs suivants au

moment de la création ou de l’édition :

mise en page, titres, notes de bas de

page et annotations, styles d’éléments de

tableau, styles d’éléments de données,

plages d’échelle des axes, paramètres

d’échelle des axes, courbes d’ajustement

et de référence et nuage de points avec

point binning.

– Présentation sous forme d’arborescence

et contrôle plus fin des groupes de

modèles.

■ Exportation de graphiques : BMP, EMF, EPS,

JPG, PCT, PNG, TIF et WMF

■ Utilitaire de conversion IGRAPH pour

ouverture des fichiers dans SPSS 15.0 et les

versions antérieures

Analyse

Statistiques descriptives

Rapports

■ Avec les cubes OLAP vous pouvez :

– estimer rapidement les changements

au niveau de la moyenne ou de la

somme de deux variables reliées en

utilisant le changement de pourcentage.

Par exemple, visualisez facilement la

façon dont les ventes augmentent d’un

trimestre à l’autre.

– créer des résumés de cas.

– créer des résumés de rapport.

– Générer des rapports de type présentation

à l’aide de nombreuses options de

formatage.

– Générer des listes de cas et des rapports

résumés de cas avec des statistiques

pour les sous-groupes.

Guide de codification (codebook)

■ Contrôlez les informations variables incluses

dans les résultats : position, libellé, type,

format, niveau de mesure, libellés de

valeur, valeurs manquantes, attributs

personnalisés, attributs réservés.

■ Contrôlez l’ordre des informations sur

les fichiers dans les résultats : nom,

emplacement, nombre de cas et libellé de

fichier, attributs personnalisés définis par

l’utilisateur, texte des fichiers de données,

nombre d’octets, attributs de fichier de

données réservés

■ Contrôlez les statistiques résumées : nombre

de cas dans chaque catégorie, pourcentage

de cas dans chaque catégorie, moyenne,

écart type, quartile.

■ Contrôlez l’ordre d’affichage : ordre des

fichiers, ordre alphabétique par nom de

variable, ordre dans lequel les variables et

les jeux de réponses multiples sont listés

dans la commande, niveau de mesure, nom

d’attribut personnalisé défini par l’utilisateur

et valeur.

Fréquences

■ Tables de fréquence : décomptes de

fréquence, pourcentage, pourcentage valide

et pourcentage cumulatif

■ Option de classement de la sortie par

analyse ou par table

■ Tables de sortie plus compactes

par élimination des lignes de texte

supplémentaires lorsqu’elles ne sont pas

nécessaires

■ Tendance centrale : moyenne, médiane,

mode et somme

■ Dispersion : maximale, minimale, étendue,

écart type, erreur standard et variance

■ Distribution : Kurtosis, erreur standard

Kurtosis, asymétrie et erreur standard

d’asymétrie

■ Valeurs percentiles : percentiles (basés

sur les données effectives ou groupées),

quartiles et groupes égaux

■ Affichage de format : condensé ou standard,

trié par fréquence ou par valeurs, ou index

de tables

■ Graphiques : à barres, histogramme ou en

secteurs

Descriptifs

■ Tendance centrale : moyenne et somme

■ Dispersion : maximum, minimum, étendue,

écart type, erreur standard et variance

■ Distribution : Kurtosis, erreur standard

Kurtosis, asymétrie et erreur standard

d’asymétrie

■ Scores Z : calculez et enregistrez en tant que

nouvelles variables

6

■ Ordre d’affichage : croissant ou décroissant

sur les moyennes et les noms de variable

Explorer

■ Les intervalles de confiance pour les

moyennes

■ Descriptifs : étendue interquartile, Kurtosis,

erreur standard Kurtosis, moyenne,

médiane, maximum, minimum, étendue,

asymétrie, erreur standard asymétrie, écart

type, erreur standard, variance, moyenne

lissée 5% et pourcentages

■ Estimateurs M : estimateur d’ondes

de Andrew, estimateur M de Hampel,

estimateur M de Huber et estimateur

‘biweight’ de Tukey

■ Valeurs extrêmes et aberrances identifiées

■ Tables de fréquences groupées : centre de

classe, fréquence, pourcentage, pourcentage

valide et cumulatif

■ Graphes : construisez des graphes avec une

échelle uniforme ou une dépendance par

rapport aux valeurs des données

– A surfaces : variables dépendantes et

niveaux de facteur simultanément

– Descriptifs : histogrammes et graphes «

tige et feuille »

– Normalité : graphes de probabilité

normale et graphes de probabilité

redressée avec les statistiques

Kolmogorov-Smirnov et Shapiro-Wilk

– Graphes étalés contre graphes de niveau

avec le test de Levene : estimation

de puissance, transformée ou non

transformée

– Le test de normalité de Shapiro-Wilk dans

EXAMINE, autorise 5 000 cas lorsque les

poids ne sont pas spécifiés

Tableaux croisés

■ Les relations à triple entrée dans les

données catégoriques avec les statistiques

de Cochran et Mantel-Haenszel, permettent

d’aller au-delà des limites d’un tableau à

double entrée

■ Décomptes : fréquences observées et

prévues

■ Pourcentages : colonne, ligne et total

■ Variables de chaîne longue

■ Valeurs résiduelles : brutes, standardisées et

standardisées ajustées

■ Valeurs marginales : fréquences observées

et pourcentages totaux

■ Tests d’indépendance : Khi-carré corrigé

de Pearson et Yates, Khi-carré avec taux de

vraisemblance et test exact de Fisher

■ Test d’association linéaire : Khi-carré de

Mantel-Haenszel

■ Mesure d’association linéaire : Pearson r

■ Mesures des données nominales :

coefficient de contingence, V de Cramer,

Phi, Lambda de Goodman et Kruskal

(asymétrique et symétrique), Tau (en

fonction des colonnes ou des lignes) et

coefficient d’incertitude (asymétrique et

symétrique)

■ Mesures des données ordinales : Gamma

de Goodman et Kruskal, Tau-b et Tau-c

de Kendall, D de Somers (asymétrique et

symétrique) et Rho de Spearman

■ Nominale par mesure d’intervalle : Eta

■ Mesure d’agrément : Kappa de Cohen

■ Estimations du risque relatif pour le contrôle

des cas et les études de cohorte

■ Affichage des tables en ordre croissant ou

décroissant

■ Décomptes de fréquence écrits vers un

fichier

■ Test de McNemar

■ Option d’utilisation de coefficients de

pondération entiers ou non entiers

Statistiques de ratio descriptives

■ Aident à comprendre vos données grâce à :

– Coefficient de dispersion

– Coefficient de variation

– Différentiel associé au prix (PRD)

– Déviance absolue moyenne

Comparer les moyennes

Moyennes

■ Créez de meilleurs modèles avec des

moyennes harmoniques et géométriques

■ Cellules : nombre, moyenne, écart type,

somme et variance

■ Totaux à entrées multiples

■ Mesure de l’analyse avec Eta et Eta2

■ Test de linéarité avec R et R2

■ Résultats affichés dans des formats

de rapports, de tableaux croisés ou

d’arborescence

■ Statistiques calculées pour le test t

d’échantillon total

■ Un test t d’échantillon pour comparer la

moyenne de l’échantillon à une moyenne de

référence de votre choix

■ Statistiques d’échantillon indépendantes

: comparez les moyennes d’échantillon

de deux groupes pour les estimations de

variance groupées et séparées avec le test

de Levene pour les variances égales

■ Statistiques d’échantillon par paire :

corrélation entre les paires, différences

entre les moyennes et probabilité à deux

possibilités pour le test d’absence de

différence et pour le test de corrélation zéro

entre les paires

■ Statistiques : intervalles de confiance,

décomptes, degrés de liberté, moyenne,

probabilité à deux possibilités, écart type,

erreurs standard et statistique t

Analyse de variance simple

■ Contrastes : linéaires, quadratiques,

cubiques, d’ordre supérieur et définis par

l’utilisateur

■ Tests d’étendue : Duncan, LSD, Bonferroni,

Student-Newman-Keuls, Scheffé, test alterné

de Tukey et HSD de Tukey

■ Tests post hoc : Student-Newman-Keuls,

différence honnêtement significative

de Tukey, b de Tukey, procédure de

comparaison multiple de Duncan basée

sur le test de l’étendue de Student, test t

de comparaison multiple de Scheffe, test t

à deux possibilités de Dunnett, test t à une

possibilité de Dunnett, test t de Bonferroni,

test t de différence la moins significative,

test t de Sidak, GT2 de Hochberg, test

des comparaisons par paire de Gabriel

basé sur le test de modulus maximum de

Student, procédure descendante multiple

de Ryan-Einot-Gabriel-Welsch basée sur un

test F, procédure descendante multiple de

Ryan-Einot-Gabriel-Welsch basée sur le test

d’étendue de Student, T2 de Tamhane,

T3 de Tamhane, test de comparaison par

paires de Games et Howell basé sur le

test d’étendue de Student, C de Dunnett,

test t de Waller-Duncan

■ Statistiques analyse de variance : entre et à

l’intérieur de sommes de carrés de groupes,

degrés de liberté, carrés moyens, ratio F et

probabilité de F

■ Mesures à effets fixes : écart type, erreur

standard et intervalle de confiance 95

pour-cent

■ Mesures d’effets aléatoires : estimation des

composants de variance, erreur standard, et

intervalles de confiance 95 pour-cent

7

Ces fonctions sont susceptibles d’être modifiées en fonction de la version finale du produit. Ce symbole indique une nouvelle fonction.

■ Statistiques descriptives de groupe :

maximum, moyenne, minimum, nombre de

cas, écart type, erreur standard et intervalle

de confiance 95 pour-cent

■ Homogénéité du test de variance : test de

Levene

■ Matrices de lecture et d’écriture

■ Egalité des moyennes : obtenez des

résultats précis lorsque les variances et les

tailles d’échantillon varient entre différents

groupes :

– Test Brown-Forsythe

– Test Welch

Modèles analyse de variance – factoriel simple

■ Créez des modèles personnalisés sans limite

quant à l’ordre d’interaction maximum

■ Travaillez plus rapidement sans avoir à

spécifier les étendues des niveaux de facteur

■ Choisissez le bon modèle en utilisant quatre

types de somme de carrés

■ Augmentez la certitude avec une meilleure

gestion des données dans les cellules vides

■ Exécutez des tests ‘lack-of-fit’ (absence

d’ajustement) pour sélectionner votre

meilleur modèle

■ Choisissez entre deux plans : équilibré ou

non équilibré

■ Utilisez l’analyse de covariance avec jusqu’à

10 méthodes covariables : expérimentale

classique, hiérarchique et régression

■ Entrez le contrôle des covariables : avant,

avec ou après les effets principaux

■ Définissez l’interaction pour : néant, 2, 3, 4,

ou 5 entrées

■ Choisissez parmi les statistiques suivantes

: Analyse de variance, moyennes et tableau

de décomptes, analyse de classification

multiple, coefficients de régression non

standardisés et moyennes de cellules à n

entrées.

■ Choisissez jusqu’à 10 variables

indépendantes

■ Obtenez les valeurs prédites et les

déviations par rapport à la moyenne dans un

tableau MCA

Corréler†

Avec deux variables (Bivariate)

■ r Pearson, Tau-b de Kendall et Spearman

■ Probabilités à une et deux possibilités

■ Moyennes, nombre de cas non manquants

et écarts types

■ Déviations et covariances entre les produits

■ Coefficients affichés au format matrice

ou série

Partiel†

■ Probabilités à une et deux possibilités

■ Moyenne, nombre de cas manquants et

écart type

■ Corrélations d’ordre zéro

■ Jusqu’à 100 variables de contrôle

■ Jusqu’à cinq valeurs d’ordre

■ Corrélations affichées au format de matrice

ou de chaîne série, matrice de corrélation

triangulaire inférieure ou rectangulaire

Distances

■ Calculez les proximités entre les cas ou les

variables

■ Mesures de dissimilarité

– Mesure d’intervalle : euclidien et

distance euclidienne au carré, mesure de

distance Chebychev, distance city-block

ou Manhattan, distance en mesure de

puissance Minkowski absolue et distance

personnalisée.

– Mesures de décomptes : Khi-carré et

Phi-carré

– Mesures binaires : euclidienne et distance

euclidienne au carré ; taille, modèles

et différence de formes ; mesure de

dissimilarité de variance et mesure non

métrique de Lance et Williams

■ Mesures de similarité

– Mesures d’intervalle : corrélation de

Pearson et cosinus

– Mesures binaires : Russell et Rao ;

concordance simple ; Jaccard ; dé (ou

Czekanowski ou Sorenson) ; Rodgers

et Tanimoto ; Sokal et Sneath 1 à 5 ;

Kulczynski 1 et 2 ; Hamann ; Goodman

et Krusal Lambada ; D de Anderberg

; coefficient de colligation de Yule ;

Coefficient Q de Yule ; Ochiai ; mesure de

similarité de dispersion et coefficient de

corrélation phi

■ Valeurs de données standardisées : scores

Z, étendue de –1 à 1, étendue de 0 à 1,

magnitude maximum de 1, moyenne de 1

et écart type de 1

■ Mesures de transformation : valeurs

absolues, dissimilarités en similarités,

similarités en dissimilarités et valeurs de

proximité de redimensionnement pour une

étendue de 0 à 1

■ Spécification de variable d’identification

■ Matrice imprimée des proximités entre les

éléments

■ Evolutivité améliorée pour les proximités

entre les matrices de variables

Régression – régression linéaire*

■ Méthodes : élimination arrière, entrée

forcée, suppression forcée, entrée avant,

sélection par étapes avant et changement

R2 /test de signification

■ Statistiques d’équation : critère

d’information Akaike (AIC), critère de

prédiction d’Ameniya, tableaux d’analyse

de variance (F, carré moyen, probabilité

de F, régression et valeur résiduelle de

somme des carrés), changement dans R2,

test F à l’étape, Cp de Mallow, R multiple,

probabilité de F, R2, R2 ajusté, Critère

Bayésien de Schwartz (SBC), erreur standard

d’estimation, algorithme SWEEP et matrice

variance-covariance

■ Statistiques descriptives : matrice de

corrélation, matrice de covariance,

déviations de produit vectoriel par rapport

à la moyenne, moyennes, nombre de cas

utilisés pour calculer les coefficients de

corrélation, probabilités de coefficients de

corrélation à une possibilité, écarts types et

variances

■ Statistiques des variables indépendantes :

coefficients de régression, dont B, erreurs

standard des coefficients, coefficients de

régression standardisés, erreur standard

approchée des coefficients de régression

standardisés, et t ; tolérances ; ordre

zéro ; corrélations partielles ; intervalle

de confiance 95% pour le coefficient de

régression non standardisé

■ Variables non présentes dans l’équation :

Beta ou tolérance minimale

■ Durbin-Watson

■ Diagnostics de colinéarité : indices de

condition, racines caractéristiques, facteurs

d’inflation de variance, proportions de

variances et tolérances

■ Graphes : de cas, histogramme, probabilité

normale, normale redressée, partielle,

aberrance et nuage de points

8

■ Créer et enregistrer des variables :

– Intervalles de prédiction : moyen et

individuel

– Valeurs prédites : non standardisées,

standardisées, ajustées et erreur de

moyenne standard

– Distances : distances de Cook, distance

de Mahalanobis et valeurs levier

– Valeurs résiduelles : non standardisées,

standardisées, de Student, supprimées,

et de Student supprimées

– Statistiques d’influence : dfbetas, dfbetas

standardisé, dffits, dffits standardisé et

rapports de covariance

■ Contrôles d’option : F-to-enter, F-to-remove,

probabilité de F-to-enter, probabilité de

F-to-remove, supprimer la constante, poids

de régression pour le modèle des moindres

carrés pondérés, intervalles de confiance,

nombre maximum d’étapes, remplacer les

valeurs manquantes par la moyenne des

variables, tolérance

■ Coefficients de régression affichés selon

l’ordre défini par l’utilisateur

■ Les fichiers système peuvent contenir des

estimations de paramètres et leurs matrices

de covariance et de corrélation via la

commande OUTFILE.

■ Les solutions peuvent être appliquées à de

nouveaux cas ou utilisées dans d’autres

analyses.

■ La prise de décision peut être optimisée

pour toute l’entreprise en exportant les

modèles via XML.

Régression ordinale – PLUM†

■ Prédire les résultats ordinaux

– Sept options pour contrôler l’algorithme

itératif utilisé pour l’estimation, pour

spécifier la tolérance numérique pour

la vérification de singularité et pour

personnaliser la sortie

– Cinq fonctions de liens pour spécifier le

modèle : Cauchit, log-log complémentaire,

logit, log-log négatif et probit

– Sous-commande de localisation pour

spécifier le modèle de localisation

: interception, effets principaux,

interactions, effets imbriqués, effets

imbriqués à plusieurs niveaux,

imbrication dans une interaction,

interactions parmi les effets imbriqués

et covariables

– Impression : information de cellule,

matrice de corrélation asymptotique des

estimations de paramètres, statistiques «

goodness-of-fit » (qualité de l’ajustement),

historique d’itération, noyau de la fonction

log-likelihood, test d’hypothèse de lignes

parallèles, statistiques de paramètres et

résumé de modèle

– Enregistrez les statistiques de post-

estimation de cas dans le fichier actif

: probabilités prévues de facteur de

classification/modèles de covariables

dans les catégories de réponse et

catégories de réponse avec la probabilité

prévue maximum pour les modèles de

facteur/covariable.

– Personnalisez vos tests d’hypothèse en

spécifiant directement des hypothèses

nulles comme combinaisons linéaires des

paramètres avec la sous-commande TEST

(syntaxe uniquement).

Estimation de courbe

■ Onze types de courbes disponibles

■ Affichages de résumé de régression : type

de courbe, coefficient R2, degrés de liberté,

test F général et niveau de signification, et

coefficients de régression

■ Modèles de tendance-régression : linéaires,

logarithmiques, inverses, quadratiques,

cubiques, composés, puissance, S,

croissance, exponentiels, et logistiques

Tests non-paramétriques

■ Khi-carré : spécifiez l’étendue prévue (en

fonction des données ou spécifié par

l’utilisateur) et les fréquences (toutes

les catégories égales ou spécifiées par

l’utilisateur)

■ Binomial : définissez la dichotomie (en

fonction des données ou des points de

rupture) et spécifiez la proportion de test

■ Séquences : spécifiez les points de rupture

(médian, mode, moyenne ou spécifié)

■ Un échantillon : Kolmogorov-Smirnov,

uniforme, normal et Poisson

■ Deux échantillons indépendants : séquences

Mann-whitney U, Kolmogorov-Smirnov Z,

Moses extreme et Wald-Wolfowitz

■ Echantillons k indépendants : Kruskal-Wallis

H et median

■ 2 échantillons reliés : Wilcoxon, signe et

McNemar

■ Echantillons k reliés : Friedman, Kendall W

et Cochran Q

■ Descriptifs : maximum, moyenne, minimum,

nombre de cas et écart type

Réponses multiples

■ Tableaux à double entrée : nombre de

cellules, pourcentages de cellules en

fonction des cas ou des réponses, colonne

et ligne, et pourcentages de tableau à

double entrée

■ Tables de fréquence : décomptes,

pourcentage de cas ou réponses

■ La dichotomie multiple et les groupes de

réponse multiples peuvent tous deux être

gérés.

Réduction de données

Facteur*

■ Le nombre de cas et les libellés de variable

pour l’analyse peuvent être affichés

■ Entrée provenant de matrice de corrélation,

facteur, matrice de pondération, matrice de

covariance ou fichier de cas avec données

brutes

■ Sortie de matrice de corrélation ou de

matrice de facteur

■ Sept méthodes d’extraction à utiliser lorsque

l’analyse est exécutée sur des matrices

de corrélation ou des fichiers de données

brutes : composant principal, axe principal,

mise en facteur Alpha, mise en facteur

image, vraisemblance maximum, moindres

carrés non pondérés et moindres carrés

généralisés

■ Méthodes de rotation : Varimax, equamax,

quartimax, promax et oblimin

■ Affichage : communautés initiales et

finales, racines caractéristiques, variance

de pourcentage, pondérations de facteur

sans rotation, matrice de modèles de facteur

avec rotation, matrice de transformation de

facteur, structure de facteur et matrice de

corrélation (rotations obliques uniquement)

■ Les matrices de covariance peuvent être

analysées avec trois méthodes d’extraction :

composant principal, axe principal et image

■ Positions sur un facteur : régression, Bartlett

et Anderson-Rubin

■ Positions sur un facteur enregistrées en tant

que variables actives

9

† Algorithme multithread donnant des performances et une évolutivité optimisées sur les machines multiprocesseur ou multicoeur.

Ces fonctions sont susceptibles d’être modifiées en fonction de la version finale du produit. Ce symbole indique une nouvelle fonction.

6

6

7

7

8

8

9

9

1

/

9

100%