Le polycopié du cours

Principes des langages de programmation

INF 321

Eric Goubault

14 juin 2012

2

Table des mati`eres

1 Introduction 7

2 Programmation imp´erative 11

2.1 Variables et types . . . . . . . . . . . . . . . . . . . . . . . . . . . 11

2.2 Codage des nombres . . . . . . . . . . . . . . . . . . . . . . . . . 13

2.3 Expressions arithm´etiques . . . . . . . . . . . . . . . . . . . . . . 14

2.4 Instructions.............................. 14

2.5 S´emantique ´el´ementaire . . . . . . . . . . . . . . . . . . . . . . . 14

2.6 Lestableaux ............................. 16

2.7 S´emantique des r´ef´erences . . . . . . . . . . . . . . . . . . . . . . 17

2.8 La s´equence d’instructions . . . . . . . . . . . . . . . . . . . . . . 18

2.9 Conditionnelles . . . . . . . . . . . . . . . . . . . . . . . . . . . . 19

2.10 It´eration - la boucle . . . . . . . . . . . . . . . . . . . . . . . . . 20

2.11Fonctions ............................... 21

2.12 Passage d’arguments aux fonctions . . . . . . . . . . . . . . . . . 21

2.13 Variables locales, variables globales . . . . . . . . . . . . . . . . . 24

2.14 R´ef´erences, pointeurs, objets . . . . . . . . . . . . . . . . . . . . 26

2.15 Un peu de syntaxe . . . . . . . . . . . . . . . . . . . . . . . . . . 32

3 Structures de donn´ees 35

3.1 Types produits, ou enregistrements . . . . . . . . . . . . . . . . . 35

3.2 Le ramasse-miette, ou GC . . . . . . . . . . . . . . . . . . . . . . 37

3.3 Enregistrements et appels de fonctions . . . . . . . . . . . . . . . 38

3.4 Lestableaux ............................. 39

3.5 Egalit´e physique et ´egalit´e structurelle . . . . . . . . . . . . . . . 42

3.6 Partage ................................ 43

3.7 Typessomme............................. 45

3.8 Types de donn´ees dynamiques . . . . . . . . . . . . . . . . . . . . 48

3.9 Les listes lin´eaires . . . . . . . . . . . . . . . . . . . . . . . . . . 50

3.10 Application aux tables de hachage... . . . . . . . . . . . . . . . . 51

3.11 Listes et partage . . . . . . . . . . . . . . . . . . . . . . . . . . . 53

3

4TABLE DES MATI `

ERES

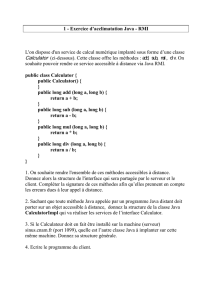

4 Programmation orient´ee objet, en JAVA 57

4.1 Statique versus dynamique . . . . . . . . . . . . . . . . . . . . . 57

4.2 Types somme, revisit´es . . . . . . . . . . . . . . . . . . . . . . . . 60

4.3 H´eritage................................ 61

4.4 Exceptions .............................. 63

4.5 Interfaces ............................... 65

4.6 H´eritage et typage . . . . . . . . . . . . . . . . . . . . . . . . . . 65

4.7 Classes abstraites . . . . . . . . . . . . . . . . . . . . . . . . . . . 66

4.8 Paquetages .............................. 67

4.9 Collections .............................. 68

4.10 Les objets en (O)Caml . . . . . . . . . . . . . . . . . . . . . . . . 68

5 R´ecursivit´e, calculabilit´e et complexit´e 69

5.1 La r´ecursivit´e dans les langages de programmation . . . . . . . . 69

5.2 Piled’appel.............................. 70

5.3 R´ecurrence structurelle . . . . . . . . . . . . . . . . . . . . . . . . 74

5.4 Partage en m´emoire et r´ecursivit´e . . . . . . . . . . . . . . . . . . 76

5.5 Les fonctions r´ecursives primitives . . . . . . . . . . . . . . . . . 78

5.6 Fonctions r´ecursives partielles . . . . . . . . . . . . . . . . . . . . 80

5.7 Pour aller plus loin . . . . . . . . . . . . . . . . . . . . . . . . . . 81

5.8 Quelques ´el´ements en complexit´e . . . . . . . . . . . . . . . . . . 82

6 S´emantique d´enotationnelle 89

6.1 S´emantique ´el´ementaire . . . . . . . . . . . . . . . . . . . . . . . 89

6.2 Probl`emes de points fixes . . . . . . . . . . . . . . . . . . . . . . 91

6.3 S´emantique de la boucle while ................... 95

6.4 S´emantique des fonctions r´ecursives . . . . . . . . . . . . . . . . . 96

6.5 Continuit´e et calculabilit´e . . . . . . . . . . . . . . . . . . . . . . 97

7 Logique, mod`eles et preuve 99

7.1 Syntaxe ................................ 99

7.2 S´emantique ..............................100

7.3 D´ecidabilit´e des formules logiques . . . . . . . . . . . . . . . . . . 102

7.4 Pour aller plus loin... . . . . . . . . . . . . . . . . . . . . . . . . . 103

7.5 Un peu de th´eorie de la d´emonstration . . . . . . . . . . . . . . . 103

8 Validation et preuve de programmes 109

8.1 La validation, pour quoi faire ? . . . . . . . . . . . . . . . . . . . 109

8.2 Preuve `a la Hoare . . . . . . . . . . . . . . . . . . . . . . . . . . 111

9 Typage, et programmation fonctionnelle 117

9.1 PCF (non typ´e) . . . . . . . . . . . . . . . . . . . . . . . . . . . . 117

9.2 S´emantique op´erationnelle . . . . . . . . . . . . . . . . . . . . . . 118

9.3 Ordres d’´evaluation . . . . . . . . . . . . . . . . . . . . . . . . . . 121

9.4 Appel par nom, appel par valeur et appel par n´ecessit´e . . . . . . 121

9.5 Combinateurs de point fixe . . . . . . . . . . . . . . . . . . . . . 123

TABLE DES MATI `

ERES 5

9.6 Typage ................................ 125

9.7 Th´eorie de la d´emonstration et typage . . . . . . . . . . . . . . . 128

9.8 Pour aller plus loin . . . . . . . . . . . . . . . . . . . . . . . . . . 131

10 Programmation r´eactive synchrone 133

10.1 Introduction . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 133

10.2Lustre .................................133

10.3 Calcul d’horloges . . . . . . . . . . . . . . . . . . . . . . . . . . . 137

10.4 Pour aller plus loin... . . . . . . . . . . . . . . . . . . . . . . . . . 138

10.5 R´eseaux de Kahn et s´emantique de Lustre . . . . . . . . . . . . . 138

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

34

34

35

35

36

36

37

37

38

38

39

39

40

40

41

41

42

42

43

43

44

44

45

45

46

46

47

47

48

48

49

49

50

50

51

51

52

52

53

53

54

54

55

55

56

56

57

57

58

58

59

59

60

60

61

61

62

62

63

63

64

64

65

65

66

66

67

67

68

68

69

69

70

70

71

71

72

72

73

73

74

74

75

75

76

76

77

77

78

78

79

79

80

80

81

81

82

82

83

83

84

84

85

85

86

86

87

87

88

88

89

89

90

90

91

91

92

92

93

93

94

94

95

95

96

96

97

97

98

98

99

99

100

100

101

101

102

102

103

103

104

104

105

105

106

106

107

107

108

108

109

109

110

110

111

111

112

112

113

113

114

114

115

115

116

116

117

117

118

118

119

119

120

120

121

121

122

122

123

123

124

124

125

125

126

126

127

127

128

128

129

129

130

130

131

131

132

132

133

133

134

134

135

135

136

136

137

137

138

138

139

139

140

140

1

/

140

100%