de von neumann aux super-microprocesseurs

1

Texte de la 248e conférence de l'Université de tous les savoirs donnée le 4 septembre

2000.

DE VON NEUMANN AUX SUPER-MICROPROCESSEURS

Par François Anceau

Histoire des machines informatiques

L'histoire des machines à traiter l'information est une saga qui trouve ses racines loin dans

l'histoire et qui se poursuit actuellement avec un rythme très rapide. Pour remonter aux

origines, nous diviserons cette histoire en trois grandes périodes.

La préhistoire

Ce qui va donner l'informatique peut être vu comme la convergence de trois courants :

- La notion d'algorithme. Celle-ci prend ses racines dans l'Antiquité. Elle a été formulée en

Perse dès le IXe siècle par Al Khowarizmi. Elle consiste à décrire précisément les

processus nécessaires à la réalisation des calculs complexes. Cette notion ne sera

réellement formalisée que onze siècles plus tard par Alan Turing en 1936 et

Alonzo Church en 1944.

- La mécanisation des opérations de calcul qui a débuté au XVIIe siècle avec les travaux de

Wilhelm Schickard en 1623, la série des Pascalines de Blaise Pascal en 1642 puis la

machine à effectuer les multiplications de Gottfried Wilhelm Leibniz en 1694.

- La programmation. Celle-ci est vraisemblablement apparue au Moyen Âge pour les

carillons automatiques dans lesquels un tambour muni de picots déclenchait une séquence

de frappes sur les cloches. Cette technologie s'est ensuite développée pour l'animation des

automates et la commande des métiers à tisser automatiques (Basile Bouchon 1725,

Jacques de Vaucanson 1745 puis Joseph Marie Jacquard 1810 qui eut l'idée de remplacer

les tambours par des cartes perforées, inventées par Falcon).

La synthèse de ces trois courants fut réalisée par Charles Babbage qui proposa en 1840 les

plans de sa machine analytique. Celle-ci est la première description d'une machine à calculer

programmable. La comtesse Ada de Lovelace a écrit des programmes mathématiques pour

cette machine. Elle fut donc la première programmeuse de l'histoire.

L'Antiquité

Les machines à calculer programmables étaient utilisées pour calculer les tables numériques

civiles et militaires, ainsi que pour effectuer des statistiques. Il s'agissait de réaliser de

manière répétitive des séquences de calculs assez simples sur de grands volumes de données.

La croissance de ces besoins fit passer ces machines de la technologie mécanique à l'électro-

mécanique puis à l'électronique en utilisant des tubes électroniques. Les premières machines à

calculer programmables électroniques furent la machine ABC de John Vincent Atanasoff en

1939 et le calculateur ENIAC réalisé par John Pesper Eckert et John Mauchy en 1947. La

mise en forme de l'algèbre binaire par George Boole en 1847 allait ouvrir la voie à son

utilisation comme base de numération pour les machines. George R. Stibitz bricola le premier

additionneur binaire en 1937 et Konrad Zuse réalisa le premier calculateur binaire

électromécanique programmable en 1938. Pendant ce temps, Alan Turing formalisa la notion

de calcul en 1936 en montrant qu'une telle machine peut être universelle, c'est-à-dire capable

de réaliser n'importe quel calcul (pourvu que l'on lui en laisse le temps et qu'elle dispose de

suffisamment de mémoire).

Cette période s'achève par la proposition de John von Neumann de ranger les programmes

dans la même mémoire que les données. Cette idée sera matérialisée par Eckert et Mauchy

2

(machine BINAC en 1949) puis par Turing (Automatic Computing Engine en 1950) qui

ajoutera la possibilité aux programmes de s'auto-modifier.

Les Temps Modernes

Les premières machines des années 1950 contenaient déjà tous les ingrédients nécessaires à

un ordinateur. Une formidable évolution technologique va leur donner la puissance, la

fiabilité et la miniaturisation que nous leur connaissons. La première de ces mutations va se

produire vers 1960 avec le développement des premiers ordinateurs à transistors au silicium.

Ces composants vont donner à l'ordinateur une fiabilité qui va lui permettre d'être

effectivement utilisé. Le développement des circuits intégrés, dont le premier exemplaire est

dû à Jack Kilby (Texas Instruments) en 1958, va permettre, dès 1965, un nouveau pas dans

l'augmentation de la complexité et de la fiabilité des ordinateurs.

Pendant les années 1960 le statut des ordinateurs va progressivement passer de celui de

machines à effectuer des calculs, jusqu'à celui de traiter de l'information de toute nature. Des

applications comme le traitement de texte et les bases de données vont apparaître. En 1971

Marcian Hoff de chez Intel conçoit le premier processeur monolithique (microprocesseur)

commercial (Intel 4004), c'est-à-dire réalisé sous la forme d'un seul circuit intégré. C'est cette

technologie qui va progressivement se développer pour s'imposer à partir des années 90.

La fantastique évolution des microprocesseurs

À la suite de l'Intel 4004, de nombreux autres modèles de microprocesseurs sont apparus, de

plus en plus puissants et de plus en plus complexes. À partir de cette date, un rythme très

rapide d'évolution s'est installé. Il s'est maintenu sans fléchir jusqu'à aujourd'hui. La

complexité de ces machines monolithiques est passée de 2 800 transistors pour l'Intel 4004 à

plusieurs dizaines de millions pour les microprocesseurs modernes. Pendant la même durée,

leur puissance de traitement est passée de 60 000 instructions exécutées par seconde par

l'Intel 4004 à plus d'un milliard par les machines actuelles les plus puissantes. L'histoire des

microprocesseurs sur les trente dernières années est certainement la plus formidable évolution

technologique de l'histoire humaine, tant en durée qu'en ampleur.

1 000

10 000

100 000

1 000 000

10 000 000

100 000 000

1970 1975 1980 1985 1990 1995 2000 2005

PPC620

I486

nombre de transistors

I4004

I8008

MC6800

I8086

I286

MC68000

MC68020 I386

MC68040

PPC601 Pentium

K6

Pentium II

Celeron

Pentium-Pro

Figure 1 – Évolution de la complexité des microprocesseurs

3

1

10

100

1 000

1984 1986 1988 1990 1992 1994 1996 1998 2000

Millions d'instructions exécutées par seconde

I386/16

I486/25 I486/50

PPC601/66

ALPHA/150

Pentium/66

Pentium/133

PPC604/133

ALPHA/300

Pentium-Pro/133

PPC750/350

Pentium

Figure 2 – Évolution de la performance des microprocesseurs

Ce rythme d'évolution effréné est appelé loi de Moore (du nom du directeur de la compagnie

Intel qui l'a formulée dans les années 1970). Il provient pour moitié de l'évolution

technologique des circuits intégrés et pour l'autre moitié de l'évolution de l'architecture de ces

machines. Les microprocesseurs actuels sont dessinés avec des motifs de 0,18 µm de largeur.

Cette dimension diminue régulièrement depuis plus de trente ans et ce rythme tend même

actuellement à s'accélérer. Si cette évolution se poursuit, nous devrions atteindre, avant la fin

de la décennie, des dimensions pour lesquelles des phénomènes quantiques devraient se

manifester et dégrader le fonctionnement des transistors.

0,01

0,1

1

10

100

1960 1970 1980 1990 2000 2010 2020

Taille des motifs minimaux (microns)

apparition des

pénomènes

quantiques

Figure 3 – Évolution de la technologie des circuits intégrés

Types d'ordinateurs

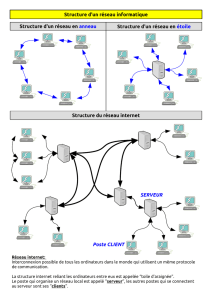

Les ordinateurs peuvent être classés en deux grandes familles suivant que nous connaissons,

ou ignorons, leur existence.

- Les ordinateurs « visibles » qui constituent tout ce que nous appelons ordinateur et surtout

ceux qui se présentent comme des machines universelles, bien qu'ils soient souvent utilisés

de manière spécifique. Ceux-ci peuvent être des ordinateurs personnels ou des stations de

travail, portables ou fixes, des ordinateurs serveurs qui fournissent de l'information sur un

réseau, des ordinateurs de contrôle de processus chargés de piloter des processus

4

industriels (raffinerie, usine automatisée, gros appareils, navires,…), des super-ordinateurs

chargés de résoudre de gros problèmes numériques (prévisions météorologiques,

simulations, ….).

- Des ordinateurs « cachés » qui se présentent comme des composants électroniques évolués

et dont nous ignorons généralement l'existence : surveillance et pilotage de véhicules

(automobiles, trains, avions, fusées), dispositifs de communication et de localisation

(terminaux GSM, répondeurs, GPS), électroménager (chaîne Hi-Fi, magnétoscope,

machine à laver), horlogerie (montres numériques, séquenceurs).

La demande en puissance de calcul des ordinateurs « visibles » semble insatiable. On ne

distingue pas de limite à court terme. Toute application (par exemple un traitement de texte),

peut utiliser des puissances de calcul de plus en plus élevées pour offrir des fonctions dont

nous n'osions même pas rêver il y a seulement quelques années (correction orthographique et

grammaticale en ligne, extraction de sens, génération automatique de texte, entrée vocale, …).

Notre imagination pour ce genre de fonctions semble être sans limite.

Les ordinateurs « cachés » sont de loin les plus nombreux. Ils apportent de l'intelligence aux

objets qui nous entourent et permettent l'occurrence de nouveaux objets inconcevables sans

leur présence (GSM, GPS, …). Ils transforment la nature de beaucoup de métiers en capturant

les connaissances et le savoir-faire qui leur sont associés (par exemple, avec un GPS un

capitaine de navire n'a plus besoin de savoir faire le point astronomique avec un sextant). De

ce fait, ces objets nous deviennent de plus en plus indispensables.

L'ensemble de ces machines influe sur l'évolution de la société. Ils permettent l'interconnexion

des individus et nous donnent accès, via les réseaux, à des informations que nous n'aurions

pas eues autrement. Ceux qui sont cachés transforment subrepticement la nature des objets qui

nous entourent (automobile, électroménager, ….) mais aussi nous écartent de plus en plus de

la connaissance de leur fonctionnement détaillé.

Absorption des gammes d'ordinateur par les microprocesseurs

L'évolution des microprocesseurs se traduit par la mise sur le marché de machines de plus en

plus puissantes, appelées micro-ordinateurs, dont le coût reste au voisinage de 1 000 à

2 000 euros. Lorsque la puissance de ces micro-ordinateurs dépasse celle d'une gamme

traditionnelle d'ordinateurs (généralement de coût plus élevé), celle-ci disparaît et sa fonction

vient s'ajouter à la liste, déjà longue, des applications des micro-ordinateurs. Ce phénomène

s'est d'abord produit pour la gamme des mini-ordinateurs, nés dans la seconde moitié des

années 1960 et absorbés au début des années 1980. De même, les ordinateurs de centre de

calcul, nés avec l'informatique, se sont fait absorber vers le milieu des années 1990. L'histoire

ne s'arrête pas là, car la puissance de calcul des micro-ordinateurs va devenir comparable à

celle des super-ordinateurs avant la fin de la décennie ce qui va provoquer l'absorption de

cette gamme.

Il faut remarquer que ces phénomènes d'absorption ne sont pas recherchés par les concepteurs

des micro-ordinateurs. En effet, ceux-ci visent le marché des applications personnelles et

surtout celui des jeux. Il se trouve que l'amélioration de ceux-ci passe par la capacité de

réaliser des simulations complexes en temps réel et par l'affichage associé de points de vues

mobiles dans un espace tri-dimensionnel. Ces caractéristiques sont très voisines de celles

demandées aux super-ordinateurs.

Structure d'un micro-ordinateur

La technologie micro-électronique fournit des dispositifs pour le traitement de l'information

extrêmement rapides (une transition en quelques centaines de pico-secondes) mais qui sont

aussi beaucoup plus complexes que ceux utilisés pour sa mémorisation (par un facteur de 5 à

50), il est donc naturel de réaliser une unité de traitement sous la forme d'une structure

5

bouclée dans laquelle les informations sont puisées dans des organes de mémorisation pour

être fournies à un organe de transformation, appelé opérateur. Les résultats de l'opération

(très simple) sont ensuite réécrits dans les organes de mémorisation. Cette organisation

bouclée permet de minimiser le matériel nécessaire par une forte réutilisation des opérateurs

dans un fonctionnement séquentiel. Le même matériel est donc utilisé répétitivement pour

toutes les opérations. Le nombre de cycles nécessaires à un traitement « visible » devient très

important. Il transforme la rapidité de la machine en sa puissance de traitement.

éléments de

mémorisation:

- registres

- mémoire

- disp. périph.

éléments

de calcul

données lues

données écrites

très rapides, relativement

volumineux

=> peu nombreux

=> utilisés de manière

sérielle

denses, peu

intelligents,

(adressables)

instructions

Figure 4 – La boucle fondamentale d'exécution

La nature de l'opération à réaliser, ainsi que l'emplacement des opérandes et du résultat sont

décrit par une chaîne de bits appelée une instruction. L'ensemble des instructions nécessaire à

un traitement constitue un programme. Depuis von Neumann, ceux-ci sont rangés dans les

organes de mémorisation.

Hiérarchie mémoire

Les caractéristiques des technologies utilisées pour réaliser les dispositifs de mémorisation

font que leur taille et leur vitesse varient de manière opposée. Plus un élément de

mémorisation est rapide, plus sa taille est réduite. Par exemple, les registres utilisés dans le

processeur ne permettent le stockage que de quelques dizaines ou centaines d'octets mais ils

peuvent être accédés à la vitesse des cycles élémentaires de la boucle de traitement. À

l'opposé, les disques magnétiques peuvent contenir des dizaines de milliards d'octets mais leur

fonctionnement séquentiel limite leur temps d'accès à la dizaine de millisecondes.

vitesse taille

registres

antémémoires

mémoire centrale

disques

unités de stockage

Figure 5 – Hiérarchie des organes de mémorisation

6

6

7

7

8

8

9

9

10

10

11

11

1

/

11

100%