initiation a l`informatique inf z10 cours theorique - Fox XP

Université de Provence

ANNEE UNIVERSITAIRE 2003-2004

INITIATION A L’INFORMATIQUE

INF Z10

1er ou 2e SEMESTRE

COURS THEORIQUE

I

Préliminaires

Le Centre Informatique pour les Lettres et Sciences Humaines (CILSH) offre des

unités d'enseignement en informatique pour un public non-spécialiste. Ces unités

d'enseignement portent sur des technologies de plus en plus nécessaires pour la

plupart des études de lettres et sciences humaines et dont la maîtrise constitue une

compétence appréciée dans le monde professionnel. L’inscription aux unités

d'enseignement en informatique donne accès aux ordinateurs en libre-service du

CILSH, sur lesquels les étudiants pourront effectuer leurs exercices et travaux

personnels, ainsi qu'à Internet.

L'unité d'enseignement INF Z10 - Initiation à l’informatique fournit le bagage minimal que

devrait maîtriser tout étudiant de Lettres et Sciences Humaines :

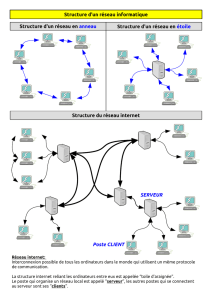

• Concepts fondamentaux (histoire de l'informatique, principe et architecture des

ordinateurs, représentation de l'information, notion de programme, réseaux, etc.) ;

• Internet (savoir naviguer sur le Web et rechercher des informations, utiliser la messagerie

électronique, etc.) ;

• Traitement de texte (présenter correctement un texte, l'enregistrer et le retrouver) ;

• Traitement des données (différents types de données, calculs simples sur des données

numériques, utilité d'un tableur, données sous forme de fiches, requêtes sur des bases de

données) ;

• Informatique et société (réflexion sur l'informatisation croissante de la société).

L'unité d'enseignement INF Z10 se déroule sur un semestre et comporte donc douze séances

de cours en amphi de 1h 30mn et 12 séances de TP de 1h 30mn. Dans le cadre du CTE, ces 12

séances sont regroupées en 6 séquences correspondant aux 6 grands thèmes traités :

- Notions de base

- Fonctionnement de l'ordinateur

- Internet

- Traitement de textes

- Traitement des données

- Programmation (présentation sommaire)

S'y ajoute une conclusion qui se veut une réflexion sur les problèmes de société posés par

l'informatique.

Outre le cours polycopié et les TP correspondants, vous pouvez disposer des cours

Sur Internet, à l'adresse suivante :

http://www.up.univ-mrs.fr/wcilsh/cours_infZ10CTE/index.htm

II

Sur le serveur du CILSH, accessible par les machines du libre-service de la salle C222

et des salles de cours (A276 et C206). Le fichier index.htm (dans poste de travail -cours sur

'serv01' (X) – CTE – INFZ10 CTE – Site Web) vous propose un sommaire identique à celui

qui se trouve sur le Web (si vous ne savez pas réaliser toutes ces opérations, faites d'abord le

TP1).

Bien que l'unité d'enseignement INF Z10 se veuille une initiation à l'informatique en général,

il est préférable, pour la suivre et exécuter les TP, de disposer d'un PC équipé du système

d'exploitation Windows 98 ou 2000. Cette dernière version est celle qui est installée sur les

machines du CILSH, et c’est le plus souvent conformément à elle que seront expliquées les

manipulations.

Travaux pratiques

Les fiches de travaux pratiques ont été conçues pour que les étudiants du CTE puissent

travailler de manière autonome. Les étudiants régulièrement inscrits à l'UE Z10 du CTE

peuvent aller travailler sur les machines du libre service du CILSH (Salle C.222) afin de se

familiariser aux diverses manipulations qui leur sont proposées dans les travaux pratiques.

Evaluation et modalités d'examen

L'unité d'enseignement INF Z10 sera évaluée par un examen de fin de semestre, comportant

cinq questions ouvertes (notées chacune sur 2 points) et 20 questions de type QCM (notées

chacune sur 0,5 point). Les questions porteront sur le cours et le contenu des TP. La durée de

l'épreuve sera de 1h 30mn.

Les étudiants inscrits à la session de février ne peuvent s'inscrire à la session de juin

Les étudiants n'ayant pas obtenu la moyenne à la session de février ou à celle de juin pourront

repasser l'épreuve à la session de septembre.

En cas de nécessité, vous pouvez me contacter par e-mail à l'adresse suivante :

tournier@up.univ-aix.fr

ou par l'intermédiaire du secrétariat du CILSH (Bureau A293)

Bon courage et bon travail !

Votre professeur,

Henri TOURNIER

1

I

Notions de base

1. Définition de l'ordinateur et de l'informatique

Le mot informatique a été proposé par Philippe Dreyfus en 1962 ; c'est un mot-valise, formé

d'information et d'automatique. L'informatique est donc une automatisation de l'information,

plus exactement un traitement automatique de l'information. L'information désigne ici tout

ce qui peut être traité par l'ordinateur (textes, nombres, images, sons, vidéos...).

L'outil utilisé pour traiter l'information de manière automatique s'appelle un ordinateur. Ce

nom a été proposé par Jacques Perret (professeur de latin à la Sorbonne) en 1954. Ce mot était

à l'origine un adjectif qui signifiait "qui met de l'ordre", "qui arrange".

L'anglais, plus restrictif, utilise le terme de computer qui peut se traduire par calculateur,

machine à calculer.

L'informatique désigne donc un concept, une science, tandis que l'ordinateur est un outil, une

machine conçue pour réaliser des opérations informatiques.

2. Histoire de l'informatique (matériel)

Par nature paresseux, l'homme a toujours cherché à simplifier et améliorer sa façon de

calculer, à la fois pour limiter ses erreurs et gagner du temps.

- 1500 av. J.C. ( ?) : le boulier. Il est toujours utilisé dans certains pays.

- en 1641 : la Pascaline (machine à calculer de Blaise PASCAL)

- en 1806 : Métier à tisser à cartes perforées (Joseph-Marie JACQUARD)

- en 1812 : le mathématicien anglais Charles BABBAGE (1792-1871) imagine une machine

capable d'effectuer toute une série d'opérations en séquences. Son projet est celui d'un

visionnaire, mais la machine ne sera jamais terminée.

- en 1937 : le Mark I d'IBM : il permet de calculer 5 fois plus vite que l'homme. Il est

constitué de 3300 engrenages, 1400 commutateurs et 800 km de fil électrique. Les engrenages

seront remplacés en 1947 par des composants électroniques.

- en 1943 : Colossus I : Composé de 1500 lampes et d'un lecteur de bandes capable de lire

5000 caractères à la seconde, ce calculateur électronique anglais a été conçu pour décoder des

messages chiffrés.

- en 1947 : invention du transistor, qui va permettre de rendre les ordinateurs moins

encombrants et moins coûteux.

- en 1948 : UNIVAC (UNIVersal Automatic Computer) : Il utilise des bandes magnétiques

en remplacement des cartes perforées. Il est composé de 5000 tubes, sa mémoire est de 1000

mots de 12 bits, il peut réaliser 8333 additions ou 555 multiplications par seconde. Sa

superficie au sol est de 25m².

- en 1958 : mise au point du circuit intégré, qui permet de réduire encore la taille et le coût

des ordinateurs.

- en 1960 : l'IBM 7000, premier ordinateur à base de transistors.

- en 1972 : l'Intel 4004, premier microprocesseur, voit le jour.

- en 1980 : l'ordinateur familial (oric, sinclair, etc.)

- en 1981 : IBM-PC (Personnal Computer)

Cet ordinateur qui n'apporte aucune idée révolutionnaire est la réaction du numéro un mondial

face à la micro-informatique. Le PC et ses clones (produits de copiage asiatiques) vont

rapidement devenir un standard. Les modèles récents sont adaptés au multimédia. Ils sont de

moins en moins coûteux.

- en 1984 : sortie du Macintosh d'APPLE

2

Aujourd'hui…

les ordinateurs parlent, entendent, voient et se déplacent ! !

Le 01/01/2000…

Ils ont passé sans encombre le cap de l'an 2000…

Et au XXIe siècle…

des ordinateurs qui "pensent" ?

Non ! Ce n’est pas un rêve ! A l’université Georgia Tech d’Atlanta aux Etats-Unis, le

professeur William Ditto et son équipe ont entrepris de fabriquer des ordinateurs qui

réfléchissent par eux-mêmes !

Ils ont extrait des neurones de sangsues (facilement manipulables), les ont plongées dans un

bain nutritif, ont relié les neurones entre eux et les ont branchés sur une puce électronique au

silicium. Ensuite on les excite à l'aide de petites décharges électriques !

Les neurones font office de transmetteurs. Comme les neurones humains, ils sont capables

d’établir des connexions entre eux. La stimulation électrique revient à leur donner des ordres.

Les chercheurs américains partent du principe que les ordinateurs actuels, même les plus

puissants, ne seront jamais aussi intelligents qu’un cerveau vivant. Il faut donc inventer des

ordinateurs capables de penser par eux-mêmes et plus seulement d’exécuter un programme

écrit par l’homme.

Rassurez-vous, ces machines mi-animales mi-électroniques n’attaqueront personne. C’est ce

qu’affirme William Ditto. Mais cette expérimentation de sangsues reliées à des puces ouvre la

voie à une discipline nouvelle : la « bio-informatique ».

Grâce à ce montage à la Frankenstein, le professeur Ditto serait déjà parvenu à faire réaliser

des calculs simples par ses sangsues, des additions basiques du type 2+2 ou 5+3...

3. Architecture de l’ordinateur

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

34

34

35

35

36

36

37

37

38

38

39

39

40

40

41

41

42

42

43

43

44

44

45

45

46

46

47

47

48

48

49

49

50

50

51

51

52

52

53

53

54

54

55

55

56

56

57

57

58

58

59

59

60

60

61

61

62

62

63

63

64

64

65

65

66

66

67

67

68

68

69

69

70

70

71

71

72

72

73

73

74

74

75

75

76

76

77

77

78

78

79

79

80

80

81

81

82

82

83

83

84

84

85

85

86

86

87

87

88

88

89

89

90

90

91

91

92

92

1

/

92

100%