Tableau Mimosa 2016

Chapitre 2

La sélection de variables

Contenu

2.1 Introduction .................................................................................................................... 2

2.2 Problématique ................................................................................................................. 2

2.3 La sélection de variables (Feature selection) .................................................................... 2

2.3.1 Etapes de sélection de variables ...............................................................................3

2.3.2 Les approches de sélection de variables .................................................................... 8

2.4 Base de données............................................................................................................10

2.5 Algorithmes de sélection de l'approche wrapper ...........................................................10

2.6 Critiques sur les algorithmes de sélection ........................................................................... 20

2.7 Etape de classification ................................................................................................... 21

2.8 Résultats ........................................................................................................................ 21

2.9 Discussion ...................................................................................................................... 21

2.10Synthèse sur les techniques de sélection ....................................................................... 21

2.11 Conclusion .................................................................................................................... 21

Dans ce chapitre nous étudions le principe de sélection de variables et les différents

algorithmes de sélection automatique des variables. Nous comparons leur efficacité sur

les données audio et choisissons par la suite un algorithme qui nous permettons

d'atteindre de meilleurs performances de classification.

CHAPITRE 2. La sélection de variables 2

© Yosr NAIJA Avril 2015 © Marwa KAABI

2.1 Introduction

Les technologies de classification automatique ou clastering font partie des méthodes

d'analyse et de fouille de données les plus utilisées. Malgré leur succès incontesté en

analyse de données exploratoire, les techniques de clustering doivent s'adapter à des

volumes de données toujours plus importants. En effet, au fur et à mesure de l'évolution

des technologies de stockage, le volume de données disponibles a progressivement

explosé en nombre d'individus mais aussi en nombre de descripteurs. Nous sommes

donc très souvent confrontés au problème de la malédiction de la dimensionnalité. On

distingue généralement deux types d'approche qui peuvent être utilisée: l'extraction de

caractéristiques (consiste à construire de nouveaux attributs à partir de l'ensemble des

variables originales) et la sélection des variables (permet de ne conserver qu'un sous-

ensemble pertinent de variables). Nous nous intéressons dans ce contexte au approche

de sélection des variables qui permet de sélectionner les variables les plus

représentatives du problème [3].

2.2 Problématique

La sélection de variables joue un rôle très important en classification lorsqu'un grand

nombre p de variables sont disponibles, certaine pouvant être peu significatives,

corrélées ou non pertinents [2]. Elle consiste à sélectionner un sous-ensemble de de

variables. La sélection permet également de faciliter l'étape d'apprentissage et de

réduire la complexité des algorithmes ainsi que les temps de calcul [4].

La sélection non supervisée de caractéristiques reste un problème difficile et lourd en

temps de calcul. Lorsqu'il s'agit de traiter des bases de données de grande taille, qu'il

n'est pas possible d'étiqueter manuellement, il est souhaitable d'avoir des méthodes de

sélection rapides et efficaces.

2.3 La sélection de variables (Feature selection)

la sélection d'attributs est une thématique de recherche assez active depuis plusieurs

décennies et en cours de développement dans divers application [8]. Elle constitue une

étape importante dans le prétraitement des données de grande dimension acheminées

vers la classification supervisée ou non supervisée.

En effet l'apparition des grandes bases de données dans le domaine de l'apprentissage et

les systèmes de fouille de données "Data Mining" a exigé une réduction de dimension,

avant d'entamer la tâche de classification des données.

La sélection des variables est un processus qui consiste à chercher dans l'ensemble des

variables explicatives disponibles un ensemble optimal des caractéristiques les plus

importantes à un système donné.

Définition (Sélection de variable) [9]

CHAPITRE 2. La sélection de variables 3

© Yosr NAIJA Avril 2015 © Marwa KAABI

La sélection de variables est un procédé permettant de choisir un sous-ensemble

optimal de variables pertinentes, à partir d'un ensemble original des variables, selon un

certain critère de performance. En fait, le choix d'un ensemble optimal de descripteurs,

ne signifie pas obligatoirement la sélection d'un ensemble composé seulement des

variables jugées pertinentes et utiles. Il peut y contenir des variables non pertinentes,

mais qui ont de meilleur performance, prises avec d'autres variables. Ainsi la procédure

de sélection de variables tente de sélectionner le sous ensemble le plus petit selon deux

principaux critères:

La précision de la classification ne se dégrade pas

la distribution des classes est proches de la distribution originale.

Algorithme générale de sélection de variables [6]

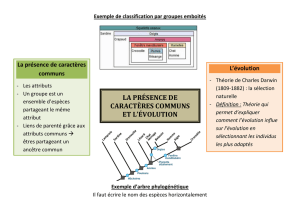

2.3.1 Etapes de sélection d'attributs

La sélection d'attributs est un domaine de recherche actif et en cours de développement

[7]. Selon[10] une procédure de sélection d'attributs est généralement composée de

quatre étapes ( la procédure de génération, la fonction d'évaluation, le critère d'arrêt, la

procédure de validation), illustrées par la figure suivante:

CHAPITRE 2. La sélection de variables 4

© Yosr NAIJA Avril 2015 © Marwa KAABI

2.3.1.1 La procédure de génération

La procédure de génération permet, à chaque itération, de générer un sous-ensemble

d’attributs qui va être évalué lors de la seconde étape de la procédure de sélection.

Cette procédure de génération peut soit commencer avec un ensemble vide d’attributs,

soit avec l’ensemble de tous les attributs, soit avec un sous-ensemble d’attributs choisis

aléatoirement. Dans les deux premiers cas, les attributs sont itérativement ajoutés

(Forward selection) ou retirés (Backward selection). Dans le troisième cas, soit on

ajoute, ou on retire des attributs comme dans les deux premiers cas, soit un nouveau

sous-ensemble d’attributs est créé de manière aléatoire à chaque itération (Random

generation).

Vu le nombre exhaustif de sous-ensemble candidats d'attributs, les méthodes de

génération peuvent être classées en trois grandes approches de génération ont été

proposées dans la littérature, la génération complète, la génération aléatoire et la

génération séquentielle [10], [11].

2.3.1.1.1 La génération complète

Dans la procédure de génération complète, un e recherche exhaustive est effectuée pour

trouver l'ensemble optimal d'attributs sur tout l'espace des solutions possibles, qui est

de l'ordre O(2N). Plusieurs procédures de recherche heuristique sont proposées afin de

réduire l'espace de recherche sans pour autant compromettre les chances de trouver le

sous-ensemble optimal à évaluer.

2.3.1.1.2 La génération aléatoire (heuristique)

Cette procédure de génération aléatoire n'évalue pas toutes les solutions possibles dans

l'espace de recherche de l'ordre O(2N), contrairement aux procédures de génération

complète. Un nombre maximal d'itérations est imposé afin de limiter le temps de calcul.

L'avantage de cette procédure est qu'elle ne nécessite pas l'utilisation de fonction

d'évaluation monotone. D'autre part, contrairement aux méthodes de génération

complète dont la complexité est exponentielle vis-à-vis de la dimension initial de

l'espace d'attributs. Plusieurs méthodes sont basées sur les algorithmes génétiques

(AG), initiés par Holland en 1975 [12], sont les méthodes de génération aléatoire les plus

utilisées [13].

2.3.1.1.3 La génération séquentielle

Le principe des procédures de génération séquentielle est d'ajouter ou supprimer un ou

plusieurs attributs au fur et à mesure des itérations. C'est-à-dire à chaque itération de

cette procédure, on considère à nouveau tout l'ensemble des attributs restants pour

l'étape de la sélection. La génération des sous-ensembles est typiquement incrémentable

(diminution/augmentation) dans un espace de recherche de l'ordre O(N2). On distingue

alors deux approches de génération séquentielle:

CHAPITRE 2. La sélection de variables 5

© Yosr NAIJA Avril 2015 © Marwa KAABI

- L'approche de type Forward ou Ascendante: cette approche part d'un ensemble vide

d'attributs auquel, à chaque itération sont ajoutés un ou plusieurs attributs.

- L'approche de type Backward ou Descendante: cette approche inverse, elle part de

l'ensemble total des attributs et à chaque itération permet de supprimer un ou plusieurs

attributs.

Les algorithmes utilisant ces approches de génération sont connus par leurs simplicité

de mise en œuvre et leur rapidité.

2.3.1.2 La fonction d'évaluation

La fonction d'évaluation permet d'évaluer les attributs ou les sous-ensembles d'attributs

générés à l'étape précédente [14]. Elle est utilisée pour mesurer:

la pertinence des attributs en les appréciant de manière individuelle, lorsqu'on

utilise un algorithme de sélection par classement des attributs.

la pertinence des sous-ensembles d'attributs générés par l'une des différentes

méthodes de génération présentées ci-dessous, lorsqu'un algorithme de

recherche du sous-ensemble est utilisé.

Toutefois, le choix d'un sous-ensemble optimal résultat de la procédure de recherche est

relatif à la fonction d'évaluation utilisée. Ainsi, le changement du critère peut changer

l'ensemble optimal en résultat.

Dés lors, les méthodes de sélection peuvent être classées en deux grandes approches(les

filtres et les wrappers), selon leur dépendance vis-à-vis de l'algorithme inductif qui

utilisera par la suite le sous-ensemble optimal des attributs

les méthodes filtres sont indépendantes de l'algorithme inductif, alors que les méthodes

wrappers utilisent l'algorithme inductif comme une fonction d'évaluation selon[1]

Différentes fonctions d'évaluation ont été proposées pour évaluer un attribut ou sous-

ensemble d'attributs peuvent être divisées en 5 catégories:

Les mesures d'erreur de classification: L’attribut ou les sous-ensembles

d’attributs considérés sont évalués en fonction de la qualité de la classification

obtenue en utilisant ces attributs. Le sous-ensemble d’attributs le plus

discriminant est celui pour lequel le taux d’erreur de classification est le plus

faible[15].

Les mesures d'information: Les mesures d’information déterminent le gain

d’information pour un attribut considéré, le gain d’information apporté par un

attribut étant estimé à partir des probabilités a posteriori. Un attribut fr est

préféré à un attribut fv si le gain d’information apporté par l’attribut fr est plus

grand que celui apporté par l’attribut fv [16].

Les mesures de consistance : Les mesures de consistance cherchent à évaluer si

l’attribut (ou le sous-ensemble d’attributs) étudié contient les informations

nécessaires à la discrimination des classes [17].

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

1

/

23

100%