Intégration des systèmes Client-Serveur - Cours - Bab Docs

DI GALLO Frédéric

Intégration des systèmes

Client / Serveur

Cours du Cycle d'Approfondissement

Cours dispensé par .

CNAM Aix-en-Provence 2001-2002

C/S

NET

SGBD

769803596

______________________________________________________________________________

___________________________________________________________________

DI GALLO Frédéric Page 2 17/04/2017

Objectifs:

Comprendre l'ensemble des concepts qui sous-tendent les architectures client-

serveur et réparties. Savoir concevoir, développer, intégrer des architectures de

type client-serveur.

Plan du cours:

Ouvrages conseillés :

Bibliographie :

769803596

______________________________________________________________________________

___________________________________________________________________

DI GALLO Frédéric Page 3 17/04/2017

INTRODUCTION AU CLIENT-SERVEUR

I. ORIGINES ET HISTORIQUE ............................................................................................ 8

1.1) Avant 1980 .............................................................................................................. 8

1.2) Les années 80 ......................................................................................................... 9

1.3) Les années 90 ......................................................................................................... 9

II. CARACTERISTIQUES DE L'APPROCHE C/S ...................................................... 10

2.1) Une répartition hiérarchique des fonctions.......................................................... 10

2.2) Définition .............................................................................................................. 10

2.3) Une grande diversité d'outils ................................................................................ 10

2.4) Une approche ouverte .......................................................................................... 11

III. POURQUOI LE C/S ? .................................................................................................... 12

3.1) Les contraintes de l'entreprise .............................................................................. 12

3.2) Mieux maÎtriser le système d'information ............................................................ 12

3.3) Prendre en compte l'évolution technologique ...................................................... 13

3.4) Réduire les coûts ? ................................................................................................ 14

IV. LES GENERATIONS DE C/S ......................................................................................... 15

L'ARCHITECTURE CLIENT-SERVEUR

V. INTRODUCTION ..................................................................................................... 19

VI. TECHNIQUES DE DIALOGUE CLIENT -SERVEUR ........................................................... 20

2.1) Notions de base ..................................................................................................... 20

2.2) Protocoles de type question-réponse .................................................................... 21

2.3) Assemblage-désassemblage des paramètres ........................................................ 21

2.4) Appel de procédure à distance ............................................................................. 22

2.5) Dialogue synchrone et asynchrone ...................................................................... 24

VII. LES DIFFERENTS TYPES DE CLIENT/SERVEUR ............................................................. 24

VIII. LE C/S DE DONNEES ET PROCEDURES ........................................................ 26

IX. LES FONCTIONS DES SERVEURS DE DONNEES ............................................. 28

5.1) Le modèle relationnel ........................................................................................... 28

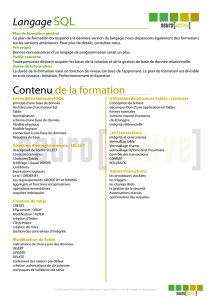

5.2) Le langage SQL .................................................................................................... 30

5.3) SQL: Bilan et conclusion ...................................................................................... 36

X. LES MEDIATEURS OU MIDDLEWARE............................................................... 37

6.1) Définition et Objectifs ........................................................................................... 37

6.2) Fonctions d'un Médiateur ..................................................................................... 38

6.3) Architecture Type ................................................................................................. 40

7.3) Les langages de programmation objet ................................................................. 44

7.4) Les langages de 4e génération (L4G) .................................................................. 46

7.5) Les ateliers de génie logiciel (AGL) ..................................................................... 47

XI. RESUME ET PERSPECTIVES ................................................................................ 48

LE MIDDLEWARE

XII. INTRODUCTION ..................................................................................................... 51

XIII. OBJECTIFS ET TYPOLOGIE DES MEDIATEURS .......................................... 52

2.1) Objectifs ................................................................................................................ 52

2.2) Typologie des médiateurs ..................................................................................... 53

XIV. INTERFACES APPLICATIVES : LE STANDARD CLI .................................................. 54

769803596

______________________________________________________________________________

___________________________________________________________________

DI GALLO Frédéric Page 4 17/04/2017

3.1) Place dans les systèmes ouverts ........................................................................... 54

3.2) Types de données, contextes et connexions .......................................................... 55

3.3) Envoi des requêtes ................................................................................................ 56

3.4) Transfert des résultats .......................................................................................... 56

3.5) Bilan et conclusion ............................................................................................... 57

XV. LES PROTOCOLES D'ECHANGE : LE STANDARD RDA .................................................. 58

XVI. INTERFACES ET PROTOCOLES: LES PRODUITS .................................................... 59

5.1) ODBC de Microsoft .............................................................................................. 59

5.2) DAL/DAM de Apple .............................................................................................. 62

5.4) Les solutions propriétaires ................................................................................... 63

XVII. ARCHITECTURES DISTRIBUEES : DCE DE L'OSF ................................................... 64

7.1) La cellule d'administration ................................................................................... 65

6.2) Le RPC DCE ......................................................................................................... 65

6.3) Le système de fichiers distribués (DFS) ............................................................... 66

6.4) Bilan de DCE ........................................................................................................ 67

XVIII. LES ARCHITECTURES D'INVOCATION D'OBJETS ...................................................... 67

7.1) CORBA de l'OMG ................................................................................................ 67

7.2) OLE 2 de Microsoft .............................................................................................. 68

XIX. CONCLUSION: VERS DES MEDIATEURS INTELLIGENTS ....................................... 68

TECHNIQUES SGBD RELATIONNELS

I. INTRODUCTION ..................................................................................................... 71

II. ARCHITECTURE TYPE D'UN SERVEUR RELATIONNEL ................................................... 72

2.1) Architecture fonctionnelle .................................................................................... 72

2.2) Architecture opérationnelle .................................................................................. 73

III. L'ANALYSE DES REQUETES ............................................................................... 74

IV. LA GESTION DES SCHEMAS ................................................................................ 76

V. LE SUPPORT DES VUES EXTERNES ................................................................... 77

5.1) Objectifs ................................................................................................................ 77

5.2) Définition des vues ............................................................................................... 78

5.3) Interrogation au travers de vues .......................................................................... 78

5.4) Mises à jour au travers de vues ............................................................................ 79

5.5) Les vues concrètes ................................................................................................ 79

VI. LA GESTION DE L'INTEGRITE ............................................................................. 80

6.1) Objectifs et principes ............................................................................................ 80

6.2) Définition des contraintes ..................................................................................... 81

6.3) Vérification des contraintes .................................................................................. 81

VII. LE CONTROLE DES DROITS D'ACCES ............................................................... 81

7.1) Objectifs et moyens ............................................................................................... 81

7.2) Accords et retraits d'autorisations ....................................................................... 82

7.3) Groupes, rôles et procédures ............................................................................... 82

VIII. L'OPTIMISATION DES REQUETES ................................................................. 83

8.1) Etapes de l'optimisation ....................................................................................... 83

8.2) Restructuration algébrique ................................................................................... 83

8.3) Modèle de coût ..................................................................................................... 85

8.4) Stratégie de recherche ........................................................................................... 86

IX. LES OPERATEURS RELATIONNELS .................................................................. 88

9.1) Opérateur de sélection .......................................................................................... 88

9.3) Le calcul des agrégats .......................................................................................... 91

769803596

______________________________________________________________________________

___________________________________________________________________

DI GALLO Frédéric Page 5 17/04/2017

X. LE SUPPORT DES PROCEDURES, ....................................................................... 91

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

34

34

35

35

36

36

37

37

38

38

39

39

40

40

41

41

42

42

43

43

44

44

45

45

46

46

47

47

48

48

49

49

50

50

51

51

52

52

53

53

54

54

55

55

56

56

57

57

58

58

59

59

60

60

61

61

62

62

63

63

64

64

65

65

66

66

67

67

68

68

69

69

70

70

71

71

72

72

73

73

74

74

75

75

76

76

77

77

78

78

79

79

80

80

81

81

82

82

83

83

84

84

85

85

86

86

87

87

88

88

89

89

90

90

91

91

92

92

93

93

1

/

93

100%