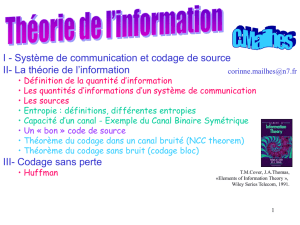

INTRODUCTION

À LA THÉORIE DE L’INFORMATION

POUR LE CODAGE

Master Systèmes de Radiocommunications, année 2007.

Version : 2.1.

Samson LASAULCE

2

Table des matières

1 Introduction. Outils de base du cours 5

1.1 Objectifsducours...................................... 5

1.2 Outilsdebase........................................ 5

1.2.1 Information associée à un événement . . . . . . . . . . . . . . . . . . . . . . . 5

1.2.2 Entropie....................................... 6

1.2.3 Entropie conditionnelle . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 7

1.2.4 Informationmutuelle................................ 7

1.2.5 Information mutuelle conditionnelle . . . . . . . . . . . . . . . . . . . . . . . . 9

1.2.6 Règlesdechaîne .................................. 9

1.2.7 ChaînesdeMarkov................................. 9

1.2.8 Séquences faiblement typiques (typicité entropique) . . . . . . . . . . . . . . . 10

1.2.9 Séquences fortement typiques . . . . . . . . . . . . . . . . . . . . . . . . . . . 11

2 Transmission point-à-point 13

2.1 Notiondecapacité ..................................... 13

2.1.1 Cas du codage à répétition . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 13

2.1.2 Empilement de sphères sur le canal binaire symétrique . . . . . . . . . . . . . . 14

2.1.3 Empilement de sphères sur le canal gaussien . . . . . . . . . . . . . . . . . . . 16

2.1.4 Préliminaire au second théorème de Shannon . . . . . . . . . . . . . . . . . . . 16

2.2 Définition du canal de Shannon . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 17

2.3 Deuxième théorème de Shannon . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 19

2.3.1 Énoncéduthéorème ................................ 19

2.3.2 Commentaires ................................... 19

2.3.3 Démonstration de l’atteignabilité (résumé) . . . . . . . . . . . . . . . . . . . . 19

2.3.4 Démonstration de la réciproque (faible) . . . . . . . . . . . . . . . . . . . . . . 21

2.4 Exploitation du second théorème de Shannon . . . . . . . . . . . . . . . . . . . . . . . 22

2.4.1 CapacitéducanalBSC............................... 22

2.4.2 CapacitéducanalBEC............................... 23

2.4.3 Capacité du canal AWGN . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 23

4 Table des matières

2.5 D’autres exemples pratiques de canaux mono-utilisateurs . . . . . . . . . . . . . . . . . 25

2.5.1 Canaux MIMO gaussiens . . . . . . . . . . . . . . . . . . . . . . . . . . . . . . 25

2.5.2 Canauxmulti-trajets ................................ 27

2.5.3 Canaux variables dans le temps . . . . . . . . . . . . . . . . . . . . . . . . . . 28

2.5.3.1 Canaux SISO à évanouissements rapides . . . . . . . . . . . . . . . . 28

2.5.3.2 Canaux MIMO à évanouissements rapides . . . . . . . . . . . . . . . 29

2.5.3.3 Canaux SISO à évanouissements lents . . . . . . . . . . . . . . . . . 29

2.5.3.4 Canaux MIMO à évanouissements lents . . . . . . . . . . . . . . . . 30

2.5.4 Canaux avec information adjacente . . . . . . . . . . . . . . . . . . . . . . . . 31

2.5.5 Canaux avec retour d’information . . . . . . . . . . . . . . . . . . . . . . . . . 31

3 Canaux à plus de deux terminaux 33

3.1 Canalàaccèsmultiple ................................... 33

3.2 Canaldediffusion...................................... 34

3.3 Canalàrelais ........................................ 37

3.4 Canal à accès multiple à émetteurs coopératifs . . . . . . . . . . . . . . . . . . . . . . . 38

3.5 Canal de diffusion à récepteurs coopératifs . . . . . . . . . . . . . . . . . . . . . . . . . 38

A Sujet examen 2004 39

B Corrigé examen 2004 43

B.1 Remarquegénérale ..................................... 43

B.2 Question1.......................................... 44

B.3 Question2.......................................... 44

B.3.1 Expressions de l’information mutuelle . . . . . . . . . . . . . . . . . . . . . . . 44

B.3.2 Calcul de I(U;S)et de I(U;Y)........................... 44

B.3.3 Allure des grandeurs considérées : I(U;S),I(U;Y),R(α) = I(U;Y)−I(U;S). . 45

B.3.4 Valeur de αqui maximise R(α) = I(U;Y)−I(U;S)................ 45

B.3.5 Capacitéducanal.................................. 45

C Sujet examen 2005 47

D Corrigé examen 2005 49

E Examen 2006 51

F Examen 2006 53

Chapitre 1

Introduction. Outils de base du cours

1.1 Objectifs du cours

Ce cours traitera assez peu de théorie de l’information au sens large. En effet, à part les définitions de

base données dans ce chapitre, l’essentiel du cours portera sur l’application de la théorie de l’information

aux communications. Dans ce cadre précis nous nous limiterons essentiellement à la notion de théorème

de codage. Une des activités de la théorie de l’information pour les communications consiste à fournir,

pour un canal donné, le théorème de codage correspondant. Un théorème de codage a au moins deux

fonctions essentielles :

1. grâce à la démonstration de la partie dite "d’atteignabilité" fournir des idées et des concepts de

codage dont on peut s’inspirer pour construire une stratégie pratique de codage canal.

2. grâce au résultat de la partie dite "réciproque", qui permet de valider l’optimalité de la stratégie

de codage construite dans la partie atteignabilité, donner les limites ultimes en termes de débit

d’information d’une communication fiable sur un canal donné.

Le cours comporte trois parties :

1. une partie qui contient les principaux outils de base de la théorie de l’information ;

2. une partie dédiée au canal mono-utilisateur, c’est-à-dire avec un seul émetteur et un seul récepteur

(canal de Shannon, canal MIMO, canal multi-trajet, ...) ;

3. une partie dédiée à des canaux plus complexes, c’est-à-dire avec au moins trois terminaux (canal

de diffusion, canal à relais, ...).

1.2 Outils de base

1.2.1 Information associée à un événement

On conçoit très bien qu’un événement certain ne contient pas de nouveauté ou d’information. Par exemple,

lorsque la météo annonce une journée sans pluie dans le Sahara, on apprend peu de choses. Inversement

l’annonce d’une journée de pluie est un renseignement précieux, car inattendu. On peut ainsi définir

l’information associée à une réalisation x(événement) d’une variable aléatoire Xdiscrète comme suit :

i(x),−log p(x).(1.1)

Bien que cette quantité soit parfois utile dans certains calculs intermédiaires ou pédagogiquement, elle

ne figure pas parmi les grandeurs d’usage de la théorie de l’information pour les communications.

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

34

34

35

35

36

36

37

37

38

38

39

39

40

40

41

41

42

42

43

43

44

44

45

45

46

46

47

47

48

48

49

49

50

50

51

51

52

52

53

53

54

54

55

55

56

56

57

57

58

58

1

/

58

100%