Guide de référence pour entrepôt de données Fast Track

Guide de référence pour entrepôt de données Fast Track pour SQL Server 2012

Article technique SQL Server

Auteurs : Eric Kraemer, Mike Bassett, Eric Lemoine, Dave Withers

Relecteurs techniques : Claude Lorenson, Susan Price, Ralph Kemperdick, Henk van der

Valk, Alexi Khalyako, Oliver Chiu

Date de publication : mars 2012

S'applique à : SQL Server 2012

Résumé : Ce document définit un modèle de configuration de référence (appelé entrepôt de

données Fast Track) à l'aide d'une approche d'équilibrage des ressources pour implémenter

une architecture système de bases de données SQL Server de type multiprocesseur symétrique

aux performances et à l'évolutivité éprouvées pour les charges de travail d'entrepôt de données.

L'objectif d'une architecture de référence d'entrepôt de données Fast Track consiste à obtenir

un équilibre efficace des ressources entre la fonctionnalité de traitement de données SQL Server

et le débit du composant matériel obtenu.

2

Copyright

Ce document est fourni « en l'état ». Les informations et les opinions exprimées dans ce document,

y compris les adresses URL et les autres références à des sites Internet, peuvent faire l'objet de

modifications sans préavis. Vous assumez tous les risques liés à son utilisation.

Ce document ne vous concède aucun droit de propriété intellectuelle portant sur les produits Microsoft.

Vous pouvez copier et utiliser ce document à titre de référence pour un usage interne.

© 2012 Microsoft. Tous droits réservés.

3

Sommaire

Historique des modifications du Guide de référence pour entrepôt de données Fast Track ...................... 6

Introduction .................................................................................................................................................. 6

Public visé.................................................................................................................................................. 6

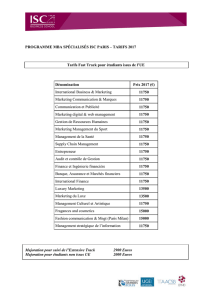

Entrepôt de données Fast Track ................................................................................................................... 6

Fast-Track .................................................................................................................................................. 7

Proposition de valeur ................................................................................................................................ 7

Méthodologie................................................................................................................................................ 7

Architecture holistique des composants .................................................................................................. 7

Méthode optimisée par charge de travail ................................................................................................ 8

Configurations de référence SQL Server Fast Track validées.................................................................... 9

Résumé ..................................................................................................................................................... 9

Charge de travail d'entrepôt de données Fast Track .................................................................................... 9

Modèles de charge de travail d'entrepôt de données.............................................................................. 9

Évaluation de la charge de travail ........................................................................................................... 10

Attributs qualitatifs de charge de travail d'entrepôt de données .......................................................... 12

Choix d'une configuration de référence d'entrepôt de données Fast Track ................................................. 13

Option 1 : évaluation de base ................................................................................................................. 14

Étape 1 : évaluer le cas d'usage du client ............................................................................................... 14

Étape 2 : choisir une architecture de référence d'entrepôt de données Fast Track publiée ............. 15

Option 2 : évaluation complète .............................................................................................................. 15

Présentation du processus .................................................................................................................. 16

Étape 1 : évaluer le cas d'usage du client ........................................................................................... 16

Étape 2 : établir les mesures d'évaluation .......................................................................................... 17

Étape 3 : choisir une architecture de référence d'entrepôt de données Fast Track .......................... 18

Option 3 : architectures de référence définies par l'utilisateur ............................................................. 18

Étape 1 : définir la charge de travail ................................................................................................... 18

Étape 2 : établir des tests d'évaluation de l'architecture des composants ........................................ 18

Choisir un résumé de l'architecture de référence Fast Track ................................................................. 19

4

Configuration standard d'entrepôt de données Fast Track ........................................................................ 20

Architecture des composants matériels ................................................................................................. 20

Impératifs relatifs aux composants et configuration .......................................................................... 21

Configuration de l'application ................................................................................................................. 23

Windows Server 2008 R2 .................................................................................................................... 23

SQL Server 2012 Enterprise ................................................................................................................ 23

Système de stockage ........................................................................................................................... 25

Meilleures pratiques SQL Server pour l'entrepôt de données Fast Track .................................................. 30

Architecture des données ....................................................................................................................... 30

Structure de table ............................................................................................................................... 30

Partitionnement de table .................................................................................................................... 32

Indexation ........................................................................................................................................... 33

Index columnstore optimisés en mémoire xVelocity ......................................................................... 33

Statistiques de base de données ........................................................................................................ 35

Compression ....................................................................................................................................... 36

Gestion de la fragmentation des données .............................................................................................. 37

Fragmentation du système de fichiers ............................................................................................... 37

Plusieurs groupes de fichiers .............................................................................................................. 39

Chargement des données ....................................................................................................................... 39

Chargements incrémentiels ................................................................................................................ 40

Migration des données ....................................................................................................................... 42

Tests d'évaluation et validation .................................................................................................................. 45

Effectuer la validation d'entrepôt de données Fast Track de référence ................................................ 46

Tests d'évaluation de référence avec SQLIO ....................................................................................... 47

Effectuer un test d'évaluation de base de données Fast Track .............................................................. 50

Calcul du MCR ..................................................................................................................................... 51

Calcul du BCR ...................................................................................................................................... 52

Architectures de référence d'entrepôt de données Fast Track publiées ................................................... 55

Conclusion ................................................................................................................................................... 55

5

Annexe ........................................................................................................................................................ 57

FTDW System Sizing Tool ........................................................................................................................ 57

Validation d'une architecture de référence Fast Track définie par l'utilisateur ..................................... 57

Test d'E/S synthétiques ....................................................................................................................... 57

Génération des fichiers de test avec SQLIO ........................................................................................ 57

Test de la charge de travail ..................................................................................................................... 60

Mesure du MCR pour votre serveur (facultatif) ................................................................................. 60

Mesure du BCR pour votre charge de travail ...................................................................................... 60

Facteurs affectant le taux de consommation de requête .................................................................. 65

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

34

34

35

35

36

36

37

37

38

38

39

39

40

40

41

41

42

42

43

43

44

44

45

45

46

46

47

47

48

48

49

49

50

50

51

51

52

52

53

53

54

54

55

55

56

56

57

57

58

58

59

59

60

60

61

61

62

62

63

63

64

64

65

65

1

/

65

100%