PETIT MANUEL EXPLICATIF DE LA ... TERRORISME SMALL EXPLANATORY MANUAL ON THE SILENT TERRORISM « FABRIC »

PETIT MANUEL EXPLICATIF DE LA FABRIQUE SILENCIEUSE DU

TERRORISME

SMALL EXPLANATORY MANUAL ON THE SILENT TERRORISM « FABRIC »

Selon le Dictionnaire de musique de Jean-Jacques ROUSSEAU, M. DCC. LXVIII. à

la page 477, l’expérience qui suit sert de principe à toute Harmonie Artificielle et est

tirée du Système de Giuseppe TARTINI 1692-1770 :

« Toutes les fois que deux sons forts, justes et soutenus, se font entendre au même

instant, il résulte de leur choc un troisième son plus ou moins sensible, à proportion

de la simplicité du rapport des deux premiers et de la finesse d’oreille des

écoutants. »

Sur le site de : www.universalis.fr/encyclopedie, on retrouve une explication de ce

phénomène dit de Giuseppe TARTINI, au registre des OTO-EMISSIONS

ACOUSTIQUES :

« Dès 1714, Giuseppe Tartini découvrait, par une méthode psycho-acoustique, que

lorsqu'il écoutait deux sons purs, de fréquences proches, émis simultanément, il

entendait un troisième son. »

Sur le site de Wikipedia.fr au registre de L’OTO-EMISSION ACOUSTIQUE, il est dit :

« Les oto-émissions acoustiques sont des vibrations de nature sonore générées

par les mouvements des cellules ciliées externes, situées le long de la membrane

basilaire cochléaire. Phénomène prédit en 1948 par Thomas Gold, sa démonstration

expérimentale a été réalisée par le physicien David Kemp en 1978 grâce au

perfectionnement micros ultrasensibles. »

Avec pour mécanisme :

« Quand un son atteint l’oreille, il passe par le pavillon et finit dans la cochlée qui

joue le rôle d'amplificateur : les cellules ciliées stimulées par l’onde acoustique

génèrent à leur tour un son très faible qui sort de l’oreille. »

Sur le site de www.coclhea.eu, au registre des OTO-EMISSIONS ACOUSTIQUES, il

est dit :

« Découvertes "prématurément" en 1978 (Kemp), les oto-émissions acoustiques

(OEAs) ont été mieux interprétées quelques années plus tard, à la lumière des

avancées sur les mécanismes actifs et les propriétés électromotiles des céllules

cliliées externes (CCEs) dont elles sont en fait le reflet. En plaçant une sonde dans

le conduit auditif externe, on peut enregistrer une réponse acoustique après une

stimulation (oto-émissions provoquées), ou même, dans certains cas, une émission

spontanée. »

Sur le site de www.universalis.fr/encyclopedie, il est précisé que :

« Les oto-émissions provoquées, contrairement aux oto-émissions spontanées,

n'apparaissent que lorsque l'oreille est stimulée par ce qu'on appelle communément

un clic, un son bref et de large spectre. »

Sur : http://www.cochlea.eu/son/psychoacoustique

« Si on fait entendre sur une même oreille un son complexe composé de deux sons

purs de fréquences différentes mais proches, la sonie reste la même tant que l’écart

entre ces deux fréquences est inférieur à la largeur de la bande critique ; dès que cet

écart dépasse la largeur de la bande critique, la sonie augmente. »

Sur : http://www.minidisc.org/French_tech/section1.html

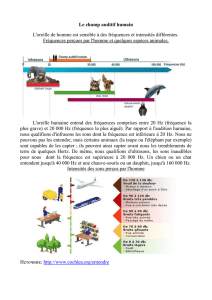

La sensibilité de notre organe auditif n'est pas linéaire, elle varie en fonction de la

fréquence (20-20 000 Hz) et du niveau sonore. L'oreille possède un maximum de

sensibilité pour des fréquences comprises entre 2 et 5 kHz (pointe à 4 kHz). De ce

fait, deux sons de fréquence différentes et de même intensité peuvent provoquer

une sensation de force sonore différente (ou une sonie différente). L'expression de

la sonie se définit en sones, où un sone représente une sensation de force sonore

équivalente de 40 dB à 1 kHz. En fonction de la sonie et de la fréquence, le

comportement de notre oreille varie et des phénomènes de masquage

apparaissent.

On parle de masquage quand un son est rendu inaudible par un autre. Il existe

plusieurs sortes d'effets de masque. Tout d'abord le plus connu, celui que l'on peut

expérimenter tous les jours en discutant avec une personne pendant qu'un train

passe à proximité, c'est-à-dire le masquage simultané ou fréquentiel. Il intervient

lorsque le cerveau doit analyser deux modulations dont la fréquence et l'amplitude

sont proches.

Il existe également un masquage appelé "effet de précédence" (ou effet de Haas)

qui apparaît lorsque le signal masqué est émis après le signal masquant. Enfin, un

son masqué émis avant le signal masquant est un masquage de postériorité.

Le masquage de postériorité et l'effet de précédence sont des masquages

temporels. On peut constater que l'effet de Haas est beaucoup plus "tolérant" que

le masquage de postériorité. Un son théoriquement masqué étant émis plus de 2 ou

3 ms avant le son soit disant masquant, devient un pré-écho audible et gênant

tandis que dans le cas du masquage par précédence, une fois le son masquant

émis, le son masqué le reste tant qu'il survient dans les 20 ms (environ) qui suivent

l'émission du son masquant. Ces valeurs ne sont cependant valables que pour des

impulsions très brèves, du type transitoires. Pour des durées supérieures, le

phénomène n'est plus le même.

Un sujet est soumis à un son pur (dans ce cas 1 kHz à 60 dB) et doit se manifester

lorsqu'il perçoit un autre son pur‚ de fréquence différente ou voisine. On constate

que le seuil d'audition absolu est alors "relevé". En effet, au voisinage de 1 kHz, il

faut augmenter de façon considérable le niveau de… ‚ pour que le sujet l'entende. Il

est important de noter que le phénomène est d'autant plus perceptible lorsqu'on

dépasse la fréquence du son masquant, à savoir 1 kHz. Ceci souligne en fait le

comportement de notre oreille interne, notamment la membrane basilaire, à

l'intérieur de laquelle les sons graves ont tendance à masquer les sons aigus, ce qui

explique la dissymétrie du parcours de… ‚ autour de…. Grâce à ce test, nous

avons pu constater qu'il y a une grande partie du spectre qui n'est pas perçue

par l'oreille.

Sur : http://www.sebsite.org/article.php3?id_article=22 relatif à la compression

ATRAC (Adaptive Transform Acoustic Coding) pour MiniDisc :

En effet, l'oreille analyse le spectre audio en le découpant en bandes dites

critiques. Dans chacune de ces bandes (dont la largeur varie en fonction de la

précision de l'oreille à ces fréquences et non de la largeur de la courbe de masking),

l'oreille assimile les fréquences et ne les différencie plus. Ces bandes correspondent

d'ailleurs à la répartition des cellules ciliées dans l'oreille interne.

Suite : http://www.minidisc.org/French_tech/section1.html

La théorie des bandes critiques est née de la découverte du phénomène décrit ci-

dessus. Elle vient de l'idée que notre oreille intègre les sons par tranches de

fréquences appelées sous-bandes. Nous avons en effet pu constater que pour

entendre le son ‚ au voisinage de..., il fallait fournir beaucoup plus de niveau chez… ‚

par rapport au seuil d'audition. Le phénomène observé n'est pas linéaire: selon la

fréquence mise en cause, la largeur de ces bandes critiques varie.

Bande

Critique

Fréquence (Hz)

Bande

Critique

Fréquence (Hz)

Basse

Haute

Largeur

Basse

Haute

Largeur

0

0

100

100

13

2000

2320

320

1

100

200

100

14

2320

2700

380

2

200

300

100

15

2700

3150

450

3

300

400

100

16

3150

3700

550

4

400

510

110

17

3700

4400

700

5

510

630

120

18

4400

5300

900

6

630

770

140

19

5300

6400

1100

7

770

920

150

20

6400

7700

1300

8

920

1080

160

21

7700

9500

1800

9

1080

1270

190

22

9500

12000

2500

10

1270

1480

210

23

12000

15500

3500

11

1480

1720

240

24

15500

22050

6550

12

1720

2000

280

Sur : http://www.audiosonica.com/fr/cours/post/23/Perception_du_son_Effet_Haas

On appelle effet Haas un certain phénomène physique qui concerne la perception du

son par le cerveau. Prenons en considération le cas d'un son produit par une source

sonore, et imaginons que nous nous trouvons dans une pièce et que nous sommes

placés à une certaine distance de la source même. En raison des réflexions du son

sur les parois, c'est avant tout le signal provenant directement de la source qui nous

parviendra et, dans un deuxième temps, celui produit par les réflexions du signal

même, sur les parois de la pièce. Ce retard est dû au fait que le son reflété traverse

un parcours plus long que le signal direct. Si les deux signaux parviennent avec un

léger retard l'un par rapport à l'autre, le cerveau perçoit un son unique provenant

d'une seule direction.

La direction perçue par le cerveau comme la direction de provenance du son est

celle de l'onde qui arrive la première (ceci est valable même si l'intensité de la

seconde onde est supérieure à la première). C'est pour cette raison que cet effet

prend le nom d'effet de précédence. Cet effet se produit quand le retard entre les

deux signaux est suffisamment court, plus précisément il ne doit pas dépasser les

30-35 ms. Cet intervalle temporel est ainsi défini zone de Haas:

Équation 2.2. zone de Haas

[0 - 35ms]

Quand le retard entre les signaux sort de la zone de Haas, on avertit deux signaux

distincts et nous entrons dans le cas de l'effet écho, où l'auditeur perçoit les deux

sons comme s'ils étaient distincts.

D’après un document PDF intitulé La Psychoacoustique.pdf du :

http://cnr.annecy.regie.free.fr/cours/La%20Psychoacoustique.pdf

L'oreille interne

L'oreille interne ou labyrinthe, séparée de l'oreille moyenne par la fenêtre ovale, est

un ensemble complexe de cavités osseuses, creusées dans l'os mastoïde et

remplies de divers liquides. Elle est le siège de l'organe transducteur de l'audition.

Son mécanisme est si complexe qu’on n’en connaît pas le fonctionnement exact et il

est toujours un sujet d'études.

La cochlée ou limaçon est une cavité spiralée contenant des liquides qui vont

transmettre les vibrations provenant du tympan. Elle contient l'organe transducteur

mécanique-neuronal : l'organe de Corti, fixé sur la membrane basilaire, est constitué

d'environ 16 000 cellules, appelées cellules ciliées ; ces capteurs essentiels ont la

propriété d’être sensibles aux micromouvements mécaniques de la membrane

tectoriale par le moyen d’un cil (d’où leur nom) et transmettent ainsi l’information

sonore sous forme d’impulsions électriques au nerf auditif. Elles sont disposées sur

quatre rangées le long de toute la membrane basilaire.

Les cellules internes transmettent une information électrochimique aux fibres

nerveuses du nerf auditif rejoignant le cerveau. Elles sont dites afférentes par

rapport au cerveau : privées de ces cellules, tout en conservant les externes, par

exemple lors des traumatismes sonores qui détruisent les cils de ces cellules, nous

devenons sourds. Celles-ci ont donc une valeur essentiellement sensorielle.

Les cellules externes sont liées à des fibres descendantes venant du cerveau.

Contractiles et adaptatrices, elles font partie du système efférent du cerveau.

Leur altération par l’âge compromet l’intelligibilité du langage. Situées en plusieurs

rangées, leur rôle est de se contracter en fonction d’une fréquence reçue, c’est à

dire que pour telle zone de la membrane basilaire, tel ensemble de fibres est activé.

Celles-ci, représentant 5% de fibres non myélinisées, sont donc en nombre infime

mais elles ont un rôle considérable, c’est à dire un rôle adaptateur, à la

manière d'un pré-ampli vis-à-vis du son plus ou moins organisé, qui a subi un

premier acheminement via le cerveau. Elles peuvent aussi affaiblir un son,

l’amortir, si celui- ci est d’une intensité trop forte ou s’il se situe dans des

fréquences trop graves. Cette mobilisation répond à une fréquence particulière

selon le lieu de la membrane basilaire envisagé (tonotopie). Les fréquences aigues

feraient plutôt réagir les cellules ciliées placées à la base de la membrane basilaire,

c’est-à-dire près de la fenêtre ovale, tandis que les fréquences aigues exciteraient

plutôt les cellules placées au bout.

1. Les cellules ciliées internes 2. Les trois rangées de cellules ciliées externes 3.

Fibres nerveuses

Schéma de la cochlée montrant, sur la partie gauche les cellules ciliées internes (1)

sur une seule rangée et sur la partie droite, les cellules ciliées externes (2) sur trois

rangées. Les autres cellules sont des cellules de soutien

Ce qui circule sur les fibres du nerf optique ne ressemble pas du tout aux

vibrations.... Sans en dire plus, les axones auditifs rejoignent les premières aires

auditives du cerveau dans lesquels il y a concurrence avec des axones venant de

nombreuses autres régions...

La localisation latérale est un des principaux critères entrant en considération dans

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

34

34

35

35

36

36

37

37

38

38

39

39

40

40

41

41

42

42

43

43

44

44

45

45

46

46

47

47

48

48

49

49

50

50

51

51

52

52

53

53

54

54

55

55

56

56

57

57

58

58

1

/

58

100%