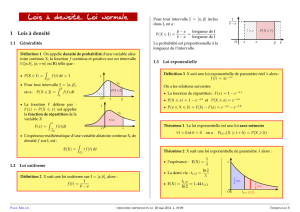

Convergence en loi et théorème limite central Chapitre 8 (Ω,

Chapitre 8

Convergence en loi et théorème

limite central

Toutes les variables aléatoires de ce chapitre sont encore définies sur un même espace

probabilisé (Ω,A,P).

Les résultats du chapitre précédent suggère de répondre à la question : Quelle est la

vitesse de convergence de la moyenne empirique vers la moyenne dans la loi des grands

nombres ? Le théorème limite central apporte une réponse à cette question. En notant

¯

Xn=1

nPn

i=1 Xila moyenne empirique de nvariables aléatoires L2indépendantes de même

loi, on a vu que pour tout α < 1

2,nα(¯

Xn−E(X1)) admet une variance qui tend vers 0avec net

donc convergence en probabilité vers 0. On va voir que le comportement de √n(¯

Xn−E(X1)),

qui a une variance constante, est bien différent. Pour le caractériser, nous introduisons un

nouveau mode de convergence qui ne prendra en compte que la suite des lois successives

des Xn.

8.1 Convergence en loi

On rappelle que FXdésigne la fonction de répartition de la variable aléatoire Xet est

définie par FX(t) = P(X≤t).

Définition 8.1.1. Soit (Xn)n≥1une suite de variables aléatoires. On dit que Xnconverge

en loi vers une variable aléatoire Xsi

FXn(t)−−−−−→

n→+∞FX(t)en tout point toù FXest continue.

Pourquoi aux points de continuité de FX?

Soit Xntel que P(Xn= 0) = P(Xn=1

n) = 1

2, alors FXn(t) =

0si t < 0

1

2si 0≤t < 1

n

1si t≥1

n

converge

vers F(t) =

0si t < 0

1

2si t= 0

1si t > 0

qui n’est pas une fonction de répartition. Mais si FXest la fonc-

tion de répartition de X= 0, on a bien que FXnconverge vers FXaux points de continuité

de FX, et donc Xnconverge en loi vers 0.

Remarque 8.1.2. 1. Contrairement aux autres modes de convergence, la convergence

en loi ne dépend que des lois PXndes variables Xnet pas de la façon dont les variables

sont définies. On notera donc indifféremment, Xn→Xen loi, ou PXn→PX, ou

carrément Xn→PXen loi.

CHAPITRE 8. CONVERGENCE EN LOI ET THÉORÈME LIMITE CENTRAL

2. En particulier, la limite n’est pas unique ! Si Xn→Xen loi et si Ya la même loi que

X, alors Xn→Yen loi. C’est en revanche la loi de la limite qui est unique.

Exemple 8.1.3. 1) Soit Xn∼ U([0,1]),n≥1, des variables aléatoires indépendantes. Alors

Yn=nmin{X1, . . . , Xn}converge en loi vers une variable aléatoire de loi E(1). En effet,

pour tout t > 0(et nassez grand),

FYn(t)=1−P(min{X1, . . . , Xn}>t

n)=1−P(X1>t

n)···P(Xn>t

n)=1−(1 −t

n)n

et donc FYn(t)→1−e−t.

2) Soit X∼ B(1

2)et pour tout n≥0,X2n=Xet X2n+1 = 1 −X. Alors pour tout n≥0,

Xn∼ B(1

2)et donc Xnconverge en loi vers X(mais aussi vers 1−X). En revanche, pour

tout 0<ε<1,P(|Xn−X|> ε)=1dès que nest impair et donc il n’y a pas convergence en

probabilité.

Cet exemple montre que la convergence en loi n’entraîne pas la convergence en proba-

bilité.

Proposition 8.1.4. La convergence en probabilité entraîne la convergence en loi.

Démonstration. Soit (Xn)n≥1une suite de variables aléatoires de fonctions de répartition

Fnet Xune variable aléatoire de fonction de répartition F. On suppose que Xn→Xen

probabilité. Soit t∈Run point de continuité de Fet ε > 0. Par continuité, il existe η > 0

tel que |x−t| ≤ ηimplique |F(x)−F(t)| ≤ ε. On montre (exercice) que Xn≤tentraîne

X≤t+ηou Xn−X≤ −η. On a donc

Fn(t)≤F(t+η) + P(Xn−X≤ −η)≤F(t) + ε+P(|Xn−X| ≥ η)

De même, comme X≤t−ηet Xn−X < η entraîne Xn≤t, on a

Fn(t)≥F(t−η)−P(Xn−X≥η)≥F(t)−ε−P(|Xn−X| ≥ η)

On en déduit |Fn(t)−F(t)| ≤ ε+P(|Xn−X| ≥ η)−−−−−→

n→+∞ε. Ceci étant vrai pour tout ε > 0,

Fn(t)→F(t).

On a vu que la réciproque est fausse en général, mais ...

Proposition 8.1.5. Si Xnconverge en loi vers une constante c∈R, alors Xnconverge en

probabilité vers c.

Démonstration. Soit ε > 0. Comme Xnconverge en loi vers c, on a FXn(t)→1[c,+∞[(t)pour

tout t6=c. Or,

P(|Xn−c| ≥ ε) = P(Xn≤c−ε) + P(Xn≥c+ε)

≤P(Xn≤c−ε) + P(Xn> c +ε

2)

≤FXn(c−ε)+1−FXn(c+ε

2).

Donc, P(|Xn−c| ≥ ε)→0+1−1=0quand n→+∞.

En conclusion, on a

convergence en probabilité ⇒

:∗convergence en loi.

et (*) vraie lorsque la limite est une constante.

8.2. APPROXIMATIONS DE LOIS

8.2 Approximations de lois

Le résultat suivant a déjà été évoqué en introduisant la loi de Poisson. Il justifie le fait

que la loi de Poisson est utilisée pour modéliser le nombre d’occurrences d’un évènement

rare.

Proposition 8.2.1 (Binomiale par Poisson).Soit (Xn)n≥1une suite de variables aléatoires

de loi B(n, pn), avec n∈Net pn∈[0,1]. Si npn→λ > 0quand n→+∞, alors

Xn−−−−−→

n→+∞P(λ)en loi.

Démonstration. Commençons par montrer que pour tout k∈N,P(Xn=k)→e−λλk

k!. Pour

nassez grand,

P(Xn=k) = n

kpk

n(1 −pn)n−k=n(n−1) ···(n−k+ 1)

nk

(npn)k

k!(1 −pn)−k(1 −pn)n

Or, quand n→+∞,npn→λ,n(n−1)···(n−k+1)

nk→1,pn→0et

(1 −pn)n=enlog(1−pn)=en(−pn+o(pn)) =e−npn+o(1) →e−λ.

On obtient,

P(Xn=k)→e−λλk

k!.

Maintenant, pour tout t∈R,

FXn(t) = btc

X

k=0

P(Xn=k)−−−−−→

n→+∞

btc

X

k=0

e−λλk

k!=F(t),

où Fest la fonction de répartition d’une loi P(λ).

En pratique ce résultat est utilisé pour remplacer la loi binomiale B(n, p)par une loi de

Poisson P(np)lorsque nest grand devant np (par exemple, mais c’est arbitraire, n > 100 et

np < 10).

On rappelle que si X∼ B(n, p)alors E(X) = np et V(X) = np(1 −p). La variable

Y=X−np

√np(1−p)est donc centrée et réduite (i.e. E(Y)=0et V(Y)=1). Le résultat suivant

est une première approche vers le théorème limite central. Sa démonstration originelle

repose sur l’utilisation d’une bonne approximation de n!, comme la formule de Stirling

n!∼√2πn nne−n.

Théorème 8.2.2 (de Moivre-Laplace (1733,1809), Binomiale par Normale).Soit (Xn)n≥1

une suite de variables aléatoires de loi B(n, p), avec n∈Net p∈[0,1]. On a

Xn−np

pnp(1 −p)−−−−−→

n→+∞N(0,1) en loi,

où N(0,1) est la loi normale centrée réduite.

C’est-à-dire, que pour tout t∈R,

P Xn−np

pnp(1 −p)≤t!−−−−−→

n→+∞Φ(t),

où Φest la fonction de répartition de la loi N(0,1).

Applications pratiques.

CHAPITRE 8. CONVERGENCE EN LOI ET THÉORÈME LIMITE CENTRAL

1. On reprend un vieil exemple. Un QCM est composé de 100 questions à deux choix

(c’est l’exemple 5.3.6). Un candidat répond à chaque question au hasard et de façon

indépendante. La loi du nombre de bonnes réponses Xest donc une loi B(100,1

2).

Son espérance vaut 50 et sa variance 25. En considérant que n= 100 est grand,

le théorème précédent nous dit que X−50

5suit approximativement une loi normale

N(0,1). Donc la probabilité d’avoir au moins 61 bonnes réponses, c’est à dire P(X >

60) = PX−50

5>2vaut approximativement 1

√2πR+∞

2e−x2

2dx = 1 −Φ(2). En utilisant

la table (c.f. section 8.5) on obtient Φ(2) '0,9772 et donc la probabilité cherchée

vaut approximativement 0,0228. Remarquons qu’en utilisant l’inégalité de Bienaymé-

Tchebychev, on avait trouvé à l’exemple 5.3.6 une majoration par 0,125. On voit donc

que la majoration avec Bienaymé-Tchebychev était très grossière.

2. (exercice) Combien doit-on faire de lancers d’une pièce de monnaie équilibrée pour

que la proportion de Pile soit comprise entre 0,45 et 0,55 ?

8.3 Théorème limite central

Le phénomène mis en lumière par le théorème de Moivre-Laplace n’est en fait pas ca-

ractéristique des lois binomiales qui, on le rappelle, sont des sommes indépendantes de lois

de Bernoulli. Il reste valable pour des sommes de nombreuses autres lois.

Théorème 8.3.1 (Théorème limite central).Soit (Xn)n≥1une suite de variables aléatoires

indépendantes, de même loi et dans L2. En notant m=E(X1),σ2=V(X1)et Sn=X1+

··· +Xn, on a Sn−nm

√n σ −−−−−→

n→+∞N(0,1) en loi.

On peut aussi écrire la conclusion du théorème

√n¯

Xn−m

σ−−−−−→

n→+∞N(0,1) en loi,

où ¯

Xn=1

nSnest la moyenne empirique, ou encore

√n(¯

Xn−m)−−−−−→

n→+∞N(0, σ2)en loi.

On remarquera le caractère universel de ce théorème. La loi des variables Xnn’est pas

précisée et, bien que restant une loi de probabilité, la limite est parfaitement identifiée.

Autrement dit, pour n“grand”, √n¯

Xn−m

σreste une variable au comportement aléatoire,

mais suivant une loi précise. La loi normale apparaît donc comme une loi universelle.

Voyons une application du TLC en estimation statistique.

8.4 Intervalle de confiance

On a vu que les lois des grands nombres permettent d’obtenir des estimateurs conver-

gents pour évaluer une probabilité inconnue. On parle d’estimateurs ponctuels. Bien sûr,

dans la pratique, on remplace “n→+∞” par “nassez grand”. La donnée d’une estimation

ponctuelle est alors assez pauvre puisqu’elle ne prend pas en compte l’erreur d’approxi-

mation. La première idée, pour tenir compte de l’erreur est de donner l’estimation sous

forme d’un intervalle : la quantité à estimer est comprise entre tant et tant. Mais l’erreur

est ici aléatoire. Le théorème précédent nous dit qu’elle tend à être distribuée comme une

8.4. INTERVALLE DE CONFIANCE

loi normale dont la variance est de l’ordre de 1

n. Pour tenir compte du caractère aléatoire

de cette erreur, on ne donnera pas une estimation toujours vraie, mais une estimation qui

a une forte probabilité d’être vraie.

Définition 8.4.1. Soit X1, . . . , Xndes variables aléatoires, θ∈Rfixé et α∈[0,1] (appelé

risque). Un intervalle aléatoire I=I(X1, . . . , Xn)est un intervalle de confiance au niveau

1−αpour θsi

P(θ∈I)≥1−α.

Remarque 8.4.2. 1. En pratique, on choisira le risque αproche de 0.

2. Attention, c’est l’intervalle Iqui est aléatoire et non pas θqui lui est fixé (bien qu’in-

connu en pratique).

3. Dans une situation concrète (statistique), on aura à disposition uniquement une réali-

sation (x1, . . . , xn)=(X1(ω), . . . , Xn(ω)) de l’échantillon (X1, . . . , Xn)et donc une réa-

lisation I(x1, . . . , xn)de l’intervalle de confiance. Bien sûr, on espère que cet intervalle

contiendra effectivement le réel θà estimer et ceci se produira donc avec probabilité

au moins 1−α.

4. Re-Attention, toujours en pratique, la loi des Xisera inconnu. On ne pourra donc pas

évaluer directement la quantité P(θ∈I), puisque la loi de Idépend de celle des Xi.

C’est ici que le théorème limite central va jouer un rôle.

Avant de donner un exemple, on introduit la notion de fractile.

Définition 8.4.3. Soit Xune variable aléatoire réelle et α∈]0,1[. On dit que u∈Rest un

fractile d’ordre αde la loi PXsi P(X≤u) = α(i.e. FX(u) = α).

Si la fonction de répartition FXest inversible, alors pour tout α∈]0,1[, il existe un unique

fractile d’ordre α.

Exemple 8.4.4. Pour la loi normale N(0,1), par parité de la densité, si uαest le fractile

d’ordre α∈]0,1[ alors −uαest le fractile d’ordre 1−α. Si u=u1−α

2est le fractile d’ordre

1−α

2de la loi N(0,1) et si X∼ N(0,1), alors P(−u < X < u)=1−α.

−3 −2 −1 0 1 2 3

0.0 0.1 0.2 0.3 0.4

Densité de la loi normale centrée réduite. u fractile d'ordre 1 − α 2

P(−u<X<u)=1−α

P(X<−u)=α2 P(X>u)=α2

−u u

6

6

7

7

1

/

7

100%