Examen Master 2

Examen Master 2

Extraction de connaissances

Documents autorisés

1h30

2005/2006

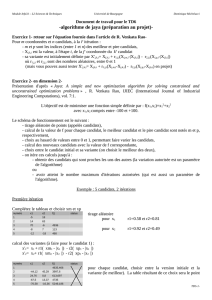

1. Comparer les méthodes Apriori et FP-tree pour le calcul des ensembles fréquents.

2. Lors de la construction des arbres de décision, une méthode permettant d’éviter l’overfitting consiste à simplifier

l’arbre obtenu lors d’une première étape.

a. Expliquer la notion d’overfitting

b. Expliquer le principe de simplification des arbres a posteriori

3. Considérons la méthode de regroupement basée sur la densité vue en cours. Cette méthode considère qu’un cluster est

un groupe d’objets qui doit être dense. La notion de densité est exprimée en utilisant le concept d’accessibilité, i.e la

distance maximale séparant deux objets voisins ainsi que le nombre minimum de voisins d’un objet. Ceci permet de

définir ce que sont deux objets accessibles. La méthode consiste donc à faire de sorte que deux objets accessibles

soient forcément dans le même cluster. Le problème de cette méthode réside dans le fait qu’il faille fixer les

paramètres Minpts et Eps (voir notes de cours). Ainsi, généralement, on procède par tâtonnement en essayant

plusieurs valeurs de ces paramètres jusqu’à obtenir un regroupement « satisfaisant ». On voit donc, qu’on est en

présence d’un processus interactif (ce qui est d’ailleurs généralement le cas avec les techniques de datamining ).

On vous propose la méthode itérative suivante :

o On compte au départ le nombre d’objets on trouve qu’il y en a n. On calcule la distance maximale séparant

deux objets et on trouve que c’est D. On fixe la valeur de Eps à d (d > 0) et MinPts à m avec m qui est bien

sûr inférieur à n.

o On lance une première fois l’algorithme pour calculer les clusters avec comme paramètres d et m

o Ensuite, on répète le processus suivant :

i. Remplacer la valeur de Eps par 2*Eps

ii. Relancer le calcul des clusters avec les paramètres MinPts (MinPts inchangé) et Eps

Jusqu’à ce que le regroupement obtenu soit égal au regroupement de l’itération précédente.

3.1 Montrer qu’à chaque itération, les groupes qu’on obtient sont en fait une fusion de groupes obtenus lors de

l’itération précédente.

3.2 Montrer que l’algorithme converge.

3.3 Donner une estimation du nombre maximum d’itérations qu’il faut pour que l’algorithme s’arrête. Quel est le

nombre minimum d’itérations ?

NB : Vous pouvez supposer que la première question est démontrée et utiliser ce résultat pour montrer la deuxième et la

troisième.

1

/

1

100%