Détection des contours de la pupille à l`aide des transformées de

Département de Production Automatisée

École de technologie supérieure

Montréal

Détection des contours de la pupille

à l’aide des transformées de Hough

Jérôme Schmaltz

Rapport de projet de session

Projet de session – SYS844 Vision par ordinateur

à l’École de Technologie Supérieure (ETS).

2006

Professeur M. Richard Lepage

SYS844-RPS

Détection de la pupille à l’aide des

transformées de Hough Rapport

ETS SYS-844 Jérôme Schmaltz Page 2 sur 36

Table des matières

Table des matières ............................................................................................................................................ 2

Liste des figures................................................................................................................................................ 3

Liste des tableaux.............................................................................................................................................. 4

1. Introduction................................................................................................................................................... 5

1.1 Travail proposé ....................................................................................................................................... 6

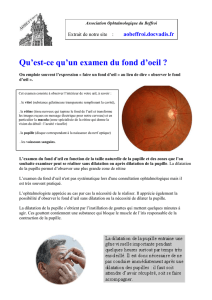

2. Caractéristiques biologiques de l’œil............................................................................................................ 7

3. Caractéristiques d’une image de l’œil acquise avec une caméra traditionnelle............................................ 9

3.1 Ombres.................................................................................................................................................. 10

3.2 Reflets ................................................................................................................................................... 10

3.3 Pupilles.................................................................................................................................................. 11

3.4 Luminosité ............................................................................................................................................ 11

3.5 Contrainte additionnelle : lunettes et lentilles....................................................................................... 12

4. Traitement de l’image pour la détection de la pupille ................................................................................ 13

4.1 Image source ..................................................................................................................................... 13

4.2 Suppression du surplus de contours.................................................................................................. 14

4.3 Conversion en niveaux de gris.......................................................................................................... 15

4.4 Détection des contours...................................................................................................................... 16

4.5 Directions des contours..................................................................................................................... 18

4.6 Détection des centres ........................................................................................................................ 19

4.7 Seuillage............................................................................................................................................ 20

4.8 Isoler les centres potentiels ............................................................................................................... 21

4.9 Recherche des cercles ....................................................................................................................... 22

5. Présentation du projet ................................................................................................................................. 24

5.1 Architecture du programme .................................................................................................................. 24

5.2 Présentation des l’interfaces usager...................................................................................................... 27

6. Résultats obtenus ........................................................................................................................................ 29

6.1 Vitesse de l’algorithme ......................................................................................................................... 33

7. Conclusion et améliorations possibles........................................................................................................ 35

Références....................................................................................................................................................... 36

SYS844-RPS

Détection de la pupille à l’aide des

transformées de Hough Rapport

ETS SYS-844 Jérôme Schmaltz Page 3 sur 36

Liste des figures

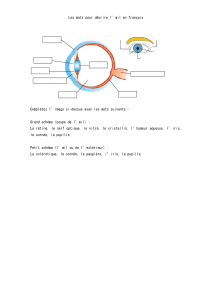

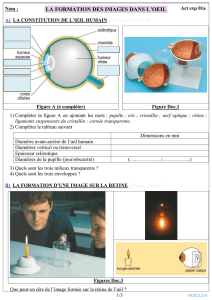

Figure 2.1 Les différentes parties externes de l’œil humain............................................................................. 7

Figure 2.2 Les différentes parties internes de l’œil humain.............................................................................. 8

Figure 2.3 Représentation des cônes et des bâtonnets. ..................................................................................... 8

Figure 3.1 Contenu spectral de la lumière. ....................................................................................................... 9

Figure 3.2 Image capturée avec une caméra traditionnelle............................................................................... 9

Figure 3.3 Formation d’ombre dans une image de l’œil................................................................................. 10

Figure 3.4

Types de reflets dans un œil. (a) Reflet de fenêtre dans l’œil. (b) Reflet d’une lampe dans l’œil. (c) Reflet d’un néon dans l’œil

. ............... 11

Figure 4.1 Différentes étapes de traitement de l’image afin de localiser la pupille dans une image.............. 13

Figure 4.2 Spécification d’une région d’intérêt pour traitements ultérieurs................................................... 13

Figure 4.3 Application du filtre moyenneur sur la région d’intérêt................................................................ 14

Figure 4.4 Exemple d’un filtre moyenneur de dimension 3x3. ...................................................................... 14

Figure 4.5 Conversion de la région d’intérêt en niveaux de gris.................................................................... 15

Figure 4.6 Détection des contours de la région d’intérêt................................................................................ 17

Figure 4.7 Noyaux de convolution de Sobel................................................................................................... 18

Figure 4.8 Déterminer les directions des gradients à partir de l’application des filtres de Sobel................... 18

Figure 4.9 Traçage d’une droite en fonction d’un contour............................................................................. 19

Figure 4.10 Traçage d’une droite dans l’accumulateur. ................................................................................. 19

Figure 4.11 Centre d’un cercle dans un accumulateur.................................................................................... 20

Figure 4.12 Traçage de lignes dans l’accumulateur en fonction de l’image de Canny et de la matrice de directions. 20

Figure 4.13 Application d’un seuil dans l’accumulateur................................................................................ 21

Figure 4.14 Représentation graphique d’un Laplacien de Gaussien. ............................................................. 21

Figure 4.15 Application d’un chapeau mexicain dans l’accumulateur........................................................... 21

Figure 4.16 Accumulateur de Hough en trois dimensions.............................................................................. 22

Figure 4.17 Traçage des cercles avec l’image de contours............................................................................. 22

Figure 4.18 Flux d’opérations pour localiser les pupilles............................................................................... 23

Figure 5.1 Architecture de haut niveau........................................................................................................... 24

Figure 5.2 Diagramme de classes. .................................................................................................................. 26

Figure 5.3 Écran principal de l’application .................................................................................................... 27

Figure 5.4 Établissement de la région d’intérêt. ............................................................................................. 27

Figure 5.5 Écran de configuration des paramètres.......................................................................................... 28

Figure 6.1 Éclairage de forte intensité dans l’axe de la caméra. Scène arrière éclairée. ................................ 29

Figure 6.2 Sous exposition de la lumière. Scène arrière éclairée. .................................................................. 29

Figure 6.3 Éclairage normal, scène arrière sous éclairée................................................................................ 30

Figure 6.4 Sur éclairage sur la gauche, scène arrière sous éclairée. ............................................................... 30

Figure 6.5 Sur éclairage sur la droite, scène arrière sous éclairée. ................................................................. 30

Figure 6.6 Éclairage normal, plan de loin....................................................................................................... 31

Figure 6.7 Plan de proche, éclairage normal, ajustement de paramètres........................................................ 31

Figure 6.8 Temps de calculs en fonction des dimensions de la région d’intérêt. ........................................... 33

Figure 6.9 Temps de calculs en fonction des coefficients de Gaussien.......................................................... 34

SYS844-RPS

Détection de la pupille à l’aide des

transformées de Hough Rapport

ETS SYS-844 Jérôme Schmaltz Page 4 sur 36

Liste des tableaux

Tableau 5.1 Spécifications techniques............................................................................................................ 24

Tableau 5.2 Description des classes. .............................................................................................................. 27

Tableau 6.1 Liste des valeurs pour les différents paramètres. ........................................................................ 29

Tableau 6.2 Valeurs des paramètres utilisés pour la figure 6.7 ...................................................................... 31

Liste des formules

Formule 4.1 Exprimant la moyenne d’un pixel d’intérêt................................................................................ 14

Formule 4.2 Conversion en niveau de gris d’un pixel RGB........................................................................... 15

Formule 4.3 Conversion en niveau de gris d’un pixel RGB en prenant en compte la perception de l’œil humain. ... 15

Formule 4.3 Représentation du filtre gaussien. .............................................................................................. 16

Formule 4.4 Convolution d’un filtre gaussien sur une image......................................................................... 16

Formule 4.5 Amplitude d’un gradient et obtention de sa direction. ............................................................... 16

Formule 4.6 Arc tangente des filtres de Sobel................................................................................................ 18

Formule 4.7 Équation de la droite................................................................................................................... 19

Formule 4.8 Représentation d’un Laplacien de Gaussien. ............................................................................. 21

SYS844-RPS

Détection de la pupille à l’aide des

transformées de Hough Rapport

ETS SYS-844 Jérôme Schmaltz Page 5 sur 36

1. Introduction

Le traitement d’images digitales n’est pas nouveau en soi. Depuis les trente dernières années, des

applications concrètes naissant du traitement d’images, ont trouvé une place importante dans plusieurs

domaines scientifiques et mêmes domestiques. Ainsi, la domotique, la robotique et la biométrie sont des

exemples de champs d’applications reposant toutes sur le traitement d’images [EFF00].

Quelques applications de la robotique arborent un système de vision exploitant le traitement d’images

digitales afin d’analyser un stimulus et d’en extraire une représentation symbolique [LEP05]. C’est souvent

le cas de robots autonomes dotés d’une intelligence artificielle. D’autres cas concrets d’applications directes

du traitement d’images se retrouvent aussi en biométrie, afin de produire un modèle mathématique de

l’identité d’un sujet en fonction des caractéristiques physionomiques d’une partie quelconque de son corps

(emprunte, iris, main, etc.).

Puisque ces milieux sont en constantes évolutions du fait qu’ils sont directement influencés par une

croissance technologique continue, la recherche en traitement d’images et en vision par ordinateur demeure

un point chaud en ingénierie.

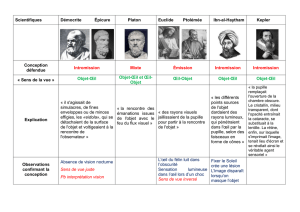

Depuis quelques années déjà, on assiste à une panoplie de recherches concernant des algorithmes et

protocoles visant la caractérisation, la quantification, la qualification et la discrétisation des attributs l’œil

humain [ZHU02, DAU04]. On peut maintenant voir une correspondance directe de ces recherches dans le

milieu de la biométrie, dans celui de la commande et même dans les domaines médicaux.

Plusieurs de ces applications nécessitent une interaction entre l’œil et la machine, où l’œil sert de dispositif

de pointage afin que la machine puisse capturer les mouvements et repérer le point de la scène vers lequel

l’œil de l’utilisateur pointe.

De tels dispositifs sont appelés Eye Trackers. On en distingue deux catégories. Ceux qui requièrent un

contact direct avec l’utilisateur, par le port de lunettes ou de lentilles spéciales, et ceux qui n’en n’imposent

pas. Ces derniers sont généralement statiques et moins adaptés à la mobilité du sujet [KRO01].

Parmi les travaux consultés [KRO01, BRO00] et les ressources d’Internet abondantes sur le sujet, bon

nombre d’entre eux reposent sur une détection soit de l’iris ou de la pupille par les transformées de Hough

(voir section correspondante).

Le travail présenté dans ce rapport se penchera sur la détection de la position des pupilles à partir d’images

diffusées en continu (vidéo) arborant la figure d’un utilisateur à partir d’une zone d’intérêt pré déterminé, et

ce, avec l’aide des transformées de Hough.

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

34

34

35

35

36

36

1

/

36

100%