Accélérateur - indico in2p3

page 36

É

LÉMENTAÍRE

Accélérateur

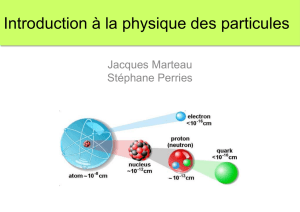

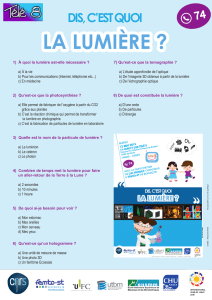

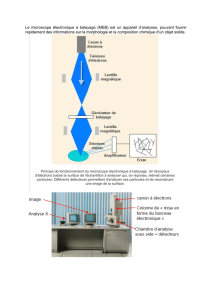

Pour observer le monde qui nous entoure, nous nous servons en priorité

de nos yeux. Que nous regardions une fleur près de nous ou une étoile

par un télescope, la vision est fondamentale pour ces études qui utilisent

la lumière comme principale source d’information. Or, les particules

élémentaires n’émettent pas de tels rayonnements : comment les «voir»

quand même ? Dans l’obscurité, il faut utiliser d’autres sens comme l’ouÏe

ou le toucher. Ainsi, pour étudier une cloche dans le noir, on pourrait

imaginer de la faire sonner ; l’analyse de ses vibrations nous renseignerait

ensuite sur sa structure. Le même raisonnement est valide pour l’étude de

l’infiniment petit : pour étudier la matière atomique et subatomique, les

physiciens secouent, font vibrer et même cassent ses consituants. Pour

cela, ils utilisent des accélérateurs de particules.

Une fois accélérées, ces dernières entrent en collision et, plus l’énergie

délivrée est importante, plus l’échelle de distance à laquelle on pourra

examiner la matière sera courte. On pourrait, en simplifiant à l’extrême,

dire que les accélérateurs de particules sont des microscopes géants.

Cependant, s’ils servent bien à observer «l’infiniment petit», ils sont basés

sur des principes très différents.

Ce besoin de chocs de plus en plus violents entre particules a donné

naissance à une discipline à part entière, appelée la physique des

accélérateurs. Dans ce numéro et dans les suivants, nous souhaitons

présenter les principaux développements dans ce domaine en les reliant

aux découvertes qu’ils ont permises. Cette perspective historique nous

conduira aux accélérateurs actuels et... futurs, de véritables bijoux

technologiques, bien loin de simples «casse-particules».

L’accélération et le guidage, à des énergies toujours plus importantes,

de particules ou de noyaux chargés repose sur l’utilisation de champs

électrique et magnétique. Dans cet article, nous allons décrire les

principes de l’accélération des particules par des champs électriques, ce

qui nous permettra d’évoquer les accélérateurs «électrostatiques».

Du tube de Crookes à la télévision

La science des accélérateurs s’appuie beaucoup sur l’électromagnétisme,

en particulier sur ses développements

fulgurants au XIXe siècle, de Volta à

Maxwell en passant par Faraday, Oersted

et Ampère. On s’intéressait beaucoup

alors à la production d’étincelles entre

deux plaques métalliques chargées.

William Crookes construisit en 1875

un appareil – voir figure 1 – pour étudier

l’influence de la densité d’air sur la

différence de potentiel à appliquer entre

les plaques pour créer une décharge

électrique. En un certain sens, il s’agissait

du premier accélérateur.

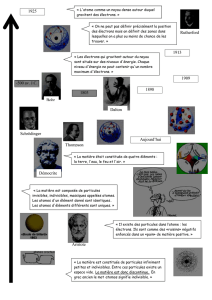

Louis de Broglie (1892-1987)

(prononcer « De Breuil ») s’est

d’abord orienté vers les Lettres.

Licencié en Histoire en 1910, il s’est

ensuite intéressé aux sciences, et

plus particulièrement à la physique

théorique, sur les conseils de son

frère aîné Maurice – physicien

autodidacte qui fonda un laboratoire

dans son propre hôtel particulier ! Sa

thèse, publiée en 1924, « Recherche

sur la Théorie des Quanta », postule

l’existence d’une longueur d’onde

associée à chaque particule et il la

relie à l’énergie cinétique de celle-ci.

D’abord accueillie avec scepticisme

par la communauté scientifique,

sa théorie est confirmée de manière

éclatante par des expériences menées

en 1927. Pour ses travaux, il reçoit

le prix Nobel de Physique en 1929.

Pourquoi toujours chercher à augmenter l’énergie des accélérateurs ?

Augmenter l’énergie des particules accélérées dans les accélérateurs a deux

avantages :

• plus l’énergie E est grande, plus on peut créer des particules de masses M

élevées – c’est la célèbre relation d’Einstein montrant l’équivalence masse – énergie

(voir la rubrique «La question qui tue») : E = M × c2

• en optique, la longueur d’onde de la lumière (proportionnelle à l’inverse

de sa fréquence) donne l’ordre de grandeur des détails que l’on peut discerner avec

cet éclairage particulier. L’un des grands succès initiaux de la Mécanique Quantique

a été de postuler, puis de démontrer l’existence d’une longueur d’onde associée à

une particule en mouvement – ce résultat est dû en particulier aux travaux de Louis

de Broglie. Cette longueur d’onde varie comme l’inverse de l’énergie, c’est « l’effet

microscope ».

Les premiers accélérateurs électrostatiques

page 37

É

LÉMENTAÍRE

Encadré 1

Pourquoi des particules chargées sont-elles accélérées dans un champ électrique ?

La relation fondamentale de la dynamique relie la variation de la quantité de mouvement

p = m × v

à la force exercée sur une particule de charge électrique q : F = q × E

Cette relation s’écrit : = F

Un champ électrique E uniforme est par exemple créé par une différence de potentiel ∆V

entre deux plaques métalliques situées à une distance D. L’intensité du champ électrique

est alors donnée par :

|E|=

La variation d’énergie de la particule correspond au travail de la force électrique à laquelle

elle est soumise, soit : ∆E=|F| × D=|q| × |E| x D = |q| × ∆V

Pour obtenir une variation d’énergie cinétique de 1 GeV (1 MeV) pour une particule de

charge ± e, il faut donc une différence de potentiel ∆V de 1 milliard (million) de volts.

Les premiers accélérateurs électrostatiques

Sous l’effet de la différence de potentiel, des charges négatives (des

électrons) sont émises à la cathode et attirées par l’anode. Lorsque le

voltage est suffisamment élevé, une circulation continue d’électrons se

met en place : c’est comme si le circuit était «fermé» par un «vrai» fil

métallique : l’air est devenu conducteur. Aujourd’hui, on utilise toujours

une cathode pour obtenir des faisceaux d’électrons mais ceux-ci sont

maintenant produits par chauffage.

La pompe à vide permit à Crookes de faire varier la pression de l’air

contenue dans le tube ; il trouva que moins il y avait d’air, moins il

fallait créer de différence de potentiel – appelée également tension de

claquage – pour «fermer» le circuit. Ce phénomène est dû à l’ionisation

des molécules composant l’air par les électrons accélérés entre les deux

plaques : la circulation de charges qui se met en place est alors similaire

à celle qui a lieu dans un fil conducteur. C’est pour éviter cette interaction

entre l’air résiduel et les faisceaux de particules que les accélérateurs

fonctionnent aujourd’hui dans un vide presque parfait. Cela permet de

contrôler au mieux l’énergie et la trajectoire des particules lors de leur

trajet dans l’accélérateur.

Plus tard, on se rendit compte qu’on pouvait modifier un peu l’expérience de

Crookes pour visualiser les «rayons cathodiques» (le faisceau d’électrons)

– voir figure 2. En donnant à l’anode la forme d’un anneau, on permit

aux électrons de passer à travers et d’aller taper sur un écran recouvert

d’une surface sensible : un point lumineux apparaissait alors, signant la

présence des électrons. Ce principe est à la base de l’oscilloscope, un

instrument permettant de visualiser la tension et l’intensité d’un courant,

mais également de la… télévision cathodique ! Chacun des bons vieux

écrans bombés que nous connaissons tous contient en effet un canon à

électron qui balaye toute sa surface à haute fréquence, générant ainsi 24

images par seconde.

Pour conclure sur les tubes de Crookes, on peut rappeler qu’un dispositif

similaire, couplé à un aimant, permit à Joseph John («J.-J.») Thomson (1856-

Les premiers accélérateurs électrostatiques

figure 1 : Schéma d’un tube de

Crookes

William Crookes (1832-1919)

-> ->

-> ->

dp

dt

->

->

—

-> ∆V

D

—

-> ->

© B. Mazoyer

© B. Mazoyer

page 38

É

LÉMENTAÍRE

Qu’est qu’un électron-volt ? Pourquoi utilise-t-on des unités particulières en physique des particules ?

A notre échelle, le kilogramme et le joule sont des unités bien adaptées pour mesurer des masses et des énergies. Il en va tout

autrement dans le monde des particules élémentaires. Par exemple, les masses de l’électron et du proton exprimées en kg

sont ridiculement faibles, respectivement me = 9,1 × 10-31 et mp = 1,7 × 10-27 kg. La situation est similaire pour les énergies.

Donc, pour éviter d’avoir en permanence à gérer des grandeurs aussi petites, il est d’usage d’utiliser un autre système d’unités.

L’unité de base pour l’énergie est l’électron-Volt (en abrégé eV) défini par :

1 eV = 1,6 × 10-19 J

C’est l’énergie d’un électron (de charge électrique -e = -1,6 × 10-19 coulomb) accéléré par une différence de potentiel de 1 Volt.

D’après la formule d’Einstein liant masse et énergie (E = m × c2), une quantité exprimée en « eV / c2 » est donc homogène

à une masse (voir rubrique «La question qui tue»). C’est cette unité qui est utilisée dans notre discipline pour « peser » les

particules ; le facteur de conversion entre eV / c2 et kg est :

1 eV / c2 ≈ 1,8 × 10-36 kg

Cette fois-ci, c’est un peu « faible » par rapport aux masses des particules : on parlera donc le plus souvent de Méga-eV

(« MeV », un million d’eV), de Giga-eV (« GeV », un milliard d’eV) voire de Téra-eV (« TeV », mille milliards d’eV) en

divisant ou non par le facteur c2 selon que l’on parle de masse ou d’énergie. Avec ces unités, on a : me = 0,511 MeV / c2 et mp

= 938 MeV / c2. Généralement on omet d’écrire «/ c2» dans le cas des masses, qui sont donc exprimées en MeV ou TeV.

figure 2 : Tube de Crookes modifié :

l’ancêtre de la télévision !

Entre deux plaques parallèles soumises

à une différence de potentiel, un champ

électrique est créé dans la direction

perpendiculaire. On obtient un champ

de même nature en remplaçant la

plaque anode par un anneau. Dans ce

cas-là, les électrons émis par la cathode

ne sont pas absorbés par l’anode mais la

traversent.

1940) de découvrir en 1897 que le faisceau émis de la cathode vers l’anode

était formé de particules de charges négatives qui furent baptisées « électrons »

– terme forgé de toutes pièces. La déviation du faisceau cathodique sous

l’action de l’aimant montra d’abord qu’il s’agissait de particules de charges

négatives, puis Thomson l’utilisa pour en déduire le rapport entre la charge

et la masse de l’électron. Ce n’est qu’en 1909 que la charge de l’électron fut

mesurée par Robert Millikan (1868-1953) en observant la chute de gouttelettes

d’huile chargées négativement. Tous deux reçurent le prix Nobel pour leurs

travaux, Thomson en 1906 et Millikan en 1923.

Les premiers accélérateurs électrostatiques

© B. Mazoyer

page 39

É

LÉMENTAÍRE

Les premiers accélérateurs électrostatiques

figure 3. Schéma d’un accélérateur électrostatique Cockcroft-Walton : les particules créées

(par exemple des protons) sont accélérées par la différence de potentiel régnant dans le tube

à vide avant d’entrer en collision avec une cible (par exemple du lithium).

Champ électrique E

Transmutation

Lors de réactions chimiques «clas-

siques», on retrouve toujours les mêmes

quantités d’éléments avant et après la

réaction. Par exemple, dans :

H2 + ½ O2—> H2O

il y a autant d’atomes d’hydrogène (H)

et d’oxygène (O) à la gauche et à la droite

de la flèche symbolisant la réaction, ici la

formation de l’eau (H2O). Au contraire,

une transmutation est une réaction dans

laquelle on transforme les éléments : les

produits de la réaction ne contiennent

pas les mêmes éléments chimiques que

les réactifs ! C’est par exemple le cas de

la réaction :

p + 3Li—> 2He + 2He

L’idée de transmutation est très

ancienne : de l’antiquité aux temps

modernes, la motivation principale des

alchimistes fut la recherche de la « pierre

philosophale », substance capable

en particulier de changer le plomb

en or. Si leur quête fut infructueuse,

leurs rêves plutôt « intéressés » sont

aujourd’hui devenus réalité grâce aux

physiciens nucléaires – pour rencontrer

les alchimistes d’aujourd’hui, voir la

rubrique «Centre ». Dans ces réactions,

le nombre de protons et de neutrons

sont séparément conservés.

Sir John D. Cockcroft (à gauche) et

Ernest T. S. Walton (à droite) dans leur

laboratoire à Cambridge dans les années

1930.

Les premiers accélérateurs électrostatiques

74 4

Les accélérateurs électrostatiques

Dans les premiers accélérateurs, l’énergie acquise par une particule

chargée est proportionnelle à la différence de potentiel établie entre une

anode et une cathode. Grâce à ces accélérateurs, dits électrostatiques

(ou de Cockcroft-Walton du nom de leurs inventeurs, voir figure 3 pour

un schéma), plusieurs découvertes furent possibles. Ainsi, en 1931, des

particules alpha (noyaux d’hélium) de 17 MeV furent produites à partir

d’un faisceau de protons de 0,125 MeV envoyés sur une plaque de lithium.

La réaction était la suivante :

p + 3Li—> 2He + 2He

Pour la première fois, un phénomène de transmutation avait eu lieu dans

un accélérateur !

Accélérateurs de Cockcroft-Walton

Un accélérateur électrostatique Cockcroft-Walton est chargé par

l’intermédiaire d’une chaîne complexe de condensateurs reliés par des

systèmes ne permettant le passage du courant que dans un seul sens.

Ainsi, bien que la source initiale de tension soit alternative – comme notre

« secteur » – les condensateurs se chargent mais ne se déchargent pas.

Le fait d’avoir plusieurs condensateurs consécutifs permet de multiplier

la charge finale de l’accélérateur qui, en première approximation, est

directement proportionnelle au nombre de condensateurs. En fait, des

effets d’oscillation limitent la longueur de la chaîne ; typiquement, on

utilise une dizaine de niveaux de condensateurs.

74 4

© B. Mazoyer

page 40

É

LÉMENTAÍRE

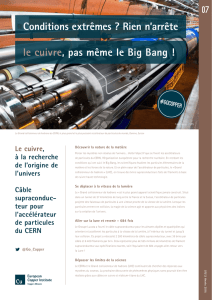

Accélérateurs de Van de Graaff

Un autre type d’accélérateur électrostatique, dit « Van de Graaff » utilise une

méthode de charge différente : les charges sont émises par un générateur

de courant continu sous une tension de quelques dizaines de kilovolts.

Ensuite, elles sont capturées par une courroie isolée et emportées jusqu’à

l’une des électrodes de l’accélérateur, exactement comme des pierres

amenées par un tapis roulant sur un chantier de génie civil. On pourrait

dire que, dans un « Van de Graaff », les charges prennent l’escalier roulant

alors que, dans un Cockcroft-Walton, elles passent plutôt par l’escalier !

Néanmoins, cette image est imparfaite car, dans les deux cas, les efficacités

sont similaires et les technologies très avancées !

En physique nucléaire, l’accélérateur « Van de Graaff » a été

considérablement amélioré par la technologie « Tandem » qui présente

deux étapes d’accélération. On part d’un faisceau d’ions positifs (pour

lesquels les sources sont plus intenses que les ions négatifs) que l’on fait

passer au travers d’un gaz à faible pression dans lequel les ions capturent

un ou deux électrons. Ensuite, un aimant permet de séparer les particules

neutres ou chargées positivement des nouveaux ions négatifs qui pénètrent

alors dans un premier accélérateur « Van de Graaff » où ils sont accélérés.

Au bout du dispositif, les ions traversent une fine couche de carbone ;

comme ils ont une énergie élevée – de l’ordre de quelques MeV – la

plupart de leurs électrons sont éjectés lors de ce passage. Les ions ainsi

L’accélérateur original construit

par Cockcroft et Walton. Le

tube à vide visible ici mesure

2,50 m de long pour un potentiel

accélérateur de l’ordre de 800 kV.

Dispositif créant la différence de potentiel

nécessaire à l’accélération des particules

dans un accélérateur de type Van de

Graaff. En particulier, on peut voir la

courroie qui transporte les charges du

générateur au dôme métallique où elles

sont amassées. Celui-ci a une forme

sphérique pour éviter les «effets de

pointe»: un champ électrique est toujours

plus intense au voisinage d’une pointe

et la présence d’un tel défaut pourrait

provoquer des décharges intempestives du

conducteur. Cet «effet de pointe» se vérifie

en particulier lors des orages : la foudre

frappe préférentiellement les éléments en

relief : arbres, pylônes, toits etc.

Les premiers accélérateurs électrostatiques

© B. Mazoyer

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

34

34

35

35

36

36

37

37

38

38

39

39

40

40

41

41

42

42

43

43

44

44

45

45

46

46

47

47

48

48

49

49

1

/

49

100%