Conception d`un micro-capteur d`image CMOS à faible

UNIVERSITÉ DE GRENOBLE

UNIVERSITÉ DE MONASTIR

THÈSE

Pour obtenir le grade de

DOCTEUR DE L’UNIVERSITÉ DE GRENOBLE

Spécialité : NANO-ELECTRONIQUE ET NANO-TECHNOLOGIES

Arrêté ministériel : 7 août 2006

Et de

DOCTEUR DE L’UNIVERSITÉ DE MONASTIR

Spécialité : PHYSIQUE

Présentée par

« Ahmed CHEFI »

Thèse dirigée par « Gilles SICARD » et

codirigée par « Rached TOURKI »

préparée au sein du Laboratoire TIMA

dans l'École Doctorale EEATS

et du Laboratoire EµE

dans l'École Doctorale Matériaux, Dispositifs et Microsystèmes

Conception d'un micro-capteur

d'image CMOS à faible consommation

d'énergie pour les réseaux de

capteurs sans fil

Thèse soutenue publiquement le

«28/01/2014», à 10h30

devant le jury composé de :

M. Salvador MIR

Directeur de recherche au CNRS, Président

M. Dominique GINHAC

Professeur à l'Université de Bourgogne, Rapporteur

M. Mohamed MASMOUDI

Professeur à l'Université de Sfax, Rapporteur

M. Mohamed ATRI

Maître de conférences à l'Université de Monastir, examinateur

M. Gilles SICARD

Maître de conférences à l'Université Joseph Fourier, Directeur de thèse

M. Rached TOURKI

Professeur à l'Université de Monastir, Co-directeur de thèse

M. Adel SOUDANI

Maître de conférences, King Saud University, Encadrant, Invité

Remerciements

Je tiens à remercier très vivement mes encadrants Adel SOUDANI et

Gilles SICARD ont accueilli, accompagné et conseillé tout au long de ce

parcours. Mon envie de persévérer dans ement et la recherche doit

beaucoup dans ces deux

tâches.

Je tiens également à remercier Monsieur Rached TOURKI et Madame

Dominique BORRIONE, avoir accueilli dans leurs laboratoires respectifs

et de m tous les moyens nécessaires au bon déroulement de mon

projet de recherche.

Mes plus sincères remerciements vont à Messieurs les professeurs

Mohamed MASMOUDI et Dominique GINHAC

les rapporteurs de cette thèse, à Monsieur Mahamed ATRI qui a accepté de

le professeur Salvador

MIR qui a accepté de la présider.

Francophonie (AUF), la

région Rhône-Alpes, le CNRS et le ministère de l'enseignement supérieur et de

la recherche scientifique Tunisien, pour avoir financé cette thèse.

Enfin, je remercie très chaleureusement tous mes proches, ma famille et

mes amis pour leur soutien et leurs encouragements.

RÉSUMÉ

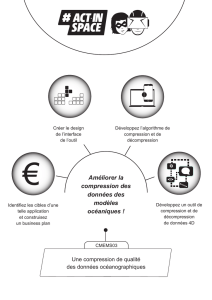

Ce travail de recherche vise à concevoir un système de vision à faible consommation d’énergie

pour les réseaux de capteurs sans fil. L'imageur en question doit respecter les contraintes spécifiques

des applications multimédias pour les réseaux de capteurs de vision sans fil. En effet, de par sa nature,

une application multimédia impose un traitement intensif au niveau du nœud et un nombre

considérable de paquets à échanger à travers le lien radio, et par conséquent beaucoup d’énergie à

consommer. Une solution évidente pour diminuer la quantité de données transmise, et donc la durée de

vie du réseau, est de compresser les images avant de les transmettre. Néanmoins, les contraintes

strictes des nœuds du réseau rendent inefficace en pratique l’exécution des algorithmes de

compression standards (JPEG, JPEG2000, MJPEG, MPEG, H264, etc.). Le système de vision à

concevoir doit donc intégrer des techniques de compression d'image à la fois efficaces et à faible

complexité. Une attention particulière doit être prise en compte en vue de satisfaire au mieux le

compromis "Consommation énergétique - Qualité de Service (QoS)".

ABSTRACT

This research aims to develop a vision system with low energy consumption for Wireless

Sensor Networks (WSNs). The imager in question must meet the specific requirements of multimedia

applications for Wireless Vision Sensor Networks. Indeed, a multimedia application requires intensive

computation at the node and a considerable number of packets to be exchanged through the

transceiver, and therefore consumes a lot of energy. An obvious solution to reduce the amount of

transmitted data is to compress the images before sending them over WSN nodes. However, the severe

constraints of nodes make ineffective in practice the implementation of standard compression

algorithms (JPEG, JPEG2000, MJPEG, MPEG, H264, etc.). Desired vision system must integrate

image compression techniques that are both effective and with low-complexity. Particular attention

should be taken into consideration in order to best satisfy the compromise "Energy Consumption -

Quality of Service (QoS)".

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

34

34

35

35

36

36

37

37

38

38

39

39

40

40

41

41

42

42

43

43

44

44

45

45

46

46

47

47

48

48

49

49

50

50

51

51

52

52

53

53

54

54

55

55

56

56

57

57

58

58

59

59

60

60

61

61

62

62

63

63

64

64

65

65

66

66

67

67

68

68

69

69

70

70

71

71

72

72

73

73

74

74

75

75

76

76

77

77

78

78

79

79

80

80

81

81

82

82

83

83

84

84

85

85

86

86

87

87

88

88

89

89

90

90

91

91

92

92

93

93

94

94

95

95

96

96

97

97

98

98

99

99

100

100

101

101

102

102

103

103

104

104

105

105

106

106

107

107

108

108

109

109

110

110

111

111

112

112

113

113

114

114

115

115

116

116

117

117

118

118

119

119

120

120

121

121

122

122

123

123

124

124

125

125

126

126

127

127

128

128

129

129

130

130

131

131

132

132

133

133

134

134

135

135

136

136

137

137

138

138

139

139

1

/

139

100%