- Cedric/CNAM

Conservatoire National des Arts et Métiers

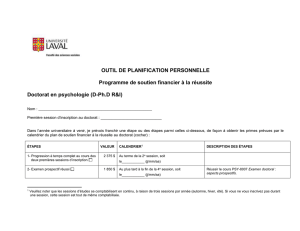

Année 2007

T H E S E

pour obtenir le grade de

docteur en informatique

Présentée et soutenue publiquement

par Didier NAKACHE

le 26 septembre 2007

Extraction automatique des diagnostics à partir des comptes rendus médicaux textuels

Préparée au sein du laboratoire CEDRIC – équipe ISID

sous la direction

d'Elisabeth Métais

Devant le jury composé de :

Président : Pr Jacky Akoka CNAM de Paris

Rapporteurs : Pr Georges Gardarin PRISM Université de Versailles Saint Quentin

Pr Gilles Venturini Ecole polytechnique de Tours

Examinateurs : Pr Reind P. Van De Riet Vrije Universitat (Pays-Bas)

Pr Yacine Rezgui University of Salford (Royaume Uni)

Pr Jean François Timsit CHU de Grenoble

Directeur de thèse : Pr Elisabeth Métais CNAM de Paris

Conservatoire National des Arts et Métiers

Thèse de doctorat en informatique

Didier Nakache

Septembre 2007

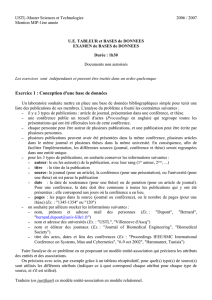

SOMMAIRE Page

Remerciements..................................................................................................... 4

Chapitre 1 : introduction.................................................................................... 5

1.1 Présentation du sujet de la thèse................................................................................. 6

1.2 Le sous projet CIREA ................................................................................................ 8

1.3 Présentation du plan ................................................................................................. 12

Chapitre 2 : état de l'art des classifications de documents textuels rédigés en

langage naturel ..................................................................................................15

2.1 Présentation générale de l'état de l'art ...................................................................... 16

2.2 Définition de la classification................................................................................... 16

2.3 Les comptes rendus hospitaliers............................................................................... 20

2.4 Convergence des méthodes ...................................................................................... 20

2.5 Méthodologie pour classifier les documents textuels .............................................. 26

2.6 L’approche linguistique............................................................................................ 28

2.7 Préparation des données par la desuffixation........................................................... 32

2.8 La vectorisation des documents ............................................................................... 33

2.9 Les mesures de distances et de similarités ............................................................... 43

2.10 Les algorithmes de classification par apprentissage ................................................ 50

2.11 Comparaison des méthodes...................................................................................... 77

Chapitre 3 : la classification automatique des comptes rendus hospitaliers85

3.1 La formalisation du problème .................................................................................. 86

3.2 Analyse du problème................................................................................................ 88

3.3 La représentation du langage médical...................................................................... 88

3.4 Constitution des corpus, des bases d'apprentissage et de test .................................. 97

3.5 Plan expérimental................................................................................................... 100

3.6 Analyse des comptes rendus et de leur reproductivité ........................................... 101

3.7 Proposition d'un algorithme de désuffixation : EDA ............................................. 107

3.8 Proposition d'un algorithme de classification : CLO3 ........................................... 114

3.9 Optimisation de l'apprentissage.............................................................................. 120

3.10 Exemple d'utilisation du logiciel............................................................................ 128

Chapitre 4 la problématique de l'évaluation ..............................................133

4.1 Présentation de la problématique ........................................................................... 134

4.2 Etat de l'art de l’évaluation des classifications....................................................... 135

4.3 Paradigme de l’évaluation : vers une nouvelle approche ? .................................... 142

4.4 De la difficulté d’évaluer........................................................................................ 142

4.5 Vers de nouveaux indicateurs ................................................................................ 145

Chapitre 5 le projet Rhéa, contexte de cette thèse ..................................... 159

5.1 De la cognition artificielle à la connaissance......................................................... 160

5.2 Définitions.............................................................................................................. 160

5.3 Présentation de l'application RHÉA....................................................................... 161

5.4 Résultats obtenus avec la base RHÉA.................................................................... 174

5.5 Conclusions sur RHÉA .......................................................................................... 178

Version finale Page 2

Conservatoire National des Arts et Métiers

Thèse de doctorat en informatique

Didier Nakache

Septembre 2007

6 Conclusions ...............................................................................................179

7 Bibliographie.............................................................................................181

8 Tables des illustrations............................................................................. 203

8.1 Table des figures .................................................................................................... 203

8.2 Table des équations ................................................................................................ 204

9 Annexes......................................................................................................205

9.1 Annexe 1 : le code Source pour EDA .................................................................... 205

9.2 Annexe 2 : arborescence et nouveautés du MeSH 2007 ........................................ 207

9.3 Annexe 3 : calculs de scores utilisés en réanimation ............................................. 212

Version finale Page 3

Conservatoire National des Arts et Métiers

Thèse de doctorat en informatique

Didier Nakache

Septembre 2007

REMERCIEMENTS

Je souhaite remercier très vivement Elisabeth Métais, non parce que c'est l'usage, mais pour

m'avoir guidé dans mes travaux, conseillé avec professionnalisme et une très grande expertise,

sans jamais compter son temps ni perdre sa bonne humeur. Ses apports majeurs me

permettent aujourd'hui de vous présenter cette thèse.

Je suis très reconnaissant envers le Professeur Akoka de me faire l'honneur de présider le jury

de cette soutenance et pour m'avoir accueilli dans l'équipe ISID. J'exprime toute ma gratitude

au Professeur Gardarin et au Professeur Venturini pour accepter d'être mes rapporteurs de

thèse. Je souhaite dire au Professeur Gardarin et son équipe du Prism et Oxymel combien j'ai

apprécié de collaborer avec eux. Je remercie le Professeur Van De Riet et le Professeur

Rezgui pour l'intérêt qu'ils portent à mon travail et en particulier pour avoir traversé les

frontières pour assister à cette présentation. Je remercie également le Professeur Timsit pour

son aide, soutien et forte implication dans ce projet.

Je tiens ensuite à exprimer ma gratitude à mon employeur, la CRAMIF, et à travers elle son

Directeur Général, Mr Tonner, ainsi que Madame Bourez, Monsieur Berton, Mr Kebaili,

Mr Martinez et leurs collaborateurs pour m'avoir soutenu et permis de réaliser cette thèse. Je

remercie très vivement Jacques Chevalier, ainsi que l'ensemble de mes collègues de travail,

les membres du laboratoire Cedric, l'association Outcome Rea, le Professeur Badran pour leur

aide, collaboration et sympathique soutien. Merci à P. Bonnardel pour sa documentation sur

Kappa. Mille mercis à Madame Bouali qui m'encourage depuis le début, ainsi qu'à Monsieur

Aït Henani de l'Université de Lille et Messieurs Chachoua et Edeivotoh de l'EIVP. Enfin je

remercie Sabine, Marie Luce, Eve, Michel, Gabrielle et Sandrine pour leur aide. Je souhaite

exprimer ma sympathie à Martine Degrave, Monique Brossier, Patrice Venel et Martine

Foucault pour leur soutien. Merci à tous mes sympathiques stagiaires pour leurs apports à ce

projet : Annabelle Dierstein, Charles de Laguiche, Julien Le Goff, Eric Dutilleul, Grégoire

Canes-Boussard, Loïc Crenn, Matthieu Ledarath, Roland Ngo, Arthur Dorival, Somruthay

Thammachak, Matthieu Lucot, Frédéric Lallouet, Steve Beroard et Sabrina Dumont.

Je souhaite également remercier ma famille et plus particulièrement mon épouse Claudie, et

mes enfants pour leurs encouragements constants.

Version finale Page 4

Conservatoire National des Arts et Métiers

Thèse de doctorat en informatique

Didier Nakache

Septembre 2007

1 CHAPITRE 1

INTRODUCTION

Version finale Page 5

6

6

7

7

8

8

9

9

10

10

11

11

12

12

13

13

14

14

15

15

16

16

17

17

18

18

19

19

20

20

21

21

22

22

23

23

24

24

25

25

26

26

27

27

28

28

29

29

30

30

31

31

32

32

33

33

34

34

35

35

36

36

37

37

38

38

39

39

40

40

41

41

42

42

43

43

44

44

45

45

46

46

47

47

48

48

49

49

50

50

51

51

52

52

53

53

54

54

55

55

56

56

57

57

58

58

59

59

60

60

61

61

62

62

63

63

64

64

65

65

66

66

67

67

68

68

69

69

70

70

71

71

72

72

73

73

74

74

75

75

76

76

77

77

78

78

79

79

80

80

81

81

82

82

83

83

84

84

85

85

86

86

87

87

88

88

89

89

90

90

91

91

92

92

93

93

94

94

95

95

96

96

97

97

98

98

99

99

100

100

101

101

102

102

103

103

104

104

105

105

106

106

107

107

108

108

109

109

110

110

111

111

112

112

113

113

114

114

115

115

116

116

117

117

118

118

119

119

120

120

121

121

122

122

123

123

124

124

125

125

126

126

127

127

128

128

129

129

130

130

131

131

132

132

133

133

134

134

135

135

136

136

137

137

138

138

139

139

140

140

141

141

142

142

143

143

144

144

145

145

146

146

147

147

148

148

149

149

150

150

151

151

152

152

153

153

154

154

155

155

156

156

157

157

158

158

159

159

160

160

161

161

162

162

163

163

164

164

165

165

166

166

167

167

168

168

169

169

170

170

171

171

172

172

173

173

174

174

175

175

176

176

177

177

178

178

179

179

180

180

181

181

182

182

183

183

184

184

185

185

186

186

187

187

188

188

189

189

190

190

191

191

192

192

193

193

194

194

195

195

196

196

197

197

198

198

199

199

200

200

201

201

202

202

203

203

204

204

205

205

206

206

207

207

208

208

209

209

210

210

211

211

212

212

213

213

214

214

215

215

216

216

217

217

218

218

219

219

1

/

219

100%